Pourquoi mon modèle ne fonctionne-t-il pas ? Guide pratique des pièges en ML

Sources: https://thegradient.pub/why-doesnt-my-model-work, https://thegradient.pub/why-doesnt-my-model-work/, The Gradient

Vue d’ensemble

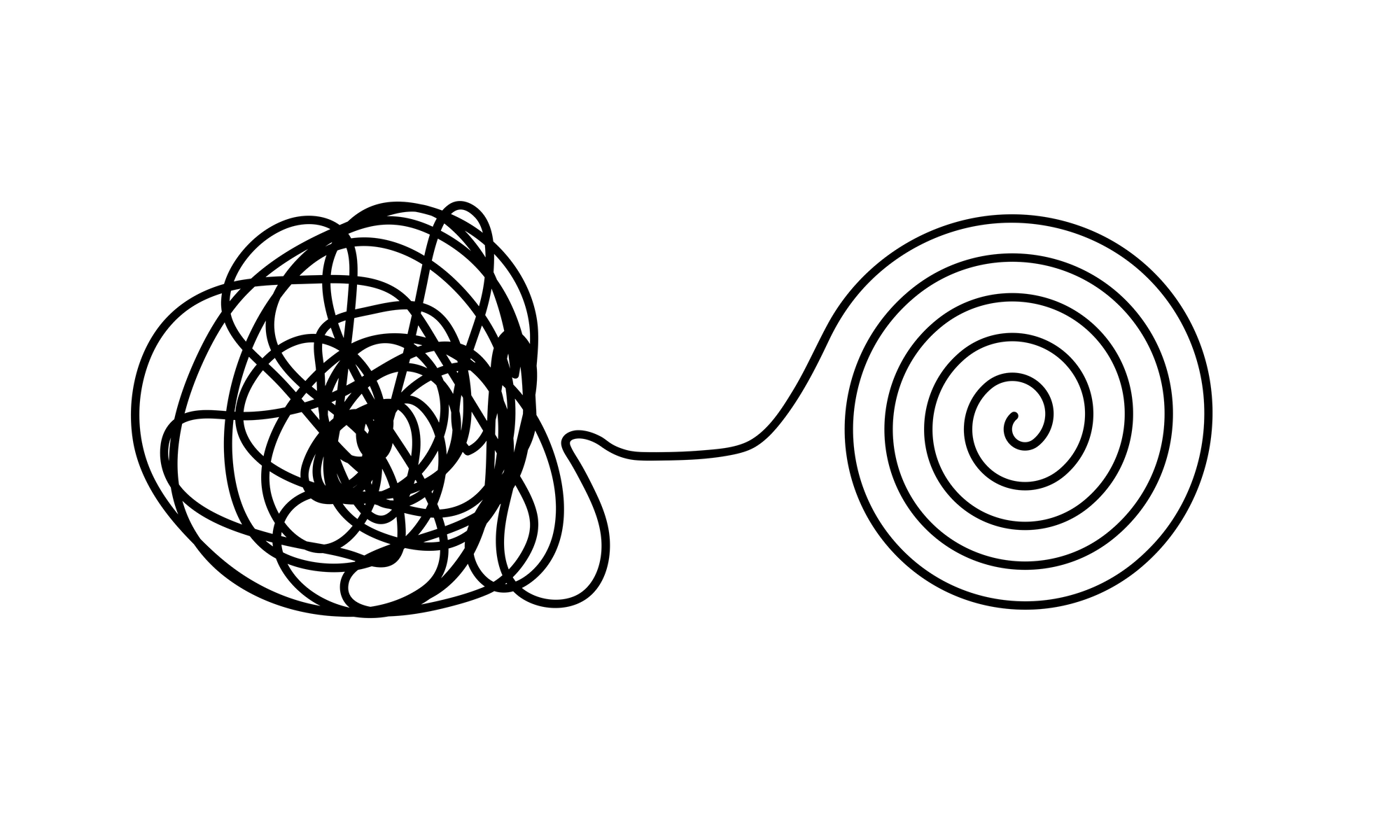

Former un modèle qui semble bon sur un ensemble de test, puis découvrir qu’il échoue sur des données du monde réel est une expérience courante et frustrante. L’article passe en revue les pièges courants que l’on peut rencontrer en ML et qui ne sont pas toujours évidents au départ. En deux décennies dans le domaine, j’ai vu de nombreux cas où les modèles paraissaient efficaces lors du développement mais n’apportaient pas une utilité réelle en pratique. Cet essai explore les erreurs qui gonflent artificiellement les performances et propose des moyens de les éviter, y compris la checklist REFORMS pour une science ML fiable. Les données trompeuses constituent un point de départ naturel pour les problèmes. Le cœur du ML est la donnée et lorsque celle-ci est de mauvaise qualité, les modèles peuvent sembler performants sans apprendre de motifs utiles. Les efforts de prédiction liés à la Covid-19, par exemple, ont impliqué des ensembles de données publics qui contenaient ensuite des signaux ne reflétant pas le phénomène réel. Dans certains cas, des enregistrements se chevauchant, des étiquetages incorrects ou des variables cachées ont aidé le modèle à prédire les étiquettes sans apprendre des signaux pertinents. Les variables cachées sont des caractéristiques présentes dans les données qui corrèlent avec la cible mais ne sont pas causalement liées au phénomène. Dans les images thoraciques liées à la Covid, par exemple, l’orientation de l’examen peut être corrélée avec le statut de la maladie plutôt qu’avec la maladie elle-même, ce qui pousse les modèles à apprendre la posture plutôt que la maladie. Une autre question est la corrélation fallacieuse. Ce sont des motifs qui coïncident avec les étiquettes sans lien causal réel. Dans un exemple classique, un ensemble d’images de tanks pouvait être identifié par le contexte plutôt que par la forme de la machine elle-même. Dans la pratique, de nombreux ensembles contiennent de tels signaux falcaux, ce qui peut mener à une mauvaise généralisation. Les modèles profonds ont la capacité de modéliser de nombreux motifs dans les données et captent souvent des motifs corrélés de fond, ce qui réduit leur généralité. La robustesse sous forme d’entraînement adversaire peut aider mais c’est coûteux; une approche plus simple consiste à examiner les informations que le modèle utilise pour prendre des décisions. Si une carte de saliency annonce que le modèle se concentre sur un élément de fond, il est probable que sa généralisation sera faible. La qualité des étiquetages est aussi problématique. Lorsqu’un humain étiquette les données, des biais ou des erreurs peuvent s’immiscer, surtout dans des tâches où le sujet est subjectif. Les jeux de données benchmarks présentent souvent un taux d’étiquetage incorrect de l’ordre de quelques pour cent, pas rien, mais significatif lorsque les modèles se disputent des marges de précision très petites. Cela signifie que si votre modèle fait légèrement mieux que les concurrents, cela peut résulter d’un bruit de labeling plutôt que d’une amélioration réelle. Au-delà des données, la pipeline peut introduire des fuites d’information qui ne devraient pas être accessibles pendant l’entraînement. Une fuite de données se produit lorsque le modèle a accès à des informations qui ne devraient pas être présentes, particulièrement des informations issues des données de test. Un exemple simple est d’effectuer des opérations de prétraitement dépendant des données sur l’ensemble entier avant de séparer test et entraînement (par exemple normalisation, sélection de features ou augmentation de données). Cela implique l’accès aux caractéristiques de l’ensemble de test et peut faire croire que la performance est meilleure qu’elle ne l’est réellement. En séries temporelles, le biais de regard vers l’avenir est un exemple plus complexe de fuite et peut artificiellement améliorer les scores du test en incluant des informations futures. Pour répondre à ces problèmes, l’article recommande l’utilisation d’un cadre structuré comme la checklist REFORMS pour rendre la science ML plus transparente et robuste. L’objectif est de rendre les données, les choix de modélisation et l’évaluation plus clairs et reproductibles, afin de réduire le risque qu’un modèle « fonctionne » uniquement dans les conditions spécifiques où il a été développé.

Caractéristiques clés

- Détecter et atténuer les données trompeuses dès le départ : éviter le « garbage in, garbage out ».

- Identifier les variables cachées et vérifier qu’elles ne guident pas les prédictions.

- Se méfier des corrélations fallacieuses pouvant gonfler les performances apparentes.

- Examiner les explications du modèle pour s’assurer que les signaux utiles guident les décisions.

- Prévenir la fuite de données en conservant les données de test isolées lors du prétraitement et de la sélection de caractéristiques.

- Surveiller les biais de temps dans les séries temporelles et d’autres domaines où des informations futures pourraient fuiter dans l’entraînement.

- Prendre en compte les biais de labellisation et les erreurs d’annotation, en reconnaissant que la subjectivité peut conduire à un sur-apprentissage sur les annotations.

- Utiliser la checklist REFORMS pour documenter la provenance des données, les choix de modélisation et les procédures d’évaluation.

- Reconnaître que des défenses comme l’entraînement adversaire coûtent cher et ne résolvent pas tout.

Cas d’usage courants

- Études ML scientifiques où les résultats rapportés pourraient surestimer l’utilité dans le monde réel en raison de fuites de données ou de variables cachées.

- Modèles prédictifs liés à la Covid-19 où des signaux latents ou des étiquetages incorrects ont gonflé les performances, mais uniquement sur des jeux de test.

- Benchmarks d’imagerie ou de séries temporelles où des motifs de fond ou des indices temporels s’associent involontairement à des étiquettes, réduisant la généralisation.

- Déploiements dans des domaines sensibles où la robustesse et la résistance aux changements de distribution sont critiques.

- Recherches sur la reproductibilité qui examinent pourquoi les modèles semblent fonctionner dans certains contextes mais échouent sur de nouvelles données.

Setup & installation

# Setup & installation non fournis dans l’article source.

echo "Aucune commande de setup disponible dans la source."Note : l’article fait référence à la checklist REFORMS et à la nécessité d’évaluer et de documenter rigoureusement, mais ne fournit pas d’étapes de configuration logicielle spécifiques.

Quick start

- Lisez l’article pour comprendre les pièges ML courants : qualité des données (étiquetages, variables cachées, corrélations fallacieuses), leakage et biais temporel.

- En concevant un modèle, inspectez ce que le modèle utilise pour décider. Si une carte de saliency souligne des caractéristiques de fond, attendez-vous à une faible généralisation.

- Vérifiez les fuites de données. Assurez-vous que tout prétraitement, normalisation ou sélection de features est effectué après la division train/test. Soyez particulièrement prudent avec les séries temporelles où des informations futures peuvent fuir dans l’entraînement.

- Évaluez la qualité des étiquetages. Vérifiez les biais d’annotation et les taux d’étiquetage incorrect pour éviter des comparaisons trompeuses.

- Envisagez des approches de robustesse plus simples avant de recourir à des défenses coûteuses. Si la force apparente du modèle dépend de signaux fallacieux, investissez dans la curation des données et une évaluation appropriée plutôt que dans des entraînements adverses lourds.

- Utilisez la checklist REFORMS pour documenter les provenance des données, les choix de modélisation et les procédures d’évaluation afin d’améliorer la transparence et la reproductibilité.

Avantages et inconvénients

- Avantages :

- Met en lumière des modes d’échec pratiques souvent négligés en milieu académique.

- Met l’accent sur la qualité des données, le contrôle des fuites et l’explicabilité comme piliers du ML robuste.

- Recommande un cadre d’évaluation structuré (REFORMS) pour améliorer la confiance.

- Inconvénients :

- Certaines stratégies de mitigation (p. ex. l’entraînement adversaire) peuvent être coûteuses et non always faisables dans tous les projets.

- Le guide est de haut niveau et peut nécessiter une adaptation spécifique au domaine.

- L’exposé se concentre sur les pièges et l’évaluation et ne prescrit pas un workflow universel.

Alternatives (comparaisons succinctes)

| Approche | Cible | Avantages | Inconvénients |---|---|---|---| | Entraînement adversaire | Robustesse face à des attaques | Améliore la résilience | Coûts élevés; ne résout pas nécessairement leakage ou données de mauvaise qualité |Explicabilité post-trêin | Comprendre les décisions | Aide à détecter l’usage de signaux non pertinents | Les explications peuvent être hétérogènes; pas toujours refléter causalité |Nettoyage des données (data-centric) | Amélioration de la qualité des données et des étiquetages | Gains fréquents sans complexité de modèle | Nécessite travail sur les données; peut être long |Protocoles d’évaluation rigoureux | Expériences transparentes et reproductibles | Améliore la confiance et la comparabilité | Demande discipline et documentation; peut ralentir l’itération |

Prix ou Licence

Non spécifié dans l’article source.

Références

- Why Doesn’t My Model Work? — The Gradient https://thegradient.pub/why-doesnt-my-model-work/

More resources

IA Générale Non Multimodale : Intelligence axée sur l’Incarnation

Ressource concise expliquant pourquoi les approches multimodales axées sur l’échelle risquent de ne pas aboutir à une AGI et pourquoi l’incarnation et les modèles du monde sont essentiels.

Forme, Simétries et Structure: Le rôle changeant des mathématiques dans la recherche ML

Examine comment les mathématiques restent centrales en ML, mais leur rôle évolue vers la géométrie, les symétries et les explications post-hoc à l’ère des grandes échelles.

Ce qui manque aux chatbots LLM : un sens de l'objectif

Explore le dialogue orienté objectif dans les chatbots LLM, soutenant que les échanges multi-tours s'alignent mieux sur les objectifs des utilisateurs et favorisent la collaboration, notamment pour le code et les assistants personnels.

Visions positives de l'IA fondées sur le bien-être

Cadre centré sur le bien-être pour des IA bénéfiques, associant sciences du bien-être, économie et gouvernance pour tracer des visions pragmatiques et actionnables.

Applications des LLMs au marché financier — aperçu et cas d'utilisation

Aperçu de comment les LLMs peuvent être appliqués aux marchés financiers, incluant la modélisation autoregressive des données de prix, l’intégration multimodale, la résidualisation, les données synthétiques et les prévisions sur plusieurs horizons.

Vue d’ensemble sur les biais de genre dans l’IA

Synthèse des travaux clés mesurant les biais de genre dans l’IA, couvrant les embeddings, la co-référence, la reconnaissance faciale, les benchmarks QA et la génération d’images; discussion sur les mitigations et les lacunes.