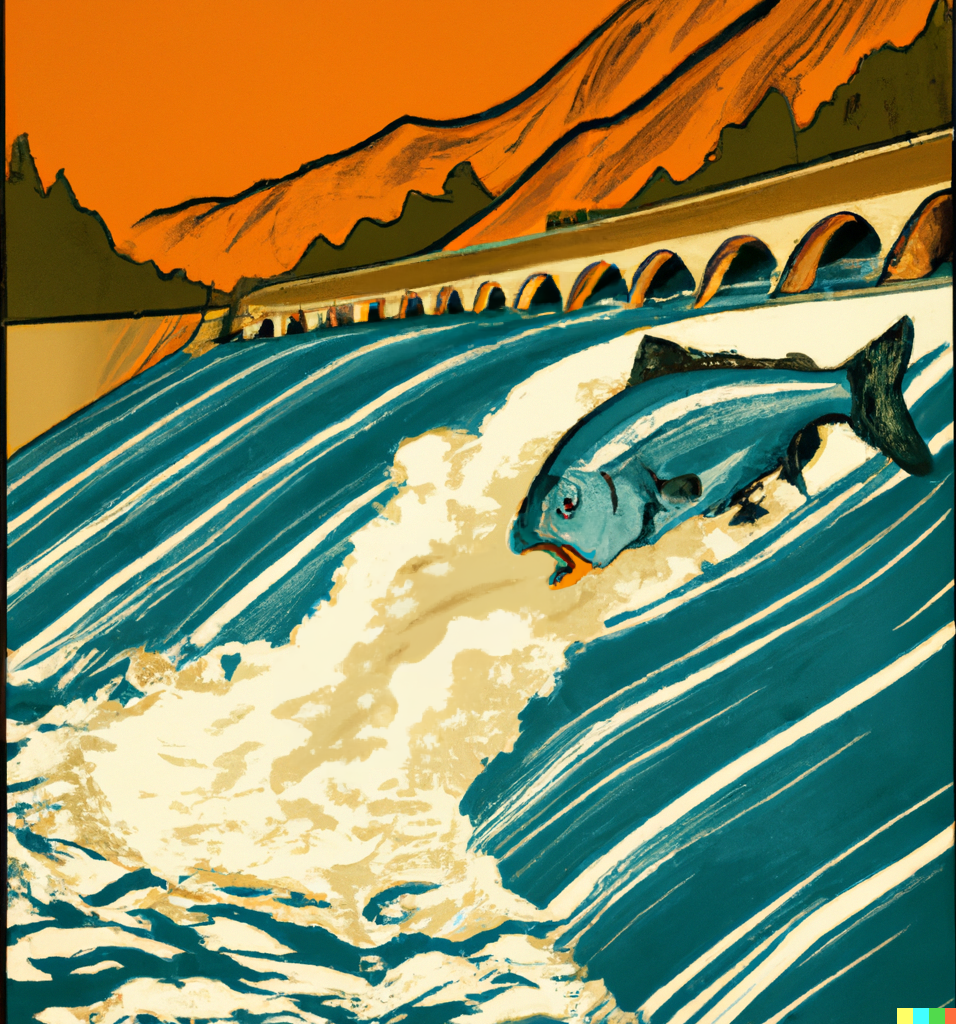

Salmon in the Loop : Comptage des poissons avec intervention humaine sur les barrages hydroélectriques

Sources: https://thegradient.pub/salmon-in-the-loop, https://thegradient.pub/salmon-in-the-loop/, The Gradient

Aperçu

Salmon in the Loop examine un problème sociotechnique complexe—compter les poissons dans un domaine en transformation numérique. L’auteur a travaillé comme consultant dans un sous-domaine des sciences environnementales axé sur le comptage des poissons qui passent par de grands barrages hydroélectriques, mettant en lumière comment la production de données avec une boucle humaine s’insère dans l’apprentissage automatique dans un contexte fortement réglementé. Le texte situe le comptage des poissons dans le cadre de la réglementation de la FERC (Federal Energy Regulatory Commission), une agence indépendante des États‑Unis qui régule la transmission et la vente en gros d’électricité et délivre des licences et permis pour construire et exploiter les barrages, veillant à ce que ces installations soient sûres, fiables et respectueuses de l’environnement. Les barrages fonctionnent comme de grandes batteries, accumulant de l’eau puis la déversant pour faire tourner des turbines; cette conversion entraîne des perturbations dans les voies navigables et peut affecter les populations de poissons, notamment les salmonidés de la région du Pacifique Nord-Ouest. Pour démontrer la conformité, les opérateurs collectent des données sur les passages des poissons, qui servent de base à l’évaluation des impacts et à l’orientation des décisions opérationnelles. La collecte de données est souvent manuelle et irrégulière: des Observateurs formés comptent visuellement les poissons qui passent, en consignent des attributs tels que maladie, origine (élevage vs sauvage) et d’autres caractéristiques observables. Ces classifications sont subtiles et nécessitent une expertise; des erreurs peuvent provenir de la transcription, de la classification des espèces ou d’un signalement incohérent. Le défi consiste à harmoniser des ensembles de données hétérogènes produits selon des normes différentes et à les traduire en entrées fiables pour évaluer les effets des barrages sur les populations de poissons. Le texte note un intérêt croissant pour l’utilisation de la vision par ordinateur et de l’apprentissage automatique afin d’automatiser les comptages, tout en conservant l’intégrité scientifique et la traçabilité — une application typique d’un système homme-en-boucle (HITL) qui combine le jugement expert et la constance algorithmique. Un fil conducteur pratique est la définition du problème: impliquer les parties prenantes pour délimiter les tâches que le système doit accomplir (par exemple l’identification des espèces, les stades de vie) et fixer des objectifs de performance dans un cadre réglementaire. Si l’objectif est d’estimer la densité de population lors de passages importants, la capture vidéo peut être privilégiée; si l’objectif est d’identifier une maladie ou une blessure lorsque les passages sont rares, des images fixes et leur étiquetage partiel peuvent suffire. L’auteur décrit un éventail de choix d’implémentation, depuis un détecteur « poisson en mouvement » qui déclenche la capture d’images et les confie ensuite à un expert pour étiquetage, jusqu’à un classificateur entraîné pour catégoriser les espèces rares. Dans des domaines réglementés comme l’industrie hydraulique, la crédibilité repose sur des tests rigoureux, l’intégrité des données, la transparence des algorithmes et la responsabilité, qui façonnent la conception et l’évaluation des systèmes HITL. L’objectif pratique souvent cité est que les comptes automatisés atteignent une précision opérationnelle proche ou équivalente à celle des comptes humains, avec un seuil courant autour de 95%, tout en reconnaissant les limites réelles du cycle de production et de la surveillance réglementaire. Ce contexte est essentiel pour les organisations qui veulent moderniser leurs flux de données sans compromettre la conformité environnementale.

Caractéristiques clés (perspectives)

- Production de données avec intervention humaine pour la curation et la validation des jeux de données.

- Alignement réglementaire avec les exigences de la FERC et les objectifs de conservation.

- Données hétérogènes, avec des granularités et des couvertures temporelles variables selon les opérateurs.

- Comptage visuel par des observateurs formés avec des classifications supplémentaires (santé, origine, etc.).

- Passage possible vers la vision par ordinateur et le ML tout en préservant la fiabilité et l’auditabilité.

- Négociation du cadre du problème et alignement avec les parties prenantes comme étape fondamentale.

- Objectifs de performance réalistes dans un contexte réglementaire.

- Intégration de flux vidéo et d’images fixes pour soutenir l’étiquetage et l’entraînement des classificateurs.

Caractéristiques clés

- Construction et curation de jeux de données avec intervention humaine.

- Orientation réglementaire FERC et considerations environnementales.

- Pratiques de collecte de données variées entre opérateurs et runs.

- Comptage visuel par des experts avec d’autres classifications (santé, origine).

- Vers une vision par ordinateur avec un accent sur la fiabilité.

- Négociation du cadre du problème avec les parties prenantes.

- Cibles de performance réalistes dans un cadre réglementaire.

- Intégration de diverses sources de données pour former les modèles.

Cas d’utilisation courants

- Comptages automatisés pour démontrer la conformité et surveiller les tendances des populations.

- Tâches de classification liées à la santé, les blessures et l’origine (sauvage vs élevage).

- Identification d’espèces et de stades de vie pour éclairer les dynamiques et la gestion.

- Surveillance en temps quasi réel du passage des poissons afin d’évaluer les opérations des barrages.

- Amélioration de la qualité des données via des processus HITL qui réduisent les erreurs de transcription et de classification.

- Intégration des passages de poissons avec les données opérationnelles pour comprendre les impacts.

- Conception et évaluation de flux de travail capables de s’étendre à plusieurs barrages avec des données variées.

Setup & installation

Aucune instruction précise de configuration ou d’installation n’est fournie dans la source. Le contenu met l’accent sur des considérations de haut niveau et des processus (définir l’espace du problème, établir des objectifs de performance, choisir des stratégies de capture de données et concevoir des flux HITL) plutôt que sur des étapes techniques ou des commandes logicielles. Remarques à retenir :

- Impliquer les parties prenantes pour définir les tâches du système.

- S’aligner sur les contraintes réglementaires (intégrité des données, transparence, conformité).

- Choisir entre les modalités de données (vidéo pour observer le mouvement, images fixes pour l’étiquetage précis).

- Prévoir des pratiques de données hétérogènes et des cycles saisonniers.

- Planifier des flux HITL où des experts étiquettent les données, ce qui alimente l’entraînement et la validation des modèles.

N/ADémarrage rapide

Le texte propose une trajectoire pratique non axée sur le code. Un schéma minimal, inspiré du contenu, serait:

- Étape 1 : Définir l’espace du problème avec les parties prenantes, préciser les tâches que le système doit accomplir (p. ex. identification des espèces, évaluation de la santé, signalement d’anomalies).

- Étape 2 : Établir des objectifs de performance réalistes dans un cadre réglementaire (par exemple viser une grande précision par rapport aux comptages humains).

- Étape 3 : Choisir la stratégie de collecte des données (capture vidéo pour observer les mouvements ou images fixes pour l’étiquetage précis) et déterminer où aura lieu l’étiquetage.

- Étape 4 : Constituer un jeu de données annoté par des experts (espèces, stade de vie, état de santé, origine) et documenter les incertitudes.

- Étape 5 : Construire un pipeline ML léger fonctionnant avec une vérification humaine, en partant d’un détecteur simple vers un classificateur.

- Étape 6 : Valider les sorties du modèle contre les comptes humains et mettre à jour les données pour améliorer la fiabilité.

- Étape 7 : Déployer avec une gouvernance axée sur la transparence, la traçabilité et l’auditabilité, en assurant la conformité à la supervision de la FERC.

- Étape 8 : Surveiller les performances et ajuster les processus de collecte et d’étiquetage au besoin. Ce parcours reflète l’accent mis sur le cadrage du problème, l’alignement des parties et l’approche HITL comme voie pragmatique de l manual vers l’automatisation, tout en préservant la responsabilité.

Avantages et inconvénients

- Avantages

- Potentiel d’une meilleure constance et d’un débit plus élevé grâce à l’automatisation.

- Diminution de la charge manuelle de collecte de données et retour d’information plus rapide.

- Le HITL conserve le jugement expert, renforçant la confiance et la conformité.

- Capacité à exploiter des données variées (vidéo, images) et à les intégrer à des données opérationnelles.

- Inconvénients

- La surveillance réglementaire exige des validations rigoureuses, de la transparence et l’intégrité des données, ce qui peut ralentir le déploiement.

- Données hétérogènes entre opérateurs compliquent la standardisation.

- Des objectifs de précision élevés peuvent être difficiles à atteindre dans certains contextes opérationnels.

- Concevoir et maintenir des flux HITL requiert des ressources humaines et une gouvernance continue.

Alternatives (comparaisons rapides)

- Comptages manuels par des observateurs formés : avantages pour la profondeur du jugement, inconvénients pour les erreurs de transcription et l’évolutivité.

- Vision par ordinateur sans HITL : avantages en termes de rapidité et de cohérence; inconvénients régulatoires et besoin d’une validation robuste.

- Systèmes HITL avec intégration modérée : équilibre entre automatisation et vérification humaine, en phase avec les exigences réglementaires, mais nécessitant une conception de flux efficace pour éviter les goulets d’étranglement.

- Approches hybrides (captation vidéo en direct pour les cas rares, étiquetage sélectif d’images fixes) : permettent une étiquetage ciblé des cas limites avec une utilisation efficace du temps des experts.

Prix ou licence

Non spécifié dans la source.

Références

More resources

IA Générale Non Multimodale : Intelligence axée sur l’Incarnation

Ressource concise expliquant pourquoi les approches multimodales axées sur l’échelle risquent de ne pas aboutir à une AGI et pourquoi l’incarnation et les modèles du monde sont essentiels.

Forme, Simétries et Structure: Le rôle changeant des mathématiques dans la recherche ML

Examine comment les mathématiques restent centrales en ML, mais leur rôle évolue vers la géométrie, les symétries et les explications post-hoc à l’ère des grandes échelles.

Ce qui manque aux chatbots LLM : un sens de l'objectif

Explore le dialogue orienté objectif dans les chatbots LLM, soutenant que les échanges multi-tours s'alignent mieux sur les objectifs des utilisateurs et favorisent la collaboration, notamment pour le code et les assistants personnels.

Visions positives de l'IA fondées sur le bien-être

Cadre centré sur le bien-être pour des IA bénéfiques, associant sciences du bien-être, économie et gouvernance pour tracer des visions pragmatiques et actionnables.

Applications des LLMs au marché financier — aperçu et cas d'utilisation

Aperçu de comment les LLMs peuvent être appliqués aux marchés financiers, incluant la modélisation autoregressive des données de prix, l’intégration multimodale, la résidualisation, les données synthétiques et les prévisions sur plusieurs horizons.

Vue d’ensemble sur les biais de genre dans l’IA

Synthèse des travaux clés mesurant les biais de genre dans l’IA, couvrant les embeddings, la co-référence, la reconnaissance faciale, les benchmarks QA et la génération d’images; discussion sur les mitigations et les lacunes.