Por que meu modelo não funciona? Armadilhas comuns de ML e como evitá-las

Sources: https://thegradient.pub/why-doesnt-my-model-work, thegradient.pub

TL;DR

- Sucesso em treinamento ou em dados de teste não garante utilidade no mundo real; a qualidade dos dados e a avaliação importam mais do que a simplicidade do modelo.

- Variáveis ocultas e correlações espúrias podem levar a alta acurácia sem aprender o sinal real da tarefa, levando a generalização ruim.

- Vazamento de dados, preprocessamento inadequado e viés de look-ahead em séries temporais podem produzir métricas de desempenho excessivamente otimistas.

- Correções práticas incluem verificar o que o modelo realmente usa, considerar robustez a adversários e seguir guias como o REFORMS.

- Tomar ciência desses truques ajuda equipes a melhorar reprodutibilidade, confiança e resultados no mundo real. source

Contexto e antecedentes

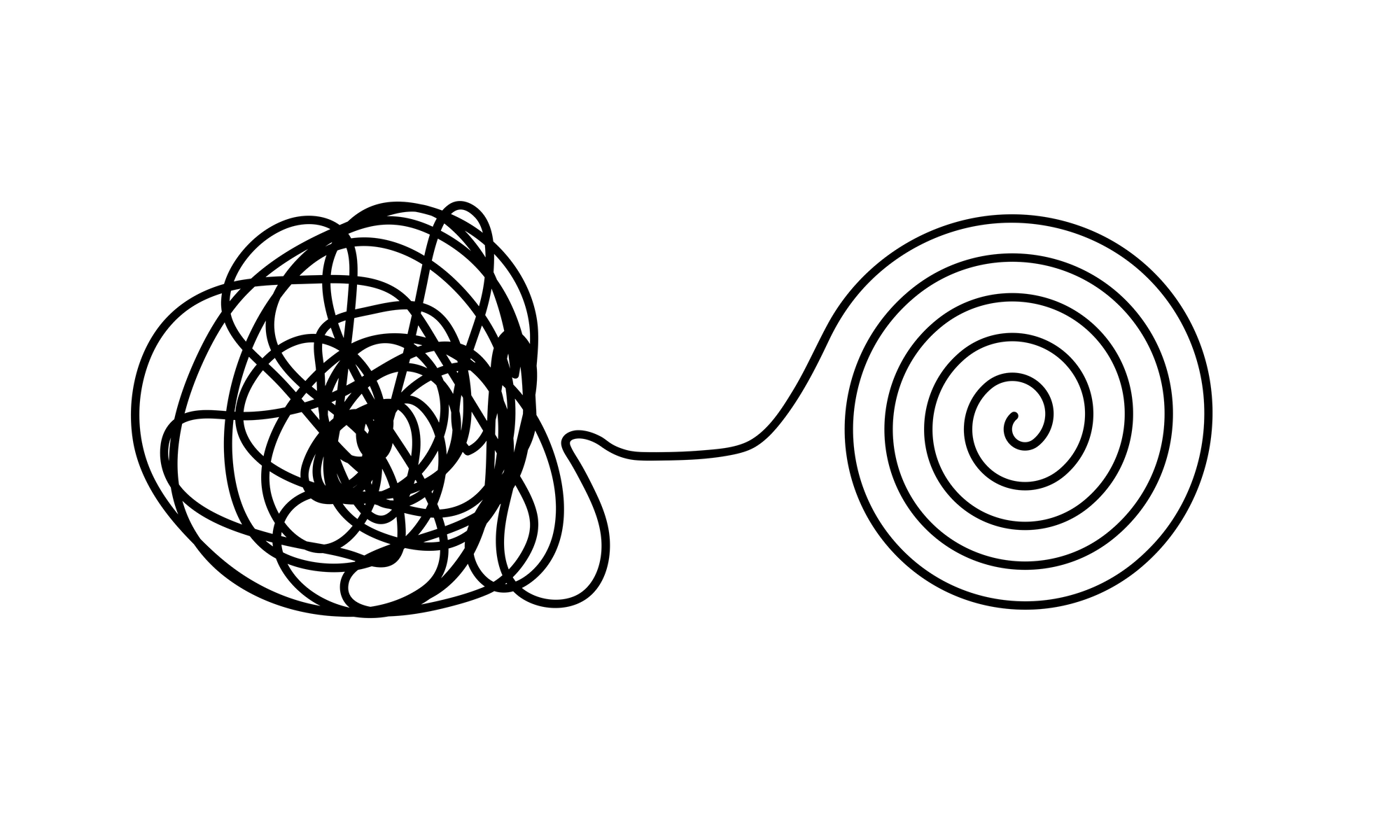

O artigo enfatiza que o aprendizado de máquina depende de dados, e todo o processo pode ser comprometido por problemas de qualidade de dados. Dados enganosos, rótulos incorretos e fatores escondidos podem fazer com que um modelo pareça eficaz apenas em um conjunto de teste, mas tenha utilidade limitada no mundo real. O conceito de garbagem de entrada resulta em garbagem de saída: modelos podem obter altas pontuações em teste sem realmente aprender o sinal útil. O texto cita trabalhos sobre Covid-19 e a emergência de conjuntos de dados públicos com sinais enganosos—como registros que se sobrepõem, rótulos incorretos e variáveis ocultas—que levaram classificadores a dependerem de indícios não relevantes para o verdadeiro problema. source Variáveis ocultas são características presentes nos dados que estão correlacionadas com o rótulo, mas não são causalmente relacionadas ao fenômeno estudado. Em conjuntos de imagens de tórax de Covid, por exemplo, a orientação do paciente poderia correlacionar com o status da doença, levando o modelo a aprender postura em vez do sinal da doença. Mesmo quando variáveis ocultas não são óbvias, classificadores podem se apoiar em marcas de fronteira, marcas d’água ou carimbos de tempo que distinguem classes sem considerar o sinal real. Tal dependência pode gerar bom desempenho em dados familiares, mas falhar em cenários novos. source Correlações espúrias são padrões que se correlacionam com rótulos sem relação causal real. Em benchmarks de visão computacional, por exemplo, fundos ou cores de pixels podem se correlacionar com classes; redes profundas captam essas pistas com facilidade, o que reduz a generalização e aumenta sensibilidade a pequenas perturbações adversárias. O treinamento adversarial pode ajudar, mas é caro; uma abordagem mais simples é examinar para quais informações o modelo recorre ao tomar decisões, por exemplo, por meio de mapas de saliência. source Qualidade de rotulagem também importa. Rótulos feitos por humanos podem introduzir vieses ou erros que distorcem a avaliação, especialmente em benchmarks de classificação de imagens. Mesmo taxas de rotulagem de alguns por cento podem influenciar comparações quando diferenças de acurácia entre modelos são mínimas. Em tarefas com subjetividade, há risco de overfitting a rotuladores específicos. source Dados não são a única fonte de problemas. Vazamento de dados e preprocessamento dependente de dados podem expor informações do conjunto de teste ou usar informações do conjunto inteiro antes da divisão. Operações como centralização e normalização de todas as características, seleção de recursos, redução de dimensionalidade e aumentos de dados podem incorporar conhecimento do conjunto inteiro, inflando artificialmente o desempenho. Em séries temporais, o look-ahead bias pode ocorrer quando dados futuros vazam no treinamento. source Casos de vazamento de dados mais complexos aparecem quando técnicas de transformação dependentes de dados são aplicadas antes da separação treino-teste, fazendo com que o conjunto de teste contenha amostras aumentadas de dados de treino, e vice-versa. Quando corrigidos, o desempenho tende a cair para próximos do acaso. Esses exemplos ilustram como decisões aparentemente menores no pipeline podem distorcer avaliações.” source Em resumo, muitos modelos que parecem bem-sucedidos não falham por causa da teoria, mas por causa dos dados e das práticas de avaliação ao redor. O artigo também destaca a promoção de guias de boas práticas, incluindo a checklist REFORMS para ciência baseada em ML, como forma de estruturar a prevenção desses problemas. source

O que há de novo

A ideia central é que a conscientização sobre armadilhas de dados está aumentando, e estruturas práticas estão sendo promovidas para combatê-las. A checklist REFORMS é apresentada como ferramenta para guiar trabalhos científicos com ML, ajudando pesquisadores a projetar experimentos menos suscetíveis a vazamentos, vieses e overfitting. O texto também cita a existência de pesquisas que documentam falhas durante a pandemia de Covid e outros casos, reforçando que esses problemas são parte de desafios metodológicos mais amplos. source

Por que isso importa (impacto para desenvolvedores/empresas)

Para desenvolvedores e empresas, as lições se traduzem em ações concretas: investigar a qualidade de dados e rótulos, verificar se o modelo usa sinais reais ou apenas características de fundo, auditar pipelines de preprocessamento para evitar vazamento temporal ou de dados, e validar modelos com conjuntos de teste totalmente independentes. O risco é duplo: modelos que performam bem no papel, mas falham na prática, e uma erosão da confiança em resultados científicos quando dados não confiáveis levam a conclusões equivocas. Adotar checagens proativas e diretrizes como REFORMS pode melhorar a confiabilidade e generalização de sistemas de ML em diversos domínios. source

Detalhes técnicos ou Implementação

Variáveis ocultas e correlações espúrias

Modelos podem depender de características preditivas no conjunto de treinamento, mas que não têm relação causal com o alvo. Ferramentas como mapas de saliência ajudam a identificar se o modelo está focado em áreas de fundo em vez do sinal de interesse. Se a explicação aponta para elementos contextuais, a generalização pode estar comprometida. A prática de treinamento adversarial pode mitigar alguns desses problemas, porém é custosa; uma verificação inicial baseada em entendimento do modelo costuma ser mais acessível. source

Qualidade e viés de rotulagem

Rotulagem humana pode introduzir vieses ou erros que distorcem avaliações, especialmente em benchmarks de classificação de imagens. Mesmo marginais taxas de rotulagem incorreta podem influenciar comparações entre modelos quando diferenças de acurácia são pequenas. Em tarefas com subjetividade, pode ocorrer overfitting a estilos de rotuladores específicos. source

Vazamento de dados e preprocessamento dependente de dados

Executar transformações em todo o conjunto antes de separá-lo em treino/teste pode vazar informações do teste para o treinamento. Técnicas como centralização, normalização, seleção de recursos e aumentos dependentes de dados devem ser confinadas ao conjunto de treino, para evitar inflar métricas de teste. Vazamentos de dados são especialmente problemáticos em séries temporais, onde o look-ahead bias é comum. source

Riscos adversariais e mecanismos de avaliação

Correlações de fundo podem tornar o modelo sensível a perturbações mínimas de entrada. O treinamento adversarial oferece uma via de mitigação, mas pode exigir recursos significativos. O exame de mapas de saliência e alinhamento com intuição humana também ajuda a detectar dependência de cues não desejados. source

Séries temporais e armadilhas de look-ahead

Casos de previsão em séries temporais são particularmente vulneráveis a vazamentos de dados futuros. Revisões de falhas e melhores práticas em avaliação de modelos de séries temporais são recomendadas para evitar esse problema. Um exemplo documentado envolve datasets onde dados futuros moldaram o treinamento, gerando desempenho inflado. source

Casos de leakage com aumento de dados

Estudos sobre predição de parto prematuro mostraram que o aumento aplicado antes da divisão de dados elevou a acurácia; ao corrigir esse vazamento, o desempenho caiu para níveis próximos ao acaso. Isso demonstra como transformações de dados podem distorcer avaliações se não forem isoladas do conjunto de teste. source

remediações práticas e governança

Além de soluções técnicas, adotar uma mentalidade de avaliação estruturada ajuda. A checklist REFORMS para ciência baseada em ML é apresentada como enquadramento prático para reduzir armadilhas e melhorar reprodutibilidade. Pesquisadores são encorajados a incorporar essas checagens no fluxo de trabalho para promover transparência e confiabilidade. source

Principais conclusões

- Qualidade de dados e integridade de rotulagem são fundamentais; dados defeituosos podem mascarar desempenho real.

- Variáveis ocultas e pistas espúrias podem comprometer a generalização e devem ser verificadas com ferramentas de explicabilidade.

- Vazamento de dados e viés de look-ahead em preprocessamento e em séries temporais podem inflar métricas.

- Robustez a adversários é relevante, mas deve ser acompanhada de checagens práticas baseadas em dados e validação adequada.

- Governança estruturada, incluindo checklists como REFORMS, ajuda equipes a evitar armadilhas comuns e a melhorar reprodutibilidade. source

FAQ

-

O que é vazamento de dados?

Vazamento de dados ocorre quando o pipeline de treinamento tem acesso a informações que não deveria ter, especialmente informações que ajudam o modelo. Isso pode ocorrer por operações de preprocessamento feitas no conjunto inteiro antes da divisão em treino e teste. [source](https://thegradient.pub/why-doesnt-my-model-work)

-

Como as variáveis ocultas afetam o desempenho do modelo?

Variáveis ocultas são características que correlacionam com o rótulo, mas não estão relacionadas causalmente ao fenômeno real; o modelo pode depender delas, elevando a performance no conjunto de treino/teste, porém falhando em dados novos. [source](https://thegradient.pub/why-doesnt-my-model-work)

-

O que são correlações espúrias e por que são perigosas?

Correlações espúrias são padrões que se associam aos rótulos sem relação causal; modelos que as utilizam podem ter boa pontuação em dados conhecidos, mas não generalizam, falhando diante de variações reais. [source](https://thegradient.pub/why-doesnt-my-model-work)

-

ual o papel da checklist REFORMS?

REFORMS oferece um conjunto estruturado de boas práticas para reduzir armadilhas de ML, promovendo maior reprodutibilidade e confiabilidade na ciência baseada em ML. [source](https://thegradient.pub/why-doesnt-my-model-work)

Referências

- The Gradient: Why Doesn’t My Model Work? https://thegradient.pub/why-doesnt-my-model-work

More news

IA Geral Não é Multimodal: Embodimento e Ambiente no Núcleo da Inteligência

Uma visão crítica argumenta que a verdadeira AGI requer embodição física e interação com o mundo real, não um patchwork de modalidades ou apenas previsão baseada em linguagem.

Forma, Simetrias e Estrutura: O Papel Mutável da Matemática na Pesquisa de Aprendizado de Máquina

O artigo defende que a matemática continua essencial no ML, mas seu papel está se expandindo com a escala, a interdisciplinaridade e novas ferramentas para entender modelos complexos.

O que Falta aos Chatbots LLM: Um Senso de Propósito

Exame sobre por que os chatbots LLM normalmente carecem de propósito e como diálogos orientados a objetivos, memória e troca de turnos podem remodelar a colaboração humano–IA, fluxos de codificação e assistência pessoal.

Precisamos de Visões Positivas de IA Fundamentadas no Bem-Estar

Uma análise aprofundada defendendo visões pragmáticas de IA centradas no bem-estar humano e na saúde da sociedade, com caminhos práticos para desenvolvimento e implantação responsáveis.

Aplicações de Mercado Financeiro de LLMs: Da Teoria à Visão Multimodal de Trading

Explora como Grandes Modelos de Linguagem (LLMs) se cruzam com finanças, incluindo desafios de dados em escala, abordagens multimodais, residualização e dados sintéticos, com base na análise da The Gradient sobre implicações de IA para o mercado.

Uma Visão Geral do Viés de Gênero na IA: de Embeddings de Palavras a LLMs

Uma visão sintética de como o viés de gênero surge em sistemas de IA — desde embeddings de palavras tendenciosos até reconhecimento facial e modelos de linguagem grande — e como pesquisadores medem, mitigam e discutem essas questões.