¿Por qué no funciona mi modelo? Errores comunes de ML y cómo solucionarlos

Sources: https://thegradient.pub/why-doesnt-my-model-work, thegradient.pub

TL;DR

- Los modelos pueden parecer buenos en datos de prueba y, sin embargo, fallar en el mundo real a causa de datos deficientes, variables ocultas y correlaciones espurias.

- Causas comunes incluyen datos engañosos, etiquetado sesgado, filtración de datos y sesgo de mirar hacia adelante en series temporales.

- Detectar qué usa realmente el modelo (p. ej., mediante mapas de saliencia) y reducir la dependencia de pistas de fondo son pasos clave; el entrenamiento adversarial ayuda, pero es costoso.

- Se discute recientemente una herramienta: la checklist REFORMS para la ciencia basada en ML, destinada a reforzar prácticas y confianza en la investigación ML. Consulte el artículo para detalles y contexto. The Gradient aborda estas trampas y medidas prácticas para evitarlas. El texto también alude a preocupaciones más amplias sobre reproducibilidad y utilidad real cuando los modelos explotan señales espurias.

Contexto y antecedentes

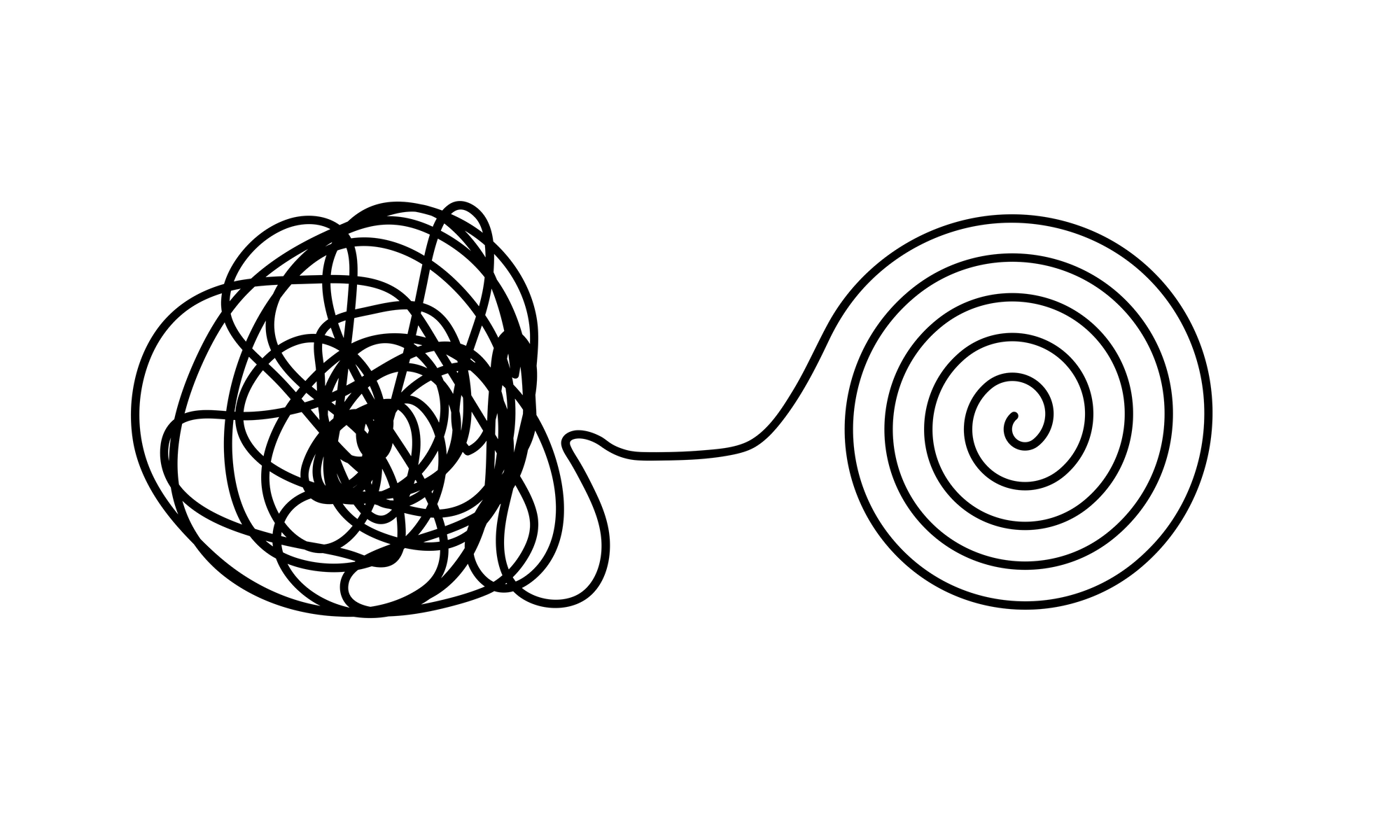

Los procesos de aprendizaje automático son intrínsecamente complejos, y es fácil caer en trampas que producen sobreajuste o un rendimiento de prueba engañosamente alto sin utilidad en el mundo real. El artículo señala que, a lo largo de aproximadamente dos décadas de experiencia, los investigadores han observado errores y consecuencias repetidamente. En años recientes, estas cuestiones han sido objeto de atención tanto en la prensa científica como en la popular, incluyendo casos donde modelos de Covid fallaron al generalizar y donde otras implementaciones de ML produjeron resultados engañosos o peligrosos. El texto cita el repositorio AIAAIC como colección de ejemplos documentados y enfatiza que fallos pueden contribuir a una crisis de reproducibilidad en la ciencia. El mensaje clave es que datos mal usados y evaluaciones inadecuadas pueden generar modelos confiados pero poco útiles. Un recordatorio central es que todo el pipeline de ML depende de los datos: datos de entrenamiento, datos de prueba y la forma en que se preparan. Cuando los datos son engañosos o no representativos, el modelo puede apoyarse en señales que no reflejan la tarea real.

¿Qué hay de nuevo?

Un punto notable es la introducción de una checklist para mejorar la ciencia basada en ML: REFORMS. El texto presenta la checklist como una herramienta práctica para que los investigadores aumenten el rigor metodológico y reduzcan conclusiones inexactas en trabajos de ML. El texto sitúa REFORMS dentro de un esfuerzo más amplio para incrementar la transparencia y la fiabilidad de la ciencia impulsada por ML. Para lectores interesados en un enfoque estructurado para evaluar experimentos ML, esta checklist se presenta como un recurso útil.

Por qué importa (impacto para desarrolladores/empresas)

- Generalización insuficiente va más allá de las métricas de overfitting; los modelos pueden rendir bien en pruebas y fallar en el mundo real si los datos contienen variables ocultas, etiquetado sesgado o correlaciones espurias.

- Las variables ocultas existen en los datos y pueden predecir etiquetas sin ser causalmente relevantes para la tarea. Por ejemplo, en algunos conjuntos de imágenes de Covid, la orientación del cuerpo coincidió con el estado de la enfermedad debido a cómo se obtuvieron las imágenes, no por señales de la enfermedad.

- Las correlaciones espurias son patrones que se correlacionan con las etiquetas sin relación causal real; los modelos profundos tienden a captar estos patrones, afectando la generalización.

- La filtración de datos y el sesgo de mirar hacia adelante pueden inflar las métricas reportadas. Practicas que usan información de todo el conjunto de datos antes de dividir entrenamiento y prueba permiten que la información del test influya en el entrenamiento, produciendo métricas excesivamente optimistas.

- El entrenamiento adversarial puede ayudar a mitigar algunos problemas, pero es costoso; controles más simples, como inspeccionar en qué información se basa el modelo, pueden revelar dependencia de señales de fondo.

- El artículo subraya la importancia de evaluaciones robustas y la adopción de guías formales (REFO…MS) para fortalecer la reproducibilidad y fiabilidad de la ciencia basada en ML.

Detalles técnicos o Implementación

El artículo destaca varios modos de fallo concretos y ofrece orientación sobre detección y mitigación. A continuación se presenta un resumen de las cuestiones clave, qué son, ejemplos y cómo detectarlas: | Problema | Qué es | Ejemplo del dominio | Cómo detectar o abordar |---|---|---|---| | Variables ocultas | Características presentes en los datos que predicen etiquetas sin relación causal | En imágenes Covid, la orientación del cuerpo correlaciona con el estado de la enfermedad | Usar herramientas de explicabilidad para ver en qué se fija el modelo; revisar los datos para señales no relacionadas con la tarea |Correlaciones espurias | Patrones que se correlacionan con etiquetas sin relación causal | Pistas de fondo o color en los píxeles para clasificar imágenes | Verificar pistas de fondo; realizar pruebas con cambios de fondo; ser cauteloso con sesgos en conjuntos de benchmarks |Filtración de datos | Información del conjunto de prueba filtrando en el entrenamiento | Preprocesamiento dependiente de datos aplicado a todo el conjunto antes de la separación | Asegurar que el preprocesamiento se realiza solo con datos de entrenamiento; garantizar la independencia de la prueba |Sesgo de anticipación (look-ahead) | Disponibilidad de información futura durante el entrenamiento | Predicciones de series temporales que usan datos futuros respecto a la prueba | Alinear correctamente las divisiones de entrenamiento/prueba; revisar prácticas de evaluación de series temporales |Ruido de etiquetas | Etiquetado humano inexacto o sesgado | Benchmarks como MNIST y CIFAR con tasas de error de etiqueta conocidas | Reconocer la incertidumbre de etiquetas y evaluar la robustez frente al ruido |Aumento de datos con filtración | Aumento aplicado antes de la división, filtrando los datos de prueba | Estudio que logra alta precisión solo tras aumentos previos a la división | Separar claramente las etapas de aumento y división de datos; reproducir sin filtración | Además de estas cuestiones, el artículo enfatiza la importancia de las herramientas de explicabilidad. Si los mapas de saliencia muestran que el modelo se centra en regiones de fondo, esto indica un problema de generalización. El entrenamiento adversarial puede ayudar, pero es costoso; enfoques más simples como revisar lo que utiliza el modelo pueden revelar dependencias de señales de fondo. Se recomienda una postura pragmática: examinar la información que utiliza el modelo y confiar en evaluaciones bien diseñadas en lugar de depender de soluciones caras.

Ideas clave para llevar a la práctica

- Las métricas de prueba sólidas no garantizan eficacia real; la calidad de los datos, el etiquetado y el pipeline de evaluación son determinantes.

- Cuidado con variables ocultas y correlaciones espurias que permiten al modelo rendir bien sin entender la tarea.

- Protege contra filtraciones de datos aislando los pasos de preprocesamiento y manteniendo el conjunto de prueba independiente.

- En series temporales, presta especial atención al sesgo de anticipación, especialmente cuando el entrenamiento usa datos futuros.

- Utiliza herramientas de explicabilidad para validar que el modelo se centra en características relevantes; prioriza verificaciones menos costosas antes de recurrir al entrenamiento adversarial.

- Considera adoptar REFORMS como checklist estructurada para mejorar la rigurosidad y la transparencia de la ciencia ML.

Preguntas Frecuentes

-

¿Qué significa garbage in, garbage out en este contexto?

Se refiere a la situación en que un modelo obtiene un rendimiento alto en la prueba pero no resulta útil en la práctica porque los datos contienen señales o artefactos engañosos que no reflejan la tarea real.

-

¿Cómo saber si mi modelo usa variables ocultas o correlaciones espurias?

El artículo sugiere usar herramientas de explicabilidad (p. ej., mapas de saliencia) para ver en qué se enfoca el modelo; si se centra en señales de fondo, indica dependencia problematica.

-

¿Qué es la filtración de datos y cómo evitarla?

La filtración de datos ocurre cuando información del conjunto de prueba se filtra en el entrenamiento; para evitarlo, aísla el preprocesamiento y garantiza la independencia del test.

-

¿Qué es el sesgo de anticipación y por qué importa para predicciones de series temporales?

Es cuando se dispone de información futura durante el entrenamiento, inflando artificialmente las métricas de prueba; asegúrate de que las divisiones de train/test respeten la secuencia temporal.

-

¿Qué es REFORMS y por qué se menciona aquí?

REFORMS es una checklist recientemente presentada para guiar la ciencia ML con mayor rigor y transparencia, ayudando a evitar errores comunes en la evaluación y la divulgación de resultados ML.

Referencias

- The Gradient: Why Doesn’t My Model Work? https://thegradient.pub/why-doesnt-my-model-work

More news

La AGI No es Multimodal: Encarnación, Modelos del Mundo y los Límites de la Escala

Una perspectiva crítica sostiene que la verdadera AGI requiere una comprensión encarnada del mundo físico, no solo procesamiento multimodal. El artículo advierte que los enfoques multimodales pueden no conducir a una inteligencia de nivel humano y explica por qué la encarnación y la interacción con

Forma, Simetrías y Estructura: El papel cambiante de las matemáticas en la investigación de ML

Explora cómo las matemáticas siguen siendo centrales en el aprendizaje automático mientras el campo avanza hacia la escala, la interdisciplinaridad y herramientas geométricas para entender modelos, pesos y simetrías de datos.

Qué le falta a los chatbots LLM: un sentido de propósito

Los chatbots basados en LLM siguen mejorando en los benchmarks, pero la experiencia del usuario podría no avanzar al mismo ritmo. Este artículo defiende un diálogo con propósito, multirondas y memoria, y examina su impacto para desarrolladores y empresas.

Necesitamos visiones positivas para la IA basadas en el bienestar

Llamado pragmático a anclar el progreso de la IA en el bienestar humano, describiendo por qué necesitamos visiones plausibles centradas en el bienestar y caminos concretos para investigadores y creadores.

Aplicaciones de LLMs en Mercados Financieros

Análisis de cómo los grandes modelos de lenguaje pueden aplicarse a series temporales financieras, datos multimodales y generación de datos sintéticos, con consideraciones prácticas.

Breve visión general del sesgo de género en la IA

Resumen sobre cómo el sesgo de género aparece en sistemas de IA, cubriendo embeddings, reconocimiento facial, resolución de anáforas y modelos de lenguaje a gran escala, con ejemplos y mitigaciones.