Memória Unificada com OpenACC para Modelagem do Oceano em GPUs (NVIDIA HPC SDK v25.7)

Sources: https://developer.nvidia.com/blog/less-coding-more-science-simplify-ocean-modeling-on-gpus-with-openacc-and-unified-memory, https://developer.nvidia.com/blog/less-coding-more-science-simplify-ocean-modeling-on-gpus-with-openacc-and-unified-memory/, NVIDIA Dev Blog

Visão geral

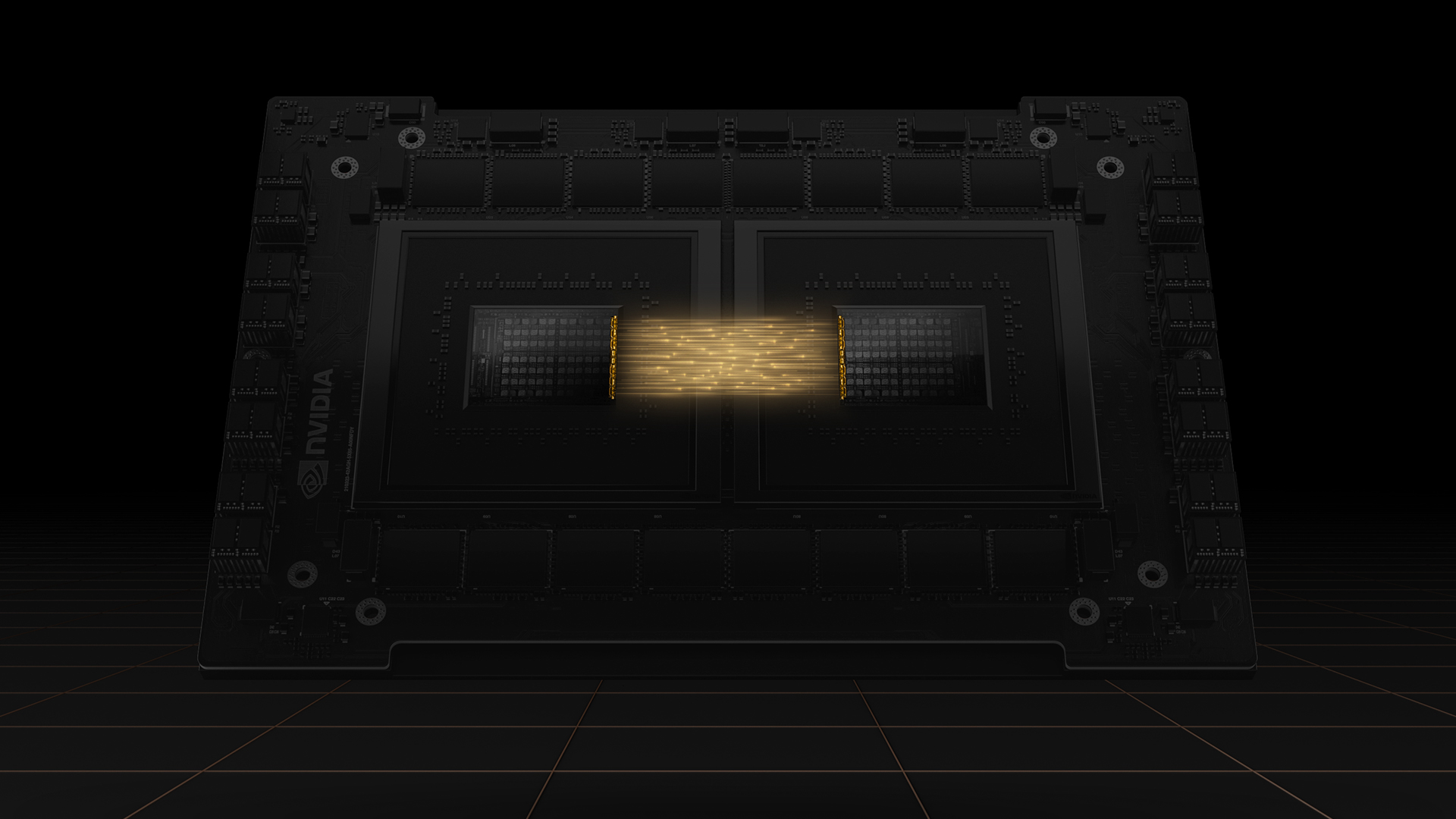

O NVIDIA HPC SDK v25.7 entrega um impulso significativo de produtividade para desenvolvedores que constroem aplicações HPC em GPUs. O foco é a memória unificada, fornecendo um conjunto completo de ferramentas que automatizam o movimento de dados entre CPU e GPU. Com um espaço de endereço compartilhado em plataformas coesas, como a família Grace Hopper, os programadores podem se concentrar na paralelização em vez de transfers manuais, graças ao movimento automático de dados gerenciado pelo driver CUDA. Essa abordagem acelera os ciclos de portabilidade para GPUs, reduz erros e oferece mais flexibilidade para otimizar workloads científicos. Entre os deployments notáveis estão o NVIDIA GH200 Grace Hopper Superchip e os sistemas GB200 NVL72, já usados na ALPS (CSCS) e no JUPITER (JSC). Essas plataformas combinam alto desempenho com alta largura de banda e coerência entre CPU e GPU, permitindo maior produtividade no aceleramento de códigos científicos. O modelo de memória unificada elimina grande parte das complexidades de gerenciamento de dados que historicamente atrasavam a portabilidade para GPUs. Em termos práticos, padrões de cópia profunda, tipos derivados e layouts de dados complexos podem ser paralelizados diretamente sem cópia explícita. O driver CUDA cuida das movimentações de memória, e a memória do sistema fica acessível tanto à CPU quanto à GPU, através de um espaço de endereços único. Desde o CUDA 12.4, migrações automáticas de páginas podem melhorar a localidade para páginas acessadas com frequência, elevando o desempenho em plataformas com Grace Hopper. Um ganho importante de produtividade é a capacidade de portar códigos reais com menos boilerplate de gerenciamento de dados. Como pesquisador, a memória unificada permite portear modelos oceânicos para GPUs com mais rapidez e experimentar com mais workloads em GPUs do que com abordagens tradicionais. O NEMO, um framework de modelagem oceânica, tem sido estudado de forma prática como evidência desses benefícios em cenários de HPC que envolvem Grace Hopper. O artigo também discute como o OpenACC e a memória unificada abordam desafios comuns de programação GPU. Por exemplo, o padrão de cópia profunda, em que um campo derivado com tipo alocado requer uma cópia adicional, torna-se mais simples com memória unificada. Da mesma forma, códigos em C++ com STL podem apresentar dificuldades sem memória unificada; com memória unificada, o acesso aos containers e aos seus elementos pode ser simplificado. No port do NEMO descrito no post, grande parte do gerenciamento de memória é automatizada pelo driver CUDA em plataformas Grace Hopper. Curvas de portabilidade geralmente começam com código em CPU, anotando laços críticos com OpenACC e movendo gradualmente as partes computacionais para a GPU, mantendo a corretude com execuções assíncronas. Resultados iniciais mostraram ganhos de desempenho na faixa de 2x a 5x para trechos portados, com melhoria global do fluxo de trabalho em torno de 2x quando o port completo é parcialmente acelerado. Esses resultados ilustram como memória unificada pode trazer ganhos de desempenho durante a portabilidade e ajudar equipes a explorar maior uso de GPUs mais cedo no projeto. Para pesquisadores e desenvolvedores, a principal conclusão é que a memória unificada — associada a interconexões de alta largura de banda e coerência de memória entre CPU e GPU — reduz a carga cognitiva da programação GPU, permitindo iterações mais rápidas, menos bugs e estratégias de otimização mais flexíveis em códigos científicos complexos. Referências sobre implantações Grace Hopper e cobertura de blogs de HPC fornecem contexto prático sobre capacidades arquiteturais e orientações de compiladores.

Fonte: NVIDIA Dev Blog: Less Coding, More Science: Simplify Ocean Modeling on GPUs With OpenACC and Unified Memory. Link: https://developer.nvidia.com/blog/less-coding-more-science-simplify-ocean-modeling-on-gpus-with-openacc-and-unified-memory/

Principais recursos

- Conjunto completo de memória unificada no HPC SDK v25.7, que automatiza o movimento de dados entre CPU e GPU.

- Espaço de endereços compartilhado em plataformas com memória coerente (Grace Hopper, GB200) que permite migração automática de páginas e coerência de memória.

- O driver CUDA gerencia a movimentação de dados; transferências explícitas entre host e dispositivo costumam ser desnecessárias, reduzindo boilerplate e bugs.

- Melhorias no OpenACC voltadas para memória unificada, incluindo estratégias assíncronas para melhorar a concorrência e evitar condições de corrida.

- Suporte para códigos reais com layouts de dados complexos (tipos derivados, arrays alocados dinamicamente, containers STL) sem a necessidade de cópia manual.

- Ganhos de produtividade observados na portabilidade de modelos oceânicos (NEMO) com melhorias de desempenho em seções e no fluxo de trabalho completo.

- Desdobramentos do uso em ambientes reais: sistemas Grace Hopper (GH200, GB200) na ALPS/CSCS e JUPITER/JSC, destacando conectividade de alta largura de banda e memória coerente.

Casos de uso comuns

- Portar modelos oceânicos e climáticos (ex.: NEMO) para GPUs para acelerar difusão e advecção e outras regiões críticas de desempenho.

- workloads com gargalo de memória onde difusão e advecção de traços são pontos quentes, beneficiando da memória unificada pela redução de código de gerenciamento.

- Códigos que utilizam recursos avançados de C++ (std::vector, containers STL) que antes exigiam reescrita com ponteiros crus para offload para GPU.

- Projetos que buscam maior produtividade na portabilidade para GPUs, permitindo experimentar com mais workloads na GPU mais cedo no ciclo de portabilidade.

- Fluxos de trabalho que se beneficiam de execução assíncrona entre CPU e GPU para melhor aproveitamento de recursos.

Setup & instalação

# Setup and installation details are not provided in the source.Quick start

Não há um exemplo mínimo executável apresentado na fonte. A discussão concentra-se na estratégia de portabilidade e nos benefícios arquiteturais, em vez de um snippet pronto para rodar. Consulte as Referências para o artigo principal.

Prós e contras

- Prós

- Ganhos significativos de produtividade com gerenciamento automático de dados e memória unificada.

- Portabilidade para GPU mais rápida com menos boilerplate de código.

- Possibilidade de experimentar mais workloads em GPUs desde o início do porting.

- Redução de condições de corrida com OpenACC 3.4 e execução assíncrona.

- Evidências de ganhos de desempenho em trechos portados e fluxos de trabalho completos.

- Plataformas Grace Hopper oferecem alta largura de banda e memória coerente, melhorando a locality.

- Contras

- Benefícios dependem do hardware com memória unificada (ex.: Grace Hopper).

- Abordagens como HMM podem ser usadas em algumas plataformas como alternativa.

- Migrações automáticas de páginas podem exigir ajustes de performance para obter o melhor locality.

- Alguns padrões de C++ legados podem exigir adaptação para comportamentos de memória unificada.

Alternativas

| Abordagem | Descrição | Quando considerar | Prós | Contras |---|---|---|---|---| | Gerenciamento manual de dados (CPU-GPU) | Transferências explícitas entre host e dispositivo com diretivas OpenACC/CUDA | Códigos legados com controle rígido de transferências | Controle total de movimento de dados; potencial de locality ótima | Maior complexidade, mais bugs, ciclos de portabilidade mais longos |Heterogeneous Memory Management (HMM) | Migração de memória assistida por driver/OS sem espaço de endereço compartilhado | Plataformas sem memória unificada completa | Funciona em várias plataformas | Pode ter latência maior e menos integração suave com o modelo de programação |Port completo apenas para CPU | Manter tudo na CPU, portando kernels para GPU conforme necessário | Workloads pequenas ou etapas finais de porting | Código mais simples no CPU | Perda de aceleração GPU; tempos de execução maiores |

Pricing ou Licença

Detalhes de licenciamento e preços não são explicitamente fornecidos no material-fonte.

Referências

More resources

CUDA Toolkit 13.0 para Jetson Thor: Ecossistema Unificado de Arm e Mais

Kit de ferramentas CUDA unificado para Arm no Jetson Thor com coerência total de memória, compartilhamento de GPU entre processos, interoperabilidade OpenRM/dmabuf, suporte NUMA e melhorias de ferramentas para embarcados e servidores.

Reduzir Custos de Implantação de Modelos Mantendo Desempenho com Swap de Memória de GPU

Utilize o swap de memória da GPU (hot-swapping de modelos) para compartilhar GPUs entre múltiplos LLMs, reduzir custos de ociosidade e melhorar o autoscaling mantendo os SLAs.

Aprimorando a auto-tunagem de GEMM com nvMatmulHeuristics no CUTLASS 4.2

Apresenta nvMatmulHeuristics para escolher rapidamente um conjunto pequeno de configurações de kernels GEMM com alto potencial para o CUTLASS 4.2, reduzindo drasticamente o tempo de tuning enquanto se aproxima do desempenho da busca exaustiva.

Deixe os ZeroGPU Spaces mais rápidos com compilação ahead-of-time (AoT) do PyTorch

Descubra como a AoT do PyTorch acelera ZeroGPU Spaces exportando um modelo compilado e recarregando-o instantaneamente, com quantização FP8, formas dinâmicas e integração cuidadosa com o fluxo Spaces GPU.

Fine-Tuning gpt-oss para Precisão e Desempenho com Treinamento de Quantização (QAT)

Guia de fine-tuning do gpt-oss com SFT + QAT para recuperar a precisão em FP4 mantendo a eficiência, incluindo upcasting para BF16, MXFP4, NVFP4 e implantação com TensorRT-LLM.

Como Modelos de Linguagem Pequenos são a Chave para IA Agentica Escalável

Explora como modelos de linguagem pequenos permitem IA agentica mais barata, flexível e escalável, ao lado de LLMs, com NVIDIA NeMo e Nemotron Nano 2.