Visual Haystacks (VHs): Benchmark de Raciocínio Visual com Múltiplas Imagens

Sources: http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks, http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks/, BAIR Blog

Visão geral

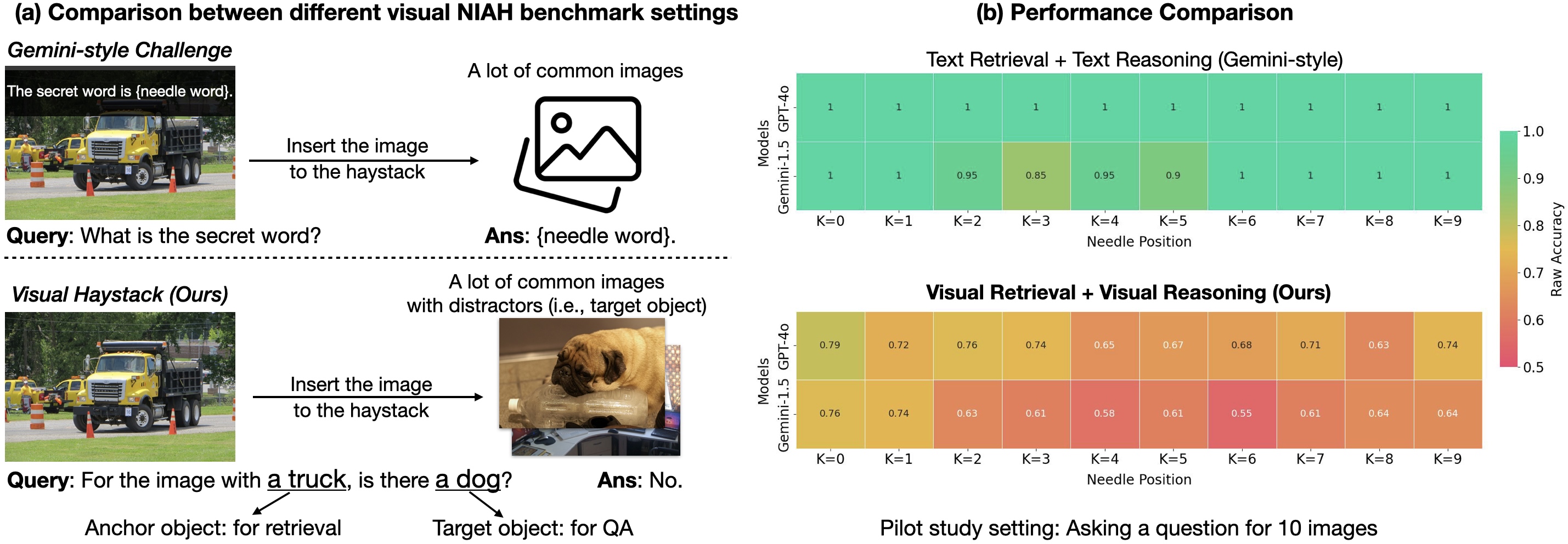

Visual Haystacks (VHs) é o primeiro benchmark centrado em visão para Needle-In-A-Haystack (NIAH) criado para avaliar de forma rigorosa Modelos Multimodais Grandes (LMMs) na capacidade de processar informações visuais em contexto longo. O foco é ir além do VQA com uma imagem, testando recuperação e raciocínio em conjuntos grandes e não correlacionados de imagens. O conjunto de dados centra-se na identificação da presença de conteúdo visual específico (por exemplo, objetos) em imagens retiradas do conjunto COCO, com aproximadamente 1K pares binários de perguntas e respostas inseridos em fenascas que podem conter de 1 a 10K imagens. A tarefa é dividida em dois desafios: Single-Needle (agulha única) e Multi-Needle (multiplas agulhas). O benchmark destaca três deficiências centrais em LMMs quando confrontados com grandes entradas visuais: dificuldades com distratores visuais, dificuldade de raciocínio entre várias imagens e sensibilidade ao posicionamento da agulha na sequência de entrada (o chamado efeito “perdido no meio”). Em resposta, os autores apresentam o MIRAGE (Multi-Image Retrieval Augmented Generation), um paradigma de treinamento de código aberto em um único estágio que estende o LLaVA para lidar com tarefas MIQA. MIRAGE aplica compressão de encodings, utiliza um recuperador embutido para filtrar imagens irrelevantes e adiciona dados de treinamento com raciocínio de várias imagens. O resultado é um modelo capaz de lidar com 1K ou 10K imagens e que demonstra alta taxa de recall e precisão em tarefas com várias imagens, superando diversos baselines em muitos cenários de agulha única. Este trabalho também compara uma linha de base de duas etapas (legenda com LLaVA seguida de uma resposta em texto usando Llama3) com modelos end-to-end visualmente conscientes, mostrando que a integração de contexto longo de legendas por LLMs pode ser eficaz, enquanto LMMs existentes muitas vezes lutam para integrar informações entre várias imagens. O benchmark VHs e o MIRAGE visam impulsionar o avanço em recuperação visual robusta e raciocínio sobre grandes coleções de imagens. Para mais detalhes e dados, consulte a fonte: https://bair.berkeley.edu/blog/2024/07/20/visual-haystacks/

Principais características

- Raciocínio visual em contexto longo em conjuntos grandes e não correlacionados de imagens (aproximadamente 1K pares de QA; haystacks com 1K–10K imagens).

- Dois desafios: Single-Needle (uma agulha) e Multi-Needle (2–5 agulhas).

- Tarefas de conteúdo visual baseadas em anotações do COCO (por exemplo, presença de um objeto alvo).

- Paradigma MIRAGE de código aberto (Multi-Image Retrieval Augmented Generation) construído sobre o LLaVA para lidar com MIQA.

- Compressão de consultas para reduzir tokens de codificação, permitindo haystacks maiores dentro de limites de contexto.

- Recuperador integrado treinado com o fluxo de fine-tuning do LLM para filtrar imagens irrelevantes dinamicamente.

- Dados de treinamento com várias imagens (aumento com dados de raciocínio de várias imagens, inclusive sintéticos).

- MIRAGE atinge desempenho de ponta na maioria das tarefas de agulha única e demonstra forte recall e precisão em tarefas com várias imagens, superando baselines como GPT-4, Gemini-v1.5 e LWM em muitos cenários.

- Recuperador co-treinado supera CLIP neste setting específico de MIQA, destacando que recuperadores genéricos podem ter desempenho inferior quando a tarefa depende de texto question-like e relevância visual.

- Paradigma de treinamento simples, de código aberto, em um único estágio, projetado para enfrentar os principais desafios de MIQA: distratores, contexto longo e raciocínio entre imagens.

- Identificadas propriedades como o efeito de posição da agulha, onde o desempenho do modelo varia significativamente com a posição da imagem-alvo na sequência (por exemplo, quedas de até ~26,5% para alguns LMMs quando não colocadas imediatamente antes da pergunta; modelos proprietários mostram quedas de até ~28,5% quando não estão no início).

Casos de uso comuns

- Analisar padrões em grandes coleções de imagens médicas (por exemplo, localizar ocorrências de um determinado achado em várias imagens).

- Monitorar desmatamento ou mudanças ecológicas em imagens de satélite ao longo do tempo.

- Mapear mudanças urbanas usando dados de navegação autônoma e sensores veiculares.

- Examinar grandes coleções de arte em busca de motivos visuais ou objetos específicos.

- Compreender o comportamento do consumidor a partir de imagens de vigilância de varejo em grande escala.

Setup e instalação

O setup e os comandos de instalação não são fornecidos na fonte.

# Setup details not provided in sourceQuick start

Observação: a fonte descreve um fluxo conceitual em vez de um roteiro pronto para execução. Um esboço de alto nível baseado na abordagem descrita é:

- Monte um haystack: reúna um conjunto grande e não correlacionado de imagens (1K–10K) com anotações do COCO para objetos-alvo.

- Prepare a consulta: defina o objeto âncora e o objeto-alvo para a tarefa da agulha.

- Use MIRAGE como pipeline de um único estágio: aplique compressão de encode para reduzir tokens, execute o recuperador em linha para filtrar imagens irrelevantes e utilize dados de treinamento com várias imagens para ajustar o modelo.

- Avalie: mensure tarefas de agulha única e múltipla agulha, comparando com baselines como legenda+LLM ou outros LMMs.

# Fluxo conceitual (ilustrativo; não é script executável)

imagens = carregar_dataset("COCO", contagem=1000_a_10000)

qa = criar_qa_binaria(agujha_objeto, objeto_alvo)

modelo = MIRAGE()

resposta = modelo.responder(imagens, qa)

print(resposta)Prós e contras

- Prós:

- Permite raciocínio em contexto longo sobre milhares de imagens potencialmente não relacionadas.

- Encodings comprimidos permitem haystacks maiores dentro dos limites de contexto.

- Recuperador embutido reduz dados irrelevantes, melhorando a qualidade da recuperação.

- Dados de treinamento com várias imagens melhoram a generalização para tarefas MIQA.

- MIRAGE atinge desempenho forte em tarefas de agulha única e demonstra resultados competitivos em tarefas com várias agulhas; o recuperador pode superar CLIP neste setting.

- Contras:

- Precisão degrada com haystacks maiores para muitos modelos devido a distratores visuais.

- Em configurações com 5+ imagens e multi-agulha, muitos LMMs apresentam desempenho abaixo de uma linha de base de legenda+LLM em alguns casos.

- Efeitos de posição da agulha podem influenciar o desempenho significativamente (até ~26,5% de variação dependendo do modelo e da posição).

Alternativas (breve comparação)

- VQA tradicional com apenas uma imagem: limitado a uma imagem; não aborda recuperação entre várias imagens ou raciocínio em contexto longo.

- Benchmarks NIAH baseados em texto Gemini-style: foco em recuperação ou raciocínio textual; VHs estende-se a múltiplas imagens visuais e raciocínio entre imagens.

- Baseline de legenda (LLaVA + Llama3): usa legenda de imagens seguida de QA em texto; pode superar alguns LMMs de ponta em determinadas tarefas com várias imagens, mas pode perder quando recursos visuais sutis são cruciais. | Abordagem | Foco | Pontos fortes | Fraquezas |---|---|---|---| | MIRAGE (baseline VHs) | QA com várias imagens e recuperação | Alto recall/precisão em MIQA; código aberto; supera várias baselines em muitas tarefas de agulha única | Requer preparação de dados de imagem e ajuste fino específico de MIQA; efeitos de posição da agulha podem alterar o desempenho |Legenda + LLM (duas etapas) | QA baseado em texto a partir de legendas | Resistente quando legendas capturam informações essenciais | Pode subutilizar detalhes visuais; pode falhar quando nuances visuais são críticas |LMMs de ponta (ex.: GPT-4o, Gemini-v1.5) | VQA visual direta em várias imagens | Potencialmente forte em alguns cenários | Mostraram fraco em configurações com 5+ imagens e várias agulhas neste estudo; limites de contexto e payload podem restringir o desempenho |

Licença ou Preços

Detalhes de licenciamento ou preços não são fornecidos na fonte. MIRAGE é descrito como código aberto dentro do contexto do benchmark, mas termos específicos de licença não são apresentados.

Referências

- Visual Haystacks: Are We Ready for Multi-Image Reasoning? Launching VHs: The Visual Haystacks Benchmark!. BAIR Blog. https://bair.berkeley.edu/blog/2024/07/20/visual-haystacks/

More resources

Fine-Tuning gpt-oss para Precisão e Desempenho com Treinamento de Quantização (QAT)

Guia de fine-tuning do gpt-oss com SFT + QAT para recuperar a precisão em FP4 mantendo a eficiência, incluindo upcasting para BF16, MXFP4, NVFP4 e implantação com TensorRT-LLM.

TextQuests: Avaliando LLMs em Jogos de Aventura Textuais

TextQuests é um benchmarks que testa agentes LLM em 25 jogos clássicos de ficção interativa, enfatizando raciocínio de longo contexto e exploração autônoma.

Defending against Prompt Injection with Structured Queries (StruQ) and Preference Optimization (SecAlign)

Recent advances in Large Language Models (LLMs) enable exciting LLM-integrated applications. However, as LLMs have improved, so have the attacks against them. Prompt injection attack is listed as the #1 threat by OWASP to LLM-integrated applications, where an LLM input contains a trusted prompt (ins

PLAID: Geração multimodal de proteínas por difusão latente

PLAID gera simultaneamente sequência 1D de proteína e estrutura 3D aprendendo o espaço latente de modelos de dobramento de proteínas. Suporta prompts de função e organismo e decodifica a estrutura com pesos congelados do modelo de dobramento.

Dimensionando o RL para Suavização do Tráfego: Implantação de 100 VEs na Estrada

100 carros controlados por RL foram implantados na I-24 durante o horário de pico para diminuir ondas de paradas e arranques, melhorar o fluxo e reduzir o consumo de combustível para todos. Controle descentralizado com sensores de radar básicos.

Anthology: Condicionando LLMs com Backstories Ricas para Personas Virtuais

Um método para guiar LLMs rumo a personas virtuais representativas, consistentes e diversas, gerando narrativas de vida detalhadas usadas como contexto de condicionamento, com aplicações em simulações e pesquisas escaláveis.