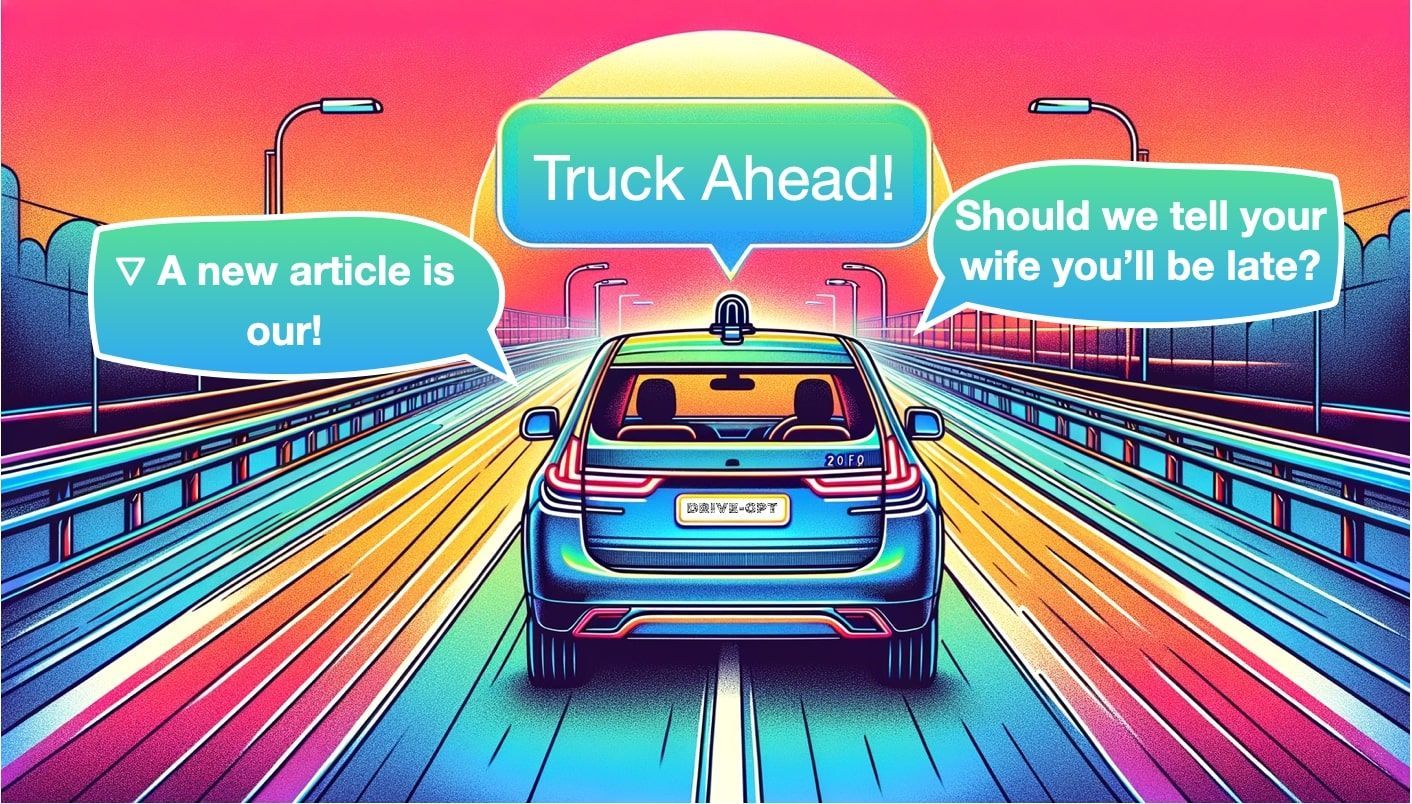

Car-GPT: Será que os LLMs finalmente tornam os carros autônomos realidade?

Sources: https://thegradient.pub/car-gpt, https://thegradient.pub/car-gpt/, The Gradient

Visão geral

A condução autônoma tem variado entre uma arquitetura modular (Perception, Localization, Planning, Control) e o apelo do aprendizado end‑to‑end. O artigo da Gradient, Car-GPT, avalia como grandes modelos de linguagem (LLMs) podem ajudar a ligar percepção, planejamento e geração por meio de prompts que descrevem cenas, intenções ou cenários futuros. O texto é cuidadoso ao enquadrar isso como pesquisa inicial: há potencial, mas ainda não está provado em carros em operação. O autor começa com uma analogia à descoberta acidental da penicilina para ilustrar como insights úteis podem emergir de sistemas baseados em dados quando métodos tradicionais não resolvem o problema. Em direção à direção autônoma, um impulso semelhante poderia vir dos LLMs que raciocinam sobre saídas de percepção, consultam uma cena de imagens ou vídeo e propõem ou questionam ações de condução. O artigo observa que a primeira leva de trabalhos que mencionam LLMs em carros autônomos apareceu por volta de meados de 2023 e analisa um amplo conjunto de abordagens, desde melhorias de percepção até planejamento e geração. Três direções ativas de pesquisa são destacadas: (1) Percepção, onde a entrada são imagens (ou vistas BEV) e a saída inclui detecções, faixas e outras anotações da cena; (2) Planejamento, onde o sistema propõe ou otimiza um trajeto de A para B; e (3) Geração, onde modelos baseados em linguagem criam descrições, previsões ou até cenas futuras para melhorar o planejamento e a coleta de dados. Nesse enquadramento, os LLMs não substituem diretamente os módulos de software automotivo; em vez disso, eles complementam as turmas existentes com raciocínio baseado em linguagem, prompts específicos para tarefas e inferência orientada a dados. O artigo descreve várias famílias de modelos e trabalhos representativos que ilustram onde os LLMs podem contribuir:

- Detecção, Previsão e Rastreamento em Percepção com modelos como HiLM-D e MTD-GPT;

- Percepção BEV (Bird Eye View) e análise guiada por linguagem via sistemas como Talk2BEV, que combina BEV com raciocínio de LLM;

- Uso de prompts para guiar uma saída de percepção (por exemplo, pedindo ao LLM para recortar regiões ou focar a atenção);

- Planejamento que produz trajetórias de condução usando raciocínio inspirado em linguagem; e

- Geração: aproximação que estende entre percepção e síntese de cenas, incluindo geração de vídeo a partir de texto e imagens (GAIA‑1 da Wayve) ou geração de cenas de condução a partir de dados de condução (MagicDrive, Driving Into the Future, Driving Diffusion). O artigo enfatiza três tarefas centrais que se alinham ao uso de LLMs na condução: Detecção (o que há na cena), Previsão (como os objetos se movem) e Rastreamento (manter IDs consistentes ao longo do tempo). Em seguida, descreve como esses outputs podem ser enriquecidos ou reinterpretados por um LLM para produzir decisões de condução acionáveis ou uma compreensão de cena mais rica. O autor levanta preocupações práticas: o risco de alucinações, a natureza de caixa-preta dos grandes modelos e o desafio de tornar tais sistemas confiáveis o suficiente para condução em tempo real. Enquanto alguns pesquisadores defendem um modelo Grok em veículo que possa responder a perguntas sobre a cena atual, a ideia é ainda muito inicial. Reconhecendo promessas e riscos, o artigo sugere que pesquisadores devem seguir um caminho experimental cuidadoso e acompanhar a literatura em evolução. No geral, Car-GPT enquadra os LLMs como um componente potencial de uma pilha autônoma multimodal, com controle de alto nível, foco humano e dados em loop, que pode aprimorar percepção, planejamento e geração – contanto que se trate de complemento aos sistemas já existentes, e não de substituição direta.

Principais recursos

- Três famílias de uso para LLMs em condução: Percepção, Planejamento e Geração. Percepção envolve detecção e descrição de objetos, faixas e semântica da cena; Planejamento usa raciocínio orientado por linguagem para propor trajetórias; Geração produz descrições ou simulações de condução.

- entradas BEV e multi‑visão: várias abordagens destacam representações BEV e a integração de imagens multi‑visão com raciocínio de LLM para criar prompts como “encontre veículos que estão virando à direita.”

- percepção orientada por linguagem: LLMs acrescentam uma camada de prompts que amplifica saídas de percepção com descrições, perguntas ou análises subsequentes.

- prompts como alavancas: prompts guiam onde recortar ou examinar regiões e como interpretar detecções para dirigir decisões de planejamento.

- 4D percepção e IDs: sistemas como PromptTrack visam atribuir IDs únicos a objetos através de quadros, permitindo rastreamento consistente em uma linha de tempo orientada por linguagem.

- planejamento via modelos de linguagem: exemplos incluem Talk2BEV, que usa mapas BEV enriquecidos por linguagem para informar decisões de planejamento, potencialmente em conjunto com modelos como LLaVA ou GPT‑class.

- geração e modelos de mundo: GAIA‑1 demonstra um pipeline em que texto e imagens dirigem um modelo de mundo capaz de produzir vídeo; outros projetos (MagicDrive, Driving Into the Future, Driving Diffusion) geram cenários futuros a partir de dados atuais.

- não é substituição simples: a ideia é que LLMs forneçam raciocínio flexível e prompts úteis, não substituam pipelines de controle determinísticos – fiabilidade, verificabilidade e responsabilidade permanecem questões centrais.

- estágio inicial e evolução: a primeira leva de trabalhos relacionados apareceu por volta de meados de 2023; a comunidade continua investigando quando, onde e como os LLMs agregam valor na condução, incluindo questões de latência, segurança e validação. | Área | O que LLMs adicionam | Evidência do artigo |---|---|---| | Percepção | Detecção, associação entre quadros, descrição em linguagem | Menciona HiLM-D, MTD-GPT e conceitos de PromptTrack |Planejamento | Mapas BEV com linguagem, prompts para foco, sugestão de trajetórias | Talk2BEV e trabalhos afins |Geração | Geração de cenas/vídeos a partir de percepção | GAIA‑1, MagicDrive, Driving Into the Future, Driving Diffusion |Confiança e verificação | Busca por transparência, questões de determinismo | Discussão sobre caixas‑pretas e desafios de uso em tempo real |

Casos de uso comuns

- Aprimoramento de percepção: usar LLMs para interpretar saídas de percepção, anotar cenas e descrever objetos, faixas e relações espaciais, permitindo uma interface humano‑máquina mais rica.

- Ampliação do planejamento: using prompts para guiar decisões de planejamento, recortar regiões de interesse e ajustar a trajetória com base na saída da percepção.

- Geração e síntese de dados: produzir cenários novos ou cenas futuras para ampliar dados de treinamento e testar planejamento sob condições diversas; exemplos incluem GAIA‑1 que gera vídeos a partir de texto e imagens, e MagicDrive que gera cenas condicionadas às saídas de percepção.

- Q&A e solução de problemas: imaginar um papel de perguntas e respostas (tipo Grok) a bordo do veículo para responder perguntas sobre a cena atual, embora a aplicação em tempo real ainda não tenha sido demonstrada.

- Ciclo de dados para treinamento: usar pipelines orientadas por linguagem para criar ou anotar dados, potencialmente melhorando percepção, consistência de rastreamento e plausibilidade de planejamento por meio de feedback iterativo.

Configuração e instalação

Não há especificação no texto da fonte sobre configuração ou instalação. O conteúdo é conceitual e revisa o estado da arte, em vez de fornecer instruções de implementação.

N/AInício rápido

O artigo oferece usos conceituais em vez de um guia prático, mas um fluxo mínimo inspirado pelo texto pode ser:

# Inspiração conceitual do artigo

# Dada uma saída de percepção com mapa BEV e detecções

perception_output = {

'bev': '...representação BEV...',

'objects': [ {'id': 1, 'type': 'vehicle', 'direction': 'left', 'speed': 25}, ... ]

}

prompt_llm = (

"Dado o mapa BEV e os objetos detectados, identifique perigos e proponha uma ação de condução segura. "

"Se útil, recorte a região frontal esquerda e reavalie."

)

# Executando um LLM conceitual; substitua pela API real que você utilizar

llm_response = LLM_run(model='gpt-4', prompt=prompt_llm, inputs=perception_output)

print(llm_response)Isso corresponde à ideia do artigo de que prompts podem guiar saídas de percepção em direção a decisões de planejamento, por exemplo, pedindo ao modelo para encontrar veículos que estão virando à direita.

Início rápido (exemplo mínimo executável)

- Passo 1: Rode um módulo de percepção para produzir mapa BEV e detecções.

- Passo 2: Provoque um LLM para interpretar as saídas e sugerir ações seguras, opcionalmente recortando regiões para inspeção.

- Passo 3: Use a saída do LLM para informar um módulo de planejamento ou gerar uma explicação narrativa da cena.

Prós e contras

- Prós

- Flexibilidade: LLMs oferecem raciocínio baseado em linguagem que pode interpretar e ampliar saídas de percepção, facilitando interfaces mais ricas.

- Controle orientado a prompts: prompts permitem ajustar dinamicamente a atenção e as análises sem retraining de modelos.

- Geração e sintese de dados: geração de cenários pode ampliar treinamento de planejamento e validação de segurança.

- Potencial de interpretabilidade prática: ainda que não seja solução completa, raciocínio em linguagem pode fornecer uma narrativa que ajude a entender decisões.

- Contras

- Alucinações e confiabilidade: o texto destaca que LLMs podem produzir saídas absurdas ou erradas, levantando a questão da confiança.

- Caixa‑preta e determinismo: existem preocupações sobre determinismo e depuração em um veículo em tempo real.

- Desafios de implantação ao vivo: a pesquisa está em estágio inicial, com evidência limitada de uso online.

- Latência e segurança: condução em tempo real exige latência baixa e garantias de segurança robustas, ainda não estabelecidas para pilhas que combinam LLMs.

Alternativas

O panorama contrasta pipelines modulares com aprendizado End-To-End. O artigo observa esses contrastes de forma sucinta: | Abordagem | Pontos fortes | Fraquezas |---|---|---| | Modular (percepção + planejamento + controle) | Responsabilidade clara; testabilidade; depuração | Requer integração confiável entre módulos; potencial latência nas passagens entre módulos |End-To-End | Pipeline mais simples; potencial ganho de desempenho com otimização conjunta | Caixa‑preta; difícil de interpretar/verificar; questões de segurança |Aprendizado com auxílio de LLM (percepção/planejamento/geração) | Adiciona raciocínio, prompts e flexibilidade; potencial melhoria na interação com humanos | Estágio inicial; questões de confiança e segurança; implantação ao vivo não comprovada |

Preços ou Licença

Não há especificação na fonte. Não há detalhes de preços ou licenciamento para os conceitos discutidos.

Referências

More resources

Reduzir Custos de Implantação de Modelos Mantendo Desempenho com Swap de Memória de GPU

Utilize o swap de memória da GPU (hot-swapping de modelos) para compartilhar GPUs entre múltiplos LLMs, reduzir custos de ociosidade e melhorar o autoscaling mantendo os SLAs.

Fine-Tuning gpt-oss para Precisão e Desempenho com Treinamento de Quantização (QAT)

Guia de fine-tuning do gpt-oss com SFT + QAT para recuperar a precisão em FP4 mantendo a eficiência, incluindo upcasting para BF16, MXFP4, NVFP4 e implantação com TensorRT-LLM.

Como Modelos de Linguagem Pequenos são a Chave para IA Agentica Escalável

Explora como modelos de linguagem pequenos permitem IA agentica mais barata, flexível e escalável, ao lado de LLMs, com NVIDIA NeMo e Nemotron Nano 2.

Como Escalar seus Agentes LangGraph em Produção de um Único Usuário para 1.000 Colegas

Guia para implantar e escalar agentes baseados em LangGraph em produção usando o NeMo Agent Toolkit, testes de carga e rollout por fases para centenas a milhares de usuários.

NVFP4 Treina com Precisão de 16 Bits e Velocidade e Eficiência de 4 Bits

NVFP4 é um formato de dados de 4 bits que oferece precisão equivalente a FP16 com a vazão e eficiência de memória de 4 bits, estendido ao pré-treinamento de modelos de linguagem grandes. Este perfil aborda experimentos em escala 12B, estabilidade e colaborações.

Apresentando o NVIDIA Jetson Thor: a Plataforma Definitiva para IA Física

Jetson Thor combina computação de IA de ponta, MIG de virtualização e sensores multimodais para robótica flexível em tempo real na borda, com aceleração FP4/FP8 e suporte a Isaac GR00T e a modelos grandes de linguagem/visão.