Por que Meu Modelo Não Funciona? Guia Prático de Armadilhas em ML

Sources: https://thegradient.pub/why-doesnt-my-model-work, https://thegradient.pub/why-doesnt-my-model-work/, The Gradient

Visão geral

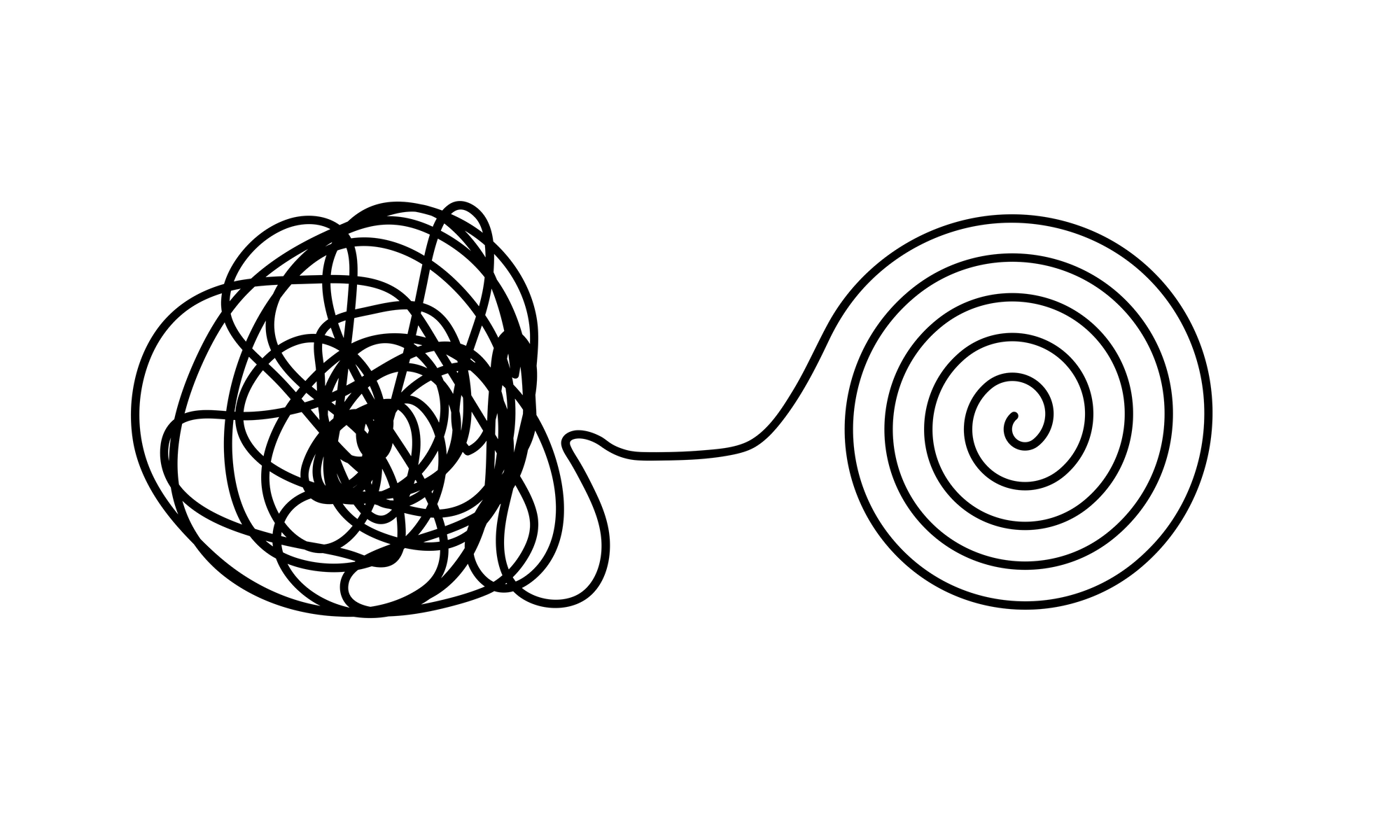

Treinar um modelo que parece bom em um conjunto de validação e depois descobrir que ele falha em dados do mundo real é uma experiência comum e frustrante. O artigo discute como o machine learning pode facilmente tropeçar em armadilhas que nem sempre são óbvias à primeira vista. Nas duas décadas em que trabalho com ML, vi muitos casos em que modelos pareciam ter bom desempenho durante o desenvolvimento, mas geravam utilidade muito limitada na prática. Este texto aborda os tipos de erro que inflacionam o desempenho aparente e sugere formas de evitá-los, incluindo a checklist REFORMS para ciência baseada em ML. Dados enganadores são um ponto de partida natural para problemas. O núcleo do ML é o dado, e quando a qualidade é fraca, modelos podem parecer bem sucedidos sem realmente aprender padrões úteis. Esforços de predição para Covid-19, por exemplo, envolveram conjuntos de dados públicos que mais tarde continham sinais que não refletiam o fenômeno subjacente. Em alguns casos, havia sobreposição de registros, rótulos incorretos ou variáveis ocultas que ajudaram o modelo a prever os rótulos sem aprender padrões relevantes. Variáveis ocultas são características presentes nos dados que, por coincidência, são preditivas para o rótulo, mas não se relacionam causalmente com o fenômeno. Em imagens torácicas de Covid, por exemplo, a orientação do exame pode correlacionar com o status da doença mais do que com a doença em si, fazendo com que os modelos aprendam a prever postura em vez de infecção. Questões relacionadas são as correlações espúrias. São padrões que correlacionam com os rótulos sem terem uma relação causal real. Um exemplo clássico é um conjunto de dados de tanques onde o modelo reconhece cues de fundo ou o horário, em vez do tanque em si. Na prática, muitos conjuntos de dados contêm sinais espúrios, o que pode levar a uma generalização ruim. Modelos profundos tendem a capturar padrões nos pixels de fundo ou em características incidentais, aumentando a suscetibilidade a mudanças de distribuição e a ataques adversários. Se o modelo depender de pistas de fundo, pequenas mudanças podem inverter a previsão. Outra questão importante é a qualidade das rotulagens. Rótulos feitos por humanos carregam vieses ou erros, especialmente em tarefas subjetivas. Mesmo benchmarks amplamente usados podem apresentar taxas de rotulagem incorreta. Em resumo, um pequeno ganho de acurácia pode refletir ruído de rotulagem ou viés de anotação, não uma melhora real no desempenho. Além da qualidade dos dados, a pipeline pode vazar informações que não deveriam estar disponíveis durante o treinamento. A leakage de dados ocorre quando conhecimento do conjunto de teste — ou de dados futuros — influencia o treinamento. Um formato comum é realizar etapas de pré-processamento, como normalização ou seleção de características, em todo o conjunto antes da divisão entre treino e teste, o que permite que o modelo aprenda com as características do conjunto de teste. Em séries temporais, o viés de olhar adiante é especialmente problemático. Corrigindo vazamentos, muitas métricas de desempenho caem drasticamente, às vezes de quase perfeição para algo apenas melhor que o acaso. O artigo recomenda práticas para tornar a ciência com ML mais transparente e robusta, incluindo a checklist REFORMS. Em resposta, o artigo propõe práticas que melhoram a confiabilidade: reconhecer problemas de dados, entender o que o modelo usa para decidir, e evitar dependência de sinais sem relação causal. A função principal é tornar a avaliação mais confiável e menos dependente de condições específicas de um conjunto de dados particular.

Principais características

- Detectar e mitigar dados enganosos desde o início: evite o “lixo entra, lixo sai”.

- Identificar variáveis ocultas e confirmar que elas não conduzem as previsões.

- Cautela com correlações espúrias que podem inflar o desempenho aparente.

- Examinar explicações do modelo para assegurar que ele depende de sinais significativos, não de cues de fundo.

- Prevenir leakage de dados mantendo o conjunto de teste isolado durante o pré-processamento e seleção de características.

- Observar viés de tempo em séries temporais e outras áreas onde informações futuras podem vazar para o treinamento.

- Atentar para vieses na rotulagem e erros de anotação; reconhecer que subjetividade pode levar ao overfitting aos anotadores.

- Usar o checklist REFORMS para documentar proveniência de dados, escolhas de modelagem e procedimentos de avaliação.

- Reconhecer que defesas como treinamento adversário têm custos e nem sempre são a solução definitiva.

Casos de uso comuns

- Estudos de ML científico onde resultados relatados podem superestimar utilidade no mundo real devido a leakage de dados ou variáveis ocultas.

- Esforços de predição de Covid-19 onde datasets continham sinais latentes ou rótulos incorretos que inflaram o desempenho apenas em split de teste.

- Benchmarks de visão computacional ou séries temporais onde padrões de fundo ou pistas de tempo inadvertidamente se correlacionam com rótulos, prejudicando a generalização.

- Implementações em domínios sensíveis onde robustez e resistência a mudanças de distribuição são críticas.

- Pesquisas de reprodutibilidade que investigam por que modelos parecem funcionar em alguns cenários, mas falham em dados novos.

Setup & instalação

# Setup & instalação não são fornecidos no artigo de origem.

echo "Nenhum comando de setup disponível na origem."Observação: o artigo faz referência ao checklist REFORMS e à necessidade de avaliação e documentação cuidadosas, mas não fornece passos de instalação ou configuração de software específicos.

Quick start

- Leia o artigo para entender as armadilhas comuns de ML: problemas de qualidade de dados (rotulagem, variáveis ocultas, correlações espúrias), leakage de dados e viés de tempo.

- Ao desenhar um modelo, examine o que o modelo utiliza para decidir. Se um mapa de saliência ou uma ferramenta de explicabilidade destacar características de fundo ou cues irrelevantes, antecipe uma generalização fraca.

- Verifique vazamentos de dados. Garanta que qualquer pré-processamento, escalonamento ou seleção de características seja feito após a divisão treino-teste. Tenha cuidado com dados de séries temporais onde informações futuras podem vazar para o treino.

- Avalie a qualidade das labels. Verifique vieses de anotação e taxas de rotulagem incorreta que possam distorcer comparações de desempenho.

- Considere abordagens de robustez mais simples antes de recorrer a defesas caras. Se a força aparente do modelo depende de pistas espúrias, invista em curadoria de dados e avaliação adequada antes de treinamentos adversários pesados.

- Utilize o checklist REFORMS para documentar a proveniência dos dados, escolhas de modelagem e procedimentos de avaliação, aumentando transparência e reprodutibilidade.

Prós e contras

- Prós:

- Aponta problemas práticos de ML que muitas vezes passam despercebidos.

- Enfatiza qualidade de dados, controle de leakage e explicabilidade como pilares da ML robusta.

- Recomenda um framework de avaliação estruturado (REFORMS) para melhorar a confiança.

- Contras:

- Algumas estratégias de mitigação (p. ex., treinamento adversário) podem ser caras e nem sempre viáveis.

- Orientação é em alto nível; pode exigir adaptação ao domínio específico.

- O texto foca em armadilhas e avaliação, não prescreve um workflow único universal.

Alternativas (comparações breves)

| Abordagem | Objetivo | Prós | Contras |---|---|---|---| | Treinamento adversário | Robusteza a exemplos adversários | Pode aumentar resiliência a perturbações | Custos computacionais elevados; não resolve leakage nem dados de qualidade |Explicabilidade pós-treino | Entender decisões do modelo | Ajuda a detectar uso de sinais não relevantes | Explicações podem ser imprecisas; nem sempre refletem causalidade |Limpeza de dados (data-centric) | Melhorar qualidade de dados e rótulos | Geralmente traz ganhos com menos complexidade de modelo | Requer engenharia de dados; pode ser demorado |Protocolos de avaliação rigorosos | Experimentos transparentes e reprodutíveis | Aumenta confiança e comparabilidade | Requer disciplina e documentação; pode reduzir velocidade de iteração |

Pricing or License

Não especificado no artigo da fonte.

References

- Why Doesn’t My Model Work? — The Gradient https://thegradient.pub/why-doesnt-my-model-work/

More resources

IA Geral Não é Multimodal: Inteligência com Ênfase no Encarnamento

Recursos concisos expondo por que abordagens multimodais baseadas em escala não devem produzir AGI; enfatiza inteligência enraizada em mundo físico.

Forma, Simetrias e Estrutura: O Papel da Matemática na Pesquisa de ML em Transformação

Explora como a matemática continua central no ML, mas seu papel está evoluindo da garantia teórica para geometria, simetrias e explicações pós-hoc em IA de escala.

O que falta nos chatbots de LLM: um senso de propósito

Explora o diálogo intencional em chatbots LLM, argumentando que interações de várias voltas alinham melhor a IA com os objetivos do usuário e permitem colaboração, especialmente em casos de uso de código e assistentes pessoais.

Visões positivas de IA fundamentadas no bem-estar

Propõe fundamentar os benefícios de IA no bem-estar humano e na saúde institucional, integrando ciência do bem-estar à IA e delineando visões práticas para desenvolvimento e implantação que promovam o florescimento individual e social.

Aplicações de LLMs no Mercado Financeiro — Visão geral e casos de uso

Visão geral de como LLMs podem ser aplicados a mercados financeiros, incluindo modelagem autoregressiva de dados de preços, entradas multimodais, residualização, dados sintéticos e previsões em múltiplos horizontes, com ressalvas sobre eficiência de mercado.

Recursos: Medindo e Mitigando Viés de Gênero em IA

Panorama de trabalhos influentes que medem viés de gênero em IA, abrangendo embeddings, co-referência, reconhecimento facial, benchmarks de QA e geração de imagens; discute mitigação, lacunas e auditoria robusta.