Mémoire unifiée avec OpenACC pour la modélisation océanique sur GPU (NVIDIA HPC SDK v25.7)

Sources: https://developer.nvidia.com/blog/less-coding-more-science-simplify-ocean-modeling-on-gpus-with-openacc-and-unified-memory, https://developer.nvidia.com/blog/less-coding-more-science-simplify-ocean-modeling-on-gpus-with-openacc-and-unified-memory/, NVIDIA Dev Blog

Vue d’ensemble

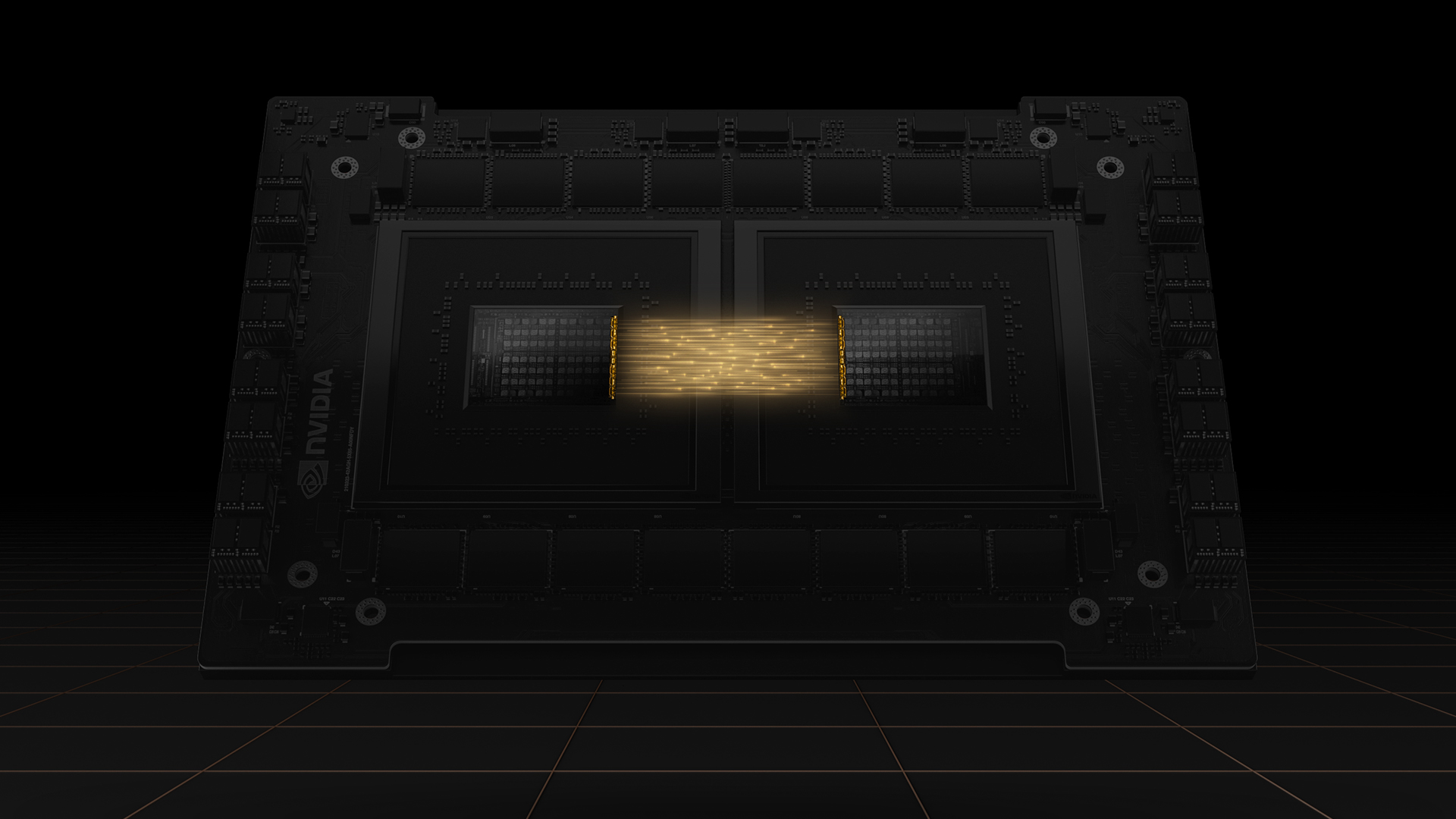

NVIDIA HPC SDK v25.7 apporte un bond significatif de productivité pour les développeurs travaillant sur des applications HPC accélérées par GPU. Cette version met l’accent sur la mémoire unifiée et fournit un ensemble d’outils complets qui automatisent les déplacements de données entre CPU et GPU. Avec un espace d’adressage partagé sur des plateformes cohérentes comme Grace Hopper, les programmeurs peuvent se concentrer sur la parallélisation plutôt que sur les transferts manuels, grâce au mouvement automatique des données géré par le pilote CUDA. Cette approche accélère les cycles de portage vers les GPU, réduit les bogues et offre plus de flexibilité pour optimiser les charges de travail scientifiques. Parmi les déploiements notables figurent le NVIDIA GH200 Grace Hopper Superchip et les systèmes GB200 NVL72, utilisés à ALPS (CSCS) et JUPITER (JSC). Ces plateformes allient haute bande passante et cohérence CPU-GPU, permettant une productivité accrue pour les codes scientifiques. Le modèle de mémoire unifiée élimine une grande partie des complexités de gestion des données qui freinaient historiquement le portage vers les GPU. En pratique, les motifs de copie profonde, les types dérivés et les configurations de données complexes peuvent être parallélisés directement sans boucles de transfert explicites. Le pilote CUDA se charge des mouvements de données et la mémoire système est accessible à la fois par la CPU et le GPU via un espace d’adresses unique. Depuis CUDA 12.4, les migrations automatiques de pages peuvent améliorer la localité des pages fréquemment accédées, augmentant ainsi les performances sur les plateformes Grace Hopper et similaires. Un avantage clé en matière de productivité est la capacité de porter des codes réels avec moins de boilerplate de gestion des données. Comme le souligne un chercheur, la programmation à mémoire unifiée permet de porter plus rapidement les modèles océaniques vers les GPU et d’expérimenter avec davantage de charges de travail sur les GPU par rapport aux approches traditionnelles. Le cadre de modélisation NEMO a été étudié comme exemple concret de ces bénéfices dans des scénarios HPC utilisant Grace Hopper. L’article aborde également la manière dont OpenACC et la mémoire unifiée répondent aux défis courants de la programmation GPU. Par exemple, le motif de copie profonde, lorsque des tableaux dérivés avec des types alloués nécessitent une boucle de transfert supplémentaire, peut être simplifié grâce à la mémoire unifiée. De même, les codes C++ utilisant STL (comme std::vector) peuvent présenter des difficultés sans mémoire unifiée; avec mémoire unifiée, l’accès aux éléments des containers et à leurs métadonnées devient plus simple. Dans le portage NEMO décrit, toute la gestion de mémoire est automatisée par le driver CUDA sur les plateformes Grace Hopper. Sur des systèmes cohérents comme Grace Hopper, la mémoire système est accessible depuis le CPU comme le GPU via la règle de first-touch. Depuis CUDA 12.4, l’estimation par les pages et l’acheminement automatique peuvent améliorer la localité et les performances. Grâce aux interconnexions à haute bande passante et à des mécanismes de cohérence dédiés, les systèmes Grace Hopper devraient surpasser les systèmes memory-unified qui s’appuient sur HMM. Le schéma montre l’évolution progressive du port vers le GPU GPU: on porte d’abord l’étape horizontale de diffusion des traceurs actifs et passifs, puis l’advection et enfin la diffusion verticale et le filtrage temporel. À chaque portion du code portee, les gains observés vont de ~2x à ~5x pour l’exécution sur Hopper par rapport à Grace, et l’accélération globale d’environ ~2x. Même dans les débuts de portage, on observe des gains d’end-to-end grâce à l’accélération partielle. Pour les chercheurs et les décideurs techniques, la conclusion est claire: la mémoire unifiée, combinée à des interconnexions et à des mécanismes de cohérence, réduit la charge cognitive de la programmation GPU et permet une itération plus rapide, moins de bogues et des stratégies d’optimisation plus souples pour des codes scientifiques complexes. La couverture sur Grace Hopper et les talks GTC associées fournissent un contexte pratique pour ces capacités architecturales et les avancées du compilateur.

Source: NVIDIA Dev Blog: Less Coding, More Science: Simplify Ocean Modeling on GPUs With OpenACC and Unified Memory. Lien: https://developer.nvidia.com/blog/less-coding-more-science-simplify-ocean-modeling-on-gpus-with-openacc-and-unified-memory/

Caractéristiques clés

- Ensemble d’outils mémoire unifiée complet dans le HPC SDK v25.7, automatisant les déplacements de données entre CPU et GPU.

- Espace d’adressage partagé sur des plateformes cohérentes (Grace Hopper, GB200) pour une migration automatique des pages et une cohérence mémoire.

- Le pilote CUDA gère les mouvements de données; les transferts explicites ne sont souvent pas nécessaires, réduisant le boilerplate et les bogues.

- Améliorations OpenACC axées sur la mémoire unifiée, incluant des stratégies asynchrones pour améliorer la concurrence et éviter les conditions de course.

- Prise en charge de codes réels avec des layouts de données complexes (types dérivés, tableaux alloués dynamiquement, containers STL) sans copier manuellement.

- Gains de productivité démontrés dans le portage d’anciens codes océanographiques (NEMO) avec des accélérations notables.

- Déploiements Grace Hopper réalistes: systèmes GH200/GB200 chez ALPS/CSCS et JUPITER/JSC, mettant en évidence une interconnexion haute bande passante et une mémoire cohérente.

Cas d’utilisation courants

- Portage de modèles océaniques et climatiques (ex.: NEMO) sur GPUs pour accélérer les noyaux de diffusion et d’advection et d’autres portions critiques.

- Charges de travail à mémoire saturée où la diffusion et l’advection des traceurs constituent les points chauds, bénéficiant de la mémoire unifiée et de la réduction du code de gestion.

- Codes C++ avancés utilisant std::vector et containers STL qui nécessitaient autrefois une réécriture en pointeurs bruts pour le offload GPU.

- Projets recherchant une productivité accrue lors du portage, permettant d’expérimenter plus tôt avec davantage de workloads sur GPU.

- Workflows qui tirent parti de l’exécution asynchrone CPU-GPU pour optimiser l’utilisation des ressources.

Setup & installation

# Setup and installation details are not provided in the source.Quick start

Aucune démonstration rapide et exécutable n’est fournie dans la source. L’article se concentre sur la stratégie de portage et les bénéfices architecturaux plutôt que sur un exemple prêt à exécuter. Reportez-vous à la section Références pour l’article principal.

Avantages et inconvénients

- Avantages

- Gains importants de productivité grâce à la gestion automatique des données et à la mémoire unifiée.

- Portage vers GPU plus rapide avec moins de boilerplate.

- Possibilité d’expérimenter plus largement avec les workloads GPU dès les premières étapes du portage.

- Réduction des conditions de course via OpenACC 3.4 et les exécutions asynchrones.

- Preuves d’amélioration des performances sur des sections portées et des flux de travail globaux.

- Les plateformes Grace Hopper offrent une interconnexion haute bande passante et une mémoire cohérente, améliorant la locality.

- Inconvénients

- Les bénéfices dépendent du matériel avec mémoire unifiée (Grace Hopper et équivalents).

- Des approches alternatives comme HMM restent pertinentes sur certaines plateformes.

- Les migrations automatiques de pages peuvent nécessiter des ajustements de performance pour obtenir la locality optimale.

- Certains motifs C++ hérités peuvent nécessiter des ajustements lorsque le comportement de mémoire unifiée diffère des attentes du compilateur.

Alternatives

| Approche | Description | Quand considérer | Avantages | Inconvénients |---|---|---|---|---| | Gestion manuelle des données (CPU-GPU) | Transferts explicites entre host et device avec OpenACC/CUDA | Codes existants nécessitant un contrôle précis des transferts | Contrôle total du déplacement des données; localisation potentielle optimisée | Complexité plus élevée, plus de bugs, cycles de portage plus longs |Gestion de mémoire hétérogène (HMM) | Migration mémoire assistée par driver/OS sans espace d’adresses partagé | Plates-formes sans mémoire unifiée complète | Fonctionne sur une plus grande variété de plateformes | Latence potentiellement plus élevée et intégration moins fluide |Port CPU-only | Tout sur CPU, port de kernels pour GPU au besoin | Petites charges ou portages tardifs | Code plus simple côté CPU | Perte d’accélération GPU; temps d’exécution plus longs |

Prix ou Licence

Les détails de tarification et de licence ne sont pas fournis explicitement dans la source.

Références

More resources

CUDA Toolkit 13.0 pour Jetson Thor : Écosystème Arm Unifié et Plus

Kit CUDA unifié pour Arm sur Jetson Thor avec cohérence mémoire complète, partage du GPU entre processus, interop OpenRM/dmabuf, support NUMA et outils améliorés pour l’embarqué et le serveur.

Réduire les coûts de déploiement des modèles tout en conservant les performances grâce au swap de mémoire GPU

Exploitez le swap mémoire GPU (hot-swapping de modèles) pour partager les GPUs entre plusieurs LLM, réduire les coûts inoccupés et améliorer l’auto-Scaling tout en respectant les SLA.

Amélioration de l’auto-tuning GEMM avec nvMatmulHeuristics dans CUTLASS 4.2

Présente nvMatmulHeuristics pour sélectionner rapidement un petit ensemble de configurations de kernels GEMM à fort potentiel pour CUTLASS 4.2, réduisant considérablement le temps de tuning tout en approchant les performances d’une Recherche Exhaustive.

Accélérez ZeroGPU Spaces avec la compilation ahead-of-time (AoT) de PyTorch

Découvrez comment la compilation AoT de PyTorch accélère ZeroGPU Spaces en exportant un modèle compilé et en le rechargeant instantanément, avec quantification FP8, formes dynamiques et intégration au flux Spaces GPU.

Fine-Tuning gpt-oss pour la précision et les performances avec l’entraînement par quantisation (QAT)

Guide du fine-tuning de gpt-oss utilisant SFT + QAT pour récupérer la précision FP4 tout en préservant l’efficacité, avec upcast vers BF16, MXFP4, NVFP4 et déploiement avec TensorRT-LLM.

Comment les petits modèles linguistiques contribuent à une IA agentique évolutive

Explique comment les petits modèles linguistiques permettent une IA agentique plus rentable et flexible, aux côtés des LLMs, via NVIDIA NeMo et Nemotron Nano 2.