Car-GPT : les LLMs pourraient-ils enfin rendre les voitures autonomes possibles ?

Sources: https://thegradient.pub/car-gpt, https://thegradient.pub/car-gpt/, The Gradient

Aperçu

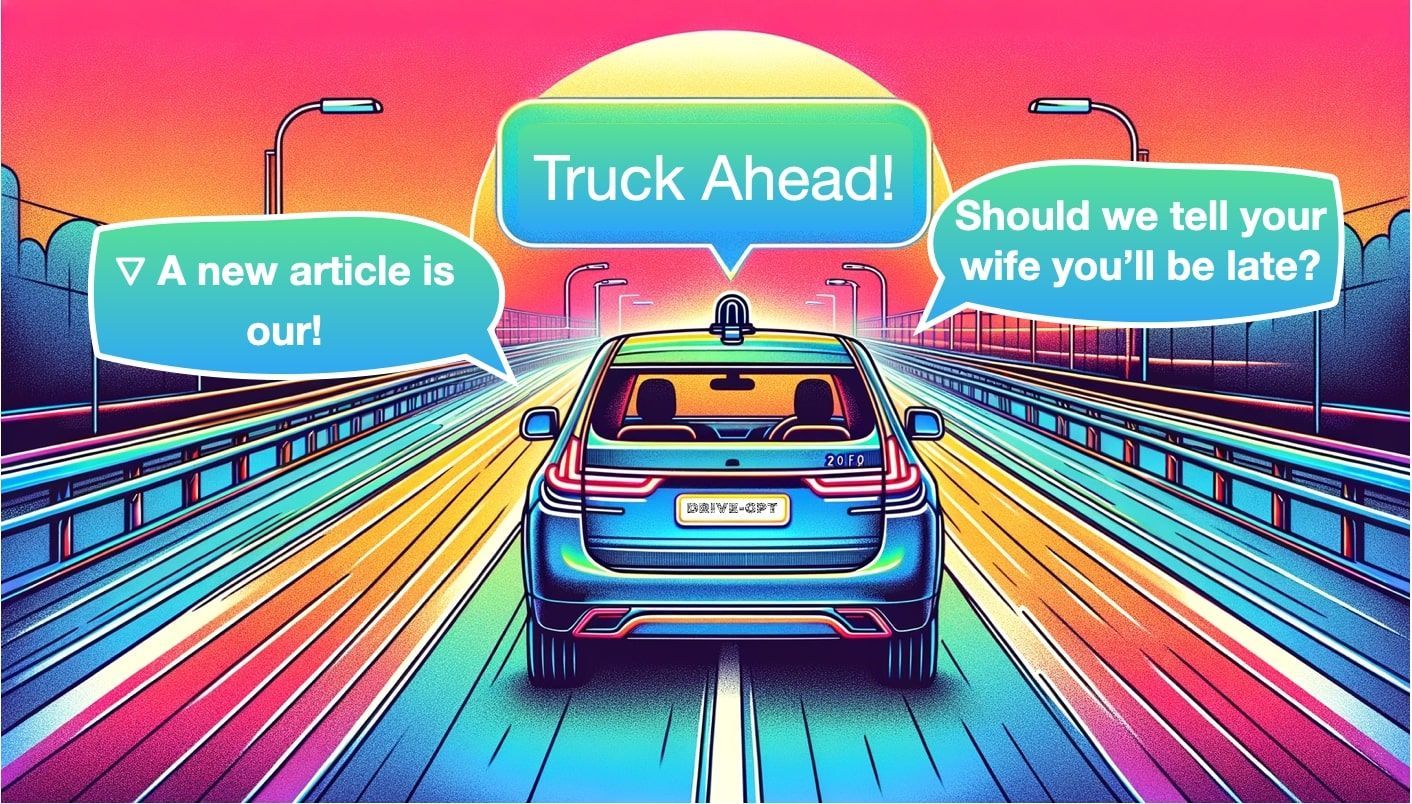

La conduite autonome a longtemps oscillé entre une architecture modulaire (Perception, Localisation, Planification, Contrôle) et l’attrait de l’apprentissage de bout en bout. L’article de The Gradient, Car-GPT, explore comment les grands modèles de langage (LLMs) pourraient aider à relier perception, planification et génération via des invites qui décrivent des scènes, des intentions ou des scénarios futurs. Le texte insiste sur le fait qu’il s’agit d’un domaine de recherche précoce : le potentiel existe, mais ce n’est pas encore démontré sur des véhicules en service. L’auteur ouvre avec une analogie à la découverte accidentelle de la pénicilline pour illustrer comment des idées utiles peuvent émerger à partir de systèmes basés sur les données quand les méthodes traditionnelles ne suffisent pas. Dans le domaine de la conduite autonome, un pivot similaire pourrait venir des LLMs qui raisonnent sur les sorties de perception, interroger une scène image ou vidéo et proposer ou critiquer des actions de conduite. L’article note que la première vague de publications mentionnant les LLMs dans les voitures autonomes est apparue vers la mi‑2023 et passe en revue un paysage varié d’approches, depuis les améliorations de perception jusqu’au planification et à la génération. Trois directions de recherche actives sont mises en avant : (1) Perception, où l’entrée est constituée d’images (ou de vues BEV) et la sortie comprend détections, bandes et autres annotations de scène ; (2) Planification, où le système propose ou optimise un trajet ; et (3) Génération, où des modèles axés sur le langage créent des descriptions, des prédictions ou même des scènes futures afin d’améliorer le décours des données et la planification. Dans ce cadre, les LLMs ne remplacent pas les modules logiciels automobiles ; ils complètent plutôt les modules existants par un raisonnement basé sur le langage, des invites spécifiques à la tâche et des inférences guidées par les données. L’article décrit plusieurs familles de modèles et des travaux représentatifs qui illustrent où les LLMs peuvent apporter de la valeur :

- Détection, Prédiction et Suivi en Perception avec des modèles comme HiLM-D et MTD-GPT ;

- Perception BEV et analyse guidée par le langage via des systèmes comme Talk2BEV, qui associe BEV et raisonnement par LLM ;

- L’utilisation d’invites pour guider une sortie de perception (par exemple, demander au LLM de rogner des régions ou de focaliser l’attention) ;

- Plans qui utilisent le raisonnement en langage pour proposer des trajectoires ; et

- Génération et scénarios à partir du langage, avec des approches comme GAIA‑1 qui peut produire des vidéos à partir de texte et d’images, ou encore MagicDrive et Driving Into the Future et Driving Diffusion qui génèrent des scénarios futurs. L’article souligne trois tâches centrales qui s’alignent sur l’utilisation des LLM dans la conduite : Détection (ce qui est dans la scène), Prédiction (comment les objets vont bouger) et Suivi (maintenir des identifiants cohérents sur la durée). Il explique ensuite comment ces sorties peuvent être améliorées ou interprétées par un LLM pour produire des décisions de conduite actionnables ou une compréhension de scène plus riche. L’auteur soulève des préoccupations pratiques : le risque d’hallucinations, la nature boîte-noire des grands modèles et le défi de rendre ces systèmes fiables pour la conduite en temps réel. Alors que certains chercheurs soutiennent l’idée d’un modèle Grok sur véhicule capable de répondre à des questions sur la scène actuelle, l’article affirme que nous sommes encore au tout début. Tout en reconnaissant les promesses et les risques, il suggère que les chercheurs devraient tracer une voie expérimentale rigoureuse et suivre l’évolution de la littérature. Dans l’ensemble, Car-GPT présente les LLM comme un composant potentiel d’une pile autonome multimodale, avec raisonnement basé sur le langage et prompts dynamiques, afin d’améliorer perception, planification et génération—à condition de les considérer comme complément à des systèmes existants et non comme un remplacement direct.

Caractéristiques clés

- Trois familles d’utilisation des LLM dans la conduite : Perception, Planification et Génération. La Perception inclut la détection et la description des objets, des bandes et de la sémantique de la scène ; la Planification utilise le raisonnement guidé par le langage pour proposer des trajectoires ; et la Génération produit des descriptions ou simulations de conduite.

- Entrées BEV et multi-vues : des approches mettent l’accent sur les représentations Bird Eye View et l’intégration d’images multi-vues avec le raisonnement des LLM afin de produire des invites du type « trouvez les véhicules qui tournent à droite ».

- Perception guidée par le langage : les LLMs ajoutent une couche d’invites qui enrichissent les sorties de perception par des descriptions, questions ou analyses.

- Les invites comme leviers d’action : les invites guident où rogner ou examiner des régions et comment interpréter les détections pour orienter les décisions de planification.

- Identification et traçabilité 4D : des systèmes comme PromptTrack visent à attribuer des identifiants uniques aux objets à travers les images, permettant un suivi cohérent dans une chaîne guidée par le langage.

- Planification via des modèles de langage : des exemples incluent Talk2BEV, qui exploite des cartes BEV enrichies par le langage pour éclairer les décisions de planification, potentiellement avec des modèles tels que LLaVA ou des systèmes du type GPT.

- Génération et modèles du monde : GAIA‑1 démontre un pipeline où le texte et les images pilotent un modèle du monde capable de produire des vidéos ; d’autres projets (MagicDrive, Driving Into the Future, Driving Diffusion) génèrent des scénarios futurs à partir des données actuelles.

- Pas une solution miracle : l’article souligne que l’intérêt des LLM réside dans le raisonnement et l’invite plutôt que dans le remplacement d’un pipeline de contrôle déterministe. Fiabilité, traçabilité et sécurité restent des questions cruciales.

- Stade précoce et évolutif : les premiers travaux liés apparaissent vers la mi‑2023; la communauté explore encore quand, où et comment les LLMs ajoutent de la valeur dans la conduite, y compris des questions de latence, de sécurité et de vérification.

| Domaine | Ce que les LLMs apportent | Éléments du texte |

|---|---|---|

| Perception | Détection, corrélation entre les cadres, description en langage | |

| Mentionne HiLM-D, MTD-GPT et concepts de PromptTrack | ||

| Planification | Cartes BEV avec langage, invites de focalisation, proposition de trajectoires | |

| Talk2BEV et travaux associés | ||

| Génération | Génération de scènes/vidéos à partir de perception | |

| GAIA‑1, MagicDrive, Driving Into the Future, Driving Diffusion | ||

| Confiance et vérification | Recherche de transparence et problématiques de déterminisme | |

| Discussion sur les boîtes noires et les défis en temps réel |

Cas d’usage courants

- Amélioration de la perception : utilisation des LLMs pour interpréter les sorties de perception, annoter les scènes et décrire objets, lanes et relations spatiales, offrant une interface homme‑machine plus riche.

- Renforcement de la planification : des invites guident la prise de décision de planification, recadrent des régions d’intérêt et ajustent la trajectoire en fonction des sorties de perception.

- Génération et synthèse de données : produire de nouveaux scénarios ou scènes futures pour étoffer les données d’entraînement et tester le planificateur dans des conditions variées ; exemples comprennent GAIA‑1 qui génère des vidéos à partir de texte et d’images, et MagicDrive qui génère des scènes à partir des sorties de perception.

- Q&A et débogage : envisager un rôle de questions/réponses à bord (type Grok) pour répondre à des questions sur la scène actuelle, bien que l’utilisation en temps réel reste à démontrer.

- Boucle de données pour l’entraînement : utiliser des pipelines guidés par le langage pour créer ou annoter des données, améliorant potentiellement perception, cohérence du suivi et plausibilité du plan par un feedback itératif.

Configuration et installation

Aucune information spécifique dans la source sur la configuration ou l’installation. Le contenu est conceptuel et ne fournit pas d’instructions d’implémentation.

N/ADémarrage rapide

L’article offre des utilisations conceptuelles plutôt qu’un guide prêt à l’emploi. Un flux minimal, inspiré par le texte, pourrait être :

# Démarrage rapide conceptuel inspiré par l’article

# Données de perception avec carte BEV et détections

perception_output = {

'bev': '...représentation BEV...',

'objects': [ {'id': 1, 'type': 'vehicle', 'direction': 'left', 'speed': 25}, ... ]

}

prompt_llm = (

"Étant donné la carte BEV et les objets détectés, identifiez les dangers et proposez une action de conduite sûre. "

"Si utile, rognez la région frontale gauche et réévaluez."

)

# Exécution conceptuelle d’un LLM ; remplacez par votre API réelle

llm_response = LLM_run(model='gpt-4', prompt=prompt_llm, inputs=perception_output)

print(llm_response)Cela reflète l’idée de l’article selon laquelle les invites peuvent guider les sorties de perception vers des décisions de planification, par exemple en demandant au modèle de trouver les véhicules qui tournent à droite.

Démarrage rapide (exemple minimal et exécutable)

- Étape 1 : exécutez un module de perception pour produire une carte BEV et des détections.

- Étape 2 : invitez un LLM à interpréter les sorties et à proposer des actions sûres, en rognant éventuellement des régions pour inspection.

- Étape 3 : utilisez la sortie du LLM pour informer le module de planification ou générer une explication narrative de la scène.

Avantages et inconvénients

- Avantages

- Flexibilité : les LLMs apportent un raisonnement basé sur le langage qui peut interpréter et compléter les sorties de perception, favorisant une interface humain‑machine plus riche.

- Contrôle par prompts : les invites permettent d’ajuster dynamiquement l’attention et l’analyse sans retrain.

- Génération et synthèse de données : la génération de scénarios peut augmenter la diversité des données d’entraînement et tester le planificateur dans des conditions variées.

- Potentiel d’interprétabilité : même s’il n’est pas une solution parfaite, le raisonnement en langage peut offrir une narration traçable des décisions.

- Inconvénients

- Hallucinations et fiabilité : l’article souligne que les LLMs peuvent produire des sorties absurdes ou incorrectes, soulevant des questions de confiance.

- Boîte noire et déterminisme : des inquiétudes persistent quant à la traçabilité et au débogage dans un véhicule en temps réel.

- Défis de déploiement en temps réel : les premiers travaux restent à démontrer en environnement réel.

- Latence et sécurité : les contraintes de conduite exigent une latence faible et des garanties de sécurité robustes qui ne sont pas encore établies pour des systèmes combinant LLM et conduite.

Alternatives

Le paysage oppose pipelines modulaires et apprentissage de bout en bout. L’article résume ces contrastes ainsi : | Approche | Points forts | Points faibles |---|---|---| | Modulaire (perception + planification + contrôle) | Responsabilités claires ; testabilité ; débogage | Nécessite une intégration fiable entre modules ; possible latence entre modules |End-To-End | Pipeline plus simple ; potentiel de gains via optimisation conjointe | Boîte noire ; difficile à interpréter et vérifier ; sécurité potentielle |Amélioré par LLM (perception/planification/génération) | Ajoute raisonnement, invites et flexibilité ; potentiel d’amélioration de l’interaction humaine | Stade précoce ; questions de confiance et sécurité ; déploiement réel non démontré |

Prix ou licence

Non spécifié dans la source. Aucun détail sur les prix ou les licences des concepts discutés.

Références

More resources

Réduire les coûts de déploiement des modèles tout en conservant les performances grâce au swap de mémoire GPU

Exploitez le swap mémoire GPU (hot-swapping de modèles) pour partager les GPUs entre plusieurs LLM, réduire les coûts inoccupés et améliorer l’auto-Scaling tout en respectant les SLA.

Fine-Tuning gpt-oss pour la précision et les performances avec l’entraînement par quantisation (QAT)

Guide du fine-tuning de gpt-oss utilisant SFT + QAT pour récupérer la précision FP4 tout en préservant l’efficacité, avec upcast vers BF16, MXFP4, NVFP4 et déploiement avec TensorRT-LLM.

Comment les petits modèles linguistiques contribuent à une IA agentique évolutive

Explique comment les petits modèles linguistiques permettent une IA agentique plus rentable et flexible, aux côtés des LLMs, via NVIDIA NeMo et Nemotron Nano 2.

Comment faire évoluer vos agents LangGraph en production d’un seul utilisateur à 1 000 collègues

Guide pour déployer et faire évoluer des agents LangGraph en production avec le NeMo Agent Toolkit, des tests de charge et une mise en œuvre par étapes pour des centaines à des milliers d’utilisateurs.

NVFP4 Entraîne avec une Précision de 16 Bits et une Vitesse et Efficacité de 4 Bits

NVFP4 est un format de données en 4 bits offrant une précision équivalente au FP16 avec la bande passante et l’efficacité mémoire du 4 bits, étendu au pré-entraînement pour les grands modèles de langage. Ce profil couvre des expériences en 12B, la stabilité et les collaborations industrielles.

TextQuests : Évaluer les LLM dans des jeux d’aventure textuels

TextQuests est un benchmark qui évalue les agents LLM sur 25 jeux classiques d’infocom, mettant l’accent sur le raisonnement en contexte long et l’exploration autonome.