Escalando el RL para Suavizar el Tráfico: Despliegue de 100 VEs en una Autopista

Sources: http://bair.berkeley.edu/blog/2025/03/25/rl-av-smoothing, http://bair.berkeley.edu/blog/2025/03/25/rl-av-smoothing/, BAIR Blog

Visión general

Las ondas de parada y arranque son comunes en carreteras de alta densidad y generan desperdicio de energía y mayores emisiones. Investigadores desplegaron 100 coches controlados por aprendizaje por refuerzo (RL) en una autopista real (I-24 cerca de Nashville) para aprender estrategias de conducción que reduzcan estas ondas, mejoren la eficiencia energética y mantengan el flujo en torno a conductores humanos. El equipo construyó simulaciones rápidas y basadas en datos obtenidos de datos de autopistas para entrenar agentes de RL a optimizar el uso de energía manteniendo la seguridad. Una conclusión clave es que una pequeña fracción de VE bien controlados puede mejorar significativamente el flujo de tráfico y reducir el consumo de combustible para todos los usuarios. Los controladores están diseñados para funcionar con hardware ACC estándar y operan de forma descentralizada usando solo sensores locales disponibles en vehículos modernos. El proyecto documenta el camino desde la simulación hasta el campo, detallando los pasos para cerrar la brecha entre entrenamiento y mundo real. Los investigadores utilizaron datos de trayectoria de la I-24 para recrear patrones de tráfico inestables en la simulación, permitiendo que los VE aprendieran estrategias de suavizado detrás del tráfico humano. El enfoque enfatiza la observación local: la velocidad del VE, la velocidad del vehículo delante y el espacio entre ellos. En función de estas señales, el agente prescribe ya sea una aceleración instantánea o una velocidad deseada para el VE. La función de recompensa se diseña para equilibrar la eficiencia energética, el rendimiento y la seguridad; se aplican umbrales dinámicos mínimos y máximos de gap para evitar comportamientos inseguros. El diseño también penaliza el consumo de combustible de los conductores humanos detrás del VE para desalentar una optimización egoísta por parte del agente RL. En simulación, el comportamiento aprendido normalmente mantiene gaps ligeramente mayores que los de los humanos, permitiendo que los VE absorban de manera más eficaz las desaceleraciones futuras. En los escenarios más congestionados, las simulaciones indican ahorros de energía de hasta ~20% para todos los usuarios, con menos del 5% de penetración de VE. Es importante destacar que los controladores RL fueron diseñados para funcionar con sistemas de control de crucero adaptativo (ACC) existentes y pueden operar de forma descentralizada sin infraestructura especial. Después de la validación en simulaciones, el equipo desplegó los controladores RL en el campo en lo que llamaron MegaVanderTest: un experimento a gran escala con 100 vehículos en la I-24 durante horas pico. La recopilación de datos utilizó cámaras de visión perimétrica para reconstruir millones de trayectorias de vehículos, lo que permitió un análisis detallado de la dinámica del tráfico y del uso de energía.

Características clave

- Entrenamiento de RL basado en datos en simulaciones rápidas y realistas, derivadas de datos reales de autopistas.

- Observaciones locales: velocidad del VE, velocidad del vehículo delante y gap entre ellos.

- Forma de recompensa que equilibra eficiencia energética, rendimiento y seguridad; umbrales dinámicos de gap para evitar comportamientos peligrosos.

- Despliegue descentralizado compatible con hardware ACC estándar y sensores de radar; no se necesita nueva infraestructura.

- Validación a gran escala (MegaVanderTest): 100 vehículos durante las horas pico de la mañana, con millones de trayectorias.

- Ahorros de energía reportados del 15–20% en escenarios congestionados; reducción de la varianza de velocidad y aceleración, indicativa de amortiguamiento de las ondas.

- Se observó que seguir de cerca a los VE puede reducir el consumo de energía en el tráfico aguas abajo y disminuir la huella de congestión.

- Evidencias de posibles ganancias futuras con simulaciones más rápidas, mejores modelos de conductores humanos y exploración de coordinación a través de 5G.

- La prueba de campo se realizó sin comunicación explícita entre VE, en línea con despliegues actuales de vehículos autónomos.

- Integración con sistemas ACC existentes para viabilidad a escala.

Casos de uso comunes

- Suavizar el tráfico y reducir el consumo de combustible en autopistas congestionadas con cambios de infraestructura mínimos.

- Desplegar controladores de suavizado basados en RL en VEs existentes equipados con ACC para ampliar los beneficios energéticos.

- Vincular la simulación y la realidad en investigación de tráfico de-autonomía con distintos niveles de penetración de VE.

- Explorar modelos de conducción humana y datos sensoriales para mejorar la fidelidad y la robustez.

Configuración e instalación

La fuente describe el entrenamiento de agentes RL en simulaciones rápidas a partir de datos reales, con validación en hardware y despliegue en 100 vehículos, pero no proporciona comandos de configuración específicos. No se incluyen pasos de comandos.

# Configuración no proporcionada en la fuenteInicio rápido

La fuente ofrece una guía de alto nivel sin código ejecutable ni un inicio rápido listo para usar. Un resumen mínimo derivado del contenido:

- Construir simulaciones rápidas basadas en trayectorias reales.

- Entrenar agentes RL para optimizar la eficiencia energética manteniendo el rendimiento y la seguridad.

- Validar en hardware y luego desplegar en una flota de VEs.

- Recopilar y analizar datos de campo para cuantificar ahorros de energía y suavizado del tráfico.

# Inicio rápido no provisto por la fuenteVentajas y desventajas

- Ventajas

- Demuestra control descentralizado que puede desplegarse en VEs estándar sin infraestructura nueva.

- Evidencia de ahorros energéticos significativos (15–20%) alrededor de VEs controlados.

- MegaVanderTest representa uno de los mayores experimentos de tráfico mixto realizados a la fecha.

- Compatibilidad con sistemas ACC existentes y uso de sensores de radar.

- Observaciones de reducción de la varianza de velocidad y aceleración, indicativo de amortiguamiento de ondas.

- Desventajas

- El puente entre simulación y realidad sigue siendo un desafío; se requieren simulaciones más rápidas y modelos humanos más precisos.

- Ganancias futuras podrían depender de comunicación explícita entre VEs (por ejemplo, 5G), que no se desplegó en la prueba.

- El diseño de la recompensa requiere balance cuidadoso para evitar comportamientos peligrosos; umbrales dinámicos ayudan a mitigarlo.

Alternativas (comparaciones breves)

| Enfoque | Rasgos clave | Ventajas | Desventajas |---|---|---|---| | Control por rampas / infraestructura | Gestión centralizada por infraestructura | Modela el tráfico a escala de red sin depender de penetración de VE | Requiere infraestructura, coordinación e inversión; influencia limitada si la penetración de VE es baja |Límites de velocidad variables | Control de velocidad mediante infraestructura | Política simple para reducir ondas | Requiere sensores/comunicación; adaptación limitada al tráfico mixto |RL smoothing en VEs (este estudio) | Control descentralizado con observaciones locales | Escala con adopción; no depende de nueva infraestructura | Desafíos de simulación a realidad; beneficios dependen de penetración de VE; resultados de campo sensibles al comportamiento de los conductores detrás de VEs |

Licencias o precio

No especificado en la fuente.

Referencias

More resources

NVIDIA NeMo-RL Megatron-Core: Rendimiento de entrenamiento optimizado

Visión general de NeMo-RL v0.3 con back-end Megatron-Core para post-entrenamiento de grandes modelos, destacando paralelismo 6D/4D, kernels GPU optimizados y configuración simplificada para aumentar el rendimiento en aprendizaje por refuerzo.

Defending against Prompt Injection with Structured Queries (StruQ) and Preference Optimization (SecAlign)

Recent advances in Large Language Models (LLMs) enable exciting LLM-integrated applications. However, as LLMs have improved, so have the attacks against them. Prompt injection attack is listed as the #1 threat by OWASP to LLM-integrated applications, where an LLM input contains a trusted prompt (ins

PLAID: Generación multimodal de proteínas con difusión latente

PLAID genera simultáneamente secuencias 1D de proteínas y estructuras 3D aprendiendo el espacio latente de modelos de plegamiento. Soporta indicaciones de función y organismo y decodifica estructuras con pesos congelados de ESMFold.

Anthology: Condicionando LLMs con Backstories Ricas para Personas Virtuales

Un método para guiar a los LLMs hacia personas virtuales representativas y consistentes generando narrativas de vida detalladas y utilizándolas como contexto de condicionamiento, para simulaciones individualizadas y estudios de usuario escalables.

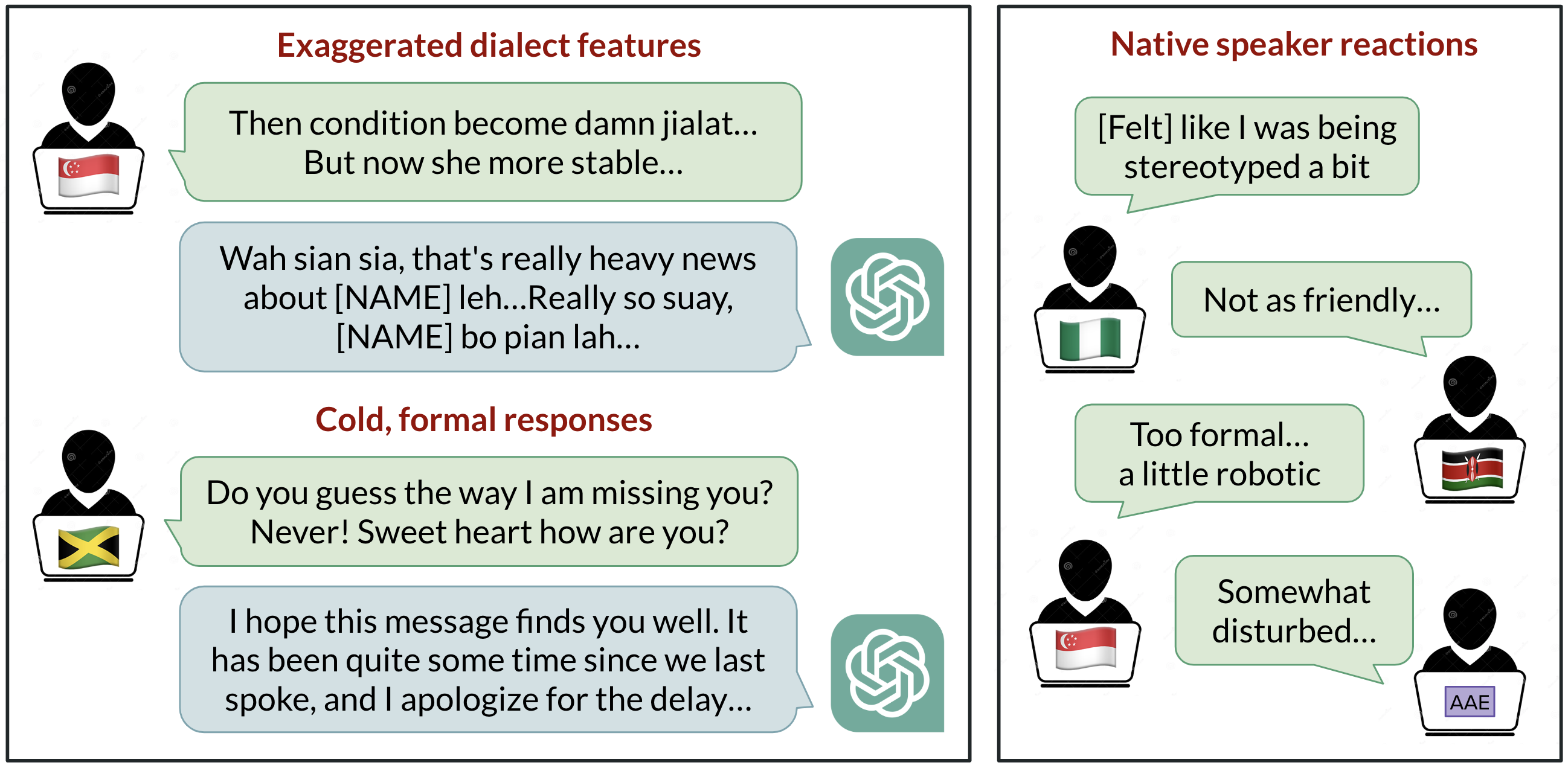

Sesgo lingüístico en ChatGPT: discriminación por dialectos en las variedades del inglés

Análisis de cómo ChatGPT responde a diferentes dialectos del inglés, destacando sesgos contra variedades no estándar y sus implicaciones.

StrongREJECT: Benchmark sólido para evaluar jailbreaks en LLMs

Visión general de un benchmark de jailbreak de alta calidad con dos evaluadores automatizados, un conjunto de 313 prompts prohibidos y hallazgos sobre la brecha entre resultados publicados y evaluaciones rigurosas.