Visual Haystacks (VHs): Benchmark de razonamiento visual multi-imagen

Sources: http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks, http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks/, BAIR Blog

Visión general

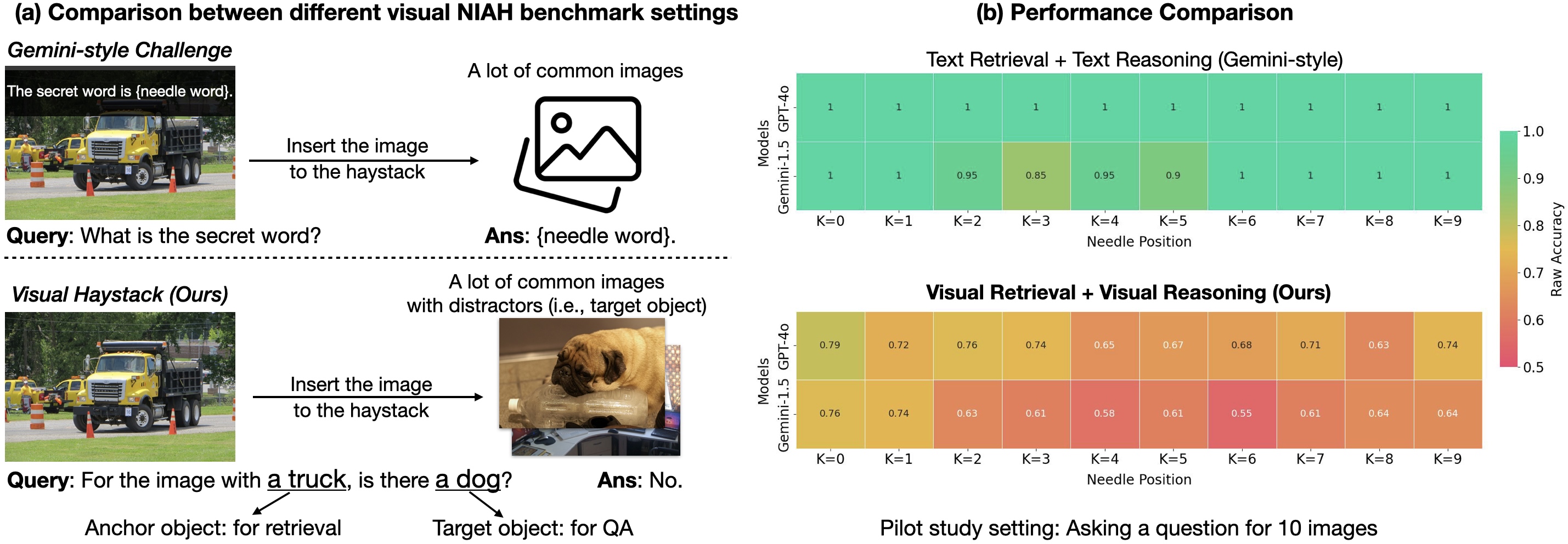

Visual Haystacks (VHs) es el primer benchmark centrado en visión de Needle-In-A-Haystack (NIAH) diseñado para evaluar rigurosamente Modelos Multimodales Grandes (LMM) en el procesamiento de información visual en contextos largos. El objetivo es ir más allá del VQA con una imagen y probar recuperación y razonamiento a través de grandes conjuntos de imágenes no correlacionadas. El dataset se centra en identificar presencia de contenido visual específico (p. ej., objetos) en imágenes tomadas del COCO, con aproximadamente 1K pares binarios de preguntas y respuestas incrustados en montones (haystacks) que pueden contener entre 1 y 10K imágenes. La tarea se divide en dos desafíos: Single-Needle (una aguja) y Multi-Needle (varias agujas). El benchmark destaca tres deficiencias principales de los LMM cuando se enfrentan a entradas visuales extensas: dificultad con distracciones visuales, dificultad para razonar entre múltiples imágenes y sensibilidad a la posición de la aguja en la secuencia de entrada (efecto de “perdido en medio”). En respuesta, los autores presentan MIRAGE (Multi-Image Retrieval Augmented Generation), un paradigma de entrenamiento de código abierto en un solo paso que extiende LLaVA para manejar tareas MIQA. MIRAGE aplica compresión de codificaciones, utiliza un recuperador integrado para filtrar imágenes irrelevantes y añade datos de entrenamiento de razonamiento con múltiples imágenes. El resultado es un modelo capaz de manejar 1K o 10K imágenes y que demuestra una alta capacidad de recall y precisión en tareas multi-imagen, superando a varios baselines en muchos escenarios de aguja única. Este trabajo también compara un enfoque de dos etapas (captioning con LLaVA seguido de una respuesta en texto usando Llama3) con modelos visuales conscientes y muestra que la integración de leyendas en contextos largos por parte de LLMs puede ser eficaz, mientras que los LMMs existentes a menudo tienen dificultades para integrar información entre varias imágenes. El benchmark VHs y MIRAGE buscan impulsar avances en recuperación visual robusta y razonamiento sobre grandes colecciones de imágenes. Para más detalles y datos, consulta la fuente: https://bair.berkeley.edu/blog/2024/07/20/visual-haystacks/

Características clave

- Razonamiento visual en contexto largo sobre grandes conjuntos de imágenes no correlacionadas (aprox. 1K pares QA; haystacks de 1K a 10K imágenes).

- Dos desafíos: Single-Needle (una aguja) y Multi-Needle (2 a 5 agujas).

- Tareas de contenido visual basadas en anotaciones COCO (por ejemplo, presencia de un objeto objetivo).

- Paradigma MIRAGE de código abierto (Multi-Image Retrieval Augmented Generation) construido sobre LLaVA para MIQA.

- Compresión de consultas para reducir tokens de codificación, posibilitando haystacks más grandes dentro de los límites de contexto.

- Recuperador integrado entrenado con el flujo de ajuste fino del LLM para filtrar dinámicamente imágenes irrelevantes.

- Datos de entrenamiento multi-imagen: aumento con datos de razonamiento multi-imagen y datos sintéticos.

- MIRAGE logra rendimiento de punta en la mayoría de tareas de aguja única y demuestra fuertes tasas de recall y precisión en tareas multi-imagen, superando a baselines como GPT-4, Gemini-v1.5 y LWM en muchos escenarios.

- El recuperador entrenado en co‑tareas supera a CLIP en este setting MIQA específico, destacando que recuperadores genéricos pueden rendir peor cuando la tarea depende de textos tipo pregunta y relevancia visual.

- Paradigma de entrenamiento simple y de código abierto, en un solo paso, diseñado para abordar los principales desafíos de MIQA: distractores, contexto largo y razonamiento entre imágenes.

- Identificación de fenómenos como el efecto de posición de la aguja, donde el rendimiento del modelo varía significativamente según la posición de la imagen-aguja en la secuencia (por ejemplo, caídas de hasta ~26,5% para algunos LMM cuando no se coloca justo antes de la pregunta; modelos propietarios muestran caídas de hasta ~28,5% cuando no están al principio).

Casos de uso comunes

- Analizar patrones en grandes colecciones de imágenes médicas (p. ej., localizar hallazgos en múltiples imágenes).

- Monitorear deforestación o cambios ecológicos mediante imágenes satelitales a lo largo del tiempo.

- Mapear cambios urbanos usando datos de navegación autónoma y sensores.

- Examinar grandes colecciones de arte en busca de motivos u objetos visuales específicos.

- Comprender el comportamiento del consumidor a partir de imágenes de vigilancia minorista a gran escala.

Configuración e instalación

Los detalles de configuración e instalación no están disponibles en la fuente.

# Detalles de configuración no proporcionados en la fuenteInicio rápido

Nota: la fuente describe un flujo conceptual en lugar de una receta lista para ejecutar. Un esquema de alto nivel basado en el enfoque descrito:

- Reunir un haystack: recolectar un gran conjunto de imágenes no correlacionadas (1K–10K) con anotaciones COCO para objetos objetivo.

- Preparar la consulta: definir el objeto ancla y el objeto objetivo para la tarea de aguja.

- Usar MIRAGE como pipeline de un solo paso: aplicar compresión de codificaciones para reducir tokens, ejecutar el recuperador en línea para filtrar imágenes irrelevantes y aprovechar datos de entrenamiento multi-imagen.

- Evaluar: medir tareas de aguja única y multi-aguja, comparando con baselines como captioning+LLM u otros LMMs.

# Flujo conceptual (ilustrativo; no es un script ejecutable)

imágenes = cargar_dataset("COCO", count=1000_a_10000)

qa = crear_qa_binaria(objeto_A, objeto_B)

modelo = MIRAGE()

respuesta = modelo.responder(imágenes, qa)

print(respuesta)Pros y contras

- Pros:

- Permite razonamiento en contexto largo sobre miles de imágenes potencialmente no relacionadas.

- Codificaciones comprimidas permiten ampliar haystacks más allá de los límites de contexto.

- Recuperador integrado reduce datos irrelevantes, mejorando la recuperación.

- Datos de entrenamiento multi-imagen mejoran la generalización para tareas MIQA.

- MIRAGE ofrece un rendimiento sólido en tareas de aguja única y resultados competitivos en tareas multi-imagen; el recuperador puede superar a CLIP en este setting.

- Contras:

- La precisión disminuye a medida que los haystacks se hacen más grandes para muchos modelos debido a distracciones visuales.

- En escenarios 5+ imágenes y multi-aguja, muchos LMMs presentan rendimientos inferiores frente a una baseline de captioning+LLM en ciertos casos.

- Efectos de posición de la aguja pueden influir significativamente en el rendimiento (hasta ~26,5% de variación según modelo y posición).

Alternativas (comparación breve)

- VQA tradicional en una sola imagen: limitado a una imagen; no aborda recuperación entre imágenes ni razonamiento en contexto largo.

- Benchmarks NIAH basados en texto (Gemini-style): centrados en recuperación o razonamiento textual; VHs extiende esto a datos visuales multi-imagen y razonamiento entre imágenes.

- Baseline de captioning (LLaVA + Llama3): usa una leyenda de imágenes seguida de QA en texto; puede superar a algunos LMMs de punta en ciertas tareas multi-imagen, pero puede perder cuando los indicadores visuales son críticos. | Enfoque | Enfoque | Fortalezas | Debilidades |---|---|---|---| | MIRAGE (base VHs) | QA multi-imagen con recuperación | Alto recall/precisión en MIQA; código abierto; supera baselines en muchas tareas de aguja única | Requiere preparación de datos y ajuste MIQA; efectos de posición de la aguja pueden modificar el rendimiento |Captioning + LLM (dos etapas) | QA basado en texto a partir de leyendas | Robusto cuando las leyendas capturan la información clave | Puede subutilizar detalles visuales; matices visuales pueden ser críticos |LMMs avanzados (GPT-4o, Gemini-v1.5) | VQA visual directo sobre varias imágenes | Potencialmente fuertes en ciertos contextos | Resultados bajos en escenarios 5+ imágenes y multi-aguja en este estudio; límites de contexto y de carga |

Licencias o Precios

No se proporcionan detalles de precios o licencias en la fuente. MIRAGE se describe como open-source dentro del contexto del benchmark, pero no se especifican términos de licencia.

Referencias

- Visual Haystacks: Are We Ready for Multi-Image Reasoning? Launching VHs: The Visual Haystacks Benchmark!. BAIR Blog. https://bair.berkeley.edu/blog/2024/07/20/visual-haystacks/

More resources

Ajuste fino de gpt-oss para Precisión y Rendimiento con Entrenamiento Consciente de Cuantización (QAT)

Guía de afinado fino de gpt-oss usando SFT + QAT para recuperar precisión FP4 manteniendo la eficiencia, con upcasting a BF16, MXFP4, NVFP4 y despliegue con TensorRT-LLM.

TextQuests: Evaluar LLMs en Juegos de Aventura Basados en Texto

TextQuests es un benchmark que evalúa agentes LLM en 25 juegos clásicos de ficción interactiva, enfatizando razonamiento de contexto largo y exploración autónoma.

Defending against Prompt Injection with Structured Queries (StruQ) and Preference Optimization (SecAlign)

Recent advances in Large Language Models (LLMs) enable exciting LLM-integrated applications. However, as LLMs have improved, so have the attacks against them. Prompt injection attack is listed as the #1 threat by OWASP to LLM-integrated applications, where an LLM input contains a trusted prompt (ins

PLAID: Generación multimodal de proteínas con difusión latente

PLAID genera simultáneamente secuencias 1D de proteínas y estructuras 3D aprendiendo el espacio latente de modelos de plegamiento. Soporta indicaciones de función y organismo y decodifica estructuras con pesos congelados de ESMFold.

Escalando el RL para Suavizar el Tráfico: Despliegue de 100 VEs en una Autopista

100 coches controlados por RL desplegados en la I-24 durante la hora punta para atenuar las ondas de parada y arranque, mejorar el flujo y reducir el consumo de combustible para todos los usuarios. Control descentralizado con sensores radar básicos.

Anthology: Condicionando LLMs con Backstories Ricas para Personas Virtuales

Un método para guiar a los LLMs hacia personas virtuales representativas y consistentes generando narrativas de vida detalladas y utilizándolas como contexto de condicionamiento, para simulaciones individualizadas y estudios de usuario escalables.