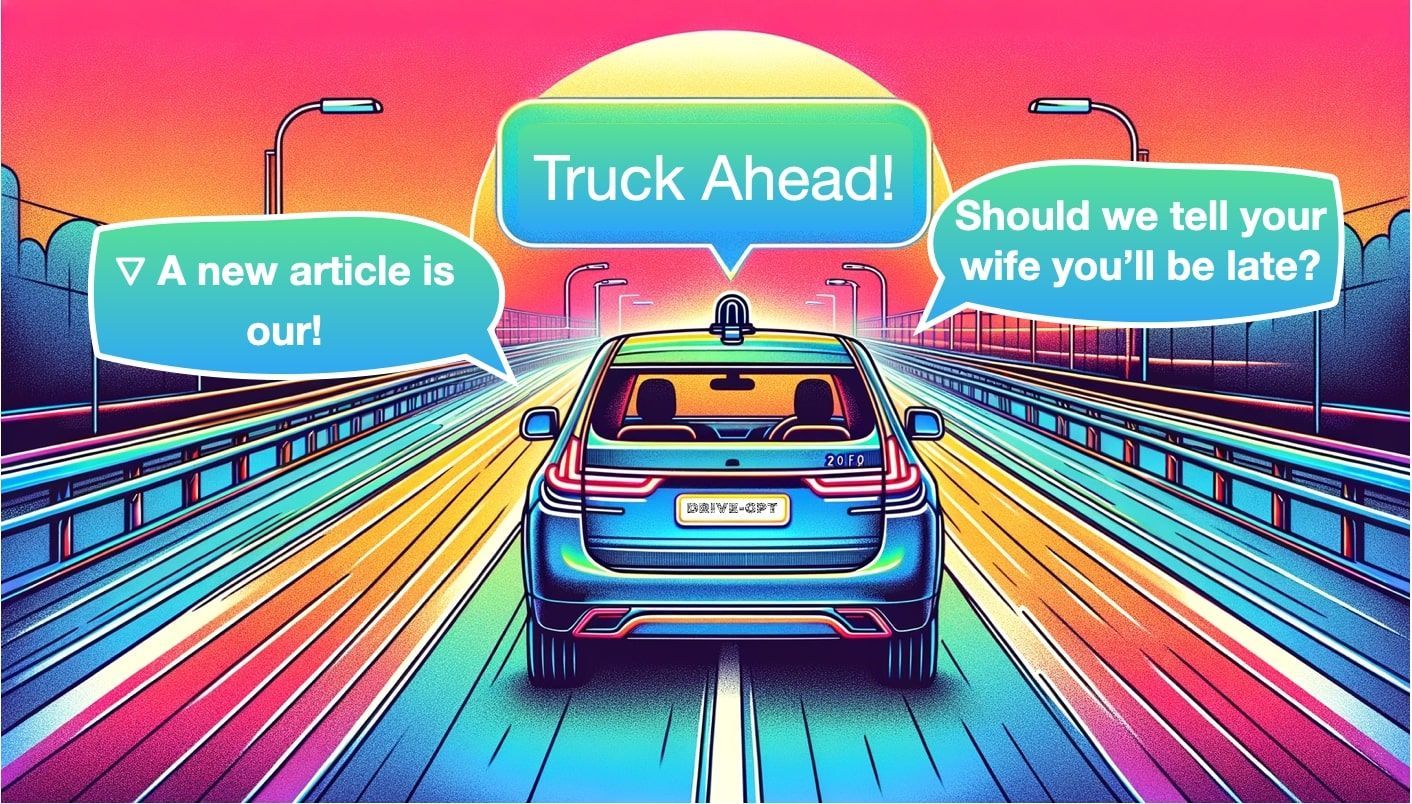

Car-GPT: ¿Pueden los LLMs hacer realidad los coches autónomos?

Sources: https://thegradient.pub/car-gpt, https://thegradient.pub/car-gpt/, The Gradient

Visión general

La conducción autónoma ha oscilado entre una arquitectura modular (Percepción, Localización, Planificación, Control) y el encanto del aprendizaje de extremo a extremo. El artículo de The Gradient, Car-GPT, explora cómo los grandes modelos de lenguaje (LLMs) podrían ayudar a conectar percepción, planificación y generación a través de prompts que describen escenas, intenciones o escenarios futuros. El texto subraya que se trata de una área de investigación temprana: hay potencial, pero no está probado aún en vehículos en operación. El autor inicia con una analogía a la descubrimiento accidental de la penicilina para ilustrar cómo ideas útiles pueden emerger de sistemas basados en datos cuando los métodos tradicionales no resuelven el problema. En la conducción autónoma, un cambio similar podría venir de LLMs que razonan sobre salidas de percepción, consultan imágenes o videos y proponen o critican acciones de conducción. El artículo señala que la primera ola de trabajos que mencionan LLMs en coches autónomos apareció alrededor de mediados de 2023, y revisa un panorama amplio de enfoques, desde mejoras de percepción hasta planificación y generación. Se destacan tres direcciones de investigación: (1) Percepción, donde la entrada son imágenes (o vistas BEV) y la salida incluye detecciones, carriles y otras anotaciones de escena; (2) Planificación, donde el sistema propone u optimize una ruta; y (3) Generación, donde modelos basados en lenguaje crean descripciones, predicciones o incluso escenas futuras para mejorar los datos y la planificación. En este marco, los LLMs no reemplazan a los módulos de software automotriz; más bien los complementan con razonamiento en lenguaje, prompts específicos para tareas y inferencias basadas en datos. El artículo describe varias familias de modelos y trabajos representativos que ilustran dónde pueden aportar valor los LLMs:

- Detección, Predicción y Seguimiento en Percepción con modelos como HiLM-D y MTD-GPT;

- Percepción BEV y análisis guiado por lenguaje mediante sistemas como Talk2BEV, que combina BEV con razonamiento de LLM;

- El uso de prompts para guiar una salida de percepción (por ejemplo, pedir al LLM que recorte regiones o enfoque la atención);

- Planificación que utiliza razonamiento guiado por lenguaje para proponer trayectorias; y

- Generación: enfoques que generan escenas o vídeos a partir de texto e imágenes (GAIA‑1 de Wayve) o generan escenas futuras a partir de datos de conducción (MagicDrive, Driving Into the Future, Driving Diffusion). El artículo subraya tres tareas centrales que coinciden con el uso de LLMs en la conducción: Detección (qué hay en la escena), Predicción (cómo se moverán los objetos) y Seguimiento (mantener IDs consistentes a lo largo del tiempo). Luego describe cómo estos outputs pueden ser mejorados o reinterpretados por un LLM para producir decisiones de conducción accionables o una comprensión de escena más rica. El autor plantea preocupaciones prácticas: el riesgo de alucinaciones, la naturaleza de caja negra de los grandes modelos y el desafío de hacer sistemas confiables para conducción en tiempo real. Si bien algunos investigadores proponen un modelo Grok en el vehículo para responder preguntas sobre la escena actual, el artículo afirma que aún estamos en una etapa muy temprana. Reconociendo tanto las promesas como los riesgos, sugiere que la comunidad siga un camino experimental cuidadoso y esté atenta a la literatura que evoluciona. En conjunto, Car-GPT enmarca a los LLMs como un componente potencial de una pila de conducción autónoma multimodal, con razonamiento en lenguaje y promps que pueden mejorar percepción, planificación y generación, siempre y cuando se vean como complemento a los sistemas existentes y no como un reemplazo directo.

Características clave

- Tres familias de uso de LLMs en la conducción: Percepción, Planificación y Generación. Percepción incluye detección y descripción de objetos, carriles y semántica de la escena; la Planificación usa razonamiento guiado por lenguaje para proponer trayectorias; y la Generación produce descripciones o simulaciones de conducción.

- Entradas BEV y multi‑vista: algunos enfoques enfatizan representaciones Bird Eye View y la integración de imágenes multi‑vista con razonamiento de LLM para generar prompts como “encuentra los vehículos que están girando a la derecha”.

- Percepción guiada por lenguaje: los LLMs añaden una capa de prompts que enriquecen las salidas de percepción con descripciones, preguntas o análisis.

- Los prompts como palancas: los prompts guían dónde recortar o examinar regiones y cómo interpretar las detecciones para impulsar decisiones de planificación.

- Identificación y trazabilidad 4D: sistemas como PromptTrack buscan asignar IDs únicos a objetos a través de fotogramas, habilitando un seguimiento consistente en una cadena de procesos guiada por lenguaje.

- Planificación mediante modelos de lenguaje: ejemplos como Talk2BEV utilizan mapas BEV enriquecidos por lenguaje para informar decisiones de planificación, potencialmente junto con modelos como LLaVA o GPT‑class.

- Generación y modelos del mundo: GAIA‑1 demuestra un pipeline donde texto e imágenes impulsan un modelo del mundo capaz de producir vídeo; otros proyectos (MagicDrive, Driving Into the Future, Driving Diffusion) generan escenarios futuros.

- No es una sustitución milagrosa: el artículo subraya que el valor de los LLMs reside en el razonamiento y en los prompts, no en reemplazar pipelines determinísticos; fiabilidad, transparencia y seguridad siguen siendo desafíos.

- Etapa inicial y evolución: los primeros trabajos se publicaron alrededor de mediados de 2023; la comunidad sigue investigando cuándo, dónde y cómo los LLMs aportan valor en la conducción, incluyendo preguntas sobre latencia, seguridad y verificación. | Área | Qué añaden los LLMs | Evidencia del artículo |---|---|---| | Percepción | Detección, correlación entre frames, descripción en lenguaje | Menciona HiLM-D, MTD-GPT y conceptos de PromptTrack |Planificación | Mapas BEV con lenguaje, prompts para focalización, propuesta de trayectorias | Talk2BEV y trabajos asociados |Generación | Generación de escenas/vídeos a partir de percepción | GAIA‑1, MagicDrive, Driving Into the Future, Driving Diffusion |Confianza y verificación | Búsqueda de transparencia y cuestiones de determinismo | Discusión sobre cajas negras y desafíos en tiempo real |

Casos de uso comunes

- Mejora de percepción: usar LLMs para interpretar salidas de percepción, anotar escenas y describir objetos, carriles y relaciones espaciales, habilitando una interfaz humano‑máquina más rica.

- Mejora de planeación: usar prompts para guiar decisiones de planificación, recortando áreas de interés y ajustando la trayectoria según salidas de percepción.

- Generación y síntesis de datos: producir nuevos escenarios o escenas futuras para ampliar los datos de entrenamiento y probar el planificador en condiciones diversas; ejemplos incluyen GAIA‑1 que genera vídeos a partir de texto y imágenes, y MagicDrive que genera escenas a partir de salidas de percepción.

- Preguntas y respuestas y depuración: imaginar un rol de preguntas y respuestas a bordo (tipo Grok) para responder preguntas sobre la escena actual, aunque su uso en vivo aún no está demostrado.

- Bucle de datos para entrenamiento: usar pipelines guiados por lenguaje para crear o anotar datos, mejorando potencialmente percepción, coherencia de seguimiento y plausibilidad de planificación mediante retroalimentación iterativa.

Configuración e instalación

No hay especificaciones en la fuente sobre configuración o instalación. El contenido es conceptual y describe el panorama de investigación, no instrucciones de implementación.

N/AInicio rápido

El artículo ofrece usos conceptuales, no una guía práctica. Un flujo mínimo inspirado en el texto podría ser:

# Inicio rápido conceptual inspirado por el artículo

# Datos de percepción con mapa BEV y detecciones

perception_output = {

'bev': '...representación BEV...',

'objects': [ {'id': 1, 'type': 'vehicle', 'direction': 'left', 'speed': 25}, ... ]

}

prompt_llm = (

"Dado el mapa BEV y los objetos detectados, identifique peligros y proponga una acción de conducción segura. "

"Si es útil, recorte la región frontal izquierda y vuelva a evaluar."

)

# Ejecución conceptual de un LLM; sustituye por tu API real

llm_response = LLM_run(model='gpt-4', prompt=prompt_llm, inputs=perception_output)

print(llm_response)Esto refleja la idea del artículo de que las invitaciones pueden guiar salidas de percepción hacia decisiones de planificación, por ejemplo, pidiendo al modelo que encuentre vehículos que giran a la derecha.

Inicio rápido (ejemplo mínimo ejecutable)

- Paso 1: Ejecuta un módulo de percepción para producir un mapa BEV y detecciones.

- Paso 2: Invita a un LLM a interpretar las salidas y proponer acciones seguras, recortando regiones para inspección cuando haga falta.

- Paso 3: Usa la salida del LLM para informar un módulo de planificación o generar una explicación narrativa de la escena.

Pros y contras

- Pros

- Flexibilidad: los LLMs ofrecen razonamiento en lenguaje que puede interpretar y complementar salidas de percepción, facilitando una interacción humano‑máquina más rica.

- Control por prompts: los prompts permiten ajustar dinámicamente atención y análisis sin entrenamiento adicional.

- Generación de datos y simulación: la generación de escenarios puede ampliar la diversidad de datos de entrenamiento y probar el planificador bajo condiciones variadas.

- Potencial de interpretabilidad: el razonamiento en lenguaje puede proporcionar una narrativa trazable de las decisiones.

- Contras

- Alucinaciones y fiabilidad: el artículo señala que los LLMs pueden producir salidas falsas o absurdas, planteando cuestiones de confianza.

- Caja negra y determinismo: persisten preocupaciones sobre la trazabilidad y depuración en un vehículo en tiempo real.

- Desafíos de despliegue en tiempo real: la investigación está en una etapa temprana, con evidencia limitada de uso en línea.

- Latencia y seguridad: la conducción en tiempo real exige baja latencia y garantías de seguridad robustas, que aún no están totalmente establecidas para pilas que combinen LLM y conducción.

Alternativas

El paisaje contrasta pipelines modulares y aprendizaje de extremo a extremo. El artículo resume estos contrastes así: | Enfoque | Fortalezas | Debilidades |---|---|---| | Modular (percepción + planificación + control) | Responsabilidades claras; probabilidad de prueba; depuración | Requiere una integración fiable entre módulos; posible latencia entre transiciones |End-To-End | Pipeline más simple; potencial de rendimiento por optimización conjunta | Caja negra; difícil de interpretar/verificar; seguridad potencial |Mejorado por LLM (percepción/planificación/generación) | Añade razonamiento, prompts y flexibilidad; posible mejora de interacción humano | Estadio temprano; cuestiones de confianza y seguridad; despliegue real no probado |

Precio o Licencia

No especificado en la fuente. No hay detalles de precios o licencias para los conceptos discutidos.

Referencias

More resources

Reducir costos de implementación de modelos manteniendo el rendimiento con intercambio de memoria de GPU

Utiliza el intercambio de memoria de GPU (hot-swapping de modelos) para compartir GPUs entre varios LLM, reducir costos de GPU ociosas y mejorar el autoescalado manteniendo los SLA.

Ajuste fino de gpt-oss para Precisión y Rendimiento con Entrenamiento Consciente de Cuantización (QAT)

Guía de afinado fino de gpt-oss usando SFT + QAT para recuperar precisión FP4 manteniendo la eficiencia, con upcasting a BF16, MXFP4, NVFP4 y despliegue con TensorRT-LLM.

Cómo los modelos de lenguaje pequeños son la clave para una IA agentica escalable

Explica cómo los modelos de lenguaje pequeños permiten IA agentica más rentable y flexible junto a LLMs, mediante NVIDIA NeMo y Nemotron Nano 2.

Cómo Escalar tus Agentes LangGraph en Producción de un Solo Usuario a 1,000 Compañeros

Guía para desplegar y escalar agentes LangGraph en producción usando NeMo Agent Toolkit, pruebas de carga y despliegue por fases para cientos a miles de usuarios.

NVFP4 Entrena con Precisión de 16 Bits y Velocidad y Eficiencia de 4 Bits

NVFP4 es un formato de datos de 4 bits que ofrece precisión similar a FP16 con el rendimiento y la eficiencia de memoria de 4 bits, extendido al preentrenamiento de grandes modelos de lenguaje. Este perfil aborda experimentos a nivel 12B, estabilidad y colaboraciones industriales.

TextQuests: Evaluar LLMs en Juegos de Aventura Basados en Texto

TextQuests es un benchmark que evalúa agentes LLM en 25 juegos clásicos de ficción interactiva, enfatizando razonamiento de contexto largo y exploración autónoma.