¿Por qué mi modelo no funciona? Guía práctica de fallas en ML

Sources: https://thegradient.pub/why-doesnt-my-model-work, https://thegradient.pub/why-doesnt-my-model-work/, The Gradient

Visión general

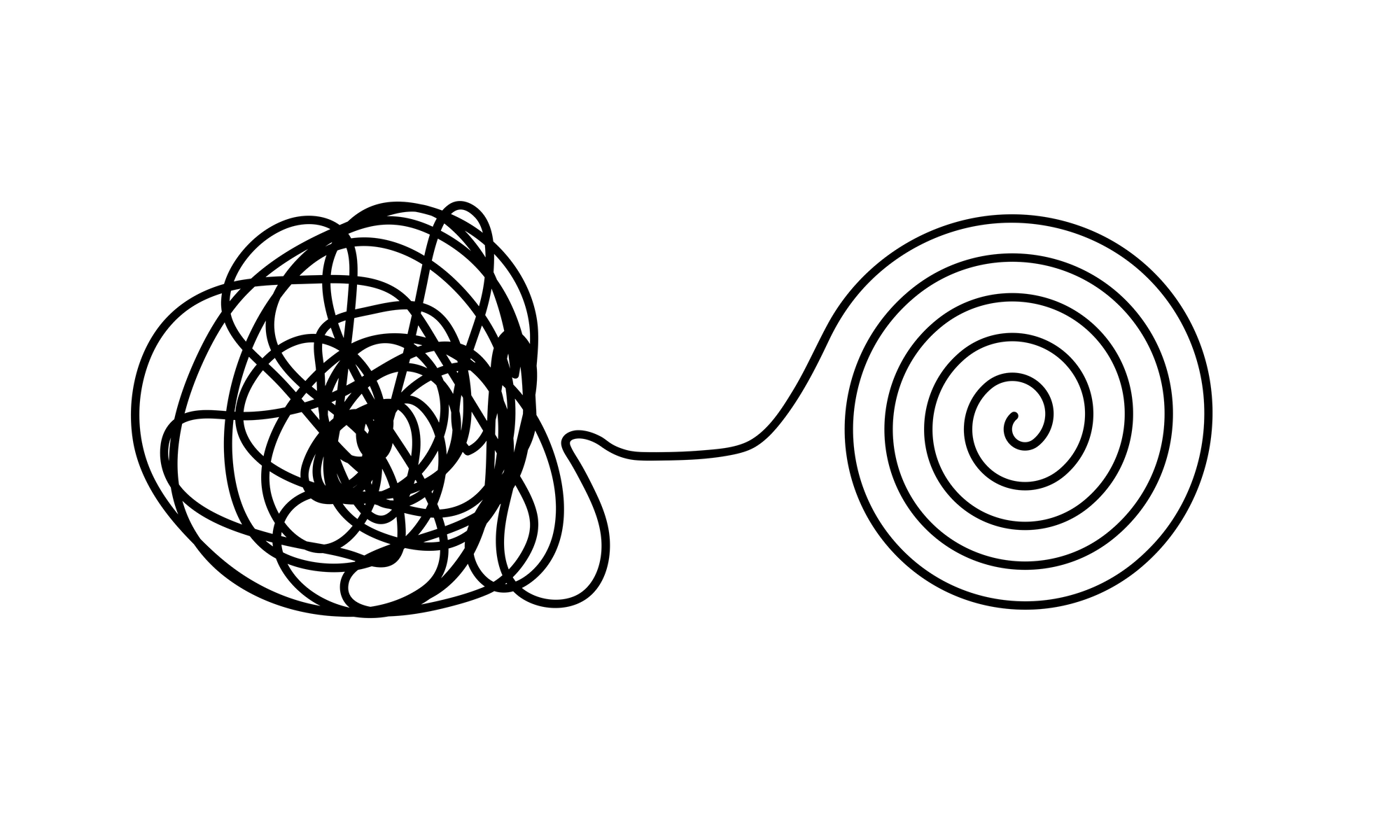

Entrenar un modelo que parece bueno en un conjunto de prueba y descubrir que falla en datos del mundo real es una experiencia común y frustrante. El artículo aborda las trampas del aprendizaje automático que no siempre son evidentes a primera vista. En las dos décadas que llevo trabajando en ML, he visto muchos casos en que los modelos parecían funcionar bien durante el desarrollo pero ofrecían utilidad muy limitada en la práctica. Este texto examina los tipos de errores que inflan el rendimiento aparente y sugiere formas de evitarlos, incluyendo la lista de verificación REFORMS para la ciencia basada en ML. Los datos engañosos son un punto de partida natural para los problemas. El núcleo del ML es el dato y cuando la calidad es deficiente, los modelos pueden parecer exitosos sin aprender patrones útiles. Los esfuerzos de predicción para Covid-19, por ejemplo, involucraron conjuntos de datos públicos que más tarde mostraron señales que no reflejaban el fenómeno subyacente. En algunos casos había duplicación de registros, etiquetas incorrectas o variables ocultas que ayudaron al modelo a predecir las etiquetas sin aprender patrones relevantes. Las variables ocultas son características presentes en los datos que, por coincidencia, son predictivas para la etiqueta, pero no están causalmente relacionadas con el fenómeno. En las imágenes torácicas de Covid, por ejemplo, la orientación del escaneo puede correlacionarse con el estado de la enfermedad más que con la enfermedad en sí, lo que lleva a que el modelo aprenda la postura en lugar de la enfermedad. Un problema relacionado son las correlaciones espurias. Son patrones que se correlacionan con las etiquetas sin tener una relación causal real. Un ejemplo clásico es un conjunto de imágenes de tanques donde el modelo reconoce pistas de fondo o la hora del día en lugar de la forma del objeto. En la práctica, muchos conjuntos contienen estas señales espurias, lo que puede deteriorar la generalización. Los modelos profundos tienden a capturar patrones en los píxeles de fondo u otros rasgos incidentales, aumentando la posibilidad de que sean vulnerables a cambios de distribución o a ataques adversarios. Si un modelo depende de cues de fondo, cambios pequeños pueden inverter la predicción. Aunque la entrenamiento adversario puede ayudar, es costoso; una alternativa más simple es revisar qué información utiliza el modelo para tomar decisiones, por ejemplo mediante mapas de saliencia u otras explicaciones, para confirmar que está usando señales significativas. La calidad de las etiquetas también importa. Cuando las etiquetas las realizan humanos, pueden introducir sesgos o errores, especialmente en tareas con alto grado de subjetividad. Incluso benchmarks ampliamente usados pueden contener tasas notables de etiquetado incorrecto. En resumen, un pequeño margen de mejora puede deberse a ruido de etiqado o sesgo de anotación más que a una mejora real en la capacidad del modelo. Más allá de la calidad de los datos, la canalización de ML puede filtrarlo información que no debería estar disponible durante el entrenamiento. El leakage de datos ocurre cuando el modelo tiene acceso a información que no debería usar durante el entrenamiento, especialmente información de los datos de prueba. Un caso común es realizar transformaciones dependientes de los datos sobre el conjunto completo antes de dividirlo en entrenamiento y prueba (por ejemplo, normalización, selección de características o aumento de datos). Esto permite que el modelo aprenda de las características del conjunto de prueba y distorsiona las estimaciones de rendimiento. En series temporales, el sesgo de mirar hacia adelante es un ejemplo más complejo de filtración; si se incluye información futura durante el entrenamiento, las métricas de prueba pueden inflarse. Para responder a estos problemas, el artículo propone prácticas como la checklist REFORMS para hacer la ciencia basada en ML más transparente y robusta. El objetivo es que los datos, las decisiones de modelado y la evaluación sean más claros y reproducibles, reduciendo la probabilidad de que un modelo “funcione” solo bajo condiciones concretas.

Características clave

- Detectar y mitigar datos engañosos desde el inicio: evitar el “garbage in, garbage out”.

- Identificar variables ocultas y verificar que no impulsen las predicciones.

- Tener cuidado con las correlaciones espurias que pueden inflar el rendimiento aparente.

- Examinar las explicaciones del modelo para asegurar que el modelo se apoye en señales significativas, no en cues de fondo.

- Prevenir el leakage de datos manteniendo los datos de prueba aislados durante el preprocesamiento y la selección de características.

- Vigilancia de sesgos de tiempo en series temporales y otros dominios donde la información futura podría filtrarse en el entrenamiento.

- Considerar sesgos de etiquetado y errores de anotación; reconocer que la subjetividad puede llevar a sobreajuste a los anotadores.

- Usar la checklist REFORMS para documentar la procedencia de los datos, las elecciones de modelado y los procedimientos de evaluación.

- Reconocer que defensas como el entrenamiento adversario pueden ser costosas y no siempre son la solución.

Casos de uso comunes

- Estudios ML científicos donde los resultados reportados podrían sobreestimar la utilidad en el mundo real debido a leakage de datos o a variables ocultas.

- Esfuerzos de predicción de Covid-19 donde datos latentes o etiquetados incorrectos inflaron el rendimiento, pero solo en conjuntos de prueba.

- Benchmarks de visión por computadora o series temporales donde patrones de fondo o indicios temporales se asocian de forma involuntaria con etiquetas, afectando la generalización.

- Despliegues en dominios sensibles donde la robustez y la resistencia a cambios de distribución son críticos.

- Investigaciones sobre reproducibilidad que analizan por qué los modelos parecen funcionar en algunos contextos pero fallan con datos nuevos.

Setup & instalación

# Setup & instalación no se proporcionan en el artículo fuente.

echo "Ningún comando de setup disponible en la fuente."Nota: el artículo hace referencia a la checklist REFORMS y a la necesidad de una evaluación y documentación cuidadosas, pero no ofrece pasos de instalación o configuración de software específicos.

Quick start

- Lee el artículo para entender las trampas comunes en ML: problemas de calidad de datos (etiquetados, variables ocultas, correlaciones espurias), leakage y sesgo temporal.

- Al diseñar un modelo, verifica qué información utiliza para decidir. Si un mapa de saliencia subraya rasgos de fondo, espera una generalización débil.

- Revisa filtraciones de datos. Asegúrate de que cualquier preprocesamiento, normalización o selección de características se haga después de la división entrenamiento/prueba. Ten cuidado con las series temporales donde la información futura podría filtrarse al entrenamiento.

- Evalúa la calidad de las etiquetas. Verifica sesgos de anotación y tasas de etiquetado incorrecto para evitar comparaciones engañosas.

- Considera enfoques de robustez más simples antes de recurrir a defensas costosas. Si la fortaleza aparente del modelo depende de señales espurias, invierte en curación de datos y evaluación adecuada en lugar de entrenamientos adversarios pesados.

- Usa la checklist REFORMS para documentar procedencias de datos, elecciones de modelado y procedimientos de evaluación para aumentar la transparencia y la reproducibilidad.

Pros y contras

- Pros:

- Ilustra modos prácticos de fallo que a menudo se pasan por alto en la investigación académica.

- Enfatiza la calidad de datos, el control de leakage y la explicabilidad como pilares del ML robusto.

- Recomienda un marco de evaluación estructurado (REFORMS) para mejorar la confianza en los resultados.

- Contras:

- Algunas estrategias de mitigación (p. ej., entrenamiento adversario) pueden ser costosas y no siempre factibles para todos los proyectos.

- La guía es de alto nivel y puede requerir adaptación específica al dominio.

- El texto se centra en trampas y evaluación; no propone un flujo de trabajo único y universal.

Alternativas (comparaciones breves)

| Enfoque | Objetivo | Pros | Contras |---|---|---|---| | Entrenamiento adversario | Robustez ante ataques | Mejora la resiliencia | Costoso computacionalmente; no resuelve leakage ni problemas de datos de mala calidad |Explicabilidad post-entrenamiento | Entender decisiones | Ayuda a detectar uso de señales no relevantes | Las explicaciones pueden ser ruidosas; no siempre reflejan causalidad |Limpieza de datos (data-centric) | Mejora de la calidad de datos y etiquetas | Ganancias reales con menos complejidad de modelo | Requiere ingeniería de datos y puede ser demorado |Protocolos de evaluación rigurosos | Experimentos transparentes y reproducibles | Aumenta la confianza y la comparabilidad | Requiere disciplina y documentación; puede ralentizar la iteración |

Precio o Licencia

No especificado en el artículo fuente.

Referencias

- Why Doesn’t My Model Work? — The Gradient https://thegradient.pub/why-doesnt-my-model-work/

More resources

IA General No Es Multimodal: Inteligencia centrada en el Encarnamiento

Recurso conciso que explica por qué las arquitecturas multimodales basadas en escalado probablemente no conducen a una AGI y por qué los modelos del mundo embebidos son esenciales.

Forma, Simetrías y Estructura: El papel cambiante de las matemáticas en la investigación de ML

Analiza cómo las matemáticas siguen siendo centrales en ML, pero su rol se expande hacia geometría, simetrías y explicaciones post-hoc a gran escala.

Qué falta en los chatbots de LLM: un sentido de propósito

Explora el diálogo con propósito en chatbots LLM, argumentando que las interacciones de varias vueltas alinean mejor la IA con los objetivos del usuario y facilitan la colaboración, especialmente en código y asistentes personales.

Visiones positivas de la IA basadas en el bienestar

Un marco centrado en el bienestar para IA beneficiosa, que une ciencias del bienestar, economía y gobernanza para delinear visiones prácticas y accionables de despliegue que apoyen el florecimiento individual y social.

Aplicaciones de LLMs en mercados financieros — visión general y casos de uso

Visión general de cómo los LLMs pueden aplicarse a los mercados financieros, incluyendo modelado autoregresivo de datos de precios, entradas multimodales, residualización, datos sintéticos y predicciones de múltiples horizontes.

Visión general sobre sesgos de género en IA

Resumen de trabajos clave que miden sesgos de género en IA, abarcando embeddings, co-referencia, reconocimiento facial, benchmarks de QA y generación de imágenes; discusión de mitigación, lagunas y auditoría robusta.