Use AWS Deep Learning Containers com o SageMaker AI gerenciado MLflow

Sources: https://aws.amazon.com/blogs/machine-learning/use-aws-deep-learning-containers-with-amazon-sagemaker-ai-managed-mlflow, https://aws.amazon.com/blogs/machine-learning/use-aws-deep-learning-containers-with-amazon-sagemaker-ai-managed-mlflow/, AWS ML Blog

TL;DR

- Integra DLCs do AWS Deep Learning Containers com o SageMaker AI gerenciado pelo MLflow para equilibrar controle de infraestrutura com governança robusta de ML.

- Usa um fluxo de trabalho de predição de idade de ostras com TensorFlow, onde o treinamento ocorre em DLCs, os artefatos são armazenados no Amazon S3 e os resultados são logados no MLflow para rastreamento centralizado.

- O MLflow gerenciado pelo SageMaker oferece log automático em uma linha, capacidades de comparação aprimoradas e rastreamento completo de linhagem para auditoria.

- A abordagem oferece equilíbrio entre personalização e padronização, permitindo que organizações padronizem fluxos de ML mantendo a flexibilidade de ambientes com DLCs ou DLAMIs.

- Pré-requisitos incluem puxar um contêiner de treinamento TensorFlow otimizado do AWS public ECR e seguir o README do repositório GitHub correspondente para provisionar e executar.

Contexto e histórico

Organizações que constroem modelos de ML personalizados frequentemente possuem requisitos especializados que plataformas padrão não atendem. Por exemplo, empresas de saúde precisam de ambientes específicos para proteger dados de pacientes, mantendo conformidade com HIPAA; instituições financeiras requerem configurações de hardware para otimizar algoritmos proprietários de negociação; equipes de pesquisa precisam de flexibilidade para experimentar técnicas de ponta com frameworks personalizados. Esses requisitos levam equipes a construir ambientes de treinamento customizados que oferecem controle sobre hardware, versões de software e configurações de segurança. Embora essa flexibilidade seja valiosa, ela cria grandes desafios para o ciclo de vida do ML, aumentando custos operacionais e demandando recursos de engenharia. AWS Deep Learning Containers (DLCs) e o MLflow gerenciado no SageMaker oferecem uma solução poderosa para atender a essas necessidades: DLCs fornecem contêineres Docker pré-configurados com frameworks populares, drivers NVIDIA CUDA para suporte a GPUs e são otimizados para desempenho na AWS. Eles são atualizados regularmente com as versões mais recentes de frameworks e patches e projetados para integração com serviços da AWS para treinamento e inferência. DLCs em conjunto com DLAMIs fornecem a infraestrutura necessária para acelerar o deep learning na nuvem em escala. O SageMaker AI gerenciado pelo MLflow oferece gerenciamento de ciclo de vida com log automático de uma linha, comparação de experimentos e rastreamento de linhagem completo, eliminando a sobrecarga operacional de manter infraestrutura de tracking. A integração apresentada neste post demonstra como combinar DLCs com MLflow para obter um fluxo de governança sem sacrificar a flexibilidade de ambientes de desenvolvimento. No fluxo de trabalho descrito, você desenvolve um modelo de rede neural TensorFlow para predição de idade de ostras com rastreamento integrado do SageMaker MLflow. Você puxa um contêiner de treinamento TensorFlow otimizado do repositório público ECR da AWS, configura uma instância EC2 com acesso ao servidor de rastreamento MLflow e executa o treinamento dentro do DLC. Os artefatos do modelo são armazenados no Amazon S3 e os resultados são logados no MLflow. Por fim, você pode visualizar e comparar os resultados dos experimentos na interface MLflow para avaliar o desempenho do modelo. O diagrama acompanhante mostra a interação entre os serviços da AWS, DLCs da AWS e o MLflow gerenciado pelo SageMaker no contexto da solução. O fluxo aborda provisionamento de infraestrutura, configuração de permissões, execução do primeiro job de treinamento e rastreamento de experimentos ao longo de todo o ciclo de ML.

O que há de novo

Este post apresenta um padrão de integração prático que equilibra controle de infraestrutura com governança ao combinar DLCs (ou DLAMIs) com o MLflow gerenciado pelo SageMaker AI. O fluxo permite rastreamento de ponta a ponta, proveniência de modelos e governança diretamente desde as execuções de treinamento até o registro de modelos, proporcionando histórico auditável de experimentos, métricas, hiperparâmetros e artefatos. A solução demonstra como:

- Executar treinamentos em DLCs mantendo artefatos com segurança no S3.

- Registrar métricas de experimentos, parâmetros e resultados em um servidor de rastreamento MLflow gerenciado pelo SageMaker AI.

- Registrar automaticamente modelos no SageMaker Model Registry por meio da integração MLflow, criando uma trilha de auditoria direta de treinamento para produção.

- Utilizar a interface MLflow para comparar execuções, inspecionar proveniência e obter visibilidade sobre dinâmica de treinamento e convergência.

- Estabelecer um fluxo de ML escalável e governado que acomoda requisitos especializados, mantendo padronização onde for possível. O post também destaca pré-requisitos e fornece referências a instruções passo a passo no repositório GitHub correspondente, assegurando que as equipes possam provisionar a infraestrutura e executar o primeiro treinamento com rastreamento de experimento completo.

Por que isso importa (impacto para desenvolvedores/empresas)

Para organizações com requisitos de governança rígidos ou necessidades específicas de computação e segurança, a habilidade de controlar o ambiente de treinamento sem sacrificar governança é essencial. Ao combinar DLCs (ou DLAMIs) com o SageMaker AI gerenciado pelo MLflow, as equipes podem:

- Manter flexibilidade para adaptar ambientes a conformidade HIPAA, configurações de hardware especializadas ou experimentação de ponta, ao mesmo tempo em que se beneficiam de governança centralizada.

- Alcançar rastreamento completo de experiências, proveniência de modelos e um histórico auditável do treinamento até a implantação.

- Acelerar o ciclo de vida do ML reduzindo a sobrecarga operacional associada ao tracking.

- Padronizar fluxos de ML entre equipes e projetos, promovendo reprodutibilidade e colaboração mais fáceis, mantendo salvaguardas exigidas por setores regulados. Essa abordagem está alinhada com objetivos mais amplos de equilibrar personalização e governança em iniciativas corporativas de IA, permitindo que cientistas de dados e equipes de operações trabalhem com mais eficiência sem comprometer segurança, rastreabilidade ou conformidade.

Detalhes técnicos ou Implementação

Elementos-chave da solução descrita incluem:

- AWS Deep Learning Containers (DLCs): contêineres Docker pré-configurados com frameworks como TensorFlow e PyTorch, incluindo drivers NVIDIA CUDA para suporte a GPU; DLCs são otimizados para AWS e recebem atualizações regulares. Eles são projetados para integração com serviços AWS para treinamento e inferência.

- AWS Deep Learning AMIs (DLAMIs): AMIs pré-configuradas para EC2 com frameworks populares; disponíveis para instâncias CPU e GPU; incluem CUDA, cuDNN e outras ferramentas necessárias, com atualizações gerenciadas pela AWS.

- SageMaker managed MLflow: oferece log automático em uma linha, comparação aprimorada e rastreamento de linhagem completo, tudo dentro de um ambiente SageMaker AI gerenciado.

- Passos de implementação (alto nível):

- Puxe um contêiner de treinamento TensorFlow otimizado do repositório público ECR da AWS.

- Configure uma instância EC2 com acesso ao servidor de rastreamento MLflow.

- Execute o treinamento dentro do DLC enquanto armazena artefatos do modelo no Amazon S3 e registra os resultados no MLflow.

- Visualize e compare resultados de experimento na interface MLflow para avaliar o desempenho do modelo.

- Ao registrar um modelo com mlflow.tensorflow.log_model() usando o parâmetro registered_model_name, o modelo é automaticamente registrado no SageMaker Model Registry, estabelecendo uma trilha de auditoria entre o treinamento e a produção.

- Os artefatos do modelo são armazenados no S3 seguindo uma estrutura padronizada, garantindo que pesos, configurações e metadados sejam preservados e acessíveis.

- Exemplo prático: previsão de idade de ostras usando um modelo TensorFlow, com o experimento abalone-tensorflow-experiment e uma execução chamada unique-cod-104, demonstrando como os recursos de governança e versionamento aparecem na interface e no registro de modelos.

- Implementação de referência: todos os exemplos de código e detalhes de implementação estão disponíveis no README do repositório GitHub correspondente, cobrindo provisionamento, permissões e a execução do primeiro treinamento com rastreamento completo de experimentos. Como mostrado nas imagens que acompanham o post, o SageMaker managed MLflow oferece um hub central para rastrear métricas, parâmetros, artefatos e modelos registrados, fornecendo governança completa e trilha de auditoria para fluxos de ML. A integração garante que os resultados de treinamento possam ser rastreados até o modelo implantado em produção, oferecendo rastreabilidade e conformidade ao longo do ciclo de ML.

Principais conclusões

- DLCs (e DLAMIs) oferecem o equilíbrio certo entre personalização e infraestrutura gerenciada para fluxos de ML na AWS.

- O SageMaker AI gerenciado pelo MLflow adiciona recursos fortes de governança, incluindo log automático, linhagem e integração com o Registro de Modelos.

- O fluxo de predição de idade de ostras com TensorFlow demonstra governança de ponta a ponta: desde execuções de treinamento até armazenamento de artefatos, comparação de experimentos e implantação em produção.

- Rastreamento centralizado do MLflow no SageMaker AI simplifica auditoria, proveniência e colaboração entre equipes de ciência de dados e operações.

- A abordagem reduz a sobrecarga operacional ao mesmo tempo em que mantém flexibilidade para requisitos especializados.

FAQ

-

O que são AWS DLCs e DLAMIs?

DLCs são contêineres Docker pré-configurados com frameworks como TensorFlow e PyTorch, incluindo drivers CUDA; DLAMIs são Amazon Machine Images pré-configuradas para EC2. Incluem CUDA, cuDNN e outras ferramentas, com atualizações gerenciadas pela AWS.

-

Como o SageMaker managed MLflow ajuda na governança?

Ele oferece gerenciamento completo do ciclo de vida com log automático em uma linha, capacidades de comparação aprimoradas e rastreamento de linhagem completo em um ambiente SageMaker AI totalmente gerenciado.

-

ual é o exemplo da abalone utilizado no walkthrough?

Trata-se de um modelo de rede neural TensorFlow para predição da idade de ostras, utilizado para demonstrar o fluxo de treinamento, registro e governança com MLflow e SageMaker.

-

Onde ficam os artefatos e resultados neste fluxo?

rtefatos do modelo e dados são armazenados no Amazon S3, enquanto métricas e parâmetros de experimentos são registrados no MLflow para rastreamento centralizado e governança.

-

Como começar a implementar esse padrão?

Consulte o README do repositório GitHub correspondente para instruções detalhadas, passo a passo, sobre provisionar infraestrutura, configurar permissões e executar o primeiro treinamento com governança de experimentos.

Referências

More news

Levar agentes de IA do conceito à produção com Amazon Bedrock AgentCore

Análise detalhada de como o Amazon Bedrock AgentCore ajuda a transformar aplicações de IA baseadas em agentes de conceito em sistemas de produção de nível empresarial, mantendo memória, segurança, observabilidade e gerenciamento de ferramentas escalável.

Monitorar Bedrock batch inference da Amazon usando métricas do CloudWatch

Saiba como monitorar e otimizar trabalhos de bedrock batch inference com métricas do CloudWatch, alarmes e painéis para melhorar desempenho, custo e governança.

Prompting para precisão com Stability AI Image Services no Amazon Bedrock

O Bedrock now oferece Stability AI Image Services com nove ferramentas para criar e editar imagens com maior precisão. Veja técnicas de prompting para uso empresarial.

Aumente a produção visual com Stability AI Image Services no Amazon Bedrock

Stability AI Image Services já estão disponíveis no Amazon Bedrock, oferecendo capacidades de edição de mídia prontas para uso via Bedrock API, ampliando os modelos Stable Diffusion 3.5 e Stable Image Core/Ultra já existentes no Bedrock.

Construir Fluxos de Trabalho Agenticos com GPT OSS da OpenAI no SageMaker AI e no Bedrock AgentCore

Visão geral de ponta a ponta para implantar modelos GPT OSS da OpenAI no SageMaker AI e no Bedrock AgentCore, alimentando um analisador de ações com múltiplos agentes usando LangGraph, incluindo quantização MXFP4 de 4 bits e orquestração serverless.

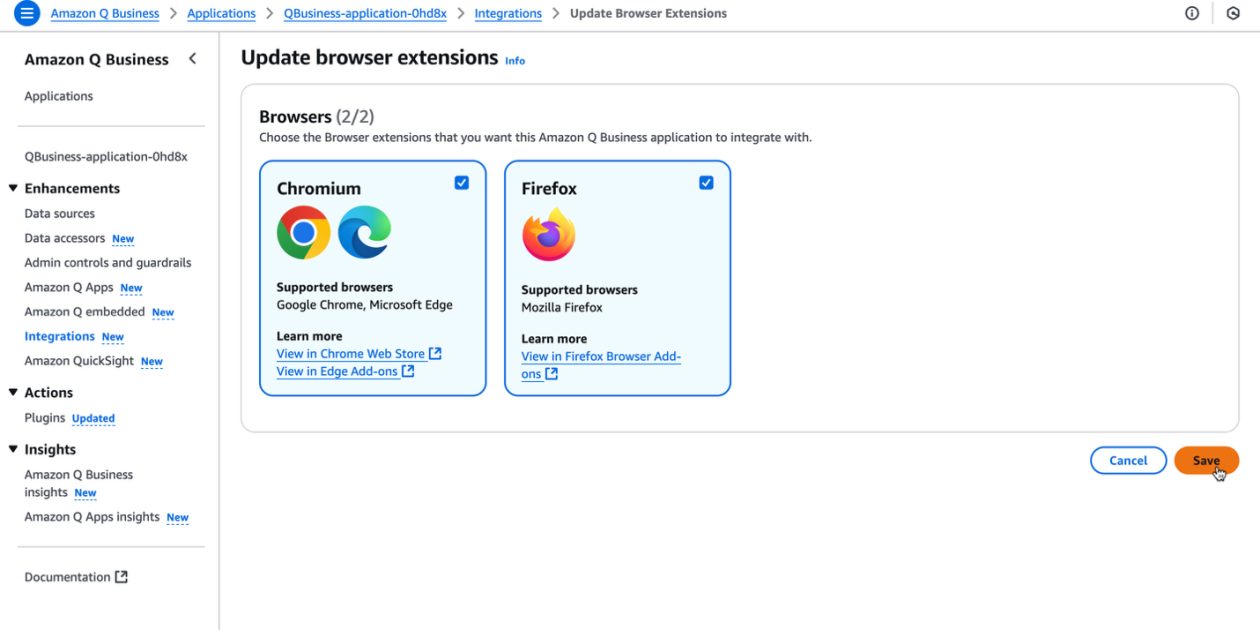

Potencialize a produtividade da sua organização com a extensão de navegador Amazon Q Business

A extensão de navegador Amazon Q Business oferece assistência com IA contextual diretamente no navegador para assinantes Lite e Pro, possibilitando insights baseados em fontes confiáveis e fluxos de trabalho sem atritos.