Monitorar Bedrock batch inference da Amazon usando métricas do CloudWatch

Sources: https://aws.amazon.com/blogs/machine-learning/monitor-amazon-bedrock-batch-inference-using-amazon-cloudwatch-metrics, https://aws.amazon.com/blogs/machine-learning/monitor-amazon-bedrock-batch-inference-using-amazon-cloudwatch-metrics/, AWS ML Blog

TL;DR

- O Bedrock batch inference permite o processamento em bulk de grandes conjuntos de dados com custo cerca de 50% menor que a inferência sob demanda, sendo adequado para análise histórica, resumos em grande escala e processamento em segundo plano.

- O Bedrock agora publica automaticamente métricas de batch inference no CloudWatch, sob o namespace AWS/Bedrock/Batch.

- As métricas podem ser visualizadas por modelId e incluem registros pendentes de processamento, tokens de entrada processados por minuto e tokens de saída processados por minuto; para modelos Anthropic Claude, também há tokens pendentes.

- Você pode iniciar um job de batch inference via Console, AWS SDKs ou AWS CLI e, em seguida, monitorar a carga de trabalho com CloudWatch Metrics Insights, alarmes e painéis.

- Monitoramento pró-ativo e automação—como alarmes que disparem notificações SNS—podem ajudar a otimizar desempenho e custo em cargas Bedrock batch. Para mais detalhes, leia o post original da AWS no blog sobre monitorar Bedrock batch inference com métricas do CloudWatch AWS Blog.

Contexto e antecedentes

À medida que as organizações ampliam suas iniciativas de IA generativa, muitos workloads priorizam processamento em bulk com baixo custo em vez de respostas em tempo real. O Bedrock batch inference atende a essa necessidade ao permitir que grandes conjuntos de dados sejam processados em lote com desempenho previsível e a um custo menor do que a inferência sob demanda. O blog da AWS ressalta que agora o Bedrock batch inference publica métricas no CloudWatch sob o namespace AWS/Bedrock/Batch, oferecendo visibilidade sobre o progresso das cargas de batch e o uso de recursos. Você pode iniciar um job de batch inference usando o Console, os SDKs ou a CLI da AWS, e monitorar o progresso e o desempenho por meio de métricas do CloudWatch. Ao usar o CloudWatch, existe um conjunto dedicado de métricas para monitorar workloads de batch. Atualmente, os modelos do Amazon Bedrock apresentam métricas como registros pendentes, tokens de entrada processados por minuto e tokens de saída processados por minuto. Para modelos Anthropic Claude, também há tokens pendentes. As métricas podem ser visualizadas por modelId, permitindo acompanhar desempenho e custo em nível de modelo. Essa nova visibilidade facilita uma compreensão mais profunda de cargas de batch e facilita a otimização e governança de Bedrock batch inference. Se você quiser explorar como visualizar e analisar essas métricas, o CloudWatch oferece Metrics Insights para consultar e visualizar dados no namespace AWS/Bedrock/Batch. O post também discute boas práticas de monitoramento, incluindo alertas pró-ativos e automação para responder a mudanças de carga e considerações de custo. O objetivo geral é maximizar a eficiência e o valor do Bedrock batch inference ao combinar métricas, alarmes e painéis.

O que há de novo

- Publicação automática de métricas de batch inference no CloudWatch sob o namespace AWS/Bedrock/Batch.

- Métricas por modelId, incluindo: registros pendentes; tokens de entrada processados por minuto; tokens de saída processados por minuto; e tokens pendentes de processamento para modelos Anthropic Claude.

- Suporte expandido de modelos e visibilidade mais profunda do progresso do batch, permitindo monitoramento e solução de problemas com mais granularidade.

- Melhoria no monitoramento de custo para acompanhar melhor o uso de cargas de batch.

- Fluxos de trabalho simplificados para iniciar um job de batch inference via Console, SDKs ou CLI, e configurar alarmes e painéis para operações contínuas. Ao disponibilizar telemetria e controle adicionais, o Bedrock batch inference se torna mais transparente e fácil de operar em escala. O blog observa que essas melhorias oferecem melhor desempenho, gestão de custos e insight operacional para equipes que gerenciam workloads generativos em grande escala. Você pode começar iniciando um job de batch inference, configurando alarmes do CloudWatch e construindo um painel de monitoramento para observar padrões de progresso e custo.

Por que isso importa (impacto para desenvolvedores/empresas)

Para desenvolvedores e empresas, o conjunto atualizado de monitoramento do Bedrock batch inference oferece vários benefícios práticos:

- Visibilidade proativa: métricas do CloudWatch fornecem visibilidade em tempo real e histórica sobre cargas de batch, facilitando a detecção de lentidão, gargalos ou picos de custo antes que impactem as partes interessadas.

- Respostas automatizadas: alarmes e notificações SNS permitem respostas automatizadas ou semi-automatizadas, como alertar a equipe de operações ou acionar pipelines de dados a jusante.

- Transparência de custos: com métricas que refletem tokens processados e tokens pendentes, as equipes podem entender melhor os drivers de custo e otimizar o processamento em lote para atender metas orçamentárias.

- Monitoramento centralizado: painéis consolidam os dados de workload de batch, permitindo solução de problemas mais rápida e planejamento de capacidade com maior eficiência.

- Governança escalável: métricas por modelo ajudam a isolar sinais de desempenho e custo, essencial quando se opera múltiplos modelos Bedrock em produção. Essas capacidades estão alinhadas com objetivos corporativos comuns: garantir desempenho previsível para tarefas de IA em lote, controlar gastos e manter a prontidão operacional para workloads generativos em grande escala. Tudo isso nasce da combinação de métricas do CloudWatch, alarmes e painéis, agora enriquecidos com telemetria de Bedrock batch inference.

Detalhes técnicos ou Implementação

Iniciar e configurar batch inference

- Você pode iniciar um job de batch inference no Bedrock usando o AWS Management Console, os AWS SDKs ou a AWS CLI. O post enfatiza que o processo é suportado por essas interfaces, embora os detalhes de cada método estejam documentados em guias de Bedrock.

- Assim que o batch job estiver em andamento, o Bedrock começará a publicar métricas para esse job no CloudWatch, no namespace AWS/Bedrock/Batch, oferecendo visibilidade sobre o progresso da carga de trabalho e o uso de recursos.

Métricas do CloudWatch e onde vê-las

- As métricas centrais que você monitorará incluem:

- Records pending processing (registros pendentes de processamento)

- Input tokens processed per minute (tokens de entrada processados por minuto)

- Output tokens processed per minute (tokens de saída processados por minuto)

- Para modelos Anthropic Claude, há também a métrica tokens pending processing. Essas métricas podem ser visualizadas por modelId, permitindo monitorar desempenho e custo por modelo.

- Para visualizar e analisar essas métricas, você pode usar o console do CloudWatch e ferramentas como Metrics Insights para consultar e visualizar dados do namespace AWS/Bedrock/Batch.

Exemplos práticos: alertas e automação

- Um exemplo concreto do blog descreve a criação de um alarme do CloudWatch que dispara quando a média de NumberOfInputTokensProcessedPerMinute excede 1.000.000 por um período de 6 horas. Tal alarme pode acionar uma notificação SNS para alertar a equipe de operações ou iniciar pipelines a jusante.

- Você também pode construir um painel do CloudWatch para centralizar as métricas relevantes, facilitando monitoramento e solução de problemas.

Observações de implementação e boas práticas

- Use métricas com escopo por modelId para diagnosticar problemas de desempenho ou custo em nível de modelo, especialmente importante quando gerencia múltiplos modelos Bedrock em produção.

- Aproveite o CloudWatch Metrics Insights para análises ad hoc e para criar painéis e consultas mais direcionados.

- Combine métricas com alarmes e painéis como parte de uma estratégia de monitoramento pró-ativo e automação para maximizar a eficiência e o valor das cargas Bedrock batch.

Pontos-chave

- Bedrock batch inference oferece processamento em bulk com desempenho previsível a um custo menor que a inferência sob demanda.

- Métricas no CloudWatch sob AWS/Bedrock/Batch com granularidade por modelId.

- Alarmes e painéis suportam gestão proativa de desempenho e controle de custos.

- Fluxo de ponta a ponta: lançar batch inference, configurar alarmes do CloudWatch, construir painéis e monitorar continuamente.

Perguntas frequentes (FAQ)

- P: Qual é o benefício do Bedrock batch inference? R: Processa grandes conjuntos de dados em lote com desempenho previsível a um custo cerca de 50% menor que a inferência sob demanda, adequado para análises em lote e tarefas de processamento em segundo plano.

- P: Quais métricas estão disponíveis para monitorar batch inference? R: Métricas no namespace AWS/Bedrock/Batch incluem records pending processing, input tokens processed per minute, e output tokens processed per minute. Para modelos Anthropic Claude, tokens pending processing também são relatados. As métricas podem ser vistas por modelId.

- P: Como configurar alertas e respostas automatizadas? R: Você pode criar alarmes do CloudWatch que acionam ações, como notificações SNS para a equipe de operações ou pipelines a jusante, quando determinadas condições de throughput ou estados são atingidas.

- P: Como iniciar um job de batch inference? R: Use o Console da AWS, os SDKs ou a AWS CLI para iniciar o job e, em seguida, monitore o progresso por meio das métricas do CloudWatch.

- P: Onde ver as métricas de batch? R: No console do CloudWatch, sob o namespace AWS/Bedrock/Batch, com granularidade por modelId.

Referências

- AWS Blog: Monitorar Bedrock batch inference usando métricas do CloudWatch. https://aws.amazon.com/blogs/machine-learning/monitor-amazon-bedrock-batch-inference-using-amazon-cloudwatch-metrics/

More news

Levar agentes de IA do conceito à produção com Amazon Bedrock AgentCore

Análise detalhada de como o Amazon Bedrock AgentCore ajuda a transformar aplicações de IA baseadas em agentes de conceito em sistemas de produção de nível empresarial, mantendo memória, segurança, observabilidade e gerenciamento de ferramentas escalável.

Prompting para precisão com Stability AI Image Services no Amazon Bedrock

O Bedrock now oferece Stability AI Image Services com nove ferramentas para criar e editar imagens com maior precisão. Veja técnicas de prompting para uso empresarial.

Aumente a produção visual com Stability AI Image Services no Amazon Bedrock

Stability AI Image Services já estão disponíveis no Amazon Bedrock, oferecendo capacidades de edição de mídia prontas para uso via Bedrock API, ampliando os modelos Stable Diffusion 3.5 e Stable Image Core/Ultra já existentes no Bedrock.

Use AWS Deep Learning Containers com o SageMaker AI gerenciado MLflow

Explore como os AWS Deep Learning Containers (DLCs) se integram ao SageMaker AI gerenciado pelo MLflow para equilibrar controle de infraestrutura e governança robusta de ML. Um fluxo de trabalho de predição de idade de ostra com TensorFlow demonstra rastreamento de ponta a ponta, governança de model

Construir Fluxos de Trabalho Agenticos com GPT OSS da OpenAI no SageMaker AI e no Bedrock AgentCore

Visão geral de ponta a ponta para implantar modelos GPT OSS da OpenAI no SageMaker AI e no Bedrock AgentCore, alimentando um analisador de ações com múltiplos agentes usando LangGraph, incluindo quantização MXFP4 de 4 bits e orquestração serverless.

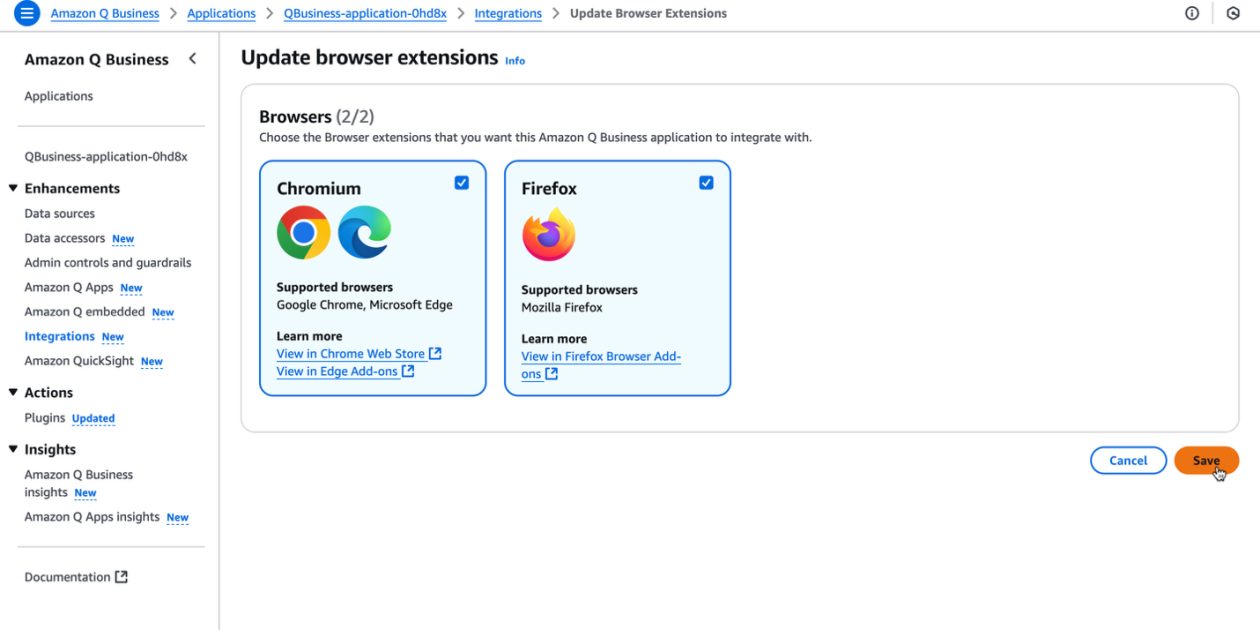

Potencialize a produtividade da sua organização com a extensão de navegador Amazon Q Business

A extensão de navegador Amazon Q Business oferece assistência com IA contextual diretamente no navegador para assinantes Lite e Pro, possibilitando insights baseados em fontes confiáveis e fluxos de trabalho sem atritos.