Qwen3-Next Modelos MoE Híbridos de Código Aberto: Maior Precisão e Inferência Mais Rápida na Plataforma NVIDIA

Sources: https://developer.nvidia.com/blog/new-open-source-qwen3-next-models-preview-hybrid-moe-architecture-delivering-improved-accuracy-and-accelerated-parallel-processing-across-nvidia-platform, https://developer.nvidia.com/blog/new-open-source-qwen3-next-models-preview-hybrid-moe-architecture-delivering-improved-accuracy-and-accelerated-parallel-processing-across-nvidia-platform/, NVIDIA Dev Blog

TL;DR

- Alibaba lançou dois modelos abertos Qwen3-Next, 80B-A3B-Thinking e 80B-A3B-Instruct, apresentando uma arquitetura híbrida de Mixture of Experts (MoE) que visa melhorar a precisão e acelerar o processamento paralelo em plataformas NVIDIA.

- Cada modelo tem 80 bilhões de parâmetros, mas apenas cerca de 3 bilhões são ativados por token, devido ao design esparso do MoE, oferecendo o poder de um modelo gigante com a eficiência de um modelo menor.

- O módulo MoE roteia entre 512 experts, mais 1 expert compartilhado, com 10 experts ativados por token, permitindo inferência escalável e roteamento flexível.

- A arquitetura suporta comprimentos de contexto muito longos (> 260 mil tokens) e utiliza Reduções Gateadas de Delta (Gated Delta Networks) para processar textos extensos com eficiência, com memória e computação que crescem quase linearmente com o comprimento da sequência.

- Quando executado em hardware NVIDIA Hopper e Blackwell, o sistema se beneficia de NVLink de 5ª geração com 1,8 TB/s de largura de banda direta GPU-a-GPU, reduzindo a latência no roteamento de experts e aumentando o throughput de tokens.

- A NVIDIA colabora com SGLang e vLLM para viabilizar o deployment como microserviços NIM (NVIDIA Inference Modules); desenvolvedores podem testar em build.nvidia.com, acessar serviços NIM prontos para uso e explorar um guia em Jupyter para criar agentes de IA usando endpoints NIM do Qwen3-Next.

Contexto e antecedentes

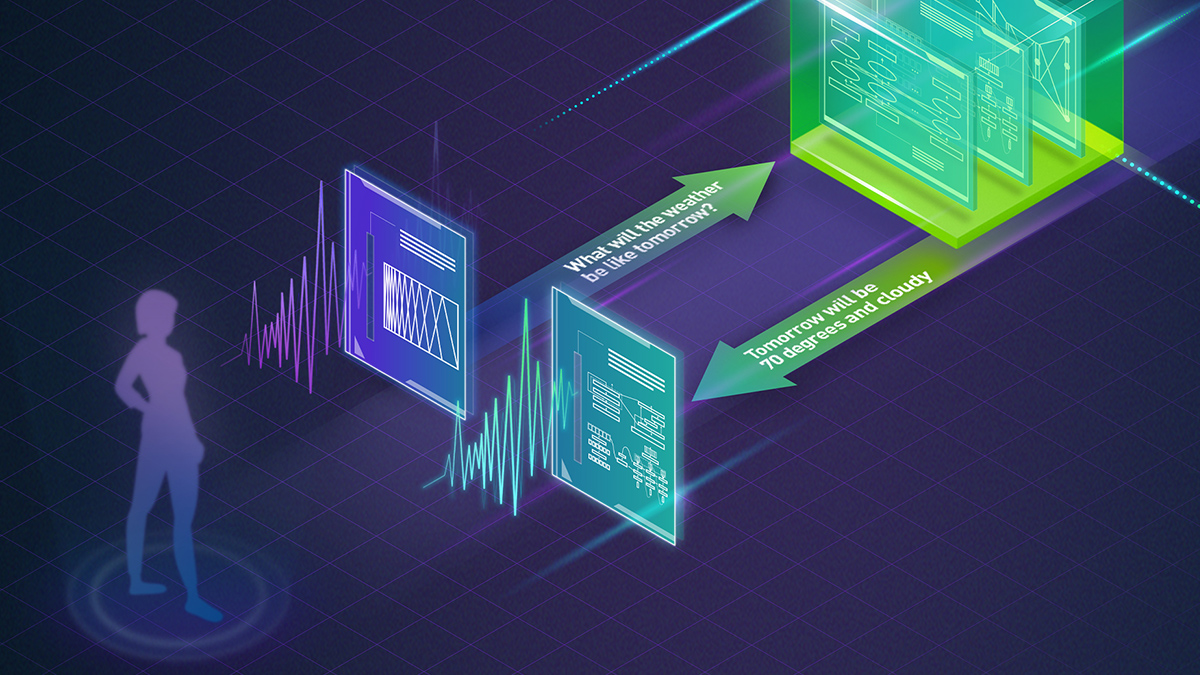

À medida que os modelos de IA crescem, a eficiência torna-se tão importante quanto a escala. Sequências de entrada muito longas são cada vez mais comuns, e há necessidade de arquiteturas que ofereçam alta precisão sem custos computacionais proibitivos. Nesse contexto, a Alibaba lançou dois modelos Qwen3-Next de código aberto—80B-A3B-Thinking e 80B-A3B-Instruct—para apresentar uma nova abordagem híbrida de Mixture of Experts (MoE) para pesquisa e desenvolvimento. A família Qwen3-Next foi projetada para oferecer as capacidades de modelos extremamente grandes mantendo o uso de recursos práticos por meio de sparsidade e comunicação entre GPUs otimizadas. Esta iniciativa faz parte do ecossistema de código aberto da NVIDIA, que inclui projetos como NeMo para gerenciamento de ciclo de vida de IA, Nemotron LLMs e Cosmos world foundation models (WFMs). O objetivo é acelerar a inovação tornando modelos de ponta mais acessíveis, transparentes e colaborativos para pesquisadores e desenvolvedores. A NVIDIA enfatiza caminhos abertos de deployment, em parceria com frameworks de código aberto como SGLang e vLLM, e empacotando os modelos como NVIDIA NIM (NVIDIA Inference Modules). Essa abordagem permite que pesquisadores e empresas testem e implantem os modelos Qwen3-Next por meio de endpoints hospedados ou containers localizados com ambientes seguros, além de experimentar fluxos práticos para construção de agentes em notebooks. O objetivo central do design híbrido MoE é ampliar eficiência e raciocínio. A combinação de uma rotaçao MoE esparsa com variantes de atenção otimizadas e novos primitivos de memória eficiente demonstra como modelos em grande escala podem ser acessados e avaliados pela comunidade sem comprometer o desempenho.

O que há de novo

Os previews do Qwen3-Next 80B-A3B-Thinking e 80B-A3B-Instruct trazem várias inovações arquitetônicas e de deployment:

- Escala e sparsidade: cada modelo tem 80 bilhões de parâmetros, mas apenas 3 bilhões são ativados por token graças à estrutura MoE esparsa. Isso permite capacidade massiva com custo computacional contido.

- MoE routing e capacidade: o módulo MoE inclui 512 experts roteados mais 1 expert compartilhado, com 10 experts ativados por token. Esse roteamento permite utilização dinâmica de submódulos conforme a entrada, melhorando eficiência para tarefas diversas.

- Contexto longo: a arquitetura é otimizada para comprimentos de contexto superiores a 260 mil tokens, apoiada por primitivos de memória e computação eficientes.

- Design de atenção: o modelo possui 48 camadas, com cada 4ª camada aplicando atenção GQA enquanto as camadas restantes utilizam uma variante de atenção linear. Essa abordagem de atenção híbrida equilibra expressividade e eficiência para sequências longas.

- Delta Networks Gateadas: contribuições da NVIDIA e MIT sobre Delta Networks ajudam a manter o foco em longas sequências, permitindo processamento de textos extensos com menor drift e maior estabilidade.

- Hardware e interconexões: os modelos são projetados para rodar em GPUs NVIDIA Hopper e Blackwell, aproveitando NVLink de 5ª geração com 1,8 TB/s de largura de banda para reduzir latência no roteamento entre experts e aumentar o throughput.

- Software e deployment: a abordagem híbrida MoE é compatível com CUDA e com ferramentas de plataforma da NVIDIA, permitindo coexistir tanto camadas de atenção completa quanto de atenção linear no stack Qwen3-Next. A NVIDIA também fez parceria com SGLang e vLLM para facilitar deployment e empacotamento como microserviços NIM, com opções de endpoints hospedados e implantações seguras em ambientes internos.

- Acesso aberto e tooling: desenvolvedores podem testar os modelos em build.nvidia.com, usar endpoints NIM para implantação prática e explorar guias de agente em notebooks para construir fluxos com NIM endpoints do Qwen3-Next.

Por que isso importa (impacto para desenvolvedores/empresas)

O design híbrido MoE do Qwen3-Next visa oferecer ganhos práticos em raciocínio e throughput. Ao ativar apenas uma fração do modelo por token, as arquiteturas buscam combinar o poder de representações profundas com a eficiência típica de modelos menores. Para desenvolvedores e empresas, a natureza de código aberto do Qwen3-Next, associada às ferramentas de deployment da NVIDIA, reduz barreiras para experimentação e integração em produção. Microserviços NIM fornecem endpoints prontos para uso, enquanto opções de deployment em self-hosted oferecem ambientes seguros para fluxos de IA no dia a dia. A colaboração com frameworks abertos como SGLang e vLLM facilita a integração de serving e experimentação. Do lado de hardware, o uso de GPUs Hopper e Blackwell com NVLink de alta largura de banda reduz a latência de roteamento entre centenas de experts e sustenta maior throughput de tokens para cargas de trabalho de inferência de IA. Na prática, isso pode significar respostas mais rápidas para tarefas de raciocínio com contexto longo, maior throughput de tokens e agentes de IA mais escaláveis em ambientes de produção. O ecossistema aberto da NVIDIA fortalece a colaboração entre pesquisadores, desenvolvedores e empresas, buscando ampliar o acesso a modelos de ponta, promovendo transparência e co-criação. Ao oferecer deployment de referência, notebooks e containers, a NVIDIA pretende acelerar a inovação e ampliar o acesso a arquiteturas avançadas de modelos.

Detalhes técnicos ou Implementação

Principais especificações em resumo

| Atributo | Valor

| --- |

|---|

| Tamanho do modelo |

| Parâmetros ativos por token |

| Roteamento MoE |

| Experts ativados por token |

| Número de camadas |

| Esquema de atenção |

| Comprimento de contexto |

| Largura de banda entre GPUs |

| Plataformas-alvo |

| Opções de implantação |

| Disponibilidade |

Notas de implementação

A abordagem híbrida MoE do Qwen3-Next distribui dinamicamente a computação entre centenas de experts. Com 10 experts ativos por token, o roteamento permite distribuir o processamento, viabilizando escalabilidade de throughput e melhora no raciocínio para entradas diversas. A combinação de GQA e variantes de atenção linear busca equilibrar a modelagem de dependências de longo alcance com limites computacionais práticos. Redes Delta Gateadas são citadas como facilitadoras do foco durante o processamento de contextos muito longos, reduzindo drift e mantendo informações relevantes ao longo de passagens extensas. Isso, por sua vez, ajuda a memória e o cálculo a crescer quase linearmente com o tamanho da sequência. Do ponto de vista de deployment, a integração com CUDA e as ferramentas de plataforma da NVIDIA, juntamente com a colaboração com SGLang e vLLM, cria caminhos práticos para pesquisa e produção. Empresas podem explorar Qwen3-Next via endpoints hospedados ou opções self-hosted com suporte de ferramentas de frameworks abertos.

Pontos-chave

- O Qwen3-Next apresenta uma abordagem MoE esparsa com 80B parâmetros, mas apenas 3B ativos por token, combinando grande capacidade com eficiência.

- Contexto longo (>260K tokens) aliado a memória e computação escaláveis graças a Delta Networks Gateadas e a uma mistura de atenções.

- Interconexões rápidas (NVLink 1,8 TB/s) e plataformas de GPU (Hopper/Blackwell) para reduzir latência de roteamento e aumentar throughput.

- Acesso aberto via NIM da NVIDIA, SGLang e vLLM para desenvolvimento e implantação; guias, containers e endpoints disponíveis.

- O trabalho exemplifica o compromisso da NVIDIA com código aberto, buscando ampliar acessibilidade, transparência e colaboração em IA.

FAQ

-

O que é o modelo 80B-A3B-Thinking do Qwen3-Next?

É um modelo de código aberto com 80 bilhões de parâmetros, projetado para funcionar com uma arquitetura híbrida MoE esparsa, permitindo ativação de cerca de 3B por token e processamento de contexto longo.

-

Como funciona a arquitetura MoE nesses modelos?

O módulo MoE possui 512 experts roteados mais 1 expert compartilhado, com 10 experts ativados por token. Esse roteamento distribui a computação entre submódulos para equilibrar capacidade e eficiência.

-

O que permite o processamento de contexto longo e eficiência?

Comprimento de contexto superior a 260K tokens, Delta Networks Gateadas para manter o foco em sequências longas e uma combinação de atenção GQA e linear em 48 camadas.

-

Como desenvolvedores podem acessar e implantar esses modelos?

Testes via build.nvidia.com, deployment com microserviços NIM e opções self-hosted com suporte de SGLang e vLLM.

-

ual é o significado mais amplo deste trabalho?

presenta um caminho para unir grande capacidade de modelo com eficiência prática, estimula o código aberto e fornece maneiras concretas de implantação em plataformas NVIDIA. ---

Referências

More news

NVIDIA HGX B200 reduz a Intensidade de Emissões de Carbono Incorporado

O HGX B200 da NVIDIA reduz 24% da intensidade de carbono incorporado em relação ao HGX H100, ao mesmo tempo em que aumenta o desempenho de IA e a eficiência energética. Esta análise resume os dados de PCF e as novidades de hardware.

Prever Eventos Climáticos Extremos em Minutos sem Supercomputador com Huge Ensembles (HENS)

NVIDIA e o Lawrence Berkeley National Laboratory apresentam Huge Ensembles (HENS), uma ferramenta de IA de código aberto que prevê eventos climáticos raros e de alto impacto usando 27.000 anos de dados, com opções de código aberto ou prontos para uso.

Playbook dos Grandmasters do Kaggle: 7 Técnicas de Modelagem Testadas para Dados Tabulares

Análise detalhada de sete técnicas testadas por Grandmasters do Kaggle para resolver grandes conjuntos de dados tabulares com aceleração por GPU, desde baselines diversificados até ensemble avançado e pseudo-rotulagem.

Como reduzir gargalos do KV Cache com NVIDIA Dynamo

O Dynamo da NVIDIA transfere o KV Cache da memória da GPU para armazenamento de custo mais baixo, permitindo janelas de contexto maiores, maior concorrência e menor custo de inferência em grandes modelos.

NVIDIA RAPIDS 25.08 Adiciona Novo Profiler para cuML, Melhorias no Motor GPU Polars e Suporte Ampliado de Algoritmos

RAPIDS 25.08 traz profiladores function-level e line-level para cuml.accel, executor streaming padrão no motor GPU Polars, suporte ampliado de tipos e strings, novo Spectral Embedding no cuML e acelerações com zero código para mais algoritmos.

Decodificação Especulativa para Reduzir a Latência na Inferência de IA: EAGLE-3, MTP e Abordagens Draft-Target

Exploração detalhada de decodificação especulativa para inferência de IA, incluindo métodos draft-target e EAGLE-3, como reduzem latência e como implantar em GPUs NVIDIA com TensorRT.