Acelere a Inferência de Estrutura de Proteínas em Mais de 100x com o NVIDIA RTX PRO 6000 Blackwell Server Edition

Sources: https://developer.nvidia.com/blog/accelerate-protein-structure-inference-over-100x-with-nvidia-rtx-pro-6000-blackwell-server-edition, https://developer.nvidia.com/blog/accelerate-protein-structure-inference-over-100x-with-nvidia-rtx-pro-6000-blackwell-server-edition/, NVIDIA Dev Blog

TL;DR

- O NVIDIA RTX PRO 6000 Blackwell Server Edition acelera a inferência end-to-end de estruturas de proteínas em um único servidor usando OpenFold, com precisão equivalente ao AlphaFold2.

- Benchmarks indicam até 138x mais rápido que o AlphaFold2 e cerca de 2,8x mais rápido que o ColabFold; acelerações de alinhamento e de inferência excedem centenas de vezes em relação a baselines de CPU.

- A plataforma oferece 96 GB de memória de alto desempenho (1,6 TB/s), capacidade MIG que faz um único cartão agir como quatro GPUs e fluxos de trabalho totalmente resididos na GPU para MSAs grandes e ensembles de proteínas.

Contexto e antecedentes

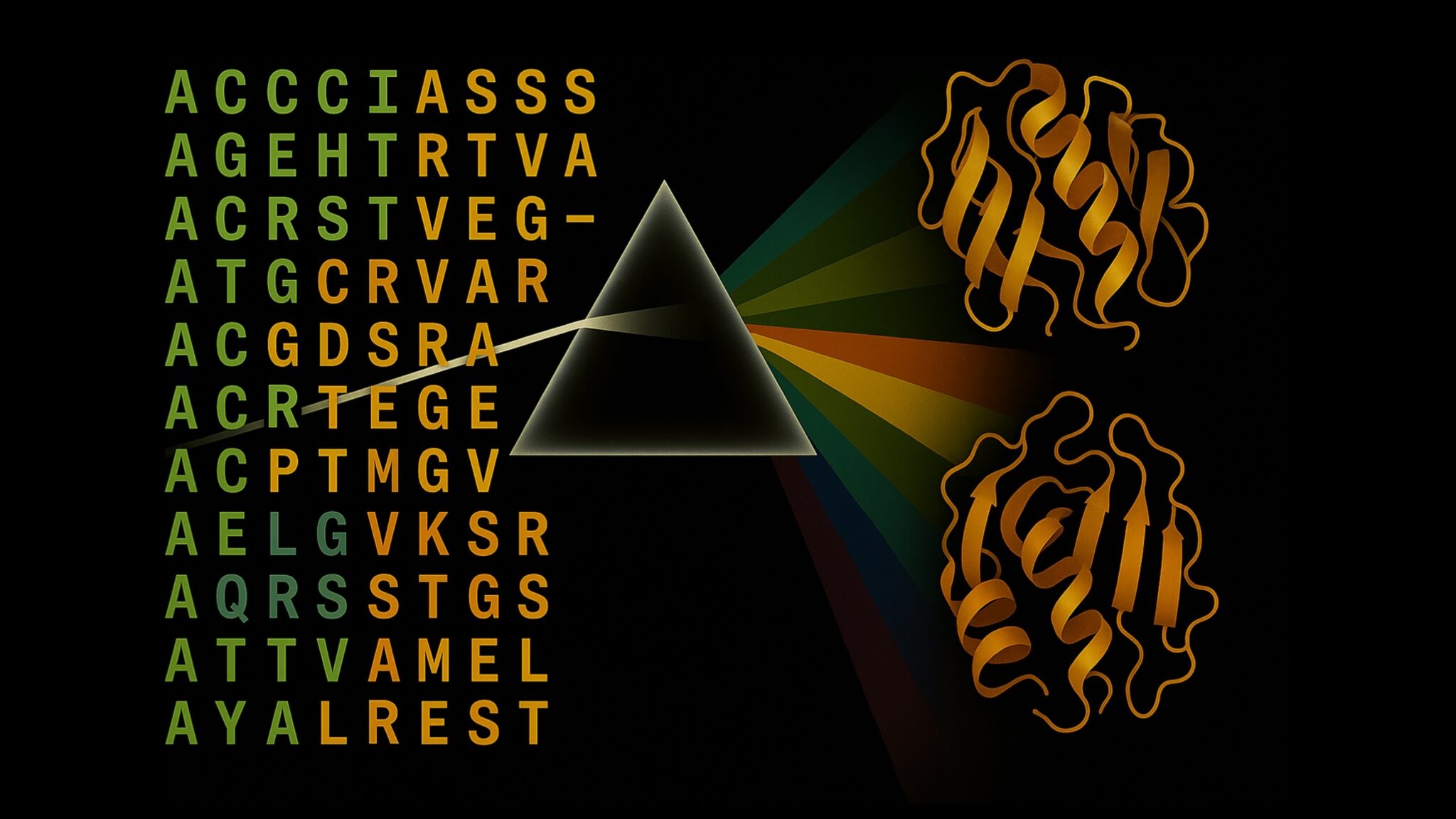

Compreender a estrutura de proteínas é fundamental para acelerar descoberta de fármacos, engenharia de enzimas e biotecnologia agrícola. Desde o AlphaFold2, as inferências de estrutura de proteínas remodelaram a forma como a pesquisa é feita, mas gargalos de desempenho continuam a impactar custo de computação e prazos. A geração de MSAs baseada em CPU e a inferência GPU ineficiente contribuíam para tempos de computação longos. Nesse cenário, a NVIDIA e os laboratórios de Digital Biology Research desenvolveram acelerações para o pipeline completo, da geração de MSA até a predição final, sem perder exatidão. O resultado é a capacidade de realizar análises de proteínas em grande escala com OpenFold em hardware RTX PRO de alto desempenho, tornando Folding de proteomas acessível a laboratórios, plataformas de software e provedores de nuvem. Em termos de magnitude, as melhorias aceleram a linha de montagem de alinhamentos com MMseqs2-GPU e as otimizações de software, abrindo caminho para pipelines end-to-end que antes exigiam clusters CPU extensos. Post no blog da NVIDIA. A carga de trabalho moderna de dobragem de proteínas envolve MSAs em escala metagenômica, refinamento iterativo e cálculos de ensembles, que podem exigir horas de computação por alvo. Escalar esses workloads por todo o proteoma ou por bibliotecas de alvos de fármacos em infraestrutura baseada em CPU é, em geral, inviável. A aceleração baseada em GPU mostrada com o RTX PRO 6000 Blackwell muda esse panorama, movendo componentes críticos do fluxo de trabalho para uma única máquina de servidor poderosa e permitindo foldings em velocidades sem precedentes. Em benchmarks, o MMseqs2-GPU mostrou ganhos significativos sobre o JackHMMER, destacando o papel transformador da GPU na bioinformática.

O que há de novo

O RTX PRO 6000 Blackwell Server Edition traz uma combinação de inovações de hardware e software para acelerar a inferência de estruturas de proteínas:

- Plataforma de GPU de alto desempenho para inference end-to-end com OpenFold, acelerada por novas instruções e otimizações do TensorRT.

- Integração eficiente do MMseqs2-GPU para geração de MSA, reduzindo bastante o tempo de pré-processamento.

- Otimizações sob medida do TensorRT para OpenFold, gerando ganhos consideráveis na velocidade de inferência.

- Validação em benchmarks padrão, incluindo 20 alvos de proteínas CASP14, demonstrando previsões com TM-scores equivalentes ao AlphaFold2, mas com velocidade muito maior.

- Memória de 96 GB com largura de banda de 1,6 TB/s e suporte MIG, permitindo ensembles grandes e MSAs inteiramente na GPU; MIG transforma um RTX PRO 6000 em quatro GPUs virtuais, viabilizando multiusuários sem perder desempenho.

- Disponibilidade imediata: o RTX PRO 6000 Blackwell Server Edition já está disponível via NVIDIA RTX PRO Servers e em instâncias de nuvem de provedores líderes.

Por que isso importa (impacto para desenvolvedores/empresas)

Para equipes de desenvolvimento de plataformas de descoberta de fármacos, proteômica ou preparação para pandemias, esse avanço se traduz em benefícios reais:

- Prova de conceito e entregas mais rápidas: previsões iniciais mais rápidas permitem testar hipóteses com maior agilidade, acelerar ciclos de design e tomadas de decisão.

- Folding em escala de proteoma torna-se viável em um único servidor, reduzindo a necessidade de grandes clusters CPU e tornando análises de grande escala acessíveis a equipes menores.

- A capacidade de rodar todo o fluxo de trabalho na GPU reduz movimentação de dados e acelera experimentação, acelerando ciclos de desenvolvimento de fármacos, melhorias de culturas agrícolas e ferramentas de biossegurança.

- O MIG facilita a colaboração entre usuários em um servidor compartilhado, otimizando o uso de recursos em laboratórios, ambientes de nuvem e centros de pesquisa.

- A combinação de OpenFold, cuEquivariance, TensorRT e MMseqs2-GPU no mesmo dispositivo define um novo patamar para a velocidade de inferência de estruturas de proteínas, com implicações diretas para pesquisa e produtos industriais. A NVIDIA observa que as acelerações ocorrem sem comprometer a exatidão das previsões em relação ao AlphaFold2. Post no blog da NVIDIA.

Detalhes técnicos ou Implementação

O desempenho decorre de uma combinação de capacidades de hardware e otimizações de software:

- Suporte de hardware: 96 GB de memória de alta largura de banda (1,6 TB/s) com capacidade MIG, permitindo que a cadeia completa de inferência permaneça na GPU, incluindo grandes MSAs e ensembles de proteínas. MIG facilita que um único RTX PRO 6000 seja particionado em quatro GPUs virtuais para atender a múltiplos fluxos de trabalho.

- Pilha de software e otimizações: instruções novas e otimizações do TensorRT orientam o OpenFold, com ganhos adicionais de 2,3x na inferência frente a setups base do OpenFold.

- Desempenho em benchmarks: a equipe de biologia computacional validou o OpenFold no RTX PRO 6000 Blackwell Server Edition com TensorRT. Folding completo com esse conjunto de hardware alcançou 138x mais rápido que o AlphaFold2 e cerca de 2,8x mais rápido que o ColabFold, mantendo TM-scores idênticos. Em um benchmark separado de alinhamento, o MMseqs2-GPU em um único L40S ficou ~177x mais rápido que o JackHMMER em CPU de 128 núcleos, com até 720x mais rápido quando distribuído em oito GPUs L40S.

- Integração de fluxo de trabalho: um exemplo completo demonstra implantar o OpenFold2 NIM em uma máquina local, construir requisições de inferência e usar um endpoint local para gerar previsões de estrutura de proteínas. Isso viabiliza folding em um único servidor com velocidade de classe mundial, tornando análises de proteoma acessíveis a laboratórios e plataformas de software.

- Disponibilidade e implantação: o RTX PRO 6000 Blackwell Server Edition está disponível hoje via NVIDIA RTX PRO Servers com fabricantes globais de sistemas e em instâncias de nuvem de provedores líderes. A NVIDIA incentiva parceiros a colaborar para realizar folding de proteínas em velocidade e escala sem precedentes. O reconhecimento inclui pesquisadores da NVIDIA, da University of Oxford e da Seoul National University.

Principais conclusões

- A inferência end-to-end de estruturas de proteínas pode ser executada em um único servidor com o RTX PRO 6000 Blackwell, oferecendo velocidade de classe mundial sem perda de exatidão em relação ao AlphaFold2.

- Os ganhos abrangem todo o pipeline: MMseqs2-GPU acelera a geração de MSAs, otimizações do TensorRT aceleram o OpenFold e o conjunto resultante supera significativamente fluxos baseados em CPU.

- Nos benchmarks, o folding com esse conjunto de tecnologias atinge até 138x mais rápido que o AlphaFold2 e cerca de 2,8x mais rápido que o ColabFold, com alinhamentos 177x mais rápidos em um único L40S e até 720x com múltiplas GPUs.

- Recursos como 96 GB de memória e MIG permitem fluxos de trabalho grandes, residentes na GPU, com compartilhamento entre usuários sem perda de desempenho.

- A disponibilidade é imediata hoje por meio de NVIDIA RTX PRO Servers e provedores de nuvem, abrindo o caminho para adoção em laboratórios e plataformas empresariais.

FAQ

-

Do que pode cuidar o RTX PRO 6000 Blackwell Server Edition?

Ele capacita inferência end-to-end de estruturas de proteínas com OpenFold em um único servidor, usando MMseqs2-GPU, TensorRT e outras acelerações para oferecer ganhos significativos frente a AlphaFold2 e ColabFold, mantendo a exatidão.

-

uão rápido é frente aos baselines estabelecidos?

Pode chegar a 138x mais rápido que o AlphaFold2 e cerca de 2,8x mais rápido que o ColabFold para o fluxo OpenFold. O MMseqs2-GPU em um único L40S fica ~177x mais rápido que o JackHMMER em CPU de 128 núcleos, com até 720x mais rápido ao escalar para oito GPUs.

-

uais recursos de hardware suportam esses ganhos?

96 GB de memória de alta largura de banda (1,6 TB/s), MIG para particionar um GPU em quatro virtuais, e um stack de software com cuEquivariance, TensorRT e MMseqs2-GPU.

-

Isso já está disponível?

Sim. O RTX PRO 6000 Blackwell Server Edition já está disponível hoje via NVIDIA RTX PRO Servers com fabricantes globais e em instâncias de nuvem de provedores líderes.

-

Onde obter mais informações ou iniciar uma implementação?

Consulte o post do blog da NVIDIA para benchmarks detalhados, resultados e diretrizes de implantação, e conecte-se a parceiros da NVIDIA para planejar um setup adequado às necessidades de laboratório ou empresarial. [Post no blog da NVIDIA](https://developer.nvidia.com/blog/accelerate-protein-structure-inference-over-100x-with-nvidia-rtx-pro-6000-blackwell-server-edition/).

Referências

More news

NVIDIA HGX B200 reduz a Intensidade de Emissões de Carbono Incorporado

O HGX B200 da NVIDIA reduz 24% da intensidade de carbono incorporado em relação ao HGX H100, ao mesmo tempo em que aumenta o desempenho de IA e a eficiência energética. Esta análise resume os dados de PCF e as novidades de hardware.

Prever Eventos Climáticos Extremos em Minutos sem Supercomputador com Huge Ensembles (HENS)

NVIDIA e o Lawrence Berkeley National Laboratory apresentam Huge Ensembles (HENS), uma ferramenta de IA de código aberto que prevê eventos climáticos raros e de alto impacto usando 27.000 anos de dados, com opções de código aberto ou prontos para uso.

Playbook dos Grandmasters do Kaggle: 7 Técnicas de Modelagem Testadas para Dados Tabulares

Análise detalhada de sete técnicas testadas por Grandmasters do Kaggle para resolver grandes conjuntos de dados tabulares com aceleração por GPU, desde baselines diversificados até ensemble avançado e pseudo-rotulagem.

Como reduzir gargalos do KV Cache com NVIDIA Dynamo

O Dynamo da NVIDIA transfere o KV Cache da memória da GPU para armazenamento de custo mais baixo, permitindo janelas de contexto maiores, maior concorrência e menor custo de inferência em grandes modelos.

Microsoft transforma site da Foxconn no data center Fairwater AI, considerado o mais poderoso do mundo

A Microsoft divulga planos para um data center Fairwater AI de 1,2 milhão de pés quadrados no Wisconsin, com centenas de milhares de GPUs Nvidia GB200. projeto de US$ 3,3 bilhões promete treinamento de IA em escala sem precedentes.

NVIDIA RAPIDS 25.08 Adiciona Novo Profiler para cuML, Melhorias no Motor GPU Polars e Suporte Ampliado de Algoritmos

RAPIDS 25.08 traz profiladores function-level e line-level para cuml.accel, executor streaming padrão no motor GPU Polars, suporte ampliado de tipos e strings, novo Spectral Embedding no cuML e acelerações com zero código para mais algoritmos.