Mercury: modelos de base da Inception Labs disponíveis no Amazon Bedrock Marketplace e no SageMaker JumpStart

Sources: https://aws.amazon.com/blogs/machine-learning/mercury-foundation-models-from-inception-labs-are-now-available-in-amazon-bedrock-marketplace-and-amazon-sagemaker-jumpstart, https://aws.amazon.com/blogs/machine-learning/mercury-foundation-models-from-inception-labs-are-now-available-in-amazon-bedrock-marketplace-and-amazon-sagemaker-jumpstart/, AWS ML Blog

TL;DR

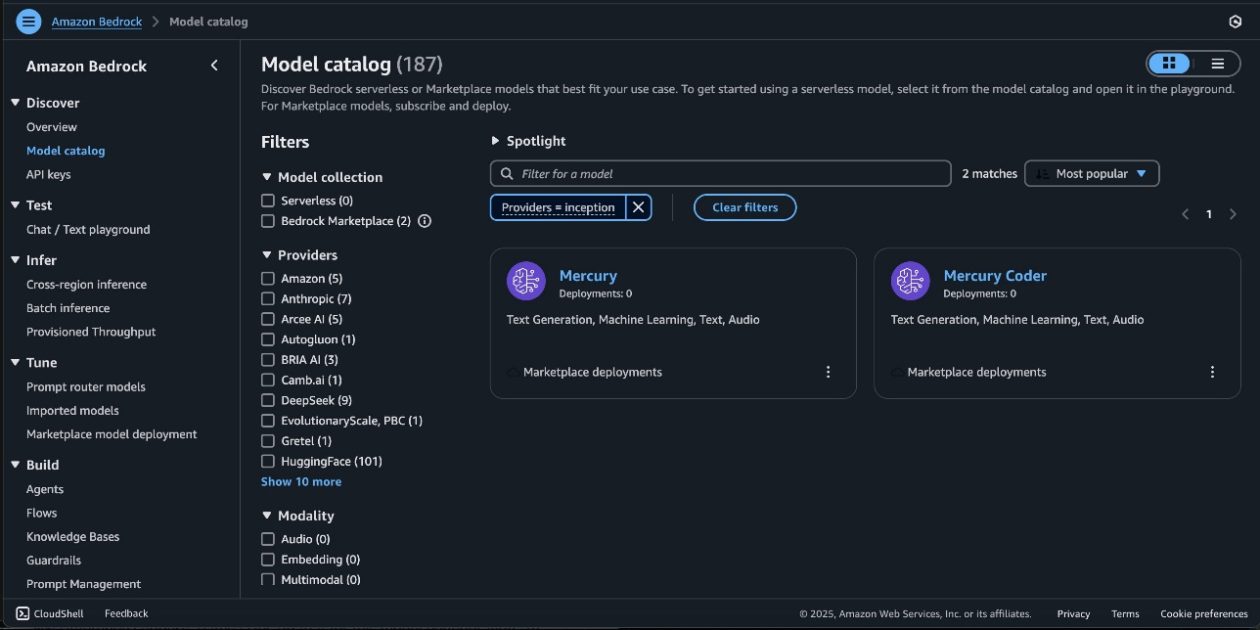

- Mercury e Mercury Coder, modelos de base da Inception Labs, agora disponíveis no Amazon Bedrock Marketplace e no Amazon SageMaker JumpStart.

- Os modelos Mercury usam geração por difusão para produzir múltiplos tokens em paralelo, proporcionando inferência mais rápida que os modelos autoregressivos tradicionais.

- Acesso via Bedrock Marketplace e JumpStart inclui teste no Bedrock playground e implantação pelo SageMaker Studio ou pelo SageMaker Python SDK.

- Demonstrações incluem um jogo completo de tic-tac-toe com IA minimax gerado em uma única resposta a 528 tokens por segundo, ilustrando a qualidade de código gerado e velocidade.

- Os modelos Mercury suportam capacidades avançadas de uso de ferramentas, permitindo que chamem funções externas com base nas consultas do usuário, habilitando agentes de IA que interagem com APIs e bancos de dados. Para mais detalhes, consulte o post original da AWS ML Blog descrevendo a disponibilidade e as capacidades. AWS ML Blog.

Contexto e histórico

Mercury representa a primeira família de modelos de linguagem baseados em difusão em escala comercial, desenvolvida pela Inception Labs. A geração por difusão difere dos modelos autoregressivos tradicionais, pois produz múltiplos tokens em paralelo por meio de um processo difuso em fases, permitindo inferência com menor latência mantendo a qualidade. Mercury Coder expande essa capacidade para tarefas de geração de código. Esses modelos foram criados para atender às necessidades corporativas de velocidade, confiabilidade e segurança ao usar IA generativa na AWS. O Bedrock Marketplace dá acesso a um catálogo amplo de modelos de base, incluindo Mercury e Mercury Coder, enquanto o SageMaker JumpStart oferece modelos pré-treinados e fluxos de trabalho otimizados para implantação e MLOps. Essa combinação facilita a exploração, implantação e testes de modelos Mercury em um ambiente AWS seguro, com opções para rodar em VPC do cliente e para usar as ferramentas do Bedrock via Converse API. Essa inauguração está alinhada às diretrizes da AWS para integrar modelos de base através do Bedrock e do JumpStart, destacando o papel dos hubs de modelos no JumpStart (por exemplo, modelos como o Mistral para várias tarefas). O objetivo é acelerar a experimentação e a adoção responsável de IA gerativa em escala na AWS.

Novidades

- Mercury e Mercury Coder agora podem ser acessados via Amazon Bedrock Marketplace e Amazon SageMaker JumpStart. Você pode implantar esses modelos difusivos para construir, experimentar e escalar aplicações de IA generativa na AWS.

- Os modelos suportam tamanhos Mini e Small, permitindo escolher o footprint do modelo que melhor atende a requisitos de latência, custo e throughput.

- O acesso ocorre por dois caminhos integrados:

- Bedrock Marketplace: páginas de detalhes do modelo fornecem capacidades, estrutura de preços e diretrizes de implementação. Você pode assinar, testar no Bedrock playground e implantar endpoints. A API Converse pode ser usada para invocar o modelo a partir das ferramentas do Bedrock.

- SageMaker JumpStart: encontre e implante Mercury e Mercury Coder nos hubs do JumpStart dentro do SageMaker Studio ou programaticamente via o SageMaker Python SDK. Hubs do JumpStart oferecem uma vasta catalogação de modelos pré-treinados para várias tarefas.

- O deployment ocorre em um ambiente AWS seguro e na sua VPC, apoiando requisitos de segurança empresarial. Você será orientado sobre permissões IAM necessárias para implantação e assinatura do modelo, incluindo as permissões para assinaturas no AWS Marketplace.

- Após a implantação, você pode testar o endpoint enviando um payload de amostra ou usando as opções de teste via SDK. O post fornece um exemplo concreto implantando o Mercury via SageMaker SDK e verificando suas capacidades com uma tarefa simples de geração de código.

- Os modelos Mercury incluem capacidades avançadas de uso de ferramentas, permitindo determinar quando e como chamar funções externas com base nas consultas do usuário. Isso possibilita construir agentes de IA que interagem com sistemas externos, APIs e bancos de dados.

- O artigo também oferece orientações de limpeza de recursos para evitar cobranças, incluindo instruções para excluir endpoints quando não estiverem mais em uso.

Como acessar e implantar

Você pode acessar os modelos Mercury tanto no Bedrock Marketplace quanto no SageMaker JumpStart. O Bedrock Marketplace expõe pacotes de modelos e fornece um playground de teste para exploração rápida, enquanto o JumpStart oferece um fluxo de implantação gerenciado e otimizado dentro do SageMaker Studio ou via SageMaker JumpStart. Para implantar, normalmente você verifica seus recursos e permissões, assina o pacote do modelo, obtém o ARN do pacote e o utiliza para criar um modelo implantável via código. O post percorre um exemplo end-to-end de implantação usando o SageMaker SDK, incluindo como referenciar o ARN do pacote do modelo e como testar o endpoint após a implantação. Um exemplo de tic-tac-toe demonstra as capacidades de geração de código e a velocidade do modelo, com 528 tokens por segundo no exemplo, ilustrando as capacidades de geração de código e a velocidade de difusão.

Por que isso importa (impacto para desenvolvedores/empresas)

- Modelos Mercury com difusão oferecem inferência de alta velocidade ao gerar múltiplos tokens em paralelo, o que é valioso para workloads de IA generativa com baixa latência, como chat, assistentes de código e pipelines de geração de conteúdo.

- Disponibilidade via Bedrock Marketplace e JumpStart reduz barreiras de acesso para desenvolvedores e empresas, permitindo experimentação rápida e iteração sem precisar de treinamento extensivo de modelos ou configuração de infraestrutura.

- A capacidade de rodar em um ambiente AWS seguro e dentro da VPC do cliente atende a exigências regulatórias e de segurança comuns a implantações empresariais. Isso é importante para setores que exigem isolamento de dados e redes controladas, mantendo o acesso a capacidades avançadas de IA generativa.

- As capacidades de uso de ferramentas pelos modelos Mercury ampliam o potencial de IA para automatizar e orquestrar tarefas externas, APIs e bancos de dados, habilitando agentes mais capazes.

- A integração com recursos do SageMaker, como Pipelines, Debugger e visibilidade de logs de containers, ajuda equipes a monitorar desempenho, aplicar práticas de MLOps e gerenciar o ciclo de vida de modelos em produção.

Detalhes técnicos ou Implementação

Mercury e Mercury Coder são oferecidos em vários tamanhos (Mini e Small) para atender a considerações de latência e custo. Acesso pode ocorrer via Bedrock Marketplace e SageMaker JumpStart, cada um com fluxo de implantação próprio:

- Bedrock Marketplace: páginas de detalhes do modelo oferecem capacidades, estruturas de preço e diretrizes de implementação. Você pode assinar, testar no Bedrock playground e implantar endpoints. A API Converse pode ser usada para invocar o modelo a partir das ferramentas do Bedrock.

- SageMaker JumpStart: Mercury aparece nos hubs do JumpStart e pode ser implantado pelo SageMaker Studio ou programaticamente via o SageMaker Python SDK. Após a implantação, você pode avaliar desempenho e controles de MLOps com os recursos da AWS, como SageMaker Pipelines, SageMaker Debugger e logs de containers. Etapas de implantação (alto nível):

- Garanta que você possua as permissões de IAM apropriadas do SageMaker para implantar o modelo, incluindo permissões de assinatura do AWS Marketplace se necessário.

- Assine o pacote do modelo ou utilize uma assinatura existente em sua conta.

- Obtenha o ARN do pacote do modelo e o utilize ao criar um modelo implantável via Boto3 (ou pela interface do JumpStart).

- Implante o endpoint e teste com payloads de exemplo para validar comportamento e latência.

- Monitore desempenho e custos; utilize as diretrizes fornecidas para limpar recursos quando terminar para evitar cobranças. Um exemplo curto no artigo demonstra o Mercury gerando um jogo de tic-tac-toe com código completo (HTML, CSS e JavaScript) em resposta única, atingindo 528 tokens por segundo naquela execução específica. Esse caso ilustra tanto as capacidades de geração de código quanto as vantagens de velocidade da geração por difusão.

Tabela rápida

| Família do modelo | Caminhos de acesso | Tamanhos suportados |---|---|---| | Mercury | Bedrock Marketplace, SageMaker JumpStart | Mini, Small |Mercury Coder | Bedrock Marketplace, SageMaker JumpStart | Mini, Small |

Principais aprendizados

- Modelos Mercury trazem velocidade de difusão para aplicações de linguagem na AWS via Bedrock Marketplace e JumpStart.

- O acesso foi desenhado para experimentação rápida, teste e escala dentro de ambientes AWS seguros.

- Capacidade de uso de ferramentas permite que agentes de IA interajam com APIs, bancos de dados e sistemas externos.

- A suíte de ferramentas do SageMaker facilita MLOps, monitoramento de produção e gestão de ciclos de vida dos modelos.

FAQ

- Q: O que são os modelos Mercury e Mercury Coder? A: São modelos de base baseados em difusão da Inception Labs, disponíveis via Bedrock Marketplace e SageMaker JumpStart na AWS.

- Q: Como posso acessá-los na AWS? A: Você pode assinar o pacote do modelo no Bedrock Marketplace ou implantá-los a partir do SageMaker JumpStart, testando no Bedrock playground ou no SageMaker Studio/SDK.

- Q: Há evidências de velocidade e capacidades? A: Um exemplo de tic-tac-toe gerou código completo e jogabilidade com 528 tokens por segundo, ilustrando a velocidade de geração por difusão.

- Q: Existem considerações de segurança? A: Os endpoints são implantados em um ambiente AWS seguro e dentro da sua VPC, com orientações de limpeza para evitar cobranças contínuas.

- Q: Como gerencio implantação e monitoramento? A: Use SageMaker Pipelines, SageMaker Debugger e logs de containers para gerenciar MLOps, desempenho e observabilidade, juntamente com as ferramentas do JumpStart.

Referências

More news

Levar agentes de IA do conceito à produção com Amazon Bedrock AgentCore

Análise detalhada de como o Amazon Bedrock AgentCore ajuda a transformar aplicações de IA baseadas em agentes de conceito em sistemas de produção de nível empresarial, mantendo memória, segurança, observabilidade e gerenciamento de ferramentas escalável.

Monitorar Bedrock batch inference da Amazon usando métricas do CloudWatch

Saiba como monitorar e otimizar trabalhos de bedrock batch inference com métricas do CloudWatch, alarmes e painéis para melhorar desempenho, custo e governança.

Prompting para precisão com Stability AI Image Services no Amazon Bedrock

O Bedrock now oferece Stability AI Image Services com nove ferramentas para criar e editar imagens com maior precisão. Veja técnicas de prompting para uso empresarial.

Aumente a produção visual com Stability AI Image Services no Amazon Bedrock

Stability AI Image Services já estão disponíveis no Amazon Bedrock, oferecendo capacidades de edição de mídia prontas para uso via Bedrock API, ampliando os modelos Stable Diffusion 3.5 e Stable Image Core/Ultra já existentes no Bedrock.

Use AWS Deep Learning Containers com o SageMaker AI gerenciado MLflow

Explore como os AWS Deep Learning Containers (DLCs) se integram ao SageMaker AI gerenciado pelo MLflow para equilibrar controle de infraestrutura e governança robusta de ML. Um fluxo de trabalho de predição de idade de ostra com TensorFlow demonstra rastreamento de ponta a ponta, governança de model

Construir Fluxos de Trabalho Agenticos com GPT OSS da OpenAI no SageMaker AI e no Bedrock AgentCore

Visão geral de ponta a ponta para implantar modelos GPT OSS da OpenAI no SageMaker AI e no Bedrock AgentCore, alimentando um analisador de ações com múltiplos agentes usando LangGraph, incluindo quantização MXFP4 de 4 bits e orquestração serverless.