Aprimore agentes de IA com modelos preditivos de ML via SageMaker AI e MCP

TL;DR

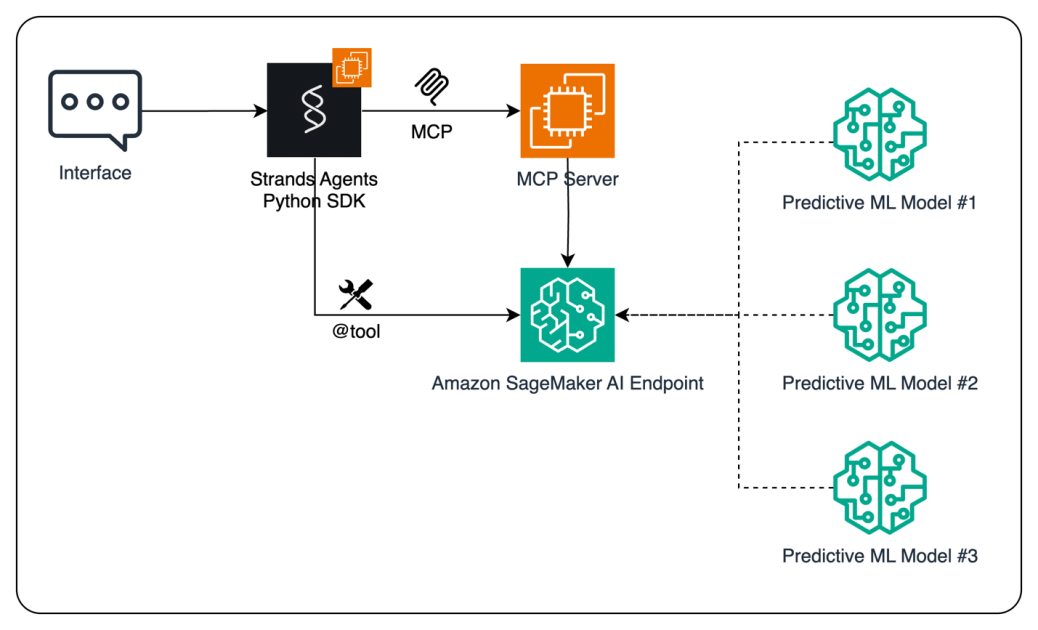

- Agentes de IA podem usar modelos preditivos de ML hospedados no Amazon SageMaker AI como ferramentas para fundamentar decisões com base em dados.

- O Model Context Protocol (MCP) permite descoberta dinâmica de ferramentas e desacopla a execução do agente da execução da ferramenta, oferecendo escalabilidade e segurança.

- O Strands Agents SDK fornece uma abordagem orientada ao modelo para construir agentes de IA rapidamente, com duas vias de acesso aos endpoints do SageMaker: chamadas diretas ao endpoint ou invocação via MCP.

- Para implantações de produção, o MCP é recomendado pela arquitetura desacoplada e pelo gerenciamento centralizado de permissões; o caminho de endpoint direto também é validado para cenários mais simples.

- O fluxo demonstrado treina um modelo de previsão de séries temporais, implanta-o no SageMaker AI e o disponibiliza para um agente de IA, ilustrando a cadeia completa desde dados até a decisão.

Contexto e antecedentes

O ML evoluiu de fases experimentais para operar como parte integrante de operações de negócios. As organizações utilizam modelos de ML para previsão de vendas, segmentação de clientes e churn. Embora a IA generativa tenha transformado experiências de clientes, o ML tradicional continua essencial para tarefas preditivas específicas. Em previsão, por exemplo, algoritmos estabelecidos como florestas aleatórias, boosting, ARIMA, LSTM e regressão linear costumam oferecer resultados superiores; modelagem de segmentação e churn também se beneficia de técnicas como K-means e clustering hierárquico. Para ampliar agentes de IA com capacidades preditivas, este estudo integra modelos preditivos com o MCP—um protocolo aberto que padroniza como aplicações fornecem contexto a modelos de linguagem (LLMs)—em conjunto com o SageMaker AI. O objetivo é permitir que agentes de IA acessem modelos hospedados como ferramentas, impulsionando decisões mais informadas, com equilíbrio entre custo e desempenho. O Strands Agents é um SDK de código aberto que apoia um design orientado a modelos para construir agentes de IA, facilitando desenvolvimento rápido de assistentes simples a fluxos de trabalho autônomos complexos. Existem dois caminhos para conectar agentes a endpoints do SageMaker: invocar endpoints diretamente do código do agente ou rotear a invocação por meio do MCP, que habilita descoberta dinâmica de ferramentas e execução desacoplada. Para implantações escaláveis e seguras, o caminho MCP é recomendado, embora o caminho direto seja apresentado para demonstração de opções. O SageMaker AI oferece dois métodos para hospedar múltiplos modelos atrás de um único endpoint: componentes de inferência e endpoints multi-model. Essas opções ajudam a otimizar recursos computacionais e reduzir a latência. Embora o exemplo foque em um único modelo para clareza, as diretrizes apontam para práticas eficientes ao lidar com múltiplos modelos. O fluxo apresentado começa com o usuário interagindo por interface baseada em chat, o agente alimentado por LLM observa o ambiente, planeja ações e executa tarefas com pouca intervenção humana. O agente utiliza o endpoint SageMaker AI para obter previsões, que são repassadas ao usuário. O código completo está disponível no GitHub, e leitores são encorajados a explorar implementações reais e a documentação correspondente para aprofundar.

O que há de novo

Essa abordagem demonstra como agentes de IA podem ser aprimorados com ML preditivo, expondo modelos como ferramentas que os agentes podem chamar em tempo real. As inovações centrais incluem:

- Integração de modelos preditivos hospedados no SageMaker AI com agentes de IA via Strands Agents SDK.

- Duas modalidades de invocação: acesso direto ao endpoint do SageMaker incorporado ao código do agente e invocação baseada em MCP que habilita descoberta dinâmica de ferramentas e a mediação da chamada via servidor MCP.

- Recomendação do MCP para implantações escaláveis e seguras, além de apresentar o caminho direto para maior flexibilidade.

- Demonstração de hospedar vários modelos atrás de um único endpoint SageMaker AI por meio de componentes de inferência ou endpoints multi-model, otimizando o uso de recursos e a latência.

- Um fluxo prático: treinar um modelo de séries temporais (XGBoost), implantar no SageMaker AI e expô-lo a um agente de IA para decisão em tempo real.

- Instruções de como expor o endpoint como uma ferramenta Strands Agent (via @tool) e como invocá-lo a partir de um agente, com docstring para facilitar uso orientado por modelo.

- Potencial para integrar previsões a ferramentas de BI (ex.: Amazon QuickSight) ou sistemas corporativos (ERP/CRM) para operacionalizar insights.

Por que isso importa (impacto para desenvolvedores/empresas)

Ao combinar ML preditivo com IA conversacional, organizações podem capacitar agentes de IA para apoiar decisões baseadas em dados em tempo real. A abordagem reduz a barreira de adoção de ML, permitindo que equipes utilizem previsões sem precisar de profunda expertise em ML. O MCP oferece descoberta dinâmica de ferramentas e governança centralizada, o que é essencial para operações em larga escala e para manter controles de segurança. Para desenvolvedores, o modelo descreve um caminho para construir agentes que possam interpretar dados, prever resultados e se integrar a ferramentas de negócio. Para empresas, o fluxo acelera ciclos de analytics para ação, facilita a integração entre previsões e sistemas operacionais, e oferece governança por meio de um servidor MCP centralizado. A combinação entre SageMaker AI e Strands Agents suporta tanto experimentação rápida quanto implantações em produção com padrões comprovados.

Detalhes técnicos ou Implementação

A solução segue um ciclo de vida claro, com arquitetura bem definida:

- Dados e preparação do modelo: criar dados de séries temporais sintéticos com tendência, sazonalidade e ruído. Realizar engineer de features para capturar efeitos sazonais relevantes (dia da semana, mês, trimestre).

- Treinamento e implantação: treinar um modelo de regressão XGBoost usando o contêiner 1P do SageMaker AI, empacotar e implantar o modelo em um endpoint do SageMaker AI para inferência em tempo real.

- Invocação do endpoint: implementar uma função como invoke_endpoint() com um docstring descritivo para que possa ser usado como ferramenta por LLMs. A função pode ser transformada em uma ferramenta Strands Agents com o decorador @tool e chamada por um agente Strands.

- Dois caminhos de integração:

- Acesso direto ao endpoint: o agente chama o endpoint do SageMaker diretamente do código, oferecendo acesso simples à inferência do modelo.

- Acesso via MCP: o cliente descobre ferramentas expostas pelo servidor MCP, formata a requisição com a interface da ferramenta e chama o endpoint de inferência através da camada MCP. O caminho MCP desacopla a lógica do agente da execução da ferramenta e centraliza permissões, aumentando a segurança e a escalabilidade.

- Servidor MCP e schemas de ferramenta: para uso em larga escala, implemente um servidor MCP (ex.: com o framework FastMCP) que envolva o endpoint do SageMaker e o exponha como uma ferramenta com interface definida. Um schema de ferramenta especifica claramente os parâmetros de entrada e os valores de retorno para uso simples por agentes de IA.

- Considerações de recursos: o SageMaker AI oferece duas formas de hospedar múltiplos modelos atrás de um único endpoint — componentes de inferência e endpoints multi-model. Embora o exemplo foque em um único modelo, as diretrizes apontam para práticas eficientes na gestão de vários modelos.

- Fluxo fim a fim: o usuário interage via chat ou app, o Strands Agent processa a requisição, decide invocar o modelo de ML, e a previsão é retornada ao usuário. O sistema pode gerar gráficos, enviar valores para ferramentas de BI ou atualizar sistemas ERP/CRM conforme necessário.

- Observações práticas: o padrão apresentado permite que agentes acessem capacidades de ML sem competências profundas em ML, oferecendo um caminho prático para adicionar inteligência preditiva a agentes de IA.

Opções de invocação de ferramentas em resumo

| Aspecto | Acesso direto ao endpoint | Invocação por MCP |---|---|---| | Mecanismo de descoberta | Chamadas de ferramenta incorporadas ao código do agente | Descoberta dinâmica através do servidor MCP |Componente arquitetural | Sem servidor MCP necessário | Introduz um servidor MCP para intermediar chamadas |Padrão de segurança | Permissões e chamadas gerenciadas no nível da ferramenta | Governança centralizada e permissões via servidor MCP |Considerações de implantação | Mais simples para prototipagem | Escalável e seguro para produção; suporta múltiplas ferramentas |Recomendação | Útil para experimentos rápidos | Recomendado para implantações escaláveis e seguras |

- Como escolher: para prototipagem rápida ou experimentos de menor escala, chamadas diretas ao endpoint funcionam bem. Para produção com descobertas dinâmicas, controle centralizado e segurança, MCP é o caminho preferencial.

- Código e referências: o código completo para esta solução está disponível no GitHub, e leitores devem consultar a documentação do SageMaker AI para detalhes sobre componentes de inferência e endpoints multi-model.

Principais conclusões

- Modelos preditivos hospedados no SageMaker AI podem funcionar como ferramentas dentro de agentes de IA para melhorar decisões.

- MCP oferece descoberta dinâmica de ferramentas e uma arquitetura desacoplada entre agentes e ferramentas, com um servidor MCP lidando com execução de ferramentas e permissões.

- O Strands Agents SDK facilita o desenvolvimento de agentes model-driven, permitindo definir agentes com prompts e ferramentas em vez de integrações personalizadas.

- O SageMaker AI suporta hospedar múltiplos modelos por meio de componentes de inferência ou endpoints multi-model, otimizando o uso de recursos e a latência.

- O fluxo demonstrado abrange dados sintéticos, engenharia de features, modelagem com XGBoost, implantação do endpoint e invocação pelo agente para demonstração de decisões preditivas em tempo real.

FAQ

-

O que o MCP resolve para agentes de IA?

O MCP permite descoberta dinâmica de ferramentas e desacopla a execução do agente da execução da ferramenta, introduzindo um servidor MCP para governança e segurança.

-

Como um agente de IA pode acessar modelos do SageMaker AI?

O agente pode invocar endpoints diretamente ou usar o MCP para descobrir e chamar as ferramentas expostas pelo servidor MCP.

-

Quais opções existem para hospedar vários modelos atrás de um único endpoint?

O SageMaker AI oferece componentes de inferência e endpoints multi-model para consolidar modelos sob um único endpoint, reduzindo o consumo de recursos e a latência quando aplicável.

-

Qual é o fluxo fim a fim do exemplo?

Treinar um modelo de séries temporais, implantar no SageMaker AI, expô-lo como ferramenta Strands Agent, invocar pelo agente e apresentar previsões a usuários ou sistemas downstream.

Referências

More news

Levar agentes de IA do conceito à produção com Amazon Bedrock AgentCore

Análise detalhada de como o Amazon Bedrock AgentCore ajuda a transformar aplicações de IA baseadas em agentes de conceito em sistemas de produção de nível empresarial, mantendo memória, segurança, observabilidade e gerenciamento de ferramentas escalável.

Monitorar Bedrock batch inference da Amazon usando métricas do CloudWatch

Saiba como monitorar e otimizar trabalhos de bedrock batch inference com métricas do CloudWatch, alarmes e painéis para melhorar desempenho, custo e governança.

Prompting para precisão com Stability AI Image Services no Amazon Bedrock

O Bedrock now oferece Stability AI Image Services com nove ferramentas para criar e editar imagens com maior precisão. Veja técnicas de prompting para uso empresarial.

Aumente a produção visual com Stability AI Image Services no Amazon Bedrock

Stability AI Image Services já estão disponíveis no Amazon Bedrock, oferecendo capacidades de edição de mídia prontas para uso via Bedrock API, ampliando os modelos Stable Diffusion 3.5 e Stable Image Core/Ultra já existentes no Bedrock.

Use AWS Deep Learning Containers com o SageMaker AI gerenciado MLflow

Explore como os AWS Deep Learning Containers (DLCs) se integram ao SageMaker AI gerenciado pelo MLflow para equilibrar controle de infraestrutura e governança robusta de ML. Um fluxo de trabalho de predição de idade de ostra com TensorFlow demonstra rastreamento de ponta a ponta, governança de model

Construir Fluxos de Trabalho Agenticos com GPT OSS da OpenAI no SageMaker AI e no Bedrock AgentCore

Visão geral de ponta a ponta para implantar modelos GPT OSS da OpenAI no SageMaker AI e no Bedrock AgentCore, alimentando um analisador de ações com múltiplos agentes usando LangGraph, incluindo quantização MXFP4 de 4 bits e orquestração serverless.