Sam Altman sobre o lançamento do GPT‑5, centros de dados, Chrome e interfaces neurais — principais pontos

TL;DR

- Sam Altman reconheceu que OpenAI “estragou” partes do lançamento do GPT‑5 e restaurou a “calidez” do modelo 4o após reação dos usuários.

- O tráfego da API dobrou em 48 horas; a empresa está sem GPUs e Altman disse que será necessário gastar trilhões em centros de dados.

- Altman confirmou planos de financiar uma startup de interface cérebro‑computador e demonstrou ambições para apps independentes, experiências sociais com IA e até avaliar o Chrome.

Contexto e antecedentes

Em São Francisco, Sam Altman e executivos da OpenAI jantaram com um pequeno grupo de repórteres e responderam questões por horas; tudo foi registrado, exceto o que foi dito durante a sobremesa. Os tópicos incluíram o recente lançamento do GPT‑5, reações de usuários, postura de produto, restrições de infraestrutura e movimentos estratégicos potenciais, como avaliar comprar o Chrome caso fosse vendido. Altman afirmou que o ChatGPT cresceu rapidamente: o produto “quadruplicou” a base de usuários em um ano e alcança “mais de 700 milhões de pessoas por semana”, posicionando‑o entre os maiores sites do mundo — um contexto importante para os desafios técnicos e de produto discutidos.

O que há de novo

- Resposta ao lançamento: Cerca de uma hora antes do jantar, a OpenAI lançou uma atualização que trouxe de volta a “calidez” do 4o, o modelo padrão anterior, como opção para assinantes pagantes. Altman disse que tomou a decisão após protestos no Reddit e no X.

- Uso e capacidade: Altman relatou que o tráfego da API dobrou em 48 horas após o lançamento e que a empresa está “sem GPUs” enquanto o ChatGPT atinge novos recordes de usuários diários.

- Investimento e infraestrutura: Altman afirmou: “Você deve esperar que a OpenAI gaste trilhões de dólares na construção de data centers em um futuro não muito distante”, destacando que limitações de capacidade forçam concessões que impedem oferecer melhores modelos ou novos produtos.

- Novas apostas técnicas: Ele confirmou que a OpenAI planeja financiar uma startup de interface neural para explorar a interação pensamento‑resposta.

- Escopo do produto e negócios: A chegada de Fidji Simo para liderar “aplicações” implica apps independentes além do ChatGPT. Altman também mencionou ambições sociais com IA e interesse em avaliar o Chrome se fosse vendido.

- Postura pública: Altman reconheceu que a empresa está em muitas reuniões sobre usuários que formam relações prejudiciais com o ChatGPT, estimando que isso é “bem abaixo de 1 por cento”. Ele disse que a OpenAI não vai explorar casos de uso predatórios (referindo‑se a “anime sex bots”) e quer que o ChatGPT seja pessoal sem adotar uma posição ideológica específica.

Por que isso importa (impacto para desenvolvedores/empresas)

- Restrições de capacidade afetam disponibilidade de produto e cronogramas de lançamento. Empresas que dependem das APIs da OpenAI devem esperar variabilidade no acesso ou limitação enquanto a demanda superar a oferta de GPUs.

- O anúncio de investimento em grande escala para data centers sinaliza planos de estabilidade e escala a longo prazo, mas também implica esforços de capital e operacionais plurianuais que podem afetar preços e termos contratuais.

- A confirmação de financiamento para interfaces neurais indica que modalidades de entrada futuras (sinais cerebrais) podem fazer parte do roadmap; desenvolvedores e parceiros de hardware devem acompanhar padrões, APIs e discussões de interoperabilidade.

- Múltiplos apps independentes e novos recursos sociais significam que empresas integradoras podem ver superfícies de produto expandidas, SDKs ou programas de parceria; equipes de produto devem rastrear mudanças.

- A ênfase de Altman em permitir que usuários ajustem preferências, mantendo uma postura central, tem implicações para moderação de conteúdo, ofertas de fine‑tuning e APIs de personalização.

Detalhes técnicos ou implementação

Resumo das informações técnicas e operacionais citadas por Altman durante o jantar:

| Tópico | Fato / Citação |

|---|---|

| Reversão de modelo | OpenAI restaurou a “calidez” do 4o como opção para assinantes pagantes; Altman disse que tomou a decisão após críticas. |

| Pico de tráfego | O tráfego da API dobrou em 48 horas após o lançamento do GPT‑5. |

| Capacidade | OpenAI está “sem GPUs” e atingindo novos recordes diários de usuários. |

| Gastos com data centers | Altman: “Você deve esperar que a OpenAI gaste trilhões de dólares na construção de data centers…” |

| Interfaces neurais | Altman confirmou planos de financiar uma startup de interface neural. |

| Escopo do produto | A chegada de Fidji Simo indica apps independentes; Altman comentou ambições sociais e interesse no Chrome. |

| Implicações operacionais: |

- Espere limitação baseada em capacidade até que mais infraestrutura de GPU esteja disponível.

- Prepare‑se para novos endpoints e possivelmente novos requisitos de segurança caso surjam interfaces neurais.

- Fique atento a comunicados de preços e cotas relacionados a grandes investimentos em infraestrutura.

Principais conclusões

- OpenAI reconheceu erros no lançamento do GPT‑5 e restaurou a opção 4o.

- A demanda aumentou significativamente e a empresa relatou falta de GPUs.

- Altman prevê gastos massivos em centros de dados para escalar operações.

- A OpenAI explora interfaces cérebro‑computador e planeja financiar startups nessa área.

- A empresa pretende expandir além do ChatGPT com apps independentes e experiências sociais.

FAQ

Referências

- Matéria original: The Verge — I talked to Sam Altman about the GPT‑5 launch fiasco: https://www.theverge.com/command-line-newsletter/759897/sam-altman-chatgpt-openai-social-media-google-chrome-interview

More news

Anthropic atualiza regras do Claude diante de um cenário de IA mais perigoso

Anthropic proibiu assistência a armas CBRN e explosivos de grande rendimento, adicionou restrições de cibersegurança, ajustou política política e clarificou requisitos de alto risco.

Build a scalable containerized web application on AWS using the MERN stack with Amazon Q Developer – Part 1

In a traditional SDLC, a lot of time is spent in the different phases researching approaches that can deliver on requirements: iterating over design changes, writing, testing and reviewing code, and configuring infrastructure. In this post, you learned about the experience and saw productivity gains

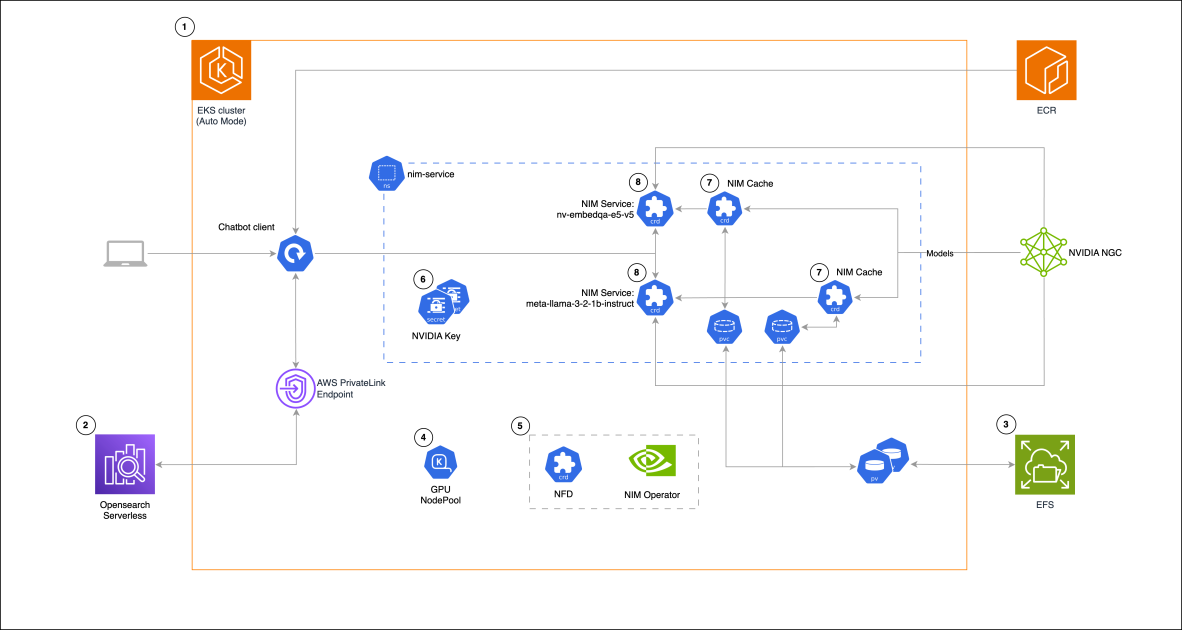

Building a RAG chat-based assistant on Amazon EKS Auto Mode and NVIDIA NIMs

In this post, we demonstrate the implementation of a practical RAG chat-based assistant using a comprehensive stack of modern technologies. The solution uses NVIDIA NIMs for both LLM inference and text embedding services, with the NIM Operator handling their deployment and management. The architectu

GPT-5 não atingiu as expectativas de hype, mas trouxe ganhos em custo, velocidade e código

O lançamento do GPT-5 gerou reações mistas: avanços incrementais em benchmarks, redução de custos e latência, desempenho em programação melhor, mas críticas ao tom da escrita e a erros inesperados.

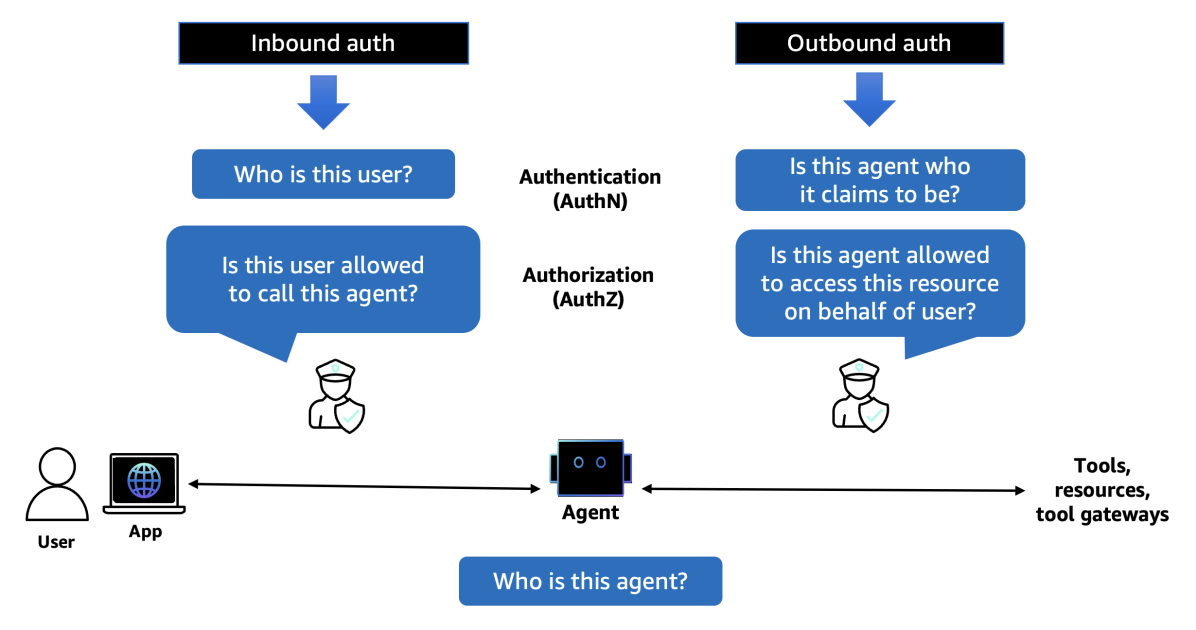

Introducing Amazon Bedrock AgentCore Identity: Securing agentic AI at scale

In this post, we explore Amazon Bedrock AgentCore Identity, a comprehensive identity and access management service purpose-built for AI agents that enables secure access to AWS resources and third-party tools. The service provides robust identity management features including agent identity director

Introducing Amazon Bedrock AgentCore Gateway: Transforming enterprise AI agent tool development

In this post, we discuss Amazon Bedrock AgentCore Gateway, a fully managed service that revolutionizes how enterprises connect AI agents with tools and services by providing a centralized tool server with unified interface for agent-tool communication. The service offers key capabilities including S