Anthropic atualiza regras do Claude diante de um cenário de IA mais perigoso

Sources: https://www.theverge.com/news/760080/anthropic-updated-usage-policy-dangerous-ai-landscape

TL;DR

- Anthropic atualizou a política de uso do Claude para proibir explicitamente assistência no desenvolvimento de armas biológicas, químicas, radiológicas e nucleares (CBRN) e explosivos de alto rendimento.

- A empresa incluiu uma seção ‘Não comprometa sistemas de computador ou redes’ proibindo descoberta/exploração de vulnerabilidades, criação de malware e ferramentas de negação de serviço.

- Em maio, Anthropic implementou proteções de ‘AI Safety Level 3’ juntamente com o lançamento do modelo Claude Opus 4 para reduzir jailbreaks e assistência a CBRN.

- Recursos agentivos como Computer Use e Claude Code foram citados como riscos por poderem facilitar abuso em escala e ataques cibernéticos.

- A política sobre conteúdo político foi flexibilizada, passando a proibir apenas casos enganosos ou disruptivos aos processos democráticos e o direcionamento de eleitores/ campanhas.

Contexto e antecedentes

Anthropic publicou uma atualização em sua política de uso para o chatbot Claude em resposta a preocupações crescentes com segurança. Anteriormente, a empresa já proibia o uso do Claude para ‘produzir, modificar, projetar, comercializar ou distribuir armas, explosivos, materiais perigosos ou outros sistemas projetados para causar dano ou perda de vidas humanas’. A comparação entre as versões antiga e nova mostra que a empresa expandiu e clarificou essa proibição em áreas específicas. Em maio, a Anthropic lançou proteções chamadas ‘AI Safety Level 3’ junto ao Claude Opus 4. Essas salvaguardas buscam tornar o modelo mais difícil de ser ‘jailbroken’ e ajudar a evitar que ele auxilie no desenvolvimento de armas CBRN. A empresa também destacou capacidades agentivas como área de risco. Exemplos citados na atualização são Computer Use, que permite ao Claude executar ações no computador de um usuário, e Claude Code, que integra Claude diretamente no terminal de um desenvolvedor. A Anthropic cita riscos como potencial de abuso em escala, criação de malware e ataques cibernéticos. Para o anúncio completo, veja a cobertura citada: The Verge.

O que há de novo

Principais alterações e esclarecimentos incluem:

- Proibição explícita de usar Claude para ajudar a desenvolver armas biológicas, químicas, radiológicas ou nucleares (CBRN).

- Proibição específica de assistência com explosivos de alto rendimento.

- Nova seção ‘Não comprometa sistemas de computador ou redes’, que impede descoberta/exploração de vulnerabilidades, criação/distribuição de malware e desenvolvimento de ferramentas de negação de serviço.

- Redução da proibição sobre conteúdo político: não é mais proibido todo conteúdo relacionado a campanhas e lobby, apenas usos enganosos ou disruptivos aos processos democráticos e direcionamento de eleitores/campanhas.

- Clarificação de que requisitos de ‘alto risco’ se aplicam a cenários de recomendação voltados ao consumidor, não ao uso interno empresarial. Essas mudanças ampliam a proibição anterior ao nomear categorias de alto risco e adicionar restrições ligadas a capacidades agentivas.

Por que isso importa (impacto para desenvolvedores/empresas)

- Conformidade e gestão de risco: Desenvolvedores e organizações que usam Claude devem revisar a nova política para garantir que suas aplicações não violem as proibições explícitas a CBRN, explosivos de alto rendimento ou as novas restrições de cibersegurança.

- Recursos agentivos exigem supervisão adicional: Computer Use e Claude Code podem realizar ações além da geração de texto. A própria atualização destaca o risco de abuso em escala e ataques cibernéticos, o que implica controles extras para integrações.

- Design e implantação de produto: Equipes que constroem sistemas de recomendação ao consumidor com Claude devem seguir os requisitos de alto risco. Anthropic esclareceu que isso se aplica a cenários voltados ao consumidor, não ao uso empresarial interno.

- Implicações políticas e de conformidade: A mudança de política em conteúdo político foca usos enganosos e direcionamento de eleitores. Organizações em tecnologia de campanhas ou lobby devem reavaliar seus usos de Claude.

Detalhes técnicos ou de implementação

A atualização combina mudanças de política com proteções a nível de modelo. Pontos técnicos e de política relevantes:

- AI Safety Level 3 e Claude Opus 4: Em maio, Anthropic implementou proteções descritas como destinadas a dificultar jailbreaks e reduzir assistência em tópicos CBRN.

- Recursos agentivos citados:

| Recurso agentivo | Descrição segundo a atualização |

|---|---|

| Computer Use | Permite ao Claude executar ações no computador do usuário; citado como gerador de riscos para abuso em escala e ataques cibernéticos |

| Claude Code | Integra Claude no terminal do desenvolvedor; citado entre recursos que introduzem riscos de malware e segurança |

- Novas proibições de cibersegurança: A seção ‘Não comprometa sistemas de computador ou redes’ proíbe uso do Claude para descobrir/explorar vulnerabilidades, criar/distribuir malware e desenvolver ferramentas de negação de serviço.

- Comparação na política de armas: | Tópico | Linguagem antiga | Linguagem nova |---|---:|---| | Armas e explosivos | Proibia produzir, modificar, projetar, comercializar ou distribuir armas, explosivos, materiais perigosos ou outros sistemas produzindo dano ou perda de vidas | Expandida para proibir explicitamente assistência ao desenvolvimento de explosivos de alto rendimento e armas CBRN |

Principais conclusões

- Proibição explícita a assistência em armas CBRN e explosivos de alto rendimento.

- Nova seção de cibersegurança proíbe descoberta de vulnerabilidades, criação de malware e ferramentas de DDoS.

- Proteções AI Safety Level 3 com Claude Opus 4 visam reduzir jailbreaks e limitar assistência em CBRN.

- Recursos agentivos como Computer Use e Claude Code são destacados como riscos e sujeitos a salvaguardas.

- Política política foi ajustada para focar em usos enganosos, disruptivos ou de direcionamento de eleitores; requisitos de alto risco são para cenários de consumidor.

FAQ

Referências

- Cobertura da atualização de política da Anthropic: The Verge

More news

Build a scalable containerized web application on AWS using the MERN stack with Amazon Q Developer – Part 1

In a traditional SDLC, a lot of time is spent in the different phases researching approaches that can deliver on requirements: iterating over design changes, writing, testing and reviewing code, and configuring infrastructure. In this post, you learned about the experience and saw productivity gains

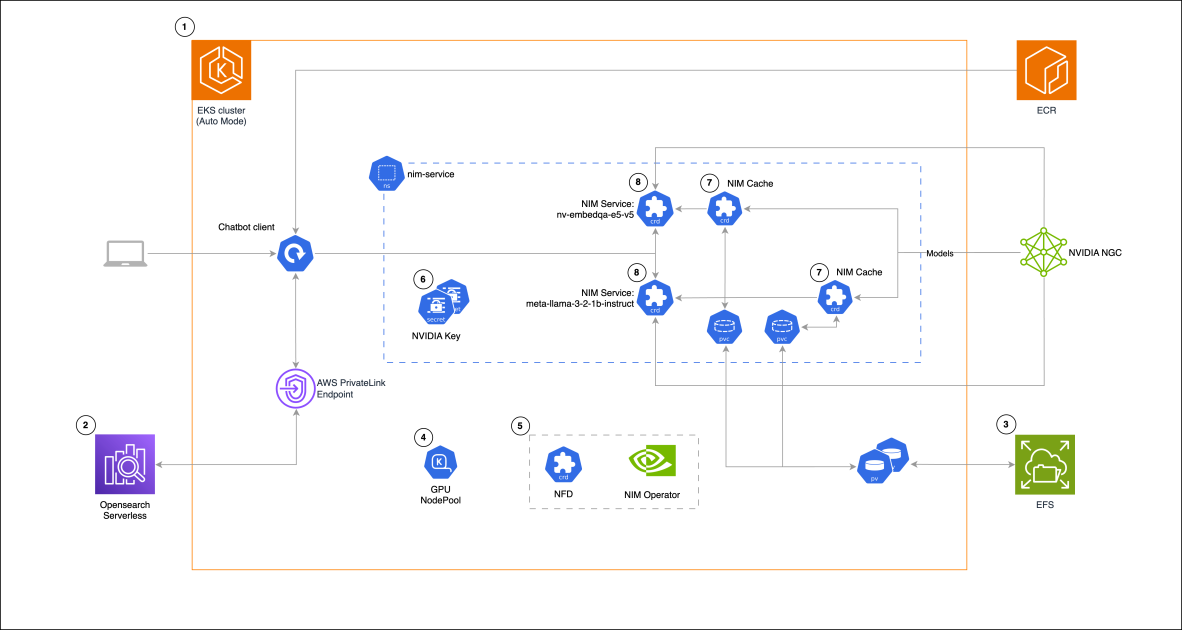

Building a RAG chat-based assistant on Amazon EKS Auto Mode and NVIDIA NIMs

In this post, we demonstrate the implementation of a practical RAG chat-based assistant using a comprehensive stack of modern technologies. The solution uses NVIDIA NIMs for both LLM inference and text embedding services, with the NIM Operator handling their deployment and management. The architectu

GPT-5 não atingiu as expectativas de hype, mas trouxe ganhos em custo, velocidade e código

O lançamento do GPT-5 gerou reações mistas: avanços incrementais em benchmarks, redução de custos e latência, desempenho em programação melhor, mas críticas ao tom da escrita e a erros inesperados.

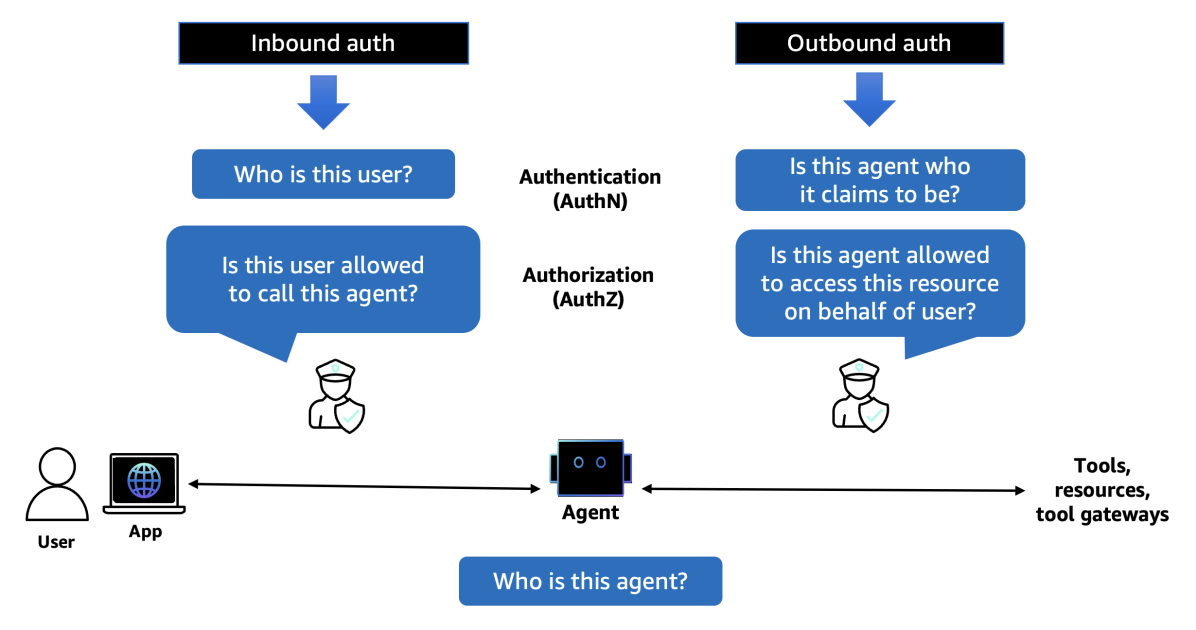

Introducing Amazon Bedrock AgentCore Identity: Securing agentic AI at scale

In this post, we explore Amazon Bedrock AgentCore Identity, a comprehensive identity and access management service purpose-built for AI agents that enables secure access to AWS resources and third-party tools. The service provides robust identity management features including agent identity director

Introducing Amazon Bedrock AgentCore Gateway: Transforming enterprise AI agent tool development

In this post, we discuss Amazon Bedrock AgentCore Gateway, a fully managed service that revolutionizes how enterprises connect AI agents with tools and services by providing a centralized tool server with unified interface for agent-tool communication. The service offers key capabilities including S

Sam Altman diz ‘sim’, há uma bolha em IA — o que ele falou à The Verge

O CEO da OpenAI, Sam Altman, disse à The Verge que acredita estar havendo uma bolha em IA, comparou ao estouro das empresas ponto.com e previu gastos massivos com data centers.