Dynamo 0.4 entrega 4x mais desempenho, autoscaling baseado em SLO e observabilidade em tempo real

Sources: https://developer.nvidia.com/blog/dynamo-0-4-delivers-4x-faster-performance-slo-based-autoscaling-and-real-time-observability, developer.nvidia.com

TL;DR

- Dynamo 0.4 oferece até 4x mais interatividade (tokens/segundo/usuário) para o modelo gpt-oss-120b usando Dynamo e TensorRT-LLM no NVIDIA B200, permitindo fluxos de trabalho mais rápidos sem comprometer a taxa de transferência [source].

- DeepSeek-R1 671B com TensorRT-LLM e Dynamo atinge cerca de 2,5x maisThroughput (tokens/segundo/GPU) sem aumentar os custos de inferência em NVIDIA GB200 NVL72.

- Atendimento disagregado divide as fases de prefill e decode entre GPUs distintas, aumentando a eficiência e a flexibilidade na paralelização de modelos.

- AIConfigurator, nova ferramenta, recomenda configurações ideais de PD disaggregation e estratégias de paralelismo de modelo com base no modelo e no orçamento de GPU, respeitando SLOs.

- Planner com autos scaling baseado em SLO, integração nativa com Kubernetes e observabilidade aprimorada permitem dimensionamento confiável e custo-efetivo com insights em tempo real.

- Melhorias de tolerância a falhas reduzem trabalho desperdiçado com redirecionamento de requisições em voo e detecção de falhas mais rápida, fortalecendo ambientes multi-nó.

- Recursos para pesquisadores e equipes: scripts de código aberto para reproduzir resultados, guias de implantação para ambientes multi-nó e suporte inicial para TensorRT-LLM no Hopper. Fonte: Dynamo 0.4 release notes.

Contexto e antecedentes

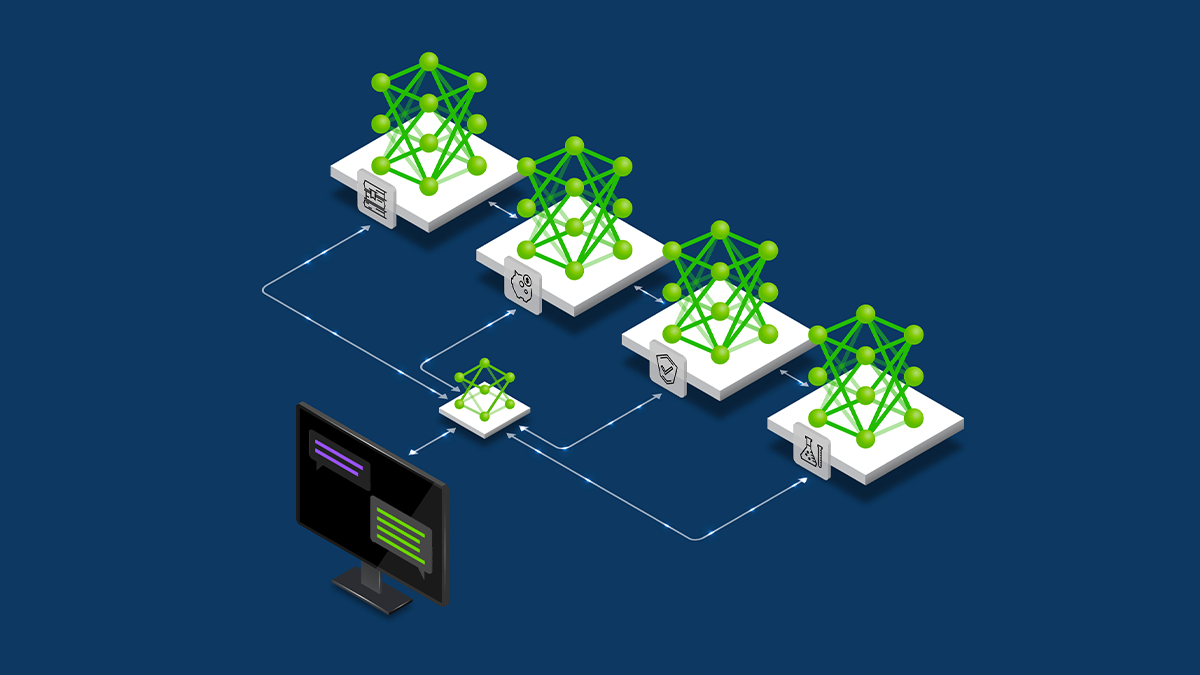

O Dynamo 0.4 foca em workloads de IA de fronteira que utilizam modelos grandes e arquiteturas de atendimento disagregado em centenas de GPUs. Ao priorizar desempenho, observabilidade e autos scaling com base em SLOs, o Dynamo 0.4 pretende tornar viável implantar modelos extremamente grandes com custo menor. O release enfatiza o atendimento disagregado, que separa as fases de prefill e decode para otimizar a alocação de recursos e a paralelização do modelo. O pacote também apresenta ferramentas para estimar ganhos de throughput, configurar GPUs e atender objetivos de serviço. A liberação enfatiza a importância de observabilidade para ambientes de inferência distribuídos, com métricas disponíveis via Prometheus, prontas para uso em Grafana e outras ferramentas de monitoramento de código aberto. O projeto também aponta para suporte inicial de TensorRT-LLM no Hopper, com planos de ampliar frameworks e hardware no futuro.

O que há de novo

- Atendimento disagregado entre prefill e decode em GPUs distintas, possibilitando alocações mais flexíveis e maior eficiência.

- AIConfigurator, ferramenta que recomenda configurações ótimas de PD disaggregation e paralelismo de modelo com base no modelo e no orçamento de GPU, respeitando SLOs.

- Planner com autos scaling baseado em SLO, integrando-se nativamente ao Kubernetes para facilitar a implantação em ambientes conteinerizados.

- Melhorias de observabilidade: métricas importantes emitidas por componentes do Dynamo via Prometheus, prontas para uso em Grafana; API para métricas personalizadas.

- Tolerância a falhas: redirecionamento de requisições em voo para GPUs online, preservando computations intermediárias; detecção de falhas mais rápida ao contornar etcd em certos sinais de saúde.

- Esforços para workloads de fronteira (MoE) e deployments multi-nó com maior resiliência, além de guias e scripts para pesquisadores.

- Suporte inicial para TensorRT-LLM no NVIDIA Hopper e planos de ampliar frameworks/hardware.

Por que isso importa (impacto para desenvolvedores/empresas)

- Escala e custo: o atendimento disagregado sustenta alto throughput para sequências muito longas, otimizando o uso de GPUs, reduzindo desperdício e custos de inferência.

- Confiabilidade em larga escala: autos scaling preditivo baseado em SLO ajuda a cumprir metas de latência em cargas diversas, desde geração de código até resumo de documentos longos.

- Observabilidade e controle: métricas integradas e API de telemetria permitem diagnosticar gargalos, validar desempenho frente a SLOs e ajustar configurações em tempo real.

- Produtividade do desenvolvedor: integração nativa com Kubernetes e recomendações automatizadas do AIConfigurator facilitam a implantação de pipelines de inferência de modelos grandes em produção.

- Ecossistema em movimento: scripts abertos, guias de implantação e referências a práticas de disaggregation encorajam adoção mais ampla.

Detalhes técnicos ou Implementação

Dynamo 0.4 avança o atendimento disagregado ao separar o prefill e o decode e distribuí-los entre GPUs distintas. Essa separação permite alocações mais flexíveis por fase e suporta paralelismo de modelo mais avançado, melhorando a eficiência para modelos grandes como gpt-oss-120b e DeepSeek-R1 671B. Para o gpt-oss-120b, executando com Dynamo e TensorRT-LLM no B200, obtém-se até 4x de ganho de interatividade (tokens/segundo) sem perder throughput. Para o DeepSeek-R1 671B, a combinação Dynamo + TensorRT-LLM + NVL72 atinge aproximadamente 2,5x mais throughput (tokens/segundo/GPU) sem custos adicionais de inferência. A AIConfigurator, nova ferramenta, utiliza dados de desempenho previamente medidos em várias camadas do modelo (atenção, FFN, comunicação, memória) e opções de agendamento (batching estático, batching em voo, atendimento disagregado). Ela modela diferentes configurações sob um orçamento de GPU e SLOs, recomendando configurações de disaggregation e estratégias de paralelismo que maximizam o throughput por GPU. O AIConfigurator vem com CLI e interface web, com suporte inicial para TensorRT-LLM no Hopper; suporte adicional para outros frameworks e hardware está por vir. O Planner, apresentado na Release 0.2, foi estendido para incluir autos scaling baseado em SLO. Ele monitora a fila de prefill e o uso de memória de decode para escalar trabalhadores de inferência, maximizando utilização de GPU e minimizando custos. O Planner integra-se nativamente ao Kubernetes, facilitando a implantação de Dynamo e o dimensionamento de workloads de IA. O suporte para vLLM está presente, com planos para adicionar mais frameworks no futuro. Observabilidade é um pilar da liberação 0.4. Métricas-chave são emitidas por trabalhadores e componentes do Dynamo por meio do toolkit Prometheus, prontas para consumo em Grafana e outras ferramentas abertas, sem personalização pesada. A API para métricas personalizadas oferece ainda mais flexibilidade para atender a necessidades específicas de time. Esse alicerce de observabilidade prepara o terreno para métricas mais granulares ligadas à disaggregation no futuro. Para ambientes com centenas de GPUs, Dynamo 0.4 introduz tolerância a falhas: re-routing de requisições em voo para GPUs online preserva o trabalho intermediário e evita retrabalho, reduzindo latência. A detecção de falhas também é mais rápida, com o router inteligente capaz de contornar etcd em sinais críticos de saúde, reduzindo a janela entre detecção e recuperação. Para pesquisadores e equipes, Dynamo 0.4 disponibiliza scripts abertos para reproduzir resultados e guias de implantação para ambientes multi-nó com DeepSeek-R1 e outros modelos usando Dynamo. Há demonstrações e recursos de office-hours para auxiliar na compreensão de conceitos de disaggregation e medição de ganhos de throughput.

Principais conclusões

- O atendimento disagregado é central no Dynamo 0.4, permitindo alocações de GPU separadas para prefill e decode e paralelismo de modelo mais eficiente.

- AIConfigurator automatiza recomendações de PD disaggregation e estratégias de paralelismo para atender SLOs dentro de um orçamento de GPU.

- Planner com autos scaling baseado em SLO oferece dimensionamento proativo com integração nativa ao Kubernetes.

- Observabilidade aprimorada com métricas Prometheus e API de telemetria facilita otimização em tempo real.

- Melhorias de tolerância a falhas reduzem trabalho desperdiçado com redirecionamento em voo e detecção mais rápida de falhas.

- Scripts abertos e guias de implantação aceleram a adoção pela comunidade.

FAQ

-

O que é atendimento disagregado no Dynamo 0.4?

Ele divide prefill e decode entre GPUs diferentes, possibilitando alocações mais flexíveis e paralelismo de modelo aprimorado.

-

O que faz o autos scaling baseado em SLO?

Ele antecipa impactos de comprimentos de sequências de entrada/saída e escala recursos antes que ocorram gargalos, para cumprir TTFT e ITL.

-

uais ferramentas auxiliam implantação e otimização?

IConfigurator para recomendações de configuração e Planner para autos scaling, com integração a Kubernetes e API para métricas personalizadas.

-

uais modelos e hardware foram demonstrados?

Demonstrações com gpt-oss-120b no NVIDIA B200 (4x mais rápido) e DeepSeek-R1 671B no NVL72 (2,5x mais throughput); TensorRT-LLM é a chave da integração.

-

Onde posso encontrar recursos para reproduzir os resultados?

NVIDIA fornece scripts de código aberto e guias de implantação; os links do repositório estão mencionados nas notas da liberação.

Referências

More news

NVIDIA HGX B200 reduz a Intensidade de Emissões de Carbono Incorporado

O HGX B200 da NVIDIA reduz 24% da intensidade de carbono incorporado em relação ao HGX H100, ao mesmo tempo em que aumenta o desempenho de IA e a eficiência energética. Esta análise resume os dados de PCF e as novidades de hardware.

Scaleway Como Novo Fornecedor de Inferência no Hugging Face para Inferência serverless de Baixa Latência

A Scaleway é agora um Fornecedor de Inferência compatível no Hugging Face Hub, permitindo inferência serverless diretamente nas páginas de modelo com as SDKs JS e Python. Acesse modelos abertos populares com operações escaláveis e baixa latência.

Prever Eventos Climáticos Extremos em Minutos sem Supercomputador com Huge Ensembles (HENS)

NVIDIA e o Lawrence Berkeley National Laboratory apresentam Huge Ensembles (HENS), uma ferramenta de IA de código aberto que prevê eventos climáticos raros e de alto impacto usando 27.000 anos de dados, com opções de código aberto ou prontos para uso.

Playbook dos Grandmasters do Kaggle: 7 Técnicas de Modelagem Testadas para Dados Tabulares

Análise detalhada de sete técnicas testadas por Grandmasters do Kaggle para resolver grandes conjuntos de dados tabulares com aceleração por GPU, desde baselines diversificados até ensemble avançado e pseudo-rotulagem.

Como reduzir gargalos do KV Cache com NVIDIA Dynamo

O Dynamo da NVIDIA transfere o KV Cache da memória da GPU para armazenamento de custo mais baixo, permitindo janelas de contexto maiores, maior concorrência e menor custo de inferência em grandes modelos.

Microsoft transforma site da Foxconn no data center Fairwater AI, considerado o mais poderoso do mundo

A Microsoft divulga planos para um data center Fairwater AI de 1,2 milhão de pés quadrados no Wisconsin, com centenas de milhares de GPUs Nvidia GB200. projeto de US$ 3,3 bilhões promete treinamento de IA em escala sem precedentes.