Maximize o Desempenho em Robótica com o Cosmos Reason da NVIDIA após o Treinamento

Sources: https://developer.nvidia.com/blog/maximize-robotics-performance-by-post-training-nvidia-cosmos-reason, developer.nvidia.com

TL;DR

- Primeira apresentação no NVIDIA GTC 2025, o NVIDIA Cosmos Reason é um modelo de raciocínio visão-language (VLM) aberto e totalmente personalizável para IA física e robótica NVIDIA blog.

- O sistema transforma vídeo e prompts de texto em tokens por meio de um codificador de visão e de um tradutor chamado projector, processando esses tokens por um núcleo que combina vários módulos de LLM.

- Fine-tuning em tarefas de IA física aumenta o desempenho base em mais de 10%, com aprendizado por reforço somando cerca de 5% adicionais, atingindo uma pontuação média de 65,7 em benchmarks de robótica e veículos autônomos.

- Desenvolvedores podem baixar pontos de verificação no Hugging Face e acessar scripts de inferência e pós-treinamento no GitHub; a implantação suporta Docker e pipelines edge-to-cloud em GPUs NVIDIA.

- Cosmos Reason utiliza raciocínio em cadeia de pensamento para compreender dinâmicas do mundo sem anotações humanas, permitindo raciocínio com conhecimento prévio, física e senso comum.

Contexto e antecedentes

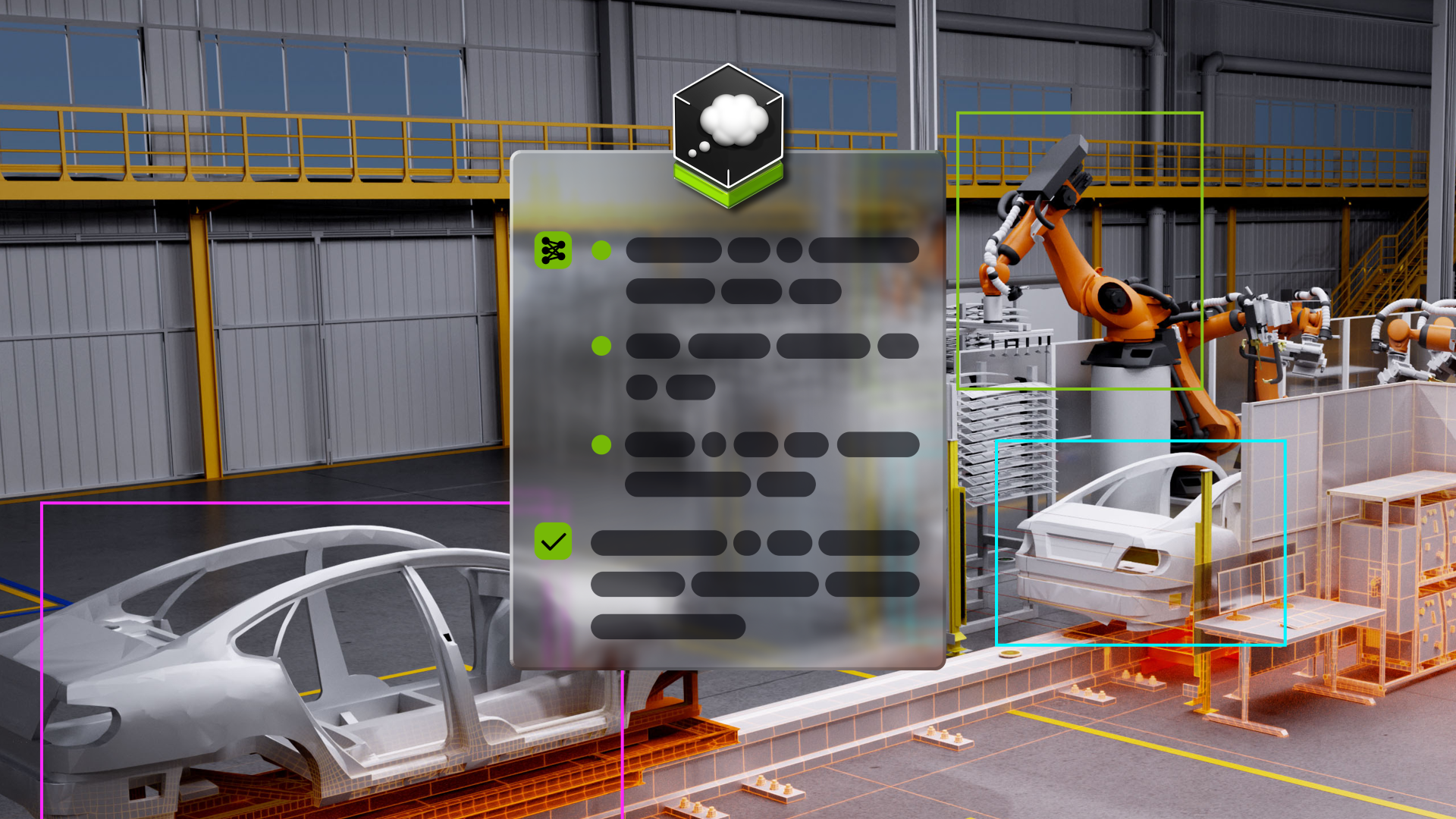

A NVIDIA apresenta o Cosmos Reason como um VLM de raciocínio aberto e totalmente personalizável, desenvolvido para IA física e robótica. O sistema é projetado para permitir que robôs e agentes de visão aprendam a raciocinar usando conhecimento prévio, compreensão da física e senso comum para entender e agir no mundo real. O Cosmos Reason lidera a lista de raciocínio físico no Hugging Face, destacando sua capacidade de raciocínio sobre dinâmicas do mundo real. O fluxo de trabalho começa com entrada de vídeo e texto; o vídeo é tokenizado por um codificador de visão, com um tradutor chamado projector convertendo esses tokens para um formato utilizável pelo núcleo do modelo. O núcleo utiliza um mix de módulos de LLM e técnicas para raciocinar. A abordagem enfatiza raciocínio passo a passo para guiar ações em cenários reais. O projeto utiliza refinamento supervisionado e aprendizado por reforço para conectar percepção multimodal e tomada de decisão no mundo real, além de aproveitar capacidades de cadeia de pensamento para entender dinâmicas sem anotações humanas.

O que há de novo

O Cosmos Reason traz várias inovações para desenvolvedores e empresas:

- Melhorias de treinamento: refinamento supervisionado (SFT) aumenta o desempenho da base em mais de 10%, e o aprendizado por reforço acrescenta cerca de 5%, resultando em uma pontuação média de 65,7 em benchmarks de robótica e veículos autônomos.

- Acesso e recursos: Pontos de verificação podem ser baixados no Hugging Face e scripts de inferência/pós-treinamento estão disponíveis no GitHub, facilitando implantação prática.

- Entrada flexível e prompts: o modelo aceita vídeos com diferentes resoluções e taxas de quadro, guiado por um prompt de texto que especifica a intenção do desenvolvedor (por exemplo, uma pergunta ou explicação) para orientar o raciocínio e as respostas. Um modelo de aprimoramento de prompts está disponível para melhorar a qualidade dos prompts.

- Implantação e hardware: Cosmos Reason é otimizado para GPUs NVIDIA e pode ser executado em Docker ou nativo. Para pipelines de visão, funciona do edge à nuvem em GPUs como NVIDIA DGX Spark, RTX Pro 6000, H100 Tensor Core ou Blackwell GB200 NVL72 no NVIDIA DGX Cloud.

- Recursos: Além dos pontos de verificação e scripts, os desenvolvedores podem consultar a documentação do Cosmos para tutoriais, detalhes de implementação e casos de uso práticos. O projeto também encoraja acompanhar as novidades da NVIDIA e participar de fóruns.

- Aplicações em robótica: o sistema é voltado para tarefas de IA física, incluindo cenários de resposta visual com robótica demonstrados usando datasets como robovqa.

Por que isso importa (impacto para desenvolvedores/empresas)

O Cosmos Reason representa um esforço para ligar percepção e tomada de decisão no mundo real em robótica e IA física. Ao combinar compreensão de vídeo com prompts baseados em linguagem e um núcleo de LLM modular, ele permite que agentes raciocinem sobre dinâmicas do mundo com menos dependência de anotações humanas, usando capacidades de cadeia de pensamento para raciocinar passo a passo. A natureza aberta do modelo — com pontos de verificação disponíveis no Hugging Face e recursos de pós-treinamento no GitHub — facilita a personalização, ajuste fino e integração de raciocínio avançado em pipelines de robótica. A otimização para GPUs NVIDIA e o suporte a Docker tornam-no adequado tanto para implantação em borda quanto para operações em nuvem em aplicações de robótica de escala. Para empresas, o Cosmos Reason oferece um caminho para prototipagem mais rápida, tomada de decisão mais capaz em IA física e potencial melhoria de desempenho por meio de ajuste fino direcionado e aprendizado por reforço.

Detalhes técnicos ou Implementação

Em alto nível, o Cosmos Reason adota uma arquitetura de raciocínio multimodal:

- Pipeline vídeo-para-token: um codificador de visão converte frames de vídeo em tokens, com um tradutor chamado projector convertendo esses tokens para um formato utilizável pelo núcleo do modelo. O sistema então funde os tokens de vídeo com o prompt de texto.

- Núcleo de raciocínio com módulos de LLM: o núcleo utiliza um mix de módulos de grandes modelos de linguagem e técnicas para raciocinar. O objetivo é pensar passo a passo e fornecer respostas detalhadas e lógicas, apoiando raciocínio em cadeia de pensamento para entender dinâmicas do mundo.

- Treinamento: refinamento supervisionado para aproximar percepção multimodal de tomada de decisão no mundo real, complementado por aprendizado por reforço para alinhar o comportamento com tarefas de IA física.

- Ganhos de desempenho: o refinamento específico para tarefas de IA física aumenta o desempenho da base em >10%, com o RL contribuindo com ~5% adicionais, resultando na métrica de 65,7 em benchmarks relevantes.

- Processamento de prompts e inferência: o modelo lida com prompts de qualidade variável e utiliza um modelo de aprimoramento de prompts para melhorar a qualidade da entrada. A implantação é compatível com Docker e ambientes nativos, com suporte a pipelines edge-to-cloud para visão.

- Acesso e implantação: pontos de verificação disponíveis no Hugging Face, com scripts de inferência e recursos de pós-treinamento no GitHub. O Cosmos Reason é otimizado para GPUs NVIDIA e funciona em plataformas que vão do edge à nuvem, incluindo DGX Spark, RTX Pro 6000, H100 Tensor Core e Blackwell GB200 NVL72 no DGX Cloud.

- Caso de uso: o texto menciona exemplos de aplicação robótica e VQA robótico, com referências como robovqa para demonstrar ganhos em tarefas específicas.

Dados-chave em resumo

| Componente | Descrição |

|---|---|

| Conversão vídeo-para-token | Codificador de visão mais projector para tokens |

| Núcleo de raciocínio | Módulos de LLM com cadeia de pensamento |

| Treinamento | SFT >10%, RL ~+5% |

| Desempenho | 65,7 média em robótica/VE benchmarks |

| Implantação | Docker ou nativo; edge-to-cloud |

| Acesso | Hugging Face e GitHub |

Principais lições

- Cosmos Reason une compreensão de vídeo com raciocínio baseado em linguagem para atuar no mundo real.

- Melhorias de treinamento pós-treinamento, incluindo refinamento supervisionado e RL, geram ganhos mensuráveis em tarefas de IA física.

- O acesso aos recursos por meio do Hugging Face e do GitHub facilita personalização, ajuste fino e integração em pipelines de robótica.

- O design otimizado para GPUs NVIDIA e o suporte a operações de borda a nuvem o tornam adequado para aplicações de robótica em escala.

FAQ

-

O que é NVIDIA Cosmos Reason e por que é significativo?

É um VLM de raciocínio aberto e totalmente personalizável para IA física e robótica, projetado para raciocinar com conhecimento prévio, física e senso comum. Foi apresentado pela primeira vez no GTC 2025 e lidera uma lista de raciocínio físico no Hugging Face.

-

Como Cosmos Reason processa vídeo e prompts de texto?

Transforma vídeo em tokens usando um codificador de visão e um projector, depois combina esses tokens com o prompt de texto antes de enviá-los ao núcleo do modelo, que utiliza módulos de LLM para raciocínio.

-

uais melhorias vêm com o fine-tuning e o aprendizado por reforço?

Fine-tuning supera 10% de melhoria e o RL acrescenta cerca de 5%, resultando em média 65,7 em benchmarks de robótica/VE.

-

Como os desenvolvedores acessam o modelo e executam?

Pontos de verificação estão no Hugging Face, scripts de inferência e recursos de pós-treinamento no GitHub; pode ser executado em Docker ou nativo.

-

Em que hardware e plataformas de nuvem Cosmos Reason funciona?

Otimizado para GPUs NVIDIA e suporta edge-to-cloud em GPUs como DGX Spark, RTX Pro 6000, H100 Tensor Core e Blackwell GB200 NVL72 no DGX Cloud.

Referências

More news

NVIDIA HGX B200 reduz a Intensidade de Emissões de Carbono Incorporado

O HGX B200 da NVIDIA reduz 24% da intensidade de carbono incorporado em relação ao HGX H100, ao mesmo tempo em que aumenta o desempenho de IA e a eficiência energética. Esta análise resume os dados de PCF e as novidades de hardware.

Prever Eventos Climáticos Extremos em Minutos sem Supercomputador com Huge Ensembles (HENS)

NVIDIA e o Lawrence Berkeley National Laboratory apresentam Huge Ensembles (HENS), uma ferramenta de IA de código aberto que prevê eventos climáticos raros e de alto impacto usando 27.000 anos de dados, com opções de código aberto ou prontos para uso.

Playbook dos Grandmasters do Kaggle: 7 Técnicas de Modelagem Testadas para Dados Tabulares

Análise detalhada de sete técnicas testadas por Grandmasters do Kaggle para resolver grandes conjuntos de dados tabulares com aceleração por GPU, desde baselines diversificados até ensemble avançado e pseudo-rotulagem.

Como reduzir gargalos do KV Cache com NVIDIA Dynamo

O Dynamo da NVIDIA transfere o KV Cache da memória da GPU para armazenamento de custo mais baixo, permitindo janelas de contexto maiores, maior concorrência e menor custo de inferência em grandes modelos.

Microsoft transforma site da Foxconn no data center Fairwater AI, considerado o mais poderoso do mundo

A Microsoft divulga planos para um data center Fairwater AI de 1,2 milhão de pés quadrados no Wisconsin, com centenas de milhares de GPUs Nvidia GB200. projeto de US$ 3,3 bilhões promete treinamento de IA em escala sem precedentes.

NVIDIA RAPIDS 25.08 Adiciona Novo Profiler para cuML, Melhorias no Motor GPU Polars e Suporte Ampliado de Algoritmos

RAPIDS 25.08 traz profiladores function-level e line-level para cuml.accel, executor streaming padrão no motor GPU Polars, suporte ampliado de tipos e strings, novo Spectral Embedding no cuML e acelerações com zero código para mais algoritmos.