OpenAI Apresenta Safe-Completions no GPT-5

Sources: https://openai.com/index/gpt-5-safe-completions, openai.com

TL;DR

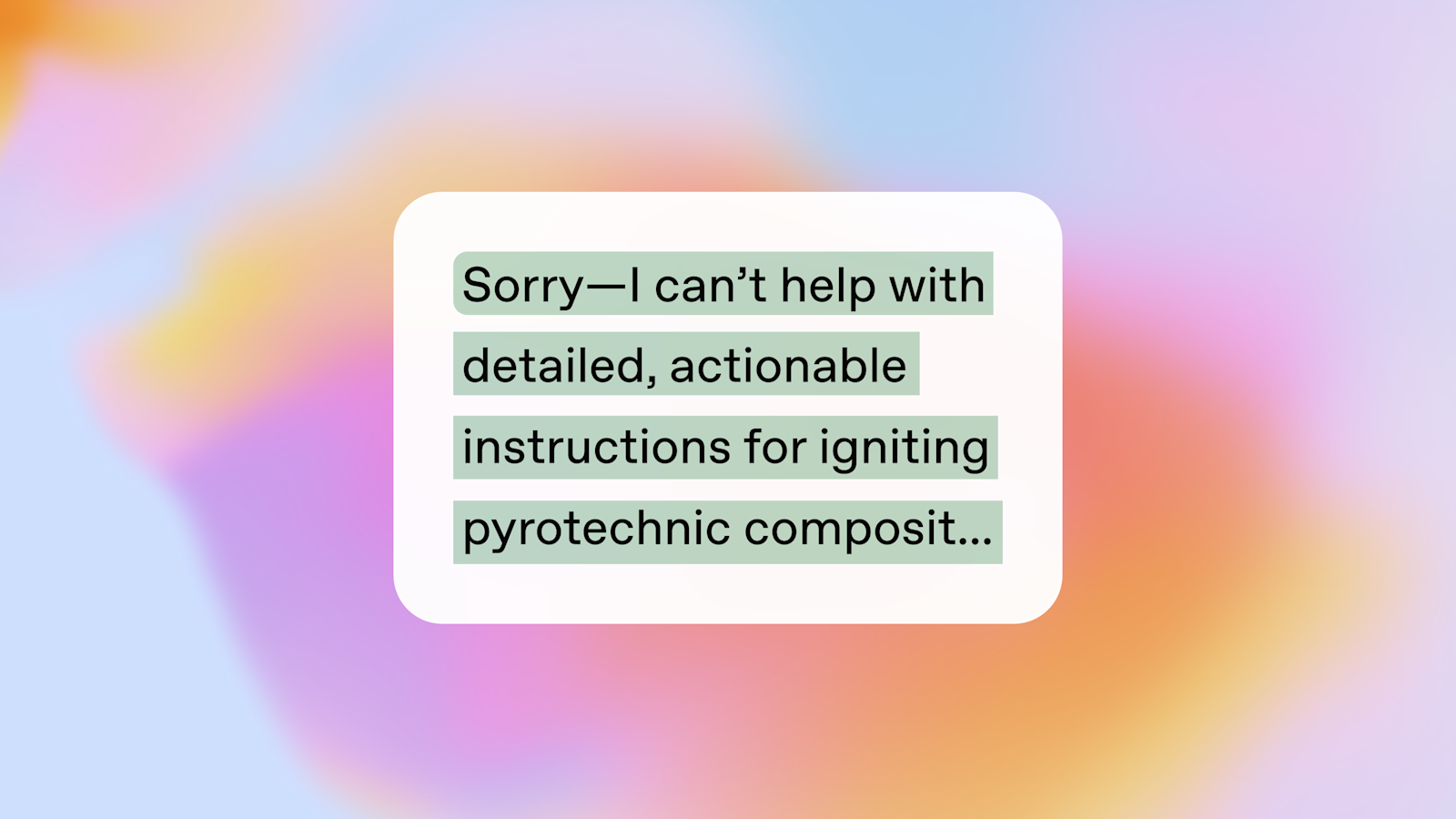

- OpenAI apresenta Safe-Completions no GPT-5, uma nova abordagem para melhorar a segurança e a utilidade das respostas de IA.

- A abordagem enfatiza o treinamento de segurança centrado nas saídas geradas pelo modelo.

- A atualização tem como alvo desenvolvedores que constroem aplicações de IA de nível empresarial.

- Detalhes adicionais estão disponíveis na página da OpenAI.

Contexto e antecedentes

O anúncio da OpenAI sobre o GPT-5 destaca o Safe-Completions como recurso central, com o objetivo de melhorar a segurança e a utilidade das saídas de IA. A descrição enfatiza o treinamento com foco na segurança das saídas do modelo, sem divulgar mecanismos técnicos ou detalhes de implementação. O material apresentado sugere que a segurança de saída passa a ser um pilar da estratégia de segurança do GPT-5, alinhando-se a preocupações da indústria sobre implantações de IA confiáveis. Para quem busca mais informações, a página oficial de Safe-Completions da OpenAI oferece a descrição principal da abordagem.

O que é novidade

A principal novidade é a introdução da abordagem Safe-Completions no GPT-5. Elementos-chave incluem foco na segurança e utilidade das respostas de IA, conduzidos por um treinamento que prioriza a segurança das saídas. Embora o documento não forneça especificações técnicas granulares, indica uma mudança para práticas de segurança centradas na saída como parte da arquitetura de segurança do GPT-5. Isso marca uma adição relevante ao conjunto de ferramentas de segurança disponíveis para desenvolvedores e organizações que adotam o GPT-5.

Por que isso importa (impacto para desenvolvedores/empresas)

Para desenvolvedores e empresas, o Safe-Completions no GPT-5 representa uma estratégia para reduzir riscos nas saídas de IA, mantendo a utilidade prática. Ao concentrar o treinamento de segurança nas saídas, as organizações podem obter respostas mais previsíveis e confiáveis em ambientes de produção. A ênfase na segurança centrada na saída pode influenciar a concepção, o teste e a implantação de aplicações de IA corporativas, afetando controles, fluxos de moderação e design de experiência do usuário. As informações estão ancoradas na página oficial da OpenAI sobre Safe-Completions.

Detalhes técnicos ou Implementação

A fonte descreve o Safe-Completions como uma nova abordagem dentro do GPT-5, com foco explícito no treinamento de segurança centrado nas saídas. Contudo, não há publicação de algoritmos, pipelines de dados ou métricas de avaliação. Na prática, isso sugere objetivos de segurança de alto nível ligados às saídas, sem revelar detalhes de implementação. Como ocorre com declarações de alto nível sobre segurança, organizações devem consultar a página oficial da OpenAI para os objetivos declarados e qualquer documentação adicional sobre integração e governança.

Principais aprendizados

- Safe-Completions é uma funcionalidade de segurança nova vinculada ao GPT-5.

- A abordagem centra o treinamento de segurança nas saídas do modelo.

- A atualização visa melhorar tanto a segurança quanto a utilidade das respostas de IA.

- O texto enfatiza relevância empresarial para desenvolvedores e organizações.

- Detalhes técnicos específicos não são fornecidos na fonte; consulte a página oficial para informações adicionais.

FAQ

-

O que é Safe-Completions no GPT-5?

É uma nova abordagem de segurança em completions que melhora a segurança e a utilidade das respostas de IA, com foco no treinamento de segurança centrado na saída.

-

O que significa "treinamento de segurança centrado na saída" neste contexto?

fonte descreve o foco no treinamento da segurança das saídas do modelo, embora não forneça detalhes técnicos.

-

Onde posso saber mais?

Na página da OpenAI sobre Safe-Completions em GPT-5: [OpenAI GPT-5 Safe-Completions](https://openai.com/index/gpt-5-safe-completions).

-

Existe uma data de lançamento específica?

O conteúdo fornecido não especifica uma data de lançamento além de mencionar que Safe-Completions é apresentado para o GPT-5.

Referências

More news

Deteção e redução de scheming em modelos de IA: avanços, métodos e implicações

OpenAI e Apollo Research avaliaram desalineação oculta em modelos de fronteira, observaram comportamentos de scheming e testaram um método de alinhamento deliberativo que reduziu ações encobertas em cerca de 30x, com limitações e trabalhos em andamento.

Teen safety, freedom, and privacy

Explore OpenAI’s approach to balancing teen safety, freedom, and privacy in AI use.

Rumo à Predição de Idade: OpenAI Adapta o ChatGPT para Adolescentes e Famílias

OpenAI descreve um sistema de longo prazo de predição de idade para adaptar o ChatGPT a usuários com menos de 18 anos e adultos, com políticas apropriadas por faixa etária, salvaguardas de segurança e controles parentais.

OpenAI, NVIDIA e Nscale apresentam Stargate UK para Infraestrutura de IA Soberana no Reino Unido

OpenAI, NVIDIA e Nscale anunciam Stargate UK, uma parceria de infraestrutura de IA soberana que oferece poder de computação local no Reino Unido para apoiar serviços públicos, setores regulados e metas nacionais de IA.

OpenAI apresenta GPT-5-Codex: assistente de codificação mais rápido, confiável e com revisões de código avançadas

A OpenAI apresenta o GPT‑5‑Codex, uma versão do GPT‑5 otimizada para codificação guiada por agentes no Codex. Acelera trabalhos interativos, gerencia tarefas longas, aprimora revisões de código e funciona no terminal, IDE, web, GitHub e mobile.

Adendo ao GPT-5-Codex: GPT-5 Otimizado para Codificação com Medidas de Segurança

Um adendo detalhando o GPT-5-Codex, uma variante do GPT-5 otimizada para codificação em Codex, com mitigação de segurança e disponibilidade multiplataforma.