TimeScope: Benchmark de Compreensão de Vídeos Longos em Modelos Visão+Linguagem

Sources: https://huggingface.co/blog/timescope-video-lmm-benchmark, Hugging Face Blog

TL;DR

- TimeScope é um benchmark de código aberto que testa modelos visão-linguagem em vídeos longos (1 minuto a 8 horas) com a inserção de needles curtas.

- Vai além da recuperação, avaliando síntese, localização e análise de movimento fino em três tipos de needles.

- Em modelos testados, vídeos mais longos revelam quedas de desempenho; apenas aumentar o tamanho do modelo não garante compreensão temporal mais longa.

- Gemini 2.5-Pro se destaca mais em vídeos acima de uma hora, enquanto outros modelos tendem a estabilizar em um comprimento de contexto similar.

- O benchmark é aberto e pode ser explorado na Hugging Face.

Contexto e antecedentes

Nos últimos anos, a IA multimodal tem apresentado promessas de entender vídeos excepcionalmente longos, espelhando o avanço de modelos de contexto longo em linguagem. Contudo, avaliar se tais promessas são reais não é trivial. Benchmarks de vídeo anteriores muitas vezes dependem de imagens isoladas “needle” inseridas nos vídeos, o que mede busca visual mais do que compreensão temporal real. Esse tipo de configuração tende a favorecer recuperação superficial e pode ocultar fraquezas na compreensão de sequências temporais extensas. Estudos em benchmarks de texto, como HELM e RULER, mostraram a fragilidade de capacidades de contexto longo quando tarefas exigem raciocínio ou agregação. No domínio de vídeo, esse desafio é ainda maior, já que muitos modelos são treinados com janelas temporais limitadas e, mesmo assim, relatam capacidades amplas. Nesse cenário, TimeScope surge como um esforço específico para quantificar o quão bem os sistemas multimodais processam narrativas de vídeo ao longo do tempo.

O que há de novo

TimeScope é um benchmark de código aberto hospedado na Hugging Face. Ele avalia a compreensão de vídeos longos inserindo várias needles curtas (aprox. 5–10 segundos) em vídeos de base, que vão de 1 minuto a 8 horas. As needles carregam as informações-chave necessárias para resolver a tarefa, forçando os modelos a processar o input completo sem depender de amostragem esparsa. O benchmark utiliza três tipos de needles, cada um desenhado para testar um aspecto diferente da compreensão de vídeos longos:

- Recuperação localizada e compreensão de eventos: perguntas que podem ser respondidas ao selecionar um frame relevante da needle, testando a capacidade de localizar e interpretar um evento específico dentro do vídeo maior.

- Síntese de informações e extração de texto disperso: needles baseadas em texto embedadas em momentos distintos exigem que o modelo identifique todas as palavras e as apresente em ordem cronológica, simulando tarefas como reconstruir uma linha do tempo ou listar fatos-chave com ordenação correta.

- Percepção de movimento temporal: para perguntas sobre movimento ou sequência dentro de uma needle, o modelo precisa acompanhar a dinâmica entre frames para determinar a resposta correta. TimeScope também analisa como o desempenho muda com o comprimento do vídeo de base. Nos resultados iniciais, observou-se um padrão: o desempenho tende a cair conforme o haystack aumenta, indicando que a compreensão temporal de longo alcance continua desafiadora mesmo para modelos fortes. Avaliações foram feitas em uma gama de modelos de visão-linguagem, incluindo opções de código aberto e grandes modelos, como o Gemini 2.5-Pro. Os resultados destacam tanto o potencial quanto os limites atuais da compreensão de vídeos longos, apontando a necessidade de estratégias de treinamento mais direcionadas e avaliações robustas de tempo.

Por que isso importa (impacto para desenvolvedores/empresas)

A capacidade de raciocinar sobre horas de vídeo abre possibilidades transformadoras: agentes autônomos poderiam resumir longas gravações, detectar anomalias sutis ao longo de operações prolongadas e responder perguntas sobre narrativas extendidas. Em robótica, análises de longa duração podem sustentar tomada de decisão em tempo real durante tarefas prolongadas. Aplicações de consumo podem ter assistentes pessoais com feedback contínuo e contexto ao longo do dia. Ainda assim, TimeScope oferece um lembrete importante: promessas de compreensão de vídeos por horas ainda não são amplamente verificadas. O benchmark ajuda desenvolvedores e empresas a escolher modelos com base em avaliação temporal rigorosa, a priorizar treinamentos voltados para raciocínio temporal e a planejar de forma mais realista o uso de modelos em cenários com vídeos longos.

Detalhes técnicos ou Implementação

TimeScope usa o método de inserção de needles. Um vídeo base serve como “palheiro” e needles curtas são inseridas em posições aleatórias. As needles codificam as informações-chave para responder às perguntas, forçando o modelo a integrar informações pela linha do tempo completa, em vez de depender de frames isolados. Os três tipos de needles testam diferentes dimensões da compreensão de vídeo longo:

- Recuperação localizada e compreensão: perguntas que exigem identificar conteúdo no needle para obter a resposta, avaliando a capacidade de localizar e interpretar um evento dentro do vídeo.

- Síntese de informações dispersas: needles de texto embedadas em momentos variados requerem que o modelo extraia e organize palavras em ordem cronológica.

- Percepção de movimento: perguntas sobre movimento exigem que o modelo acompanhe a dinâmica entre frames. TimeScope também avalia como o desempenho varia com a duração do vídeo base. Os resultados iniciais indicam padrões consistentes: quanto maior o vídeo base, mais difícil fica manter desempenho estável. Além disso, o estudo demonstra que o aumento do tamanho do modelo não necessariamente estende o alcance temporal efetivo, com exceção de casos específicos. O Gemini 2.5-Pro foi destacado por manter melhor desempenho em vídeos superiores a uma hora. Os resultados também apontam trade-offs entre tarefas. Por exemplo, o Qwen 2.5-VL se sai bem em síntese de informações (OCR), mas tem desempenho menor em Percepção Temporal Fina, onde contagem de movimento exige fidelidade temporal precisa. TimeScope, com seu design, incentiva treinar modelos para manter a fidelidade temporal de maneira equilibrada. A release open-source de TimeScope convida a comunidade a reproduzir, estender e melhorar a avaliação de vídeos longos. Todos os componentes estão disponíveis para estudo e desenvolvimento, com resultados e visualizações acessíveis na Hugging Face Space que acompanha o benchmark.

Principais conclusões

- Compreensão de vídeos longos continua sendo uma área com promessas que ainda não se traduzem plenamente em resultados consistentes.

- A simples ampliação do tamanho do modelo não garante maior alcance temporal.

- Observam-se quedas de desempenho em determinadas durações, sugerindo a necessidade de treinamentos sensíveis à duração.

- Modelos exibem forças distintas: alguns performam melhor em síntese de informações (OCR), outros em percepção de movimento.

- A disponibilidade de TimeScope como projeto aberto facilita avaliação rigorosa e progresso colaborativo rumo a sistemas multimodais com melhor compreensão de vídeos ao longo do tempo.

FAQ

-

Além de recuperação, o que TimeScope testa?

Síntese, localização e percepção de movimento temporal, através de needles inseridas em vídeos longos e perguntas que exigem raciocínio temporal.

-

ual é o intervalo de duração de vídeos base e needles no TimeScope?

Vídeos base variam de 1 minuto a 8 horas; needles têm cerca de 5–10 segundos.

-

uais modelos foram avaliados e quais são os principais achados?

Foram avaliados Qwen 2.5-VL (3B e 7B), InternVL 2.5 (2B/4B/8B) e Gemini 2.5-Pro. A principal conclusão é que maior tamanho de modelo nem sempre implica compreensão temporal mais longa; Gemini 2.5-Pro se destaca em vídeos mais longos.

-

Por que o TimeScope é open-source?

O TimeScope é hospedado na Hugging Face, com componentes liberados para reprodução, extensão e avaliação comunitárias, promovendo avanços colaborativos em compreensão de vídeo longo.

Referências

More news

Scaleway Como Novo Fornecedor de Inferência no Hugging Face para Inferência serverless de Baixa Latência

A Scaleway é agora um Fornecedor de Inferência compatível no Hugging Face Hub, permitindo inferência serverless diretamente nas páginas de modelo com as SDKs JS e Python. Acesse modelos abertos populares com operações escaláveis e baixa latência.

Reduzindo a Latência de Cold Start para Inferência de LLM com NVIDIA Run:ai Model Streamer

Análise detalhada de como o NVIDIA Run:ai Model Streamer reduz o tempo de cold-start na inferência de LLMs ao transmitir pesos para a memória da GPU, com benchmarks em GP3, IO2 e S3.

Como a msg otimizou a transformação de RH com Amazon Bedrock e msg.ProfileMap

Este post mostra como a msg automatizou a harmonização de dados para o msg.ProfileMap usando o Amazon Bedrock para alimentar fluxos de enriquecimento de dados alimentados por LLM, elevando a precisão na correspondência de conceitos de RH, reduzindo trabalho manual e alinhando-se ao EU AI Act e ao GD

Como o Treinamento com Quantização Detecta e Recupera Precisão em Inferência de Baixa Precisão

Explora quantization aware training (QAT) e distilação quantization aware (QAD) como métodos para recuperar precisão em modelos de baixa precisão, usando o TensorRT Model Optimizer da NVIDIA e formatos FP8/NVFP4/MXFP4.

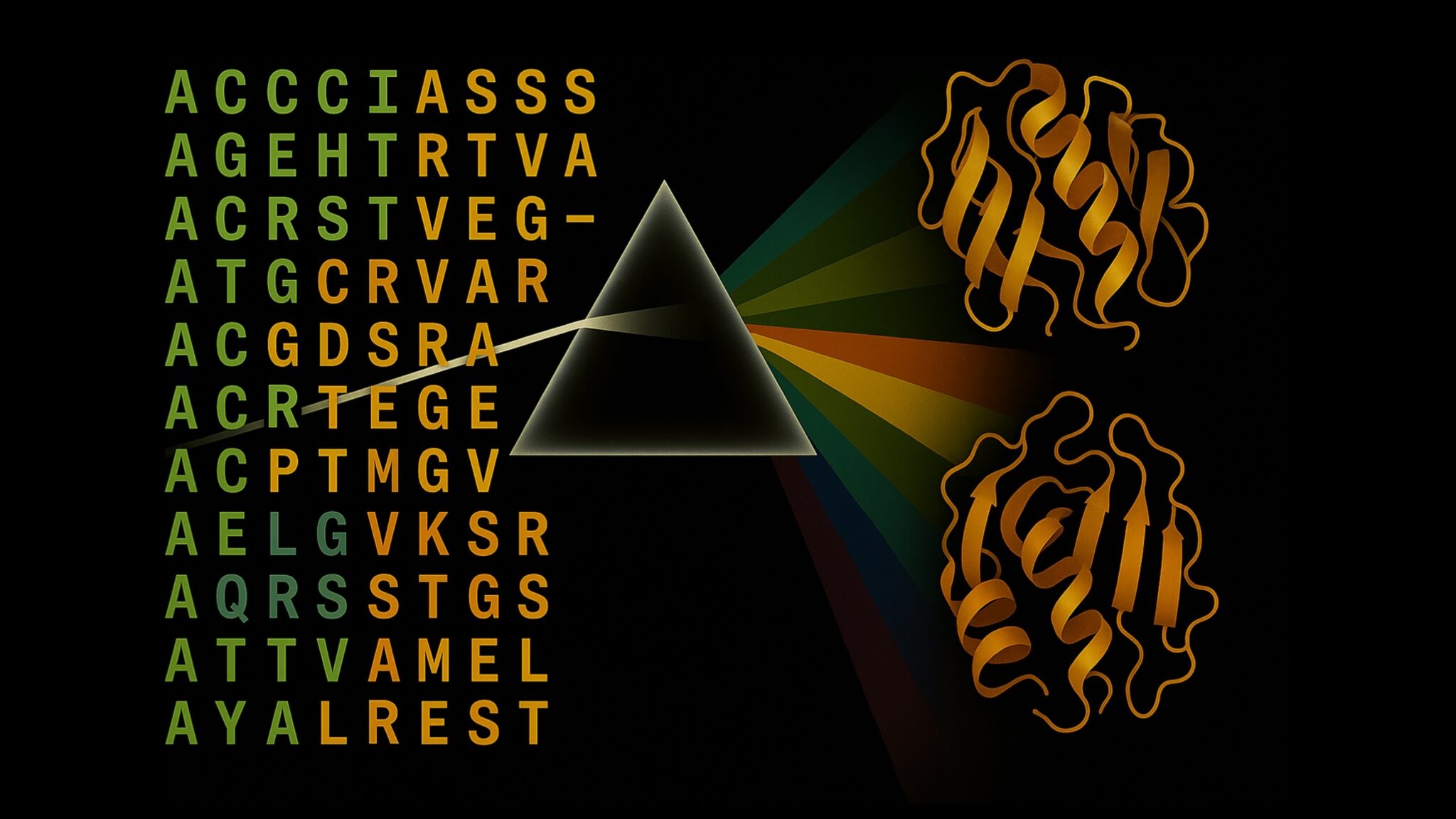

Acelere a Inferência de Estrutura de Proteínas em Mais de 100x com o NVIDIA RTX PRO 6000 Blackwell Server Edition

O RTX PRO 6000 Blackwell Server Edition da NVIDIA acelera drasticamente a inferência de estruturas de proteínas, permitindo fluxos de trabalho end-to-end movidos a GPU com OpenFold e TensorRT, atingindo até 138x mais rápido que o AlphaFold2.

Por que modelos de linguagem alucinam — e como a OpenAI está reformulando avaliações para aumentar a confiabilidade

A OpenAI descreve que as alucinações em modelos de linguagem surgem de incentivos de avaliação que favorecem adivinhação em vez da incerteza. O texto explica como pontuações e benchmarks focados na incerteza podem reduzir erros confiantes e melhorar a confiabilidade.