TimeScope: Benchmark de Tempo de Vídeos Longos para Modelos Multimodais

Sources: https://huggingface.co/blog/timescope-video-lmm-benchmark, Hugging Face Blog

TL;DR

- TimeScope é um benchmark de código aberto hospedado no Hugging Face que mede a capacidade de modelos visão-linguagem entenderem vídeos longos, inserindo needles curtas (~5–10 segundos) em vídeos-base que vão de 1 minuto a 8 horas. TimeScope blog

- O benchmark avalia três tipos de tarefas e três tipos de needles para ir além da recuperação superficial, cobrindo síntese, localização e análise de movimento fino. TimeScope blog

- O Gemini 2.5-Pro se destaca ao manter boa precisão em vídeos com mais de uma hora; Qwen 2.5-VL (3B e 7B) e InternVL 2.5 (2B, 4B, 8B) apresentam curvas de vídeo longo quase idênticas aos seus equivalentes menores. TimeScope blog

- Os resultados mostram que entender vídeos de uma hora ainda é desafiador; abrir o código ajuda a guiar melhorias direcionadas no treinamento e na avaliação de modelos multimodais. TimeScope blog

Contexto e antecedentes

Contextos longos têm sido alvo de interesse tanto para modelos visão-linguagem quanto para modelos de linguagem com contexto extensivo. Embora haja alegações de janelas de contexto muito largas, há ceticismo sobre traduzir tais claims em entendimento temporal real. Benchmarks existentes como Video Needle in a Haystack (VideoNIAH) costumam testar recuperação visual com needles estáticas, o que não mede de fato a dinâmica temporal. Benchmarks textuais como HELM e RULER já mostraram fragilidade de reivindicações de longo contexto quando tarefas exigem raciocínio ou agregação temporal. TimeScope blog O TimeScope surge para testar empiriamente a compreensão temporal ao longo de vídeos extensos, oferecendo uma abordagem que complementa avaliações baseadas em texto e em imagens estáticas. O objetivo é exigir raciocínio ao longo da linha do tempo, não apenas recuperação de trechos relevantes. TimeScope blog

O que há de novo

TimeScope apresenta um novo paradigma: um vídeo-base longo (de 1 minuto a 8 horas) funciona como o “cebolão”, e clips curtos (needles) são inseridos em posições aleatórias para exigir compreensão temporal holística. O objetivo não é apenas identificar o needle, mas entender o conteúdo no contexto completo para responder perguntas ou realizar análises. TimeScope blog Três tipos de needles e três tipos de tarefas compõem a avaliação:

- Tipos de tarefas testam recuperação, síntese de informação e localização, com ênfase na integração de informações ao longo do tempo. Por exemplo, uma pergunta pode abordar o modo de transporte mostrado em partes dispersas do vídeo. TimeScope blog

- Os needles incluem needles de texto (2–4 clipes curtos exibindo palavras na tela) que obrigam o modelo a identificar e ordenar palavras dispersas cronologicamente, simulando extração de timestamps ou fatos-chave. TimeScope blog

- Needle focada em movimento testa dinâmicas em clipes curtos; perguntas como “quantas vezes o homem balançou o machado?” exigem percepção de movimento ao longo de várias frames. TimeScope blog Com comprimentos variados de vídeo e Needle placements aleatórios, TimeScope mede quanto vídeo um modelo pode realmente processar, observando quedas de desempenho conforme o comprimento aumenta. Em testes iniciais, modelos open-source e grandes players foram avaliados, incluindo Gemini 2.5-Pro. Os resultados destacam onde os modelos falham em raciocínio temporal, síntese de informação e percepção de movimento, apontando direções para futuras melhorias no treinamento. TimeScope blog

Por que isso importa (impacto para desenvolvedores/empresas)

TimeScope trata de uma questão central para aplicações reais: será que sistemas conseguem entender narrativas de vídeo longas ou apenas realizam recuperação de trechos? Aplicações como robótica, análise de operações prolongadas e sumarização de vídeos de longo formato exigem raciocínio temporal ao longo de horas. O TimeScope, por ser de código aberto, permite que pesquisadores e empresas avaliem seus modelos de forma consistente, comparem abordagens diferentes e ajustem estratégias de treinamento para melhorias em raciocínio temporal e percepção de movimento. TimeScope blog Os achados também lembram que apenas aumentar o tamanho do modelo não garante janelas temporais mais largas; o benchmark evidencia que há limites de horizonte temporal que precisam ser superados com dados adequados e arquiteturas ajustadas. TimeScope blog

Detalhes técnicos ou implementação

A premissa do TimeScope é simples e poderosa: inserir needles curtas em vídeos longos e exigir entendimento holístico do conteúdo para resolver tarefas. As needles são breves (5–10 segundos) para forçar modelos a conectar informações ao longo da linha do tempo, em vez de depender de amostras densas. O vídeo-base pode ter 1 minuto a 8 horas, criando cenários de contexto longo para avaliação. TimeScope blog Destaques de implementação:

- Inserção de needles: Um vídeo-base longo funciona como o haystack, e uma ou mais needles curtas são inseridas em posições aleatórias. As needles contêm as informações-chave necessárias para resolver a tarefa, pressionando o modelo a processar o input inteiro sem atalhos. TimeScope blog

- Três tipos de needles, cada um mirando um aspecto diferente da compreensão de vídeos longos: (1) needles de texto para identificar e ordenar palavras dispersas, (2) needles centradas em movimento para testar a dinâmica entre frames, e (3) needles de localização para pontuar conteúdos ao longo da linha do tempo. TimeScope blog

- Tarefas avaliam recuperação, síntese de informações, localização e análise de movimento ao longo de vídeos de comprimentos crescentes. As perguntas exigem detectar, sintetizar ou analisar conteúdos contidos nas needles inseridas em profundidades diferentes no timeline. TimeScope blog Em testes iniciais, Gemini 2.5-Pro se destaca por manter precisão robusta em vídeos com mais de uma hora, enquanto Qwen 2.5-VL (3B e 7B) e InternVL 2.5 (2B, 4B, 8B) apresentam curvas de longo vídeo quase idênticas às variantes menores, com tendência de plateau na mesma janela de contexto. Isso reforça que apenas aumentar o tamanho do modelo não garante maior alcance temporal de forma automática. TimeScope blog TimeScope é de código aberto, com todos os componentes disponibilizados para a comunidade. O projeto inclui também um Hugging Face Space com resultados detalhados e visualizações, apoiando pesquisadores e desenvolvedores a diagnosticar fraquezas e orientar melhorias em treinamento e avaliação. TimeScope blog

Tabela rápida de comparações

| Modelo | Comportamento em vídeo longo | Observações |---|---|---| | Gemini 2.5-Pro | Mantém alta precisão em vídeos > 1 hora | Destaque entre os modelos testados |Qwen 2.5-VL 3B | Curva de vídeo longo similar a variantes menores | Brilha na tarefa de Síntese de Informação (OCR), mas fica atrás em Percepção Temporal Fina |Qwen 2.5-VL 7B | Curva de vídeo longo similar a 3B | Tendência semelhante à 3B; requer raciocínio temporal robusto |InternVL 2.5 (2B/4B/8B) | Curvas longas semelhantes entre tamanhos | Plateau em uma fronteira de contexto similar |

Principais conclusões

- Entender vídeos por horas ainda é um objetivo; reivindicações de processar milhares de frames ainda não se traduzem em desempenho estável em cenários longos. TimeScope blog

- O desempenho dos modelos tende a piorar conforme o comprimento do vídeo aumenta, destacando a necessidade de raciocínio temporal verdadeiro além da recuperação estática. TimeScope blog

- O Gemini 2.5-Pro se destaca para vídeos mais longos, mas a maioria dos modelos exibe comportamento de plateau, indicando limites de arquiteturas atuais ou de dados de treinamento. TimeScope blog

- A simples ampliação de parâmetros não garante horizonte temporal maior; TimeScope revela trade-offs entre tarefas como síntese de informação e percepção de movimento. TimeScope blog

- O caráter de código aberto do TimeScope permite à comunidade melhorar dados, regimes de treinamento e métodos de avaliação para avançar rumo à compreensão de vídeo de longo prazo. TimeScope blog

FAQ

-

O que é TimeScope?

TimeScope é um benchmark de código aberto hospedado no Hugging Face que testa a compreensão de vídeos longos inserindo needles curtas em vídeos-base para medir raciocínio temporal e análise de movimento.

-

Como as needles são inseridas e o que elas testam?

Needle curtas (~5–10 segundos) são inseridas em posições aleatórias em vídeos-base (1 minuto a 8 horas). Testam recuperação, síntese de informações, localização e análise de movimento ao longo da linha do tempo.

-

uais resultados foram observados até agora?

Gemini 2.5-Pro mantém precisão em vídeos com mais de uma hora; Qwen 2.5-VL e InternVL 2.5 apresentam curvas de longo vídeo semelhantes aos modelos menores, com plateau próximo ao mesmo horizonte.

-

Por que isso é importante para equipes de desenvolvimento?

Fornece uma forma padronizada e aberta de avaliar compreensão de vídeo de longo prazo, guiando dados, desenho de modelos e estratégias de treinamento para melhorar raciocínio temporal e percepção de movimento.

Referências

More news

Scaleway Como Novo Fornecedor de Inferência no Hugging Face para Inferência serverless de Baixa Latência

A Scaleway é agora um Fornecedor de Inferência compatível no Hugging Face Hub, permitindo inferência serverless diretamente nas páginas de modelo com as SDKs JS e Python. Acesse modelos abertos populares com operações escaláveis e baixa latência.

Reduzindo a Latência de Cold Start para Inferência de LLM com NVIDIA Run:ai Model Streamer

Análise detalhada de como o NVIDIA Run:ai Model Streamer reduz o tempo de cold-start na inferência de LLMs ao transmitir pesos para a memória da GPU, com benchmarks em GP3, IO2 e S3.

Como a msg otimizou a transformação de RH com Amazon Bedrock e msg.ProfileMap

Este post mostra como a msg automatizou a harmonização de dados para o msg.ProfileMap usando o Amazon Bedrock para alimentar fluxos de enriquecimento de dados alimentados por LLM, elevando a precisão na correspondência de conceitos de RH, reduzindo trabalho manual e alinhando-se ao EU AI Act e ao GD

Como o Treinamento com Quantização Detecta e Recupera Precisão em Inferência de Baixa Precisão

Explora quantization aware training (QAT) e distilação quantization aware (QAD) como métodos para recuperar precisão em modelos de baixa precisão, usando o TensorRT Model Optimizer da NVIDIA e formatos FP8/NVFP4/MXFP4.

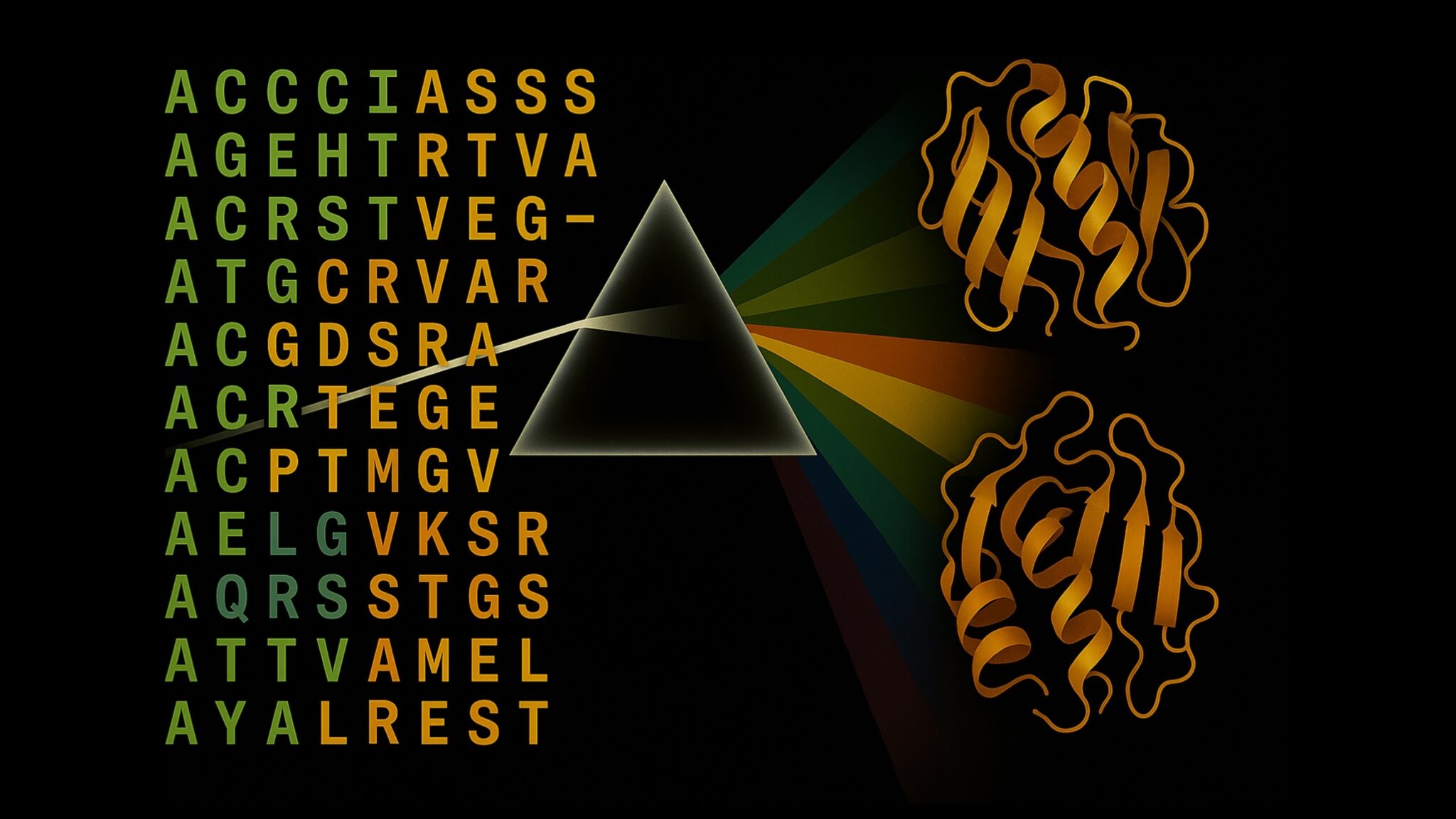

Acelere a Inferência de Estrutura de Proteínas em Mais de 100x com o NVIDIA RTX PRO 6000 Blackwell Server Edition

O RTX PRO 6000 Blackwell Server Edition da NVIDIA acelera drasticamente a inferência de estruturas de proteínas, permitindo fluxos de trabalho end-to-end movidos a GPU com OpenFold e TensorRT, atingindo até 138x mais rápido que o AlphaFold2.

Por que modelos de linguagem alucinam — e como a OpenAI está reformulando avaliações para aumentar a confiabilidade

A OpenAI descreve que as alucinações em modelos de linguagem surgem de incentivos de avaliação que favorecem adivinhação em vez da incerteza. O texto explica como pontuações e benchmarks focados na incerteza podem reduzir erros confiantes e melhorar a confiabilidade.