Consilium: Quando Vários LLMs Colaboram para Chegar a um Consenso

Sources: https://huggingface.co/blog/consilium-multi-llm, Hugging Face Blog

TL;DR

- Consilium é uma plataforma multi-LLM que permite que modelos de IA discutam questões complexas e cheguem a consenso por meio de debates estruturados.

- Opera como uma interface Gradio e como um servidor MCP (Model Context Protocol), integrando-se a aplicações e viabilizando colaboração dinâmica entre agentes.

- O projeto introduziu papéis, rodadas e um analista líder para sintetizar resultados, além de um agente de pesquisa para modelos com chamadas de função e cinco fontes de pesquisa.

- Um benchmark da MAI-DxO da Microsoft é citado no artigo, demonstrando como a colaboração entre múltiplas perspectivas de IA pode superar a análise individual, validando a abordagem do Consilium.

- Trabalhos em andamento incluem integração com o Open Floor Protocol, expansão de seleção de modelos e papéis configuráveis de agentes para suportar cenários de múltiplos agentes.

Contexto e antecedentes

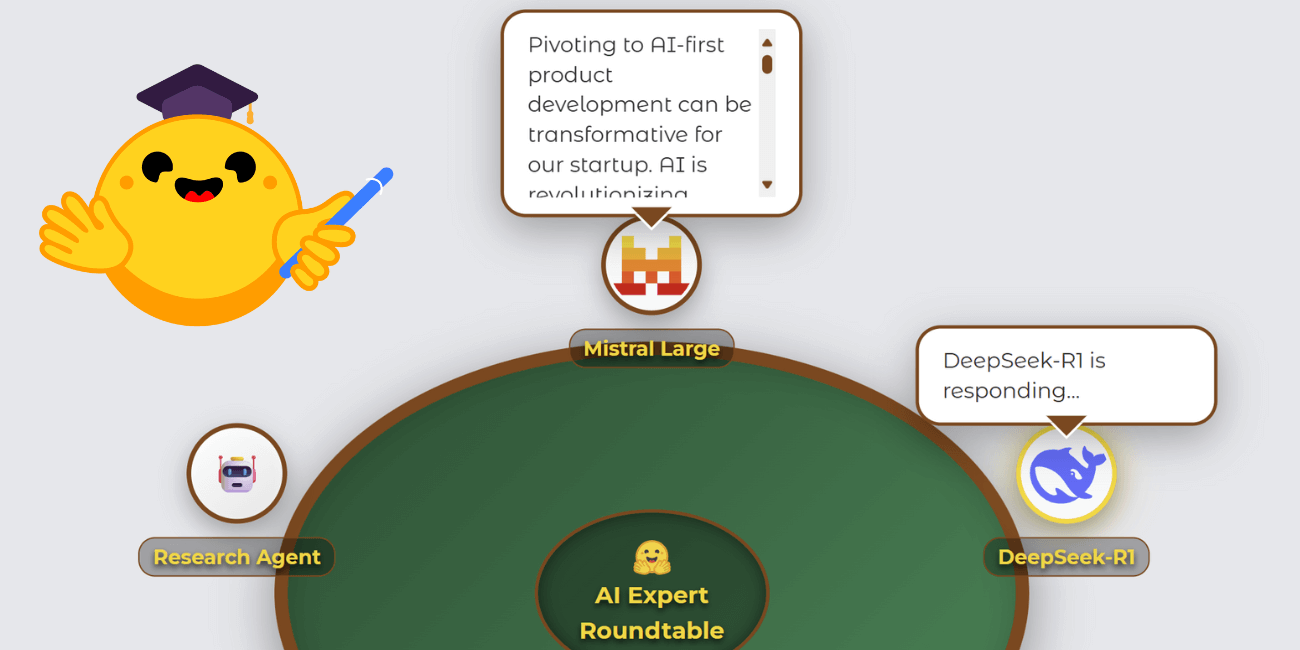

O Consilium, conforme descrito no blog da Hugging Face, é uma plataforma de IA que permite que vários modelos discutam perguntas e cheguem a consenso por meio de debates estruturados. O projeto nasceu como uma submissão de hackathon durante o Gradio Agents & MCP Hackathon e evoluiu de um servidor MCP simples para um ambiente de debate colaborativo mais rico. O autor destacou que a ideia central é o consenso através da discussão, um conceito que ganhou impulso após o trabalho da MAI-DxO da Microsoft, que apresentou um painel de IA com papéis distintos para diagnosticar problemas. Esse trabalho mostrou que a colaboração entre várias perspectivas de IA superou a análise única, ilustrando o valor potencial da abordagem do Consilium. O design também enfatiza uma experiência do usuário envolvente. Em vez de usar uma interface de chat padrão, o desenvolvedor criou uma visualização de-roundtable em estilo pôquer para situar LLMs em torno de uma mesa, exibindo respostas, status de pensamento e atividade de pesquisa. Esse visual foi implementado como um componente Gradio personalizado, peça central da demonstração e que permitiu ao projeto qualificar-se para várias trilhas do hackathon. O desenvolvimento do componente contou com a excelente experiência de desenvolvedor do Gradio, com apenas uma lacuna de documentação sobre publicação no PyPI que levou o autor a fazer a primeira contribuição ao projeto Gradio. O estado da mesa é gerenciado por meio de um dicionário de sessão, com um objeto de estado central que acompanha participantes, mensagens, palestrante atual, pensamento e exibição de balões, atualizado através de callbacks de update_visual_state para produzir atualizações em tempo real. O projeto também explorou a necessidade de papéis estruturados para tornar as discussões entre LLMs produtivas. Testes iniciais mostraram que, sem papéis definidos, as conversas careciam de engajamento. Ao introduzir papéis distintos e um analista líder para sintetizar o resultado final e avaliar se há consenso, a dinâmica da discussão melhorou. Além disso, foram adicionados dois modos de comunicação além do compartilhamento de contexto completo para dar aos usuários mais controle sobre como os modelos interagem durante os debates. O trabalho também introduziu rodadas de discussão configuráveis (de 1 a 5) e observou que mais rodadas aumentaram a probabilidade de consenso, com custo computacional proporcional.

O que há de novo

Desde a concepção, o Consilium incorporou várias inovações e integrações. A plataforma agora inclui:

- Um mecanismo de analista líder, em que o usuário escolhe um LLM para sintetizar a saída final e julgar se o consenso foi alcançado.

- Rodadas de discussão configuráveis (1–5), com testes que mostram que mais rodadas aumentam a probabilidade de consenso, porém exigem mais computação.

- Um conjunto atual de modelos incluindo Mistral Large, DeepSeek-R1, Meta-Llama-3.3-70B e QwQ-32B. Modelos notáveis como Claude Sonnet e o o3 da OpenAI não foram incluídos devido a limitações de créditos de hackathon e de patrocinadores, não por limitações técnicas.

- Um agente de pesquisa dedicado para modelos que suportam chamadas de função. Este agente aparece como um participante adicional na mesa e utiliza cinco fontes: Web Search, Wikipedia, arXiv, GitHub e SEC EDGAR.

- Uma arquitetura de base extensível para ferramentas de pesquisa, permitindo expansão futura e priorizando recursos livres para incorporação.

- Indicadores de progresso e estimativas de tempo para tarefas de pesquisa mais longas, mantendo o usuário informado.

- Compatibilidade com o Open Floor Protocol (OFP) para padronizar a comunicação entre agentes em várias plataformas. OFP permite convidar e remover agentes dinamicamente, mantendo a consciência contínua da conversa. Essas evoluções estão alinhadas com tendências de pesquisa em multiagentes e foram aceleradas pelo trabalho de referência MAI-DxO e pelo ecossistema Gradio. Para leitores interessados em ver o andamento da integração OFP, o espaço dedicado pode ser acessado em https://huggingface.co/spaces/azettl/consilium_ofp.

Por que isso importa (impacto para desenvolvedores/empresas)

O Consilium representa uma mudança de foco de apenas modelos individuais para sistemas de IA colaborativos onde múltiplos modelos especializados discutem, debatem e sintetizam resultados coletivamente. O blog observa que a colaboração entre várias perspectivas de IA pode superar a análise de um único modelo, uma afirmação apoiada por trabalhos relacionados de diagnóstico de IA que alcançaram precisão significativamente maior quando várias perspectivas foram combinadas. Isso tem implicações para desenvolvedores e empresas:

- Qualidade de decisão aprimorada: debates estruturados com papéis e síntese de analista líder podem produzir conclusões mais robustas do que a análise de um único modelo.

- Flexibilidade e extensibilidade: o servidor MCP e a arquitetura modular permitem integração com aplicações existentes e expansão futura de modelos e tipos de agentes.

- Transparência e rastreabilidade: o estado do roundtable e as atualizações incrementais oferecem uma visão clara de como as conclusões foram alcançadas, com o pensamento e a atividade de pesquisa visíveis aos usuários.

- Fluxos de colaboração personalizáveis: usuários podem ajustar o número de rodadas, definir papéis e escolher entre um conjunto crescente de modelos para tarefas específicas e restrições de recursos. A abordagem também se alinha a padrões da indústria de orquestração e governança de IA, sugerindo que sistemas com múltiplos agentes podem se tornar uma alternativa prática ou complemento para modelos grandes de propósito geral em vários casos de uso. Ao combinar uma interface visual interativa com um backend robusto (servidor MCP) e protocolos baseados em padrões (Open Floor Protocol), o Consilium se posiciona como um modelo para fluxos de trabalho de IA colaborativa em implantações do mundo real.

Detalhes técnicos ou Implementação

No núcleo, o Consilium gerencia um estado por sessão que impulsiona a visualização frontend e a lógica de debate backend. As chaves incluem participantes, mensagens, currentSpeaker, thinking e showBubbles. As mutações de estado ocorrem através de um loop de atualização simples: quando os modelos estão pensando, falando ou realizando pesquisa, o backend adiciona às mensagens e altera os indicadores de palestrante/pensamento, assegurando feedback visual em tempo real sem exigir máquinas de estado complexas. Principais escolhas arquiteturais:

- Integração MCP: o Consilium funciona como um servidor MCP, apto a conversar com projetos e aplicações existentes, facilitando integração em fluxos de trabalho reais.

- Componente Gradio personalizado: a visualização da mesa é um componente Gradio rico que oferece interações como balões de fala, estados de pensamento e progresso de pesquisa, sendo central para a demonstração e para suportar colaboração entre vários modelos em tempo real.

- Papéis de agentes distintos: a atribuição de papéis foi criada para tornar o debate entre LLMs produtivo e evitar engajamento fraco quando contextos completos são compartilhados sem estrutura.

- Síntese pelo analista líder: usuários designam um LLM para sintetizar a saída final e verificar se há consenso, fornecendo um ponto de decisão claro.

- Rodadas configuráveis: a plataforma suporta de 1 a 5 rodadas, equilibrando custo computacional e probabilidade de consenso.

- Seleção de modelos: a linha atual de modelos inclui Mistral Large, DeepSeek-R1, Meta-Llama-3.3-70B e QwQ-32B. Modelos notáveis como Claude Sonnet e o OpenAI o3 não foram incluídos por motivos de créditos de hackathon, não por limitações técnicas.

- Pesquisador com chamadas de função: para modelos que suportam chamadas de função, um agente de pesquisa aparece como participante adicional. Este agente pode acessar cinco fontes: Web Search, Wikipedia, arXiv, GitHub e SEC EDGAR, via uma arquitetura de base extensível para expansão futura.

- Integração com OFP: OFP fornece mensagens JSON padronizadas para comunicação entre agentes em várias plataformas, permitindo convite/demonstração dinâmica de agentes mantendo a consciência da conversa. O projeto está ativamente integrando OFP, com desenvolvimento contínuo hospedado em https://huggingface.co/spaces/azettl/consilium_ofp. Do ponto de vista do fluxo de trabalho, operações de pesquisa podem levar tempo. Para manter o engajamento, a interface exibe indicadores de progresso e estimativas de tempo para tarefas de pesquisa, assegurando visibilidade sobre durações previstas. O design do platforma reflete uma sintonia com pesquisas de IA por múltiplos agentes, incluindo estudos de divergência criativa via debate entre agentes. O espírito colaborativo observado durante o hackathon—sobretudo via feedback e colaboração no Discord—também moldou o desenvolvimento. Para referências de OFP, acesse o espaço dedicado mencionado acima.

Principais conclusões

- O Consilium demonstra como debates estruturados entre múltiplos LLMs podem levar a resultados de maior qualidade do que a análise de um único modelo.

- A plataforma combina uma mesa redonda visual interativa no Gradio com um servidor MCP para integração flexível em aplicações reais.

- Papéis, síntese pelo analista líder e rodadas configuráveis melhoram o engajamento e a qualidade da decisão.

- Um agente de pesquisa dedicado e acesso a cinco fontes permitem pesquisa robusta e auditarível, mantendo uma interface consistente entre modelos com chamadas de função.

- A integração com OFP está em andamento para padronizar a colaboração entre agentes entre plataformas.

FAQ

-

O que é o Consilium?

Uma plataforma multi-LLM que permite que IA discuta perguntas e chegue a consenso por meio de debates estruturados, disponível como espaço Gradio e como servidor MCP.

-

uais modelos estão sendo usados atualmente no Consilium?

Mistral Large, DeepSeek-R1, Meta-Llama-3.3-70B e QwQ-32B. Claude Sonnet e o o3 da OpenAI não estão incluídos devido a créditos de hackathon/patrocínio, não por limitações técnicas.

-

O que é o Open Floor Protocol neste contexto?

Um protocolo de comunicação entre agentes com mensagens JSON padronizadas; o Consilium está integrando OFP para permitir convite/demonstração dinâmicos de agentes mantendo a continuidade da conversa. Veja https://huggingface.co/spaces/azettl/consilium_ofp.

-

Como o Consilium determina o consenso?

Um analista líder sintetiza a saída final e avalia se o consenso foi alcançado, dentro de rodadas configuráveis.

-

uais são os componentes técnicos principais?

Um servidor MCP, um componente Gradio personalizado para a mesa, um estado de sessão, um agente de pesquisa com cinco fontes, e planos de integração OFP.

Referências

More news

Scaleway Como Novo Fornecedor de Inferência no Hugging Face para Inferência serverless de Baixa Latência

A Scaleway é agora um Fornecedor de Inferência compatível no Hugging Face Hub, permitindo inferência serverless diretamente nas páginas de modelo com as SDKs JS e Python. Acesse modelos abertos populares com operações escaláveis e baixa latência.

Como reduzir gargalos do KV Cache com NVIDIA Dynamo

O Dynamo da NVIDIA transfere o KV Cache da memória da GPU para armazenamento de custo mais baixo, permitindo janelas de contexto maiores, maior concorrência e menor custo de inferência em grandes modelos.

Reduzindo a Latência de Cold Start para Inferência de LLM com NVIDIA Run:ai Model Streamer

Análise detalhada de como o NVIDIA Run:ai Model Streamer reduz o tempo de cold-start na inferência de LLMs ao transmitir pesos para a memória da GPU, com benchmarks em GP3, IO2 e S3.

Otimize o acesso a alterações de conteúdo ISO-rating com Verisk Rating Insights e Amazon Bedrock

Verisk Rating Insights, impulsionado pelo Amazon Bedrock, LLMs e RAG, oferece uma interface conversacional para acessar mudanças ERC ISO, reduzindo downloads manuais e aumentando a velocidade e a precisão das informações.

Como a msg otimizou a transformação de RH com Amazon Bedrock e msg.ProfileMap

Este post mostra como a msg automatizou a harmonização de dados para o msg.ProfileMap usando o Amazon Bedrock para alimentar fluxos de enriquecimento de dados alimentados por LLM, elevando a precisão na correspondência de conceitos de RH, reduzindo trabalho manual e alinhando-se ao EU AI Act e ao GD

Automatize pipelines RAG avançadas com SageMaker AI da AWS

Aperfeiçoe a experimentação até a produção para Retrieval Augmented Generation (RAG) com SageMaker AI, MLflow e Pipelines, promovendo fluxos reprodutíveis, escaláveis e com governança.