Seq vs Seq: a suíte Ettin de codificadores e decodificadores emparelhados

Sources: https://huggingface.co/blog/ettin, Hugging Face Blog

TL;DR

- Ettin apresenta as primeiras versões de ponta a ponta emparelhadas entre codificadores (encoder) e decodificadores (decoder), treinadas com dados idênticos, formatos de modelo idênticos e receitas de treinamento idênticas fonte.

- A suíte cobre seis escalas, variando de 17 milhões a 1 bilhão de parâmetros, tanto para encoders quanto para decoders fonte.

- A formação segue uma receita de três fases: pré-treinamento em 1,7 trilhões de tokens com contextos curtos, Extensão de Contexto para 8K tokens em 250 bilhões de tokens e uma fase de Decaimento com 100 bilhões de tokens de fontes premium fonte.

- Todo o conjunto de dados de treinamento é público e reproduzível, permitindo comparações justas; encoders se destacam em classificação e recuperação, enquanto decoders lideram na geração fonte.

- Em benchmarks, modelos Ettin superam ou igualam baselines como Llama 3.2 1B e SmolLM2, com ganhos acentuados em tarefas com alto conteúdo de conhecimento, como SciQ fonte.

Contexto e antecedentes

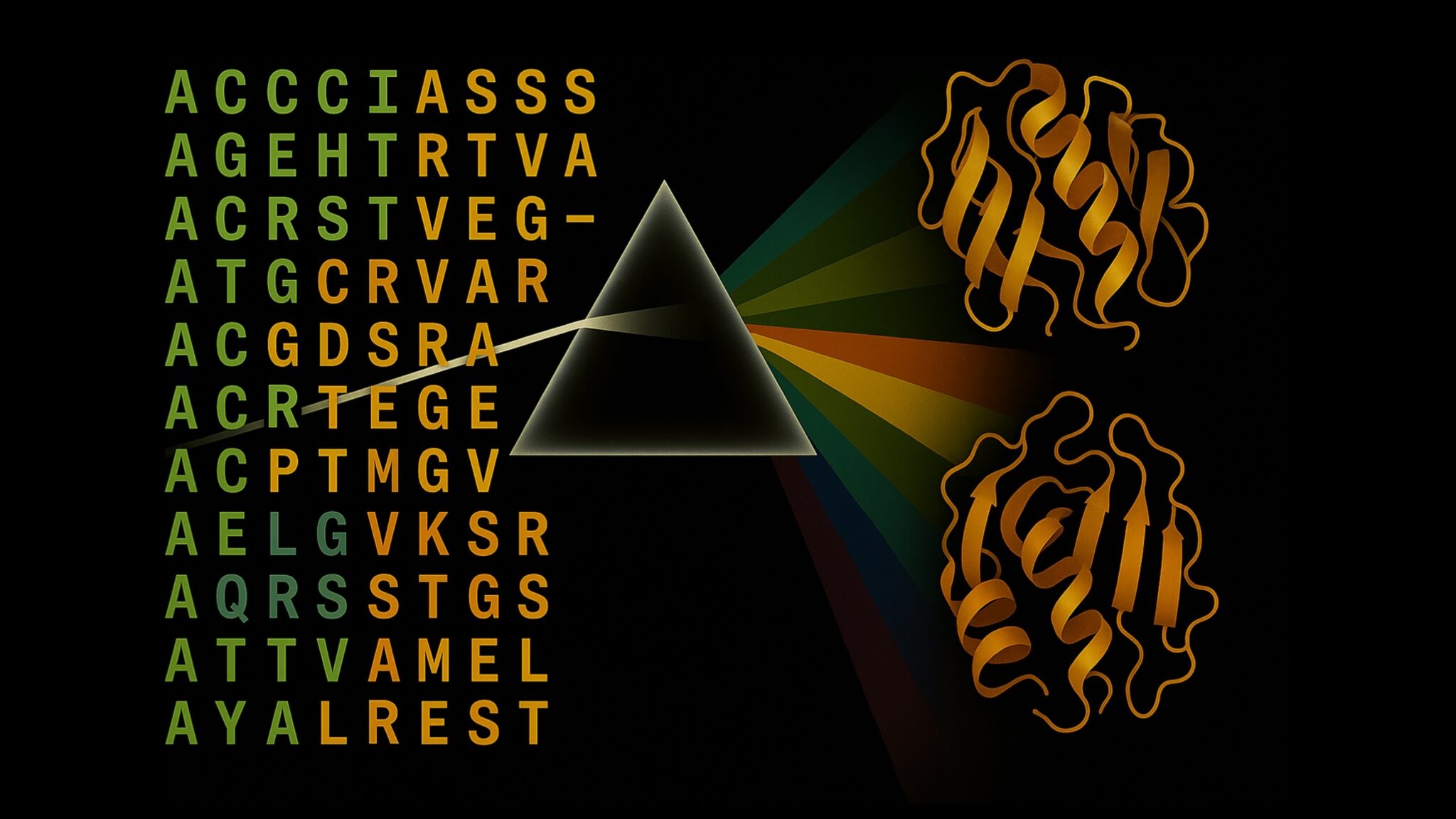

A comunidade de LLMs tem se concentrado amplamente em modelos apenas de decodificador (decoder) como GPT, Llama e Qwen para geração, enquanto modelos apenas de codificador (encoder) continuam a ser centrais para tarefas de produção como classificação, recuperação e embeddings. Encoders costumam ser mais rápidos e consomem menos memória para tarefas discriminativas, mas historicamente ficaram atrás em capacidades generativas em comparação com decoders. Ettin oferece uma comparação justa entre as duas arquiteturas, treinadas com os mesmos dados, formatos de modelo e receitas, sendo as únicas diferenças o padrão de atenção e o objetivo de treinamento. O projeto leva o nome do gigante mitológico noruegês Ettin, refletindo sua abordagem de arquiteturas emparelhadas. Todo o dado utilizado é público e reproduzível, fortalecendo o compromisso com ciência aberta e reprodutibilidade. Você pode continuar treinando esses modelos com dados novos ou propor uma nova receita para melhorar ainda mais os resultados fonte.

O que há de novo

Ettin apresenta uma suíte coerente de seis modelos para cada arquitetura, abrangendo de 17M a 1B de parâmetros. A mesma base de dados, formatos de modelo e receita de treinamento é aplicada a ambas as famílias para permitir comparações justas entre padrões de atenção e objetivos. Especificamente:

- Dois objetivos de treinamento são explorados em um cenário controlado: mascaramento de linguagem (MLM) para encoders e modelagem de linguagem causal (CLM) para decoders. A mesma base de dados e receita é aplicada a ambos, permitindo uma análise justa de arquitetura vs. objetivo.

- O regime de dados é aberto e reprodutível: os dados de treinamento são públicos, permitindo que pesquisadores reproduzam resultados ou estendam o treinamento com novos dados.

- Ettin emprega uma abordagem de treinamento em três fases, semelhante à linha do ModernBERT, com extensão de contexto para capturar dependências de longo alcance. Fase 1 pré-treina com 1,7T tokens e contextos curtos (1024) para fundar conhecimentos básicos; Fase 2 amplia o contexto para 8K tokens com dados filtrados de alta qualidade; Fase 3 utiliza 100B tokens de fontes premium e reduz gradualmente a taxa de aprendizado fonte.

- Os modelos encoders e decoders entregam desempenho de ponta para modelos abertos em várias tarefas e tamanhos. Em várias avaliações, encoders Ettin superam o ModernBERT, enquanto decoders Ettin superam ou igualam baselines consolidadas como Llama 3.2 e SmolLM2, com ganhos notáveis em tarefas de alto conteúdo de conhecimento, como SciQ fonte.

- Os resultados destacam vantagens arquiteturais fundamentais que persistem quando dados, receitas e escalas são controlados: encoders se destacam em classificação e recuperação, enquanto decoders mantêm vantagem em geração, com o desempenho se consolidando à medida que o tamanho aumenta. Um experimento adicional trocando o objetivo após o treinamento inicial sugere que a escolha da arquitetura importa além do próprio objetivo, impactando dinâmica de aprendizado e comportamento, inclusive em métricas de viés como WinoGender fonte.

- Para pesquisadores e profissionais, Ettin oferece boilerplates prontos e um caminho claro para reproduzir ou ampliar o trabalho. Os autores convidam usuários a experimentar os modelos e considerar fluxos de trabalho de classificação, recuperação e geração com encoders ou decoders fonte.

Por que isso importa (impacto para desenvolvedores/empresas)

A contribuição central de Ettin é permitir comparações justas entre arquiteturas de encoder e decoder sob as mesmas condições de dados e receitas. Isso facilita a escolha da base certa para uma aplicação, seja um modelo discriminativo rápido para dispositivos ou um sistema generativo mais capaz para tarefas de contexto longo. O caráter aberto dos dados facilita a reprodução e adaptação por equipes que desejam treinar modelos de ponta com dados próprios. Em termos práticos, equipes podem avaliar qual arquitetura melhor atende a tarefas de classificação e recuperação versus geração, entender como a escala afeta o desempenho sob uma semântica de dados comum e examinar se a mudança de objetivo influencia o comportamento do modelo de forma mensurável em cenários de produção fonte.

Detalhes técnicos ou Implementação

A suíte Ettin reúne seis escalas de modelo para cada arquitetura (encoder e decoder), variando de 17M a 1B de parâmetros. Em ambas as famílias, a mesma base de dados, formatos de modelo e receita de treinamento é aplicada, para assegurar comparações justas entre padrões de atenção. A rotina de treinamento em três fases é um recurso central: 1) pré-treinamento em 1,7T tokens com contextos curtos (1024) para consolidar fundamentos; 2) extensão de contexto para 8K tokens usando dados filtrados de alta qualidade; 3) fase de decaimento com 100B tokens de fontes premium, com redução gradual da taxa de aprendizado. Um experimento chave envolveu continuar o treinamento por mais 50B tokens com o objetivo oposto (MLM para encoders, CLM para decoders) para estudar como os objetivos moldam a aprendizagem sob a mesma arquitetura e regime de dados. A natureza aberta dos dados e dos componentes de treino permite que pesquisadores explorem vantagens de arquitetura e dynamics de viés com dados transparentes fonte.

Principais conclusões

- Ettin estabelece um framework justo para comparar arquitetura de encoder e decoder, usando dados, formatos e receitas idênticos.

- Encoders tendem a dominar tarefas de classificação e recuperação, mesmo em tamanhos menores, enquanto decoders mantêm vantagens em geração, especialmente conforme a escala cresce.

- A cobertura de seis escalas (17M–1B) para ambas as famílias oferece opções de implantação variadas, desde modelos rápidos para uso em dispositivos até sistemas maiores com alto desempenho.

- Todo o dado de treinamento de Ettin é público e reproduzível, facilitando a replicação, extensão e melhorias pela comunidade.

- Um experimento que reverteu o objetivo após o treinamento inicial mostra que a arquitetura importa além do objetivo, com impactos observáveis nas métricas e no comportamento do modelo, inclusive em métricas de viés.

- Ettin oferece boilerplates prontos para uso, promovendo um caminho claro para experimentar modelos abertos em tarefas de classificação, recuperação e geração fonte.

FAQ

-

O que é Ettin?

Ettin é descrito como a primeira suíte de modelos emparelhados de ponta entre encoder e decoder, treinados com dados, formatos e receitas idênticos; as diferenças residem na atenção e nos objetivos de treinamento [fonte](https://huggingface.co/blog/ettin).

-

uantos tamanhos de modelo existem e qual é o alcance?

suíte completa inclui seis escalas para encoders e decoders, variando de 17M a 1B de parâmetros [fonte](https://huggingface.co/blog/ettin).

-

ual regime de dados é utilizado?

O Ettin utiliza uma abordagem de três fases com 1,7T tokens de pré-treinamento, 250B tokens para extensão de contexto até 8K e 100B tokens de fontes premium na fase de decaimento; todos os dados são públicos e reproduzíveis [fonte](https://huggingface.co/blog/ettin).

-

Como os resultados se comparam a baselines conhecidos?

Encoders Ettin superam o ModernBERT em várias tarefas, enquanto decoders Ettin superam ou igualam baselines como Llama 3.2 e SmolLM2, com ganhos notáveis em tarefas de alto conteúdo de conhecimento, como SciQ [fonte](https://huggingface.co/blog/ettin).

-

Posso reproduzir ou experimentar esses modelos?

Sim. O post oferece boilerplates no final, e todos os dados de treino são públicos, permitindo reprodução ou extensão do trabalho [fonte](https://huggingface.co/blog/ettin).

Referências

More news

Scaleway Como Novo Fornecedor de Inferência no Hugging Face para Inferência serverless de Baixa Latência

A Scaleway é agora um Fornecedor de Inferência compatível no Hugging Face Hub, permitindo inferência serverless diretamente nas páginas de modelo com as SDKs JS e Python. Acesse modelos abertos populares com operações escaláveis e baixa latência.

Reduzindo a Latência de Cold Start para Inferência de LLM com NVIDIA Run:ai Model Streamer

Análise detalhada de como o NVIDIA Run:ai Model Streamer reduz o tempo de cold-start na inferência de LLMs ao transmitir pesos para a memória da GPU, com benchmarks em GP3, IO2 e S3.

Como a msg otimizou a transformação de RH com Amazon Bedrock e msg.ProfileMap

Este post mostra como a msg automatizou a harmonização de dados para o msg.ProfileMap usando o Amazon Bedrock para alimentar fluxos de enriquecimento de dados alimentados por LLM, elevando a precisão na correspondência de conceitos de RH, reduzindo trabalho manual e alinhando-se ao EU AI Act e ao GD

Como o Treinamento com Quantização Detecta e Recupera Precisão em Inferência de Baixa Precisão

Explora quantization aware training (QAT) e distilação quantization aware (QAD) como métodos para recuperar precisão em modelos de baixa precisão, usando o TensorRT Model Optimizer da NVIDIA e formatos FP8/NVFP4/MXFP4.

Acelere a Inferência de Estrutura de Proteínas em Mais de 100x com o NVIDIA RTX PRO 6000 Blackwell Server Edition

O RTX PRO 6000 Blackwell Server Edition da NVIDIA acelera drasticamente a inferência de estruturas de proteínas, permitindo fluxos de trabalho end-to-end movidos a GPU com OpenFold e TensorRT, atingindo até 138x mais rápido que o AlphaFold2.

Por que modelos de linguagem alucinam — e como a OpenAI está reformulando avaliações para aumentar a confiabilidade

A OpenAI descreve que as alucinações em modelos de linguagem surgem de incentivos de avaliação que favorecem adivinhação em vez da incerteza. O texto explica como pontuações e benchmarks focados na incerteza podem reduzir erros confiantes e melhorar a confiabilidade.