Estamos Prontos para o Raciocínio com Múltiplas Imagens? Lançamento do Benchmark Visual Haystacks (VHs)

Sources: http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks, bair.berkeley.edu

TL;DR

- Visual Haystacks (VHs) é o primeiro benchmark visual centrado em Needle-In-A-Haystack para avaliar grandes modelos multimodais (LMMs) em dados visuais de longo contexto.

- O benchmark testa duas tarefas: Single-Needle e Multi-Needle, usando imagens do conjunto COCO e aproximadamente 1K pares binários de perguntas e respostas ao longo de haystacks que vão de 1 a 10 mil imagens.

- Modelos atuais abertos e proprietários têm dificuldades à medida que o haystack cresce, com limitações de contexto e distrações visuais causando quedas de desempenho; uma simples abordagem de legendagem + LLM pode superar alguns LMMs em ambientes de várias imagens.

- MIRAGE, uma nova arquitetura de treinamento de estágio único, estende o LLaVA para QA de várias imagens (MIQA) com compressão de tokens visuais, uso de um recuperador e dados de treinamento multi-imagem, atingindo bons resultados em conjuntos de 1K–10K imagens.

- Os resultados destacam a necessidade de recuperação robusta entre imagens e integração entre várias imagens para uso prático, apontando caminhos para implementação na indústria.

Contexto e antecedentes

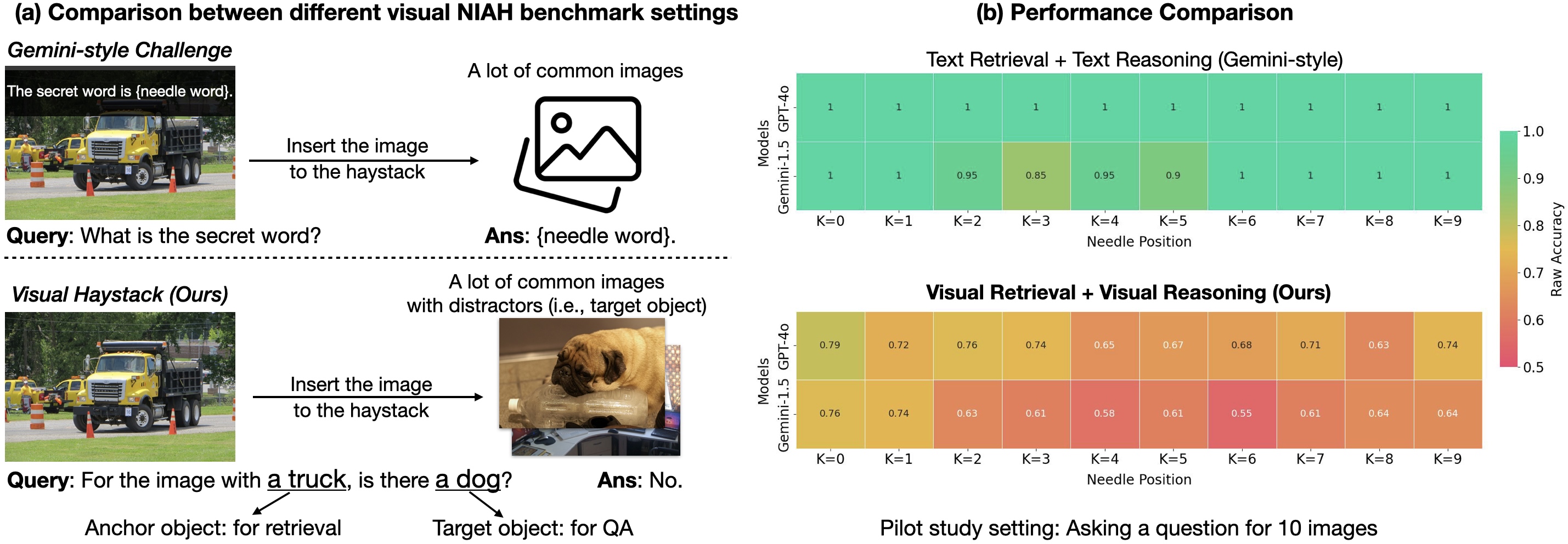

Os métodos tradicionais de Visual Question Answering (VQA) concentram-se em raciocinar sobre uma única imagem de cada vez. Ao longo dos anos, pesquisadores criaram sistemas de VQA para interpretar cenas em imagens isoladas, respondendo a perguntas sobre aquela imagem. Embora avanços recentes em modelos de base tenham reduzido a lacuna entre humanos e máquinas no processamento visual, o VQA convencional permaneceu limitado a uma única imagem por vez. Em cenários reais, porém, é comum lidar com grandes conjuntos de imagens ou fluxos visuais que exigem raciocínio entre imagens. Exemplos incluem analisar coleções médicas, monitorar desmatamento via imagens de satélite, mapear mudanças urbanas com dados de navegação autônoma, entender elementos temáticos de grandes coleções de arte ou compreender comportamento de consumidores a partir de câmeras de varejo. O desafio envolve não apenas processar visualmente várias imagens, mas também integrar as descobertas entre imagens. Para abordar esse gap, o projeto foca na tarefa Multi-Image Question Answering (MIQA), que ultrapassa o alcance de sistemas VQA tradicionais. Visual Haystacks é apresentado como a primeira benchmark visual-centra de NIAH para avaliar modelos multimodais grandes (LMMs) no processamento de informações visuais de longo contexto. O desafio NIAH tornou-se uma das abordagens mais populares para medir a capacidade de LLMs de lidar com entradas de “longos contextos”, incluindo documentos longos, vídeos ou centenas de imagens. O VHs utiliza aproximadamente 1K pares binários de perguntas e respostas, com cada conjunto contendo de 1 a 10K imagens. Ao contrário de benchmarks anteriores que se concentravam em recuperação textual e raciocínio, as perguntas do VHs envolvem identificar a presença de conteúdos visuais específicos (por exemplo, objetos) utilizando imagens e anotações do conjunto COCO. O benchmark é dividido em dois grandes desafios: Single-Needle e Multi-Needle, cada um testando a capacidade do modelo de localizar e analisar imagens relevantes antes de responder.

O que há de novo

Este trabalho introduz o Visual Haystacks (VHs) para avaliar LMMs na recuperação visual e no raciocínio através de grandes conjuntos de imagens não correlacionadas. Em experimentos, várias técnicas, incluindo LLaVA-v1.5, GPT-4o, Claude-3 Opus e Gemini-v1.5-pro, foram avaliadas, incluindo uma linha de baseline de legendagem (captions) em duas etapas onde imagens são legendadas com LLaVA e as respostas são geradas com Llama3. Principais constatações:

- Dificuldades com distratores visuais: em tarefas com apenas uma agulha, o desempenho dos modelos cai à medida que o haystack aumenta, mesmo com alta precisão de oracle; isso sugere que muitos modelos lutam com a recuperação visual quando há distratores. Observa-se ainda que modelos de código aberto, como o LLaVA, possuem limite de contexto de 2K, o que restringe o uso a cerca de três imagens na prática.

- Limites de contexto para modelos abertos e proprietários: modelos proprietários, como Gemini-v1.5 e GPT-4o, afirmam ter contexto estendido, mas muitas vezes não conseguem lidar com mais de 1K imagens devido a limites de tamanho de payload na API. Em geral, há quedas de desempenho com haystacks grandes.

- Dificuldade de raciocínio entre imagens: em tarefas com 5+ imagens, a maioria dos LMMs performa mal em QA de várias imagens, e até abordagens simples de legenda + LLM às vezes superam modelos end-to-end em MIQA.

- Posição da agulha: a posição da agulha na sequência de entrada afeta fortemente o desempenho. O LLaVA tende a ter melhor desempenho quando a agulha aparece imediatamente antes da pergunta; modelos proprietários costumam performar melhor quando a imagem está no início, com quedas significativas se não for assim. Para enfrentar esses desafios, os autores propõem MIRAGE (Multi-Image Retrieval Augmented Generation), um paradigma de treinamento simples de estágio único que estende o LLaVA para tarefas MIQA. A arquitetura MIRAGE inclui:

- Compressão de encodings: um compressor orientado a consultas reduz os tokens do codificador visual a aproximadamente 10x menor, permitindo considerar mais imagens dentro do mesmo limite de contexto.

- Recuperador integrado: um recuperador treinado em conjunto com o ajuste fino do LLM para prever se uma imagem é relevante para a pergunta; imagens irrelevantes são descartadas dinamicamente.

- Dados de treinamento multi-imagem: MIRAGE amplia dados de ajuste fino de instruções com imagens únicas, incluindo dados sintéticos para treinamento multi-imagem. Reavaliando o VHs com MIRAGE, o sistema mostrou capacidades robustas em conjuntos de 1K e 10K imagens, atingindo desempenho de ponta na maioria das tarefas de single-needle, mesmo com uma base de QA de apenas 32 tokens por imagem. Em tarefas multi-imagem, MIRAGE demonstrou recall e precisão fortes, superando significativamente concorrentes como GPT-4, Gemini-v1.5 e o Large World Model (LWM). Além disso, o sistema apresentou desempenho competitivo na QA de imagem única. Os autores também compararam o retriever co-treinado com CLIP. O retriever treinado em conjunto superou o CLIP sem perder eficiência, sugerindo que CLIP pode ser eficaz para recuperação de imagens de vocabulário amplo, mas pode não funcionar bem quando a tarefa envolve textos no estilo de perguntas. Os resultados apontam três deficiências recorrentes em LMMs frente a MIQA: (1) dificuldades em filtrar distratores visuais em grandes pools de imagens não relacionadas; (2) desafios em integrar informações visuais relevantes de várias imagens para raciocinar corretamente; (3) um efeito perceptivo de “perdido no meio” acentuado pela posição do conteúdo relevante na sequência de contexto. Em resposta, o artigo defende MIRAGE como um caminho prático para melhorar a robustez de raciocínio visual com longo contexto.

Por que isso importa (impacto para desenvolvedores/empresas)

O Visual Haystacks expõe lacunas relevantes na capacidade atual de LMMs lidarem com dados visuais de longo contexto, cada vez mais comum em aplicações reais que requerem análise de grandes coleções de imagens ou fluxos visuais contínuos. Para desenvolvedores e empresas, as lições-chave são:

- A qualidade da recuperação é crucial: a habilidade de identificar imagens relevantes dentro de grandes volumes é determinante para um raciocínio multi-imagem preciso.

- Limites de contexto são restrições práticas: muitos modelos líderes têm limites de imagens utilizáveis ou enfrentam restrições de payload ao lidar com grandes conjuntos de imagens.

- Arquiteturas simples e abertas podem superar modelos end-to-end em MIQA: MIRAGE mostra que combinar um backbone de legendagem forte com recuperação e compressão pode gerar desempenho robusto.

- Caminhos práticos de implantação: um MIRAGE similar pode habilitar sistemas empresariais para realizar análises visuais complexas, como triagem médica, interpretação de imagens de satélite, ou analytics de varejo sem depender de sistemas multi-modais extremamente grandes. O estudo também evidencia que desenvolvedores devem priorizar mecanismos eficazes de recuperação entre imagens e integração entre múltiplas imagens ao construir sistemas destinados a raciocinar sobre longos contextos visuais. A ênfase em componentes de código aberto e em um regime de treinamento escalável oferece um roteiro concreto para equipes que buscam implementar capacidades MIQA em produção.

Detalhes técnicos ou Implementação (seleção)

O VHs centra-se em duas ideias centrais: recuperação robusta a partir de grandes conjuntos de imagens e integração eficaz de informações de várias imagens para formar uma resposta coerente. O MIRAGE implementa essas ideias através de:

- Compressão de encodings visuais: um compressor orientado a consulta reduz os tokens do codificador visual para uma representação muito menor, permitindo considerar mais imagens dentro do limite de contexto.

- Recuperador integrado: um recuperador treinado junto com o ajuste fino do LLM para prever a relevância da imagem para a pergunta; imagens irrelevantes são descartadas de forma dinâmica.

- Dados de treinamento multi-imagem: MIRAGE amplia dados de ajuste fino com conteúdo de várias imagens, além de dados sintéticos para treinar raciocínio entre imagens.

- Capacidade de 1K ou 10K imagens: o método é projetado para lidar com haystacks grandes, com provas de conceito em tarefas de needle único e múltiplo. Em termos práticos, MIRAGE atinge resultados fortes no benchmark VHs, superando várias baselines em tarefas de needle único e mantendo desempenho competitivo em tarefas multi-needle. O retriever é comparado com CLIP, com o retriever co-treinado apresentando melhor desempenho sem sacrificar a eficiência. Isso destaca que mesmo modelos de recuperação de vocabulário amplo (como CLIP) podem não ser ideais quando a tarefa envolve texto com formato de pergunta. A pesquisa reforça três deficiências centrais em LMMs para MIQA: (1) dificuldades em filtrar distratores em grandes coleções; (2) desafios em integrar informações relevantes de várias imagens para um raciocínio correto; (3) efeito de “perdido no meio” sensível à posição do conteúdo relevante na sequência de contexto. Com MIRAGE, os autores oferecem um caminho prático para melhorar a capacidade de raciocínio visual com contexto longo, mantendo a viabilidade de implantação.

Perguntas frequentes (FAQ)

- Q: O que é Visual Haystacks (VHs)? A: VHs é um benchmark visual centrado em Needle-In-A-Haystack para avaliar LMMs em processamento de informações visuais de longo contexto, com cerca de 1K pares de perguntas e respostas distribuídos em haystacks de 1 a 10K imagens.

- Q: Quais são as tarefas-chave em VHs? A: Single-Needle e Multi-Needle, que exigem localizar a imagem-alvo em um haystack e responder se o conteúdo está presente nas imagens relevantes.

- Q: O que é MIRAGE? A: MIRAGE é um regime de treinamento de estágio único, de código aberto, que estende o LLaVA para MIQA, incluindo compressão de encodings, recuperador treinado e dados de treinamento multi-imagem para raciocínio entre imagens.

- Q: Como os modelos atuais se saem no VHs? A: Os modelos mostram quedas de desempenho com haystacks maiores e com distratores visuais. MIRAGE apresenta resultados fortes em tarefas de needle único e compete bem em situações de várias imagens, indicando avanços potenciais, mas ainda existem desafios em MIQA.

Referências

More news

Como reduzir gargalos do KV Cache com NVIDIA Dynamo

O Dynamo da NVIDIA transfere o KV Cache da memória da GPU para armazenamento de custo mais baixo, permitindo janelas de contexto maiores, maior concorrência e menor custo de inferência em grandes modelos.

Reduzindo a Latência de Cold Start para Inferência de LLM com NVIDIA Run:ai Model Streamer

Análise detalhada de como o NVIDIA Run:ai Model Streamer reduz o tempo de cold-start na inferência de LLMs ao transmitir pesos para a memória da GPU, com benchmarks em GP3, IO2 e S3.

Otimize o acesso a alterações de conteúdo ISO-rating com Verisk Rating Insights e Amazon Bedrock

Verisk Rating Insights, impulsionado pelo Amazon Bedrock, LLMs e RAG, oferece uma interface conversacional para acessar mudanças ERC ISO, reduzindo downloads manuais e aumentando a velocidade e a precisão das informações.

Como a msg otimizou a transformação de RH com Amazon Bedrock e msg.ProfileMap

Este post mostra como a msg automatizou a harmonização de dados para o msg.ProfileMap usando o Amazon Bedrock para alimentar fluxos de enriquecimento de dados alimentados por LLM, elevando a precisão na correspondência de conceitos de RH, reduzindo trabalho manual e alinhando-se ao EU AI Act e ao GD

Automatize pipelines RAG avançadas com SageMaker AI da AWS

Aperfeiçoe a experimentação até a produção para Retrieval Augmented Generation (RAG) com SageMaker AI, MLflow e Pipelines, promovendo fluxos reprodutíveis, escaláveis e com governança.

Como o Treinamento com Quantização Detecta e Recupera Precisão em Inferência de Baixa Precisão

Explora quantization aware training (QAT) e distilação quantization aware (QAD) como métodos para recuperar precisão em modelos de baixa precisão, usando o TensorRT Model Optimizer da NVIDIA e formatos FP8/NVFP4/MXFP4.