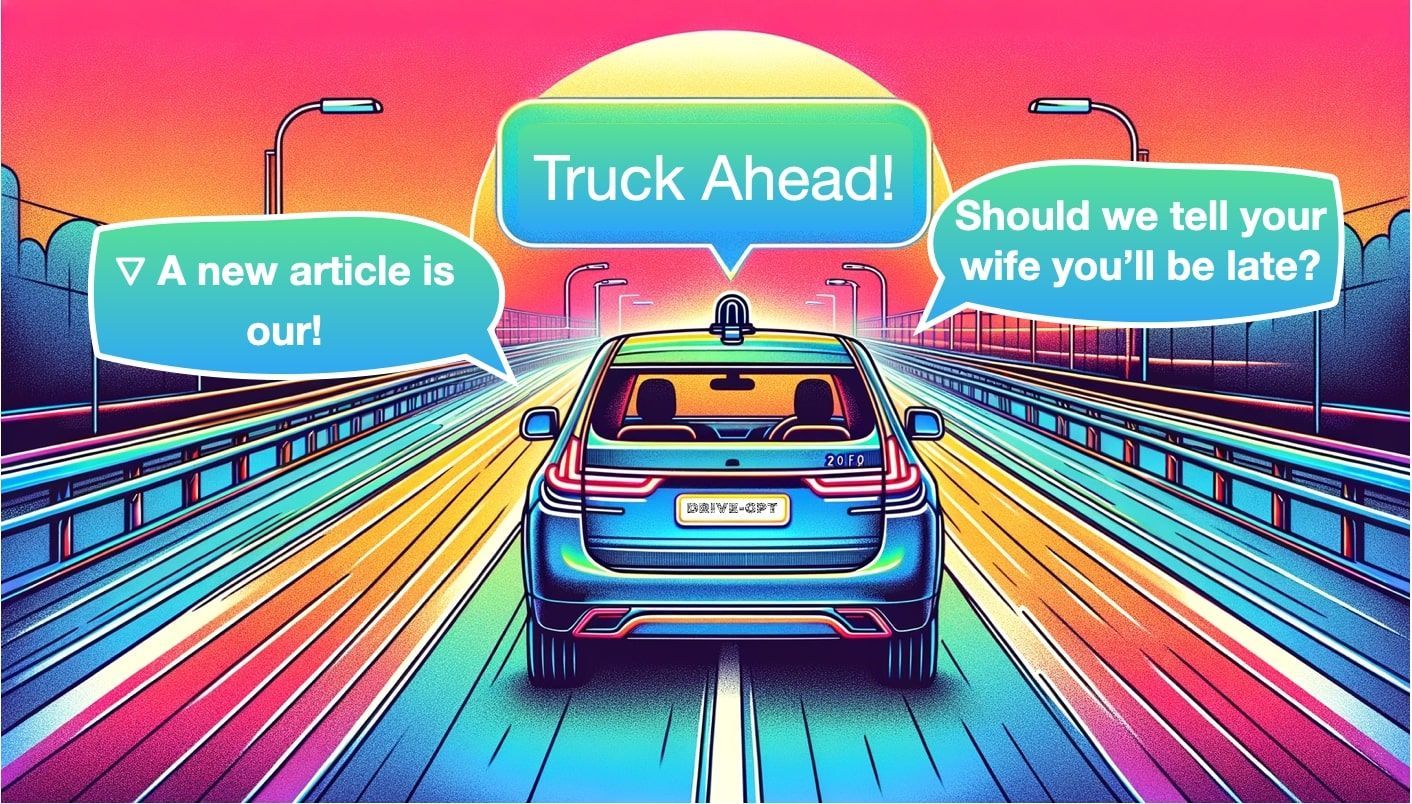

Car-GPT: Será que os LLMs finalmente tornam os carros autônomos uma realidade?

Sources: https://thegradient.pub/car-gpt, thegradient.pub

TL;DR

- Modelos de linguagem (LLMs) estão sendo estudados para condução autônoma em percepção, predição/planejamento e geração, com exemplos como Talk2BEV, GAIA-1 e DriveGPT, além de abordagens de percepção enriquecida por linguagem.

- Pesquisas iniciais destacam benefícios e grandes desafios, incluindo confiabilidade, possíveis alucinações e a preocupação com a caixa-preta em sistemas críticos de segurança.

- A área valoriza abordagens híbridas onde LLMs augmentam saídas de percepção (por exemplo, mapas BEV) ou orientam o planejamento, em vez de substituir todos os módulos de forma imediata.

- A ideia de um uso futuro envolve modelos para perguntas e respostas (Q&A) ou orientação do modelo de mundo em veículos, mas uso vivo em carros ainda é uma área ativa de estudo desde meados de 2023.

- O panorama aponta várias direções: percepção, previsão/planejamento, geração de cenas, e prompts para guiar o comportamento do modelo; há uma pesquisa para consolidar evoluções até a data.

Contexto e antecedentes

A condução autônoma avançou de uma arquitetura modular tradicional para uma fase de experimentação com aprendizagem de ponta a ponta (End-To-End), na qual uma única rede neural tenta prever direção e aceleração. A pilha modular comum divide o software em Perception (ver o mundo), Localização (se localizar com precisão), Planning (traçar uma trajetória) e Controle (executar comandos). Essa divisão facilita testes e avaliações de segurança, mesmo quando equipes exploram abordagens End-To-End que reduzem a transparência dos módulos — o que aumenta o problema da caixa-preta. Em termos de tarefas centrais, percepção envolve entrada de imagens (ou feeds de várias visões) e saídas como detecção de objetos e lanes; planejamento traduz percepções em trajetórias; e tracking vincula objetos ao longo de quadros com IDs para manter consistência temporal. Recentemente, pesquisadores estudam como LLMs — tradicionalmente usados para linguagem natural — podem auxiliar ou englobar funções de condução. A ideia é que LLMs possam raciocinar sobre informações textuais e visuais, produzir orientações ou restrições e ajudar a traduzir saídas de percepção em decisões acionáveis. Vários trabalhos concretos emergiram. Em Perception, modelos como HiLM-D e MTD-GPT tratam detecção; abordagens como PromptTrack adicionam IDs aos objetos rastreados usando algoritmos de correspondência bipartita (ex.: algoritmo de Hungarian) para manter correspondências entre quadros. No planejamento, projetos como Talk2BEV reformulam o planejamento em torno de representações BEV e utilizam prompts de linguagem para moldar decisões de condução. Outros trabalhos, como DriveGPT, passam saídas de Perception para o ChatGPT para gerar trajetórias de condução. Sistemas que focam BEV facilitam a compreensão espacial para o LLM e podem melhorar a interpretabilidade. Além disso, existem modelos que geram cenas futuras a partir de percepções ou entradas textuais: GAIA-1 da Wayve aceita texto e imagens para produzir vídeos, usando um World Model para entender interações e dinâmicas. Modelos como MagicDrive também utilizam a saída de Perception para gerar cenas futuras, enquanto Driving Into the Future e Driving Diffusion exploram a geração de cenários com base no estado atual. Em resumo, existem três famílias proeminentes de uso de LLMs em carros autônomos: Percepção, Previsão/Planejamento e Geração. Uma pergunta crucial continua sendo a confiabilidade dessas abordagens em uso real, diante de preocupações com alucinações e com a necessidade de maior transparência em sistemas de segurança.

O que há de novo

O que distingue o debate atual é a moldura explícita de LLMs como componentes que podem ampliar ou guiar pipelines tradicionais, em vez de substituir todos os módulos por redes apenas linguísticas. Avanços recentes enfatizam percepções enriquecidas por linguagem (por exemplo, usando prompts para recortar regiões ou inspecionar zonas específicas) e planejamento guiado por linguagem que pode raciocinar em BEV ou outras representações.

- Melhorias de percepção: modelos aumentados com linguagem podem descrever cenas, identificar objetos e atribuir IDs, com a ideia de informar o planejamento subsequente. Abordagens combinam entradas de múltas visões com uma base Encoder-Decoder e usam prompts para refinar resultados ou direcionar a atenção.

- Planejamento com orientação linguística: modelos como Talk2BEV usam prompts para moldar decisões, enquanto entradas BEV simplificam o raciocínio espacial para o LLM e aumentam a interpretabilidade.

- Geração e modelagem de mundo: geração de vídeos a partir de texto/imagem (GAIA-1) demonstra como dados de percepção podem se transformar em saídas visuais plausíveis, útil para treinamento, validação e planejamento sob incerteza. A narrativa também enfatiza a interpretabilidade das decisões guiadas por LLMs. Embora eles possam oferecer maior flexibilidade, o risco de alucinações e outputs não determinísticos permanece um desafio central. O texto afirma ser cedo para saber se LLMs podem ser usados com confiabilidade ao vivo em veículos, recomendando validação de segurança, testes e evidência prática. A direção sugerida é a de usar LLMs para ampliar, explicar ou restringir sistemas de condução existentes, em vez de substituí-los completamente.

Por que isso importa (impacto para desenvolvedores/empresas)

Para desenvolvedores e players automotivos, a integração de LLMs em direção autônoma traz potenciais benefícios e riscos correspondentes. Entre os benefícios, há maior flexibilidade na interpretação de dados de percepção, fluxos de trabalho de operador com linguagem mais acessível e a possibilidade de explicar o raciocínio por trás das decisões quando combinado com representações como BEV. Entre os riscos, destacam-se confiabilidade, alucinações e governança de segurança. A natureza de caixa-preta de componentes de IA permanece um obstáculo para adoção em contextos críticos. Embora avancem os progressos em interpretabilidade, ainda estamos no estágio inicial de uso online em estradas, além de treinamentos e validações offline. Para empresas, a mensagem é que LLMs para direção autônoma não é uma solução única, mas um conjunto de abordagens que podem complementar pilhas existentes. Organizações podem começar incorporando capacidades guiadas por linguagem sobre pipelines de percepção ou mapas BEV, expandindo gradualmente o papel dos LLMs à medida que a segurança, os testes e o monitoramento amadurecem. O momento exato permanece incerto, e uma trajetória cautelosa baseada em evidências é aconselhável.

Detalhes técnicos ou Implementação

O artigo apoia a discussão com conceitos e mecanismos concretos, que aparecem em várias linhas de modelos citados:

- Tokenização e topologia do modelo: LLMs convertem texto em tokens, que podem ser palavras, subpalavras ou caracteres. Diferentes modelos (ChatGPT, LLaMA, etc.) tokenizam entradas de forma distinta, mas o princípio subjacente é transformar texto em representações numéricas processáveis pela rede.

- Percepção, detecção e rastreamento: em percepção, modelos produzem um conjunto de objetos, faixas e recursos relacionados. Alguns sistemas (p. ex., HiLM-D, MTD-GPT) tratam detecção; outros (p. ex., PromptTrack) adicionam IDs aos objetos rastreados usando algoritmos de correspondência bipartita como o algoritmo de Hungarian para manter a correspondência entre quadros.

- BEV como entrada para planejamento: várias abordagens trocam entradas multi-visão por representações BEV. BEV simplifica o raciocínio espacial; alguns modelos treinam com entradas BEV para gerar decisões de condução. Talk2BEV é um exemplo que integra BEV com planejamento guiado por linguagem.

- Planejamento com orientação por linguagem e modelos de mundo: DriveGPT e Driving Diffusion mostram pipelines onde saídas de percepção (ou mapas BEV) alimentam um modelo de linguagem que ajuda a produzir trajetórias de condução ou a projetar cenários futuros. GAIA-1 amplia essa ideia ao aceitar texto e imagens para produzir vídeos usando um World Model que entende interações e dinâmicas.

- Loop de dados e avaliação: a narrativa aponta o potencial de geração de dados (cenários futuros) para treinar e validar modelos, ampliando a cobertura de cenários de condução.

- Modelos e agregação: embora haja várias referências a modelos específicos, o foco é traçar um ecossistema: Percepção, Previsão/Planejamento e Geração. A ideia central é que a confiabilidade em tempo real ainda precisa de validação robusta. | Família de modelo | Foco central | Tarefas de exemplo |---|---|---| | Percepção | Detecção de objetos, lanes | Detectar, classificar e rastrear objetos; atribuir IDs |Previsão/Planejamento | Gerar trajetórias de condução, entender cenas | Planejamento de rota, sugestões de ações |Geração | Produzir cenas futuras ou vídeos a partir de entradas | Geração de vídeos a partir de texto/imagens; saídas de modelos de mundo | Em termos de implementação, o artigo ressalta a necessidade de validação prática de LLMs em sistemas de segurança. O caminho sugerido envolve o uso de LLMs para ampliar, explicar ou restringir pilhas existentes de condução autônoma, com caveats de confiabilidade, alucinações e governança. A mensagem é ser cauteloso, testar em ambientes controlados e buscar evidências de desempenho em cenários reais.

Pontos-chave

- LLMs podem aumentar percepção, planejamento e geração em direção autônoma, especialmente via mapas BEV enriquecidos por linguagem e prompts que guiam a atenção.

- Abordagens híbridas (LLMs para ampliar ou explicar sistemas existentes) parecem mais viáveis no curto prazo do que substituir todos os módulos por linguagem.

- Há experimentação ativa com geração de futuros cenários e trajetórias, abrindo caminhos para dados de treinamento mais ricos.

- Confiabilidade, alucinações e governança de segurança continuam como grandes desafios; usos ao vivo ainda são precauções, com validação necessária.

- O ecossistema tende a combinar saídas de percepção com raciocínio linguístico, ao invés de uma solução única; a primeira onda de trabalhos sobre LLMs em carros começou por volta de meados de 2023, com pesquisas de evolução em andamento.

FAQ

-

LLMs já são prontos para uso ao vivo em carros autônomos?

inda é cedo para determinar, com a necessidade de validação de segurança, testes e evidências práticas além do treinamento ou uso offline.

-

uais papéis os LLMs podem desempenhar hoje?

LLMs podem ampliar saídas de percepção, orientar planejamento com prompts linguagem e gerar/interpretar cenas futuras, sem substituir totalmente os módulos centrais ainda.

-

uais são os maiores desafios?

Confiabilidade, alucinações e a natureza de caixa-preta em contextos de segurança são questões centrais.

-

uais modelos ou abordagens são destacados?

HiLM-D, MTD-GPT (percepção), PromptTrack (rastreamento); Talk2BEV (planejamento BEV); GAIA-1 (geração de vídeo a partir de texto/imagem); MagicDrive, Driving Into the Future e Driving Diffusion (geração de cenários/trajectórias).

-

Onde posso aprender mais sobre o tema?

O artigo citado e suas referências oferecem uma visão sobre as evoluções até o momento; acesse: https://thegradient.pub/car-gpt

Referências

More news

Como reduzir gargalos do KV Cache com NVIDIA Dynamo

O Dynamo da NVIDIA transfere o KV Cache da memória da GPU para armazenamento de custo mais baixo, permitindo janelas de contexto maiores, maior concorrência e menor custo de inferência em grandes modelos.

Reduzindo a Latência de Cold Start para Inferência de LLM com NVIDIA Run:ai Model Streamer

Análise detalhada de como o NVIDIA Run:ai Model Streamer reduz o tempo de cold-start na inferência de LLMs ao transmitir pesos para a memória da GPU, com benchmarks em GP3, IO2 e S3.

Otimize o acesso a alterações de conteúdo ISO-rating com Verisk Rating Insights e Amazon Bedrock

Verisk Rating Insights, impulsionado pelo Amazon Bedrock, LLMs e RAG, oferece uma interface conversacional para acessar mudanças ERC ISO, reduzindo downloads manuais e aumentando a velocidade e a precisão das informações.

Como a msg otimizou a transformação de RH com Amazon Bedrock e msg.ProfileMap

Este post mostra como a msg automatizou a harmonização de dados para o msg.ProfileMap usando o Amazon Bedrock para alimentar fluxos de enriquecimento de dados alimentados por LLM, elevando a precisão na correspondência de conceitos de RH, reduzindo trabalho manual e alinhando-se ao EU AI Act e ao GD

Automatize pipelines RAG avançadas com SageMaker AI da AWS

Aperfeiçoe a experimentação até a produção para Retrieval Augmented Generation (RAG) com SageMaker AI, MLflow e Pipelines, promovendo fluxos reprodutíveis, escaláveis e com governança.

Implante Inferência de IA Escalável com NVIDIA NIM Operator 3.0.0

O NVIDIA NIM Operator 3.0.0 amplia a inferência de IA escalável no Kubernetes, permitindo implantações multi-LLM e multi-nó, integração com KServe e suporte a DRA em modo de tecnologia, com colaboração da Red Hat e NeMo Guardrails.