Scaleway rejoint les Fournisseurs d’Inference de Hugging Face pour une Inférence Serverless et Faible Latence

Sources: https://huggingface.co/blog/inference-providers-scaleway, Hugging Face Blog

TL;DR

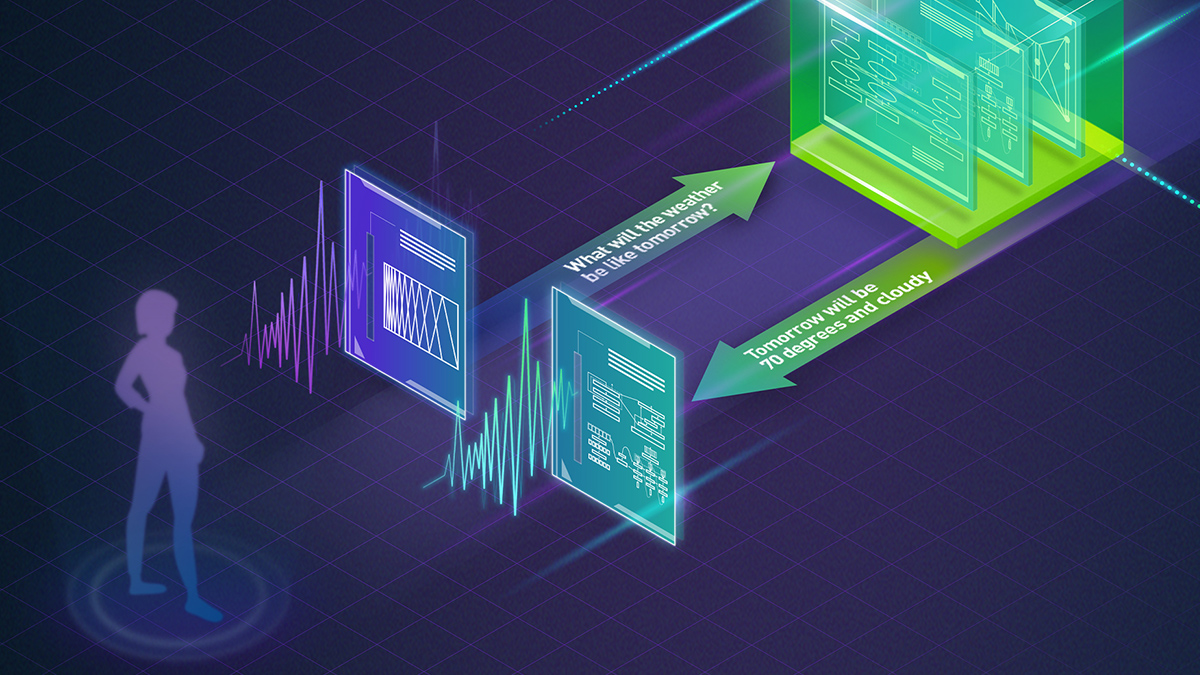

- Scaleway devient un Fournisseur d’Inference pris en charge sur le Hub Hugging Face, élargissant l’écosystème pour l’inférence serverless.

- Les Fournisseurs d’Inference s’intègrent dans les SDK clients JS et Python de Hugging Face, facilitant l’usage à travers les modèles.

- Vous pouvez accéder à des modèles open-weight populaires (par ex., gpt-oss, Qwen3, DeepSeek R1, Gemma 3) directement via Hugging Face avec Scaleway comme fournisseur.

- Scaleway Generative APIs offre un service serverless, entièrement géré, avec des tarifs à partir de €0,20 par million de tokens, des centres de données européens (Paris) et une latence

References

More news

Prévoir les phénomènes météorologiques extrêmes en quelques minutes sans superordinateur : Huge Ensembles (HENS)

NVIDIA et le Lawrence Berkeley National Laboratory présentent Huge Ensembles (HENS), un outil IA open source qui prévoit des événements météorologiques rares et à fort impact sur 27 000 années de données, avec des options open source ou prêtes à l’emploi.

Surveiller l’inférence par lot Bedrock d’AWS via les métriques CloudWatch

Apprenez à surveiller et optimiser les jobs d’inférence par lot Bedrock via CloudWatch, with alertes et tableaux de bord pour améliorer les performances, les coûts et l’exploitation.

Créer des flux de travail agentiques avec GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore

Vue d’ensemble complète sur le déploiement des modèles GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore pour alimenter un analyseur d’actions multi-agents avec LangGraph, incluant la quantification MXFP4 en 4 bits et une orchestration sans serveur.

Autodesk Research mène la CFD à vitesse Warp sur le NVIDIA GH200

Autodesk Research, Warp de NVIDIA et le GH200 démontrent une CFD Python-native avec XLB, atteignant environ 8x de vitesse et évoluant jusqu’à 50 milliards de cellules.

Réduire la latence de démarrage à froid pour l’inférence LLM avec NVIDIA Run:ai Model Streamer

Analyse approfondie sur la façon dont NVIDIA Run:ai Model Streamer abaisse les temps de démarrage à froid pour l’inférence des LLM en diffusant les poids vers la mémoire GPU, avec des benchmarks sur GP3, IO2 et S3.

Qwen3-Next Modèles MoE Hybrides Open Source : Précision Améliorée et Inférence Plus Rapide sur la Plateforme NVIDIA

Les prévisualisations open source Qwen3-Next 80B-A3B-Thinking et 80B-A3B-Instruct présentent une architecture MoE hybride pour un contexte long et une inférence efficace, avec déploiement et outils ouverts soutenus par NVIDIA.