Faire passer vos agents IA du concept à la production avec Amazon Bedrock AgentCore

Sources: https://aws.amazon.com/blogs/machine-learning/move-your-ai-agents-from-proof-of-concept-to-production-with-amazon-bedrock-agentcore, https://aws.amazon.com/blogs/machine-learning/move-your-ai-agents-from-proof-of-concept-to-production-with-amazon-bedrock-agentcore/, AWS ML Blog

TL;DR

- Amazon Bedrock AgentCore offre une voie de production pour l’IA basée sur des agents, en couvrant mémoire, sécurité, observabilité et gestion d’outils évolutive. source

- L’architecture évolue d’un prototype simple vers un agent doté de mémoire, capable de maintenir le contexte entre les sessions et de gérer plusieurs utilisateurs simultanément tout en respectant les normes d’entreprise.

- L’approche privilégie la mémoire d’abord, puis les outils centralisés via Gateway, l’identité, l’observabilité et enfin une interface client pour supporter l’échelle.

- L’utilisation de hook mémoire et d’automatisation avec AgentCore Memory et Strands Agents montre comment passer du PoC à une production prête sans réinventer les bases. source

- Bien que l’exemple démarre avec une architecture à agent unique, AgentCore prend en charge les déploiements multi-agent et les patterns de sécurité et de fiabilité pour l’entreprise. source

Contexte et contexte

Construire un agent d’IA prêt pour le monde réel est bien plus qu’un prototype ingénieux. Le passage en production nécessite d’adresser l’évolutivité, la sécurité, l’observabilité et les opérations qui n’apparaissent que rarement dans le développement. Cet article présente Amazon Bedrock AgentCore comme un ensemble complet de services pour aider à faire passer des applications basées sur des agents du concept à des systèmes de production. Le récit suit un agent de support client qui évolue d’un prototypage local vers une solution d’entreprise capable de gérer plusieurs utilisateurs tout en préservant sécurité et performance. Le texte présente AgentCore comme un ensemble de services travaillant ensemble : AgentCore Runtime pour le déploiement et l’évolutivité, AgentCore Gateway pour le développement d’outils d’entreprise, AgentCore Identity pour sécuriser les agents à l’échelle, AgentCore Memory pour les conversations contextuelles, AgentCore Code Interpreter, AgentCore Browser Tool pour l’interaction web et AgentCore Observability pour la transparence du comportement de l’agent. L’objectif est de montrer comment ces services coopèrent pour résoudre les défis opérationnels qui émergent à mesure que les applications basées sur des agents se maturent. source Le cas d’usage se concentre sur le support client, un domaine à forte demande et à grande variabilité entre les demandes — des questions de politique à la résolution de problèmes techniques. Un agent véritablement intelligent doit gérer les commandes et les comptes, consulter les politiques de retour, rechercher des informations dans les catalogues produit, effectuer des recherches sur le web pour dépanner et mémoriser les préférences du client lors de multiples interactions. Le parcours vers la production commence par un prototype et évolue vers une solution d’entreprise capable de gérer plusieurs utilisateurs avec des normes de sécurité et de fiabilité. Le post précise que les implémentations de production peuvent adopter des architectures multi-agents, ce que prend en charge Bedrock AgentCore, même si l’exemple initial se limite à un seul agent pour illustrer. source L’article rappelle que tout système de production débute par un proof of concept. Dans l’exemple, un prototype utilise Strands Agents comme cadre open source et Claude 3.7 Sonnet d’Anthropic sur Bedrock comme modèle de langage (LLM) alimentant l’agent. Il est précisé que d’autres cadres et modèles peuvent être utilisés en pratique. Les agents dépendent d’outils pour agir et interagir avec des systèmes réels; l’exemple se concentre sur trois capacités clés : recherche de politique de retour, recherche d’informations produit et recherche web pour dépanner. Le code end-to-end est disponible dans le dépôt GitHub référencé dans l’article. source L’architecture du PoC met en avant un prototype fonctionnel démontrant les capacités centrales via trois outils. Le modèle utilisé est Claude 3.7 Sonnet sur Bedrock, bien que l’article précise que d’autres cadres et modèles peuvent être employés. L’idée centrale est que les outils permettent aux agents d’agir et d’interagir avec des systèmes réels, et que leur organisation en vue de la production est une exigence cruciale. source Un obstacle technique majeur est la mémoire. Bedrock AgentCore Memory fournit une mémoire persistante à deux niveaux complémentaires, permettant à l’agent de se souvenir du client sur plusieurs interactions et d’offrir des expériences plus personnalisées. La mémoire est pilotée par des stratégies configurables qui déterminent ce qu’il convient d’extraire et de stocker, et s’appuie sur l’automatisation via le système de hooks de Strands Agents pour gérer les opérations de mémoire automatiquement. Dans l’exemple, un CustomerSupportMemoryHooks récupère le contexte client et enregistre les interactions, connectant le mémoire au constructeur de l’agent pour activer la mémoire par session. Cette mémoire rend les réponses plus personnalisées en se basant sur l’historique du client. source Après l’intégration mémoire, l’article aborde l’évolution de l’architecture des outils pour éviter les duplications et améliorer l’évolutivité. Gateway centralise la gestion des outils afin d’améliorer la fiabilité et la sécurité, tandis que Identity renforce les contrôles d’accès à l’échelle. L’article rappelle que le PoC est une simplification et que les environnements de production peuvent supporter plusieurs agents et des outils partagés et sécurisés. source Le volet pratique inclut des étapes comme l’installation des dépendances (boto3, le SDK AgentCore et le Starter Toolkit SDK) pour accélérer l’intégration des capacités AgentCore. L’article renvoie aussi à un dépôt GitHub contenant le code end-to-end démontrant comment connecter un agent au Bedrock AgentCore et souligne que l’approche est adaptable à d’autres cadres et modèles. L’idée centrale est d’utiliser les services gérés du Bedrock AgentCore pour combler les lacunes de production plutôt que de tout construire soi-même. source

Pourquoi cela compte (impact pour les développeurs/entreprises)

Pour les développeurs, le passage d’un prototype local à la production exige de gérer mémoire, sécurité, fiabilité et observabilité à l’échelle. La mémoire Bedrock AgentCore supprime un obstacle clé — maintenir le contexte entre les sessions — et permet des expériences personnalisées plus riches. Pour les entreprises, Gateway centralise les outils de manière fiable et Identity offre des contrôles de sécurité évolutifs, réduisant les coûts de maintenance et les dérives entre les déploiements. L’observabilité apporte de la transparence sur le comportement de l’agent, aidant les équipes à surveiller les performances, à dépanner et à préserver la confiance dans les déploiements d’entreprise. En proposant une voie claire commençant par la mémoire et se déployant vers une plateforme sécurisée et observable multi-agent, l’article donne un cadre utile pour opérer l’IA basée sur des agents sans compromettre la gouvernance ou la fiabilité. source

Détails techniques ou Mise en œuvre (comment c’est construit)

Le PoC démarre avec un prototype fonctionnel montrant des capacités centrales à l’aide de trois outils : consultation des politiques de retour, recherche d’informations produit et recherche web pour dépanner. Le modèle de langage utilisé pour le PoC est Claude 3.7 Sonnet d’Anthropic sur Bedrock, bien que l’article précise que d’autres cadres et modèles peuvent être employés. L’idée est que les outils permettent aux agents d’agir et d’interagir avec des systèmes réels, et que leur organisation en vue de la production est une exigence clé. source La difficulté technique centrale est la mémoire. Bedrock AgentCore Memory offre une mémoire persistante à deux niveaux complémentaires, permettant à l’agent de se souvenir du client au fil des conversations et d’offrir des expériences plus personnalisées. La mémoire est pilotée par des stratégies configurables qui déterminent ce qui doit être extrait et stocké, et s’appuie sur l’automatisation via les hooks de Strands Agents pour gérer automatiquement les opérations de mémoire. Dans l’exemple, des CustomerSupportMemoryHooks récupèrent le contexte client et enregistrent les interactions, connectant la mémoire au constructeur de l’agent pour activer la mémoire par session. Cette mémoire transforme les interactions en expériences plus cohérentes et pertinentes. source Après la mémoire, l’article décrit comment structurer les outils pour favoriser la réutilisation et la sécurité dans un cadre multi-agent. Gateway centralise les outils pour plus de fiabilité et de contrôle, et Identity assure la sécurité des opérations des agents à grande échelle. Bien que l’exemple se concentre sur un seul agent, l’article rappelle que des architectures multi-agents sont prises en charge en production. source L’article conseille aussi des étapes pratiques, comme l’installation des dépendances (boto3, le SDK AgentCore et le Starter Toolkit SDK) pour accélérer l’intégration des capacités AgentCore. Le post mentionne un dépôt GitHub contenant le chemin end-to-end et les code snippets pour connecter un agent au Bedrock AgentCore, tout en restant adaptable à d’autres cadres et modèles. L’objectif est d’utiliser les services gérés du Bedrock AgentCore pour combler les lacunes de production plutôt que de tout construire soi-même. source

Points clés

- Les défis de production pour les systèmes basés sur des agents incluent mémoire, sécurité, observabilité et outils scalables; Bedrock AgentCore apporte des services dédiés pour répondre à ces besoins. source

- L’architecture axée sur la mémoire transforme les agents en assistants contextuels capables de personnalisation continue. source

- Gateway pour les outils centralisés et Identity pour la sécurité à l’échelle sont essentiels pour des déploiements multi-agents conformes. source

- L’observabilité et la gestion automatique de la mémoire réduisent les risques opérationnels et améliorent la gouvernance en production. source

- L’article présente Bedrock AgentCore comme un cadre général pour produire des IA basées sur des agents tout en restant adaptable à différents cadres et modèles. source

FAQ

-

Quel est le principal défi de production abordé en premier par Bedrock AgentCore?

La mémoire et le maintien du contexte entre les sessions, via AgentCore Memory et les hooks de mémoire. [source](https://aws.amazon.com/blogs/machine-learning/move-your-ai-agents-from-proof-of-concept-to-production-with-amazon-bedrock-agentcore/)

-

Les déploiements de production peuvent-ils utiliser plusieurs agents?

Oui, les architectures multi-agent sont prises en charge par Bedrock AgentCore. [source](https://aws.amazon.com/blogs/machine-learning/move-your-ai-agents-from-proof-of-concept-to-production-with-amazon-bedrock-agentcore/)

-

uel rôle jouent Gateway et Identity dans la production?

Gateway centralise la gestion des outils pour la fiabilité et la sécurité; Identity renforce les contrôles d’accès à l’échelle. [source](https://aws.amazon.com/blogs/machine-learning/move-your-ai-agents-from-proof-of-concept-to-production-with-amazon-bedrock-agentcore/)

-

Où trouver le code end-to-end décrit?

Le dépôt GitHub du post contient le chemin end-to-end montrant comment connecter un agent au Bedrock AgentCore. [source](https://aws.amazon.com/blogs/machine-learning/move-your-ai-agents-from-proof-of-concept-to-production-with-amazon-bedrock-agentcore/)

Références

More news

Surveiller l’inférence par lot Bedrock d’AWS via les métriques CloudWatch

Apprenez à surveiller et optimiser les jobs d’inférence par lot Bedrock via CloudWatch, with alertes et tableaux de bord pour améliorer les performances, les coûts et l’exploitation.

Prompting pour la précision avec Stability AI Image Services sur Amazon Bedrock

Bedrock intègre Stability AI Image Services avec neuf outils pour créer et modifier des images avec précision. Apprenez les techniques de prompting adaptées à l’entreprise.

Utiliser les AWS Deep Learning Containers avec SageMaker AI géré MLflow

Découvrez comment les AWS Deep Learning Containers (DLCs) s’intègrent à SageMaker AI géré par MLflow pour équilibrer le contrôle de l’infrastructure et une gouvernance ML robuste. Un flux TensorFlow pour la prédiction de l’âge des abalones illustre le suivi de bout en bout et la traçabilité des modè

Évoluer la production visuelle avec Stability AI Image Services dans Amazon Bedrock

Stability AI Image Services est désormais disponible dans Amazon Bedrock, offrant des capacités d’édition d’images prêtes à l’emploi via l’API Bedrock et étendant les modèles Stable Diffusion 3.5 et Stable Image Core/Ultra déjà présents.

Créer des flux de travail agentiques avec GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore

Vue d’ensemble complète sur le déploiement des modèles GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore pour alimenter un analyseur d’actions multi-agents avec LangGraph, incluant la quantification MXFP4 en 4 bits et une orchestration sans serveur.

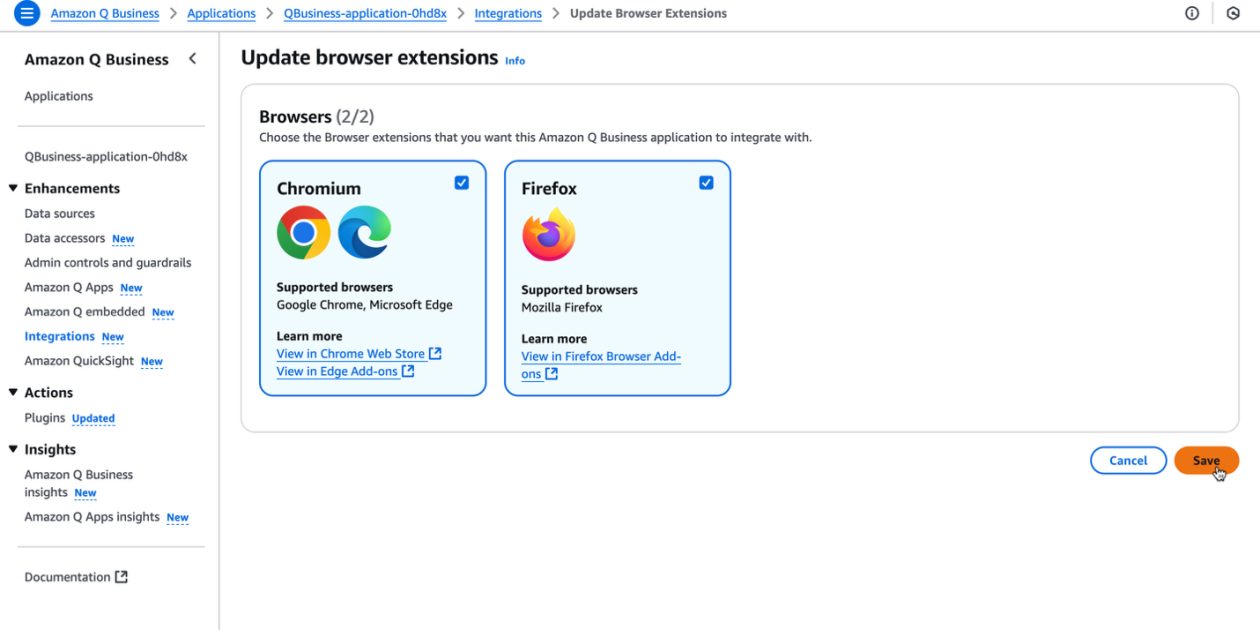

Boostez la productivité de votre organisation avec l’extension de navigateur Amazon Q Business

L’extension de navigateur Amazon Q Business apporte une assistance IA contextuelle et générative directement dans le navigateur pour les abonnés Lite et Pro, offrant des insights fiables et des flux de travail cohérents.