Qwen3-Next Modèles MoE Hybrides Open Source : Précision Améliorée et Inférence Plus Rapide sur la Plateforme NVIDIA

Sources: https://developer.nvidia.com/blog/new-open-source-qwen3-next-models-preview-hybrid-moe-architecture-delivering-improved-accuracy-and-accelerated-parallel-processing-across-nvidia-platform, https://developer.nvidia.com/blog/new-open-source-qwen3-next-models-preview-hybrid-moe-architecture-delivering-improved-accuracy-and-accelerated-parallel-processing-across-nvidia-platform/, NVIDIA Dev Blog

TL;DR

- Alibaba a publié deux modèles open source Qwen3-Next, 80B-A3B-Thinking et 80B-A3B-Instruct, présentant une architecture hybride Mixture of Experts (MoE) qui vise à améliorer la précision tout en accélérant le traitement parallèle sur les plateformes NVIDIA.

- Chaque modèle compte 80 milliards de paramètres, mais seulement environ 3 milliards sont activés par token en raison de la conception MoE creuse, offrant la puissance d’un modèle massif avec l’efficacité d’un modèle plus petit.

- Le module MoE routage entre 512 experts plus 1 expert partagé, avec 10 experts activés par token, permettant une inférence évolutive et un routage flexible.

- L’architecture prend en charge des longueurs de contexte supérieures à 260 000 tokens et utilise des Delta Networks gateés pour traiter efficacement les textes très longs, avec une croissance mémoire et calcul presque linéaire par longueur de séquence.

- Lorsqu’il est exécuté sur le matériel NVIDIA Hopper et Blackwell, le système bénéficie d’un NVLink de 5e génération à 1,8 To/s de bande passante GPU-à-GPU, réduisant la latence du routage des experts et augmentant le débit de tokens.

- NVIDIA collabore avec SGLang et vLLM pour déployer comme microservices NIM; les développeurs peuvent tester sur build.nvidia.com, accéder à des services NIM préconfigurés et explorer un guide Jupyter pour construire des agents IA via les endpoints NIM de Qwen3-Next.

Contexte et arrière-plan

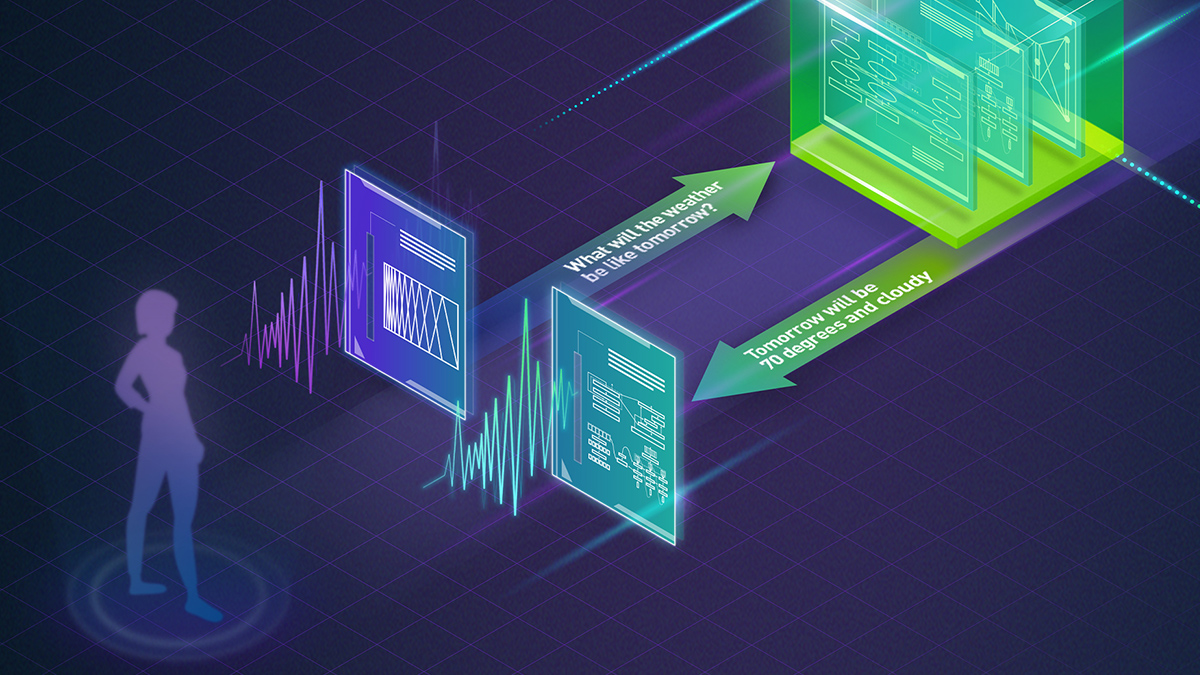

À mesure que les modèles IA gagnent en taille, l’efficacité devient aussi importante que l’échelle. Les séquences d’entrée très longues deviennent courantes, et il est nécessaire d’adresser des architectures qui offrent une haute précision tout en maintenant un débit raisonnable. Dans ce cadre, Alibaba a publié deux modèles Qwen3-Next open source—80B-A3B-Thinking et 80B-A3B-Instruct—pour démontrer une nouvelle approche hybride MoE destinée à la recherche et au développement. La famille Qwen3-Next vise à offrir les capacités de modèles très grands tout en maîtrisant l’usage des ressources grâce à la sparsité et à une communication inter-GPU optimisée. Cette initiative s’inscrit dans l’écosystème open source de NVIDIA, qui inclut des projets comme NeMo pour la gestion du cycle de vie de l’IA, Nemotron LLMs et Cosmos world foundation models (WFMs). L’objectif est d’accélérer l’innovation en rendant les modèles d’avant-garde plus accessibles, transparents et collaboratifs pour chercheurs et développeurs. NVIDIA met l’accent sur des voies d deployment ouvertes par le biais de frameworks open source comme SGLang et vLLM, et en empaquetant les modèles comme NVIDIA NIM (NVIDIA Inference Modules). Cette approche permet aux chercheurs et entreprises d’expérimenter et de déployer les Qwen3-Next via des endpoints hébergés ou des containers sur site, tout en explorant des workflows pratiques pour la construction d’agents dans des notebooks. L’objectif central de la conception hybride MoE est d’étendre l’efficacité et le raisonnement. L’association d’un routage MoE sparse avec des variantes d’attention optimisées et de nouveaux primitives mémoire-efficaces montre comment des modèles à grande échelle peuvent être accessibles et évalués par la communauté sans sacrifier la performance.

Ce qu’il y a de nouveau

Les previews Qwen3-Next 80B-A3B-Thinking et 80B-A3B-Instruct introduisent plusieurs innovations architecturales et de déploiement :

- Échelle et sparsité du modèle : chaque modèle compte 80 milliards de paramètres, mais seulement 3 milliards sont activés par token grâce à la structure MoE sparse. Cela permet une grande capacité avec un coût computationnel maîtrisé.

- Routage MoE et capacité : le module MoE comprend 512 experts routés plus 1 expert partagé, avec 10 experts activés par token. Ce routage permet une utilisation dynamique des sous-modules selon l’entrée, améliorant l’efficacité pour diverses tâches.

- Contexte long : l’architecture est optimisée pour des longueurs de contexte supérieures à 260K tokens, soutenue par des primitives mémoire et calcul efficaces.

- Design d’attention : le modèle possède 48 couches, chaque 4e couche appliquant une attention GQA tandis que les autres couches utilisent une variante d’attention linéaire. Cette approche hybride équilibre expressivité et efficacité pour les séquences longues.

- Delta Networks Gateés : les contributions des chercheurs en Delta Networks améliorent le focus lors du traitement de longs contextes, réduisant le drift et maintenant les informations pertinentes sur de longues passages.

- Matériel et interconnecteurs : les modèles sont conçus pour fonctionner sur les GPUs NVIDIA Hopper et Blackwell, utilisant NVLink 5e génération avec 1,8 To/s de bande passante pour réduire la latence du routage et soutenir des débits plus élevés.

- Logiciel et déploiement : l’approche hybride MoE est compatible avec CUDA et les outils de plateformes NVIDIA, permettant à la fois des couches d’attention complètes et des couches d’attention linéaire dans la stack Qwen3-Next. NVIDIA collabore aussi avec SGLang et vLLM pour faciliter le déploiement et l’empaquetage sous forme de microservices NIM, avec des endpoints hébergés et des déploiements sur site sécurisés.

- Accès ouvert et tooling : les développeurs peuvent tester les modèles sur build.nvidia.com, utiliser les endpoints NIM pour un déploiement pratique et explorer des guides Jupyter pour construire des agents avec les endpoints NIM du Qwen3-Next.

Pourquoi cela compte (impact pour les développeurs/entreprises)

La conception hybride MoE du Qwen3-Next vise à offrir des gains concrets en raisonnement et en throughput. En activant uniquement une faible fraction du modèle par token, ces architectures tentent de concilier la puissance de grands modèles avec l’efficacité typiquement associée à des modèles plus petits. Pour les développeurs et les entreprises, la nature open source de Qwen3-Next et les outils de déploiement NVIDIA réduisent les obstacles à l’expérimentation et à l’intégration en production. Les microservices NIM fournissent des endpoints prêts à l’emploi, tandis que les options on-site offrent des environnements sécurisés pour les flux IA en interne. La collaboration avec SGLang et vLLM diminue encore les frictions d’intégration pour le serving et l’expérimentation. D’un point de vue matériel, l’utilisation des GPUs Hopper et Blackwell avec NVLink à grande vitesse réduit la latence du routage entre des centaines d’experts et soutient un débit accru pour les charges de travail d’inférence IA. En pratique, cela peut se traduire par des réponses plus rapides pour des tâches de raisonnement à contexte long, un débit de tokens accru et des agents IA plus scalables en production. L’écosystème ouvert NVIDIA illustre un engagement envers l’ouverture, favorisant la collaboration entre chercheurs, développeurs et entreprises afin d’étendre l’accès à des architectures de pointe et de promouvoir la transparence et la co-création. En fournissant des déploiements de référence, des notebooks et des containers, NVIDIA cherche à accélérer l’innovation et à élargir l’accès aux architectures de modèles avancées.

Détails techniques ou Implémentation

Spécifications clés en bref

| Attribut | Valeur

| --- |

|---|

| Taille du modèle |

| Paramètres actifs par token |

| Routage MoE |

| Experts activés par token |

| Nombre de couches |

| Schéma d’attention |

| Longueur de contexte |

| Bande passante entre GPUs |

| Plateformes cibles |

| Options de déploiement |

| Disponibilité |

Remarques techniques

L’approche hybride MoE du Qwen3-Next répartit dynamiquement le calcul entre des centaines d’experts. Avec 10 experts actifs par token, le routage permet de distribuer le traitement, rendant possible une scalabilité du throughput et une amélioration du raisonnement pour des entrées variées. L’association d’une attention GQA et d’une attention linéaire sur 48 couches cherche à équilibrer la capacité de modélisation des dépendances à longue portée avec les contraintes computationnelles. Les Delta Networks gateés sont décrites comme permettant un meilleur maintien de l’attention sur des contextes très longs, réduisant le drift et conservant les informations pertinentes sur des passages étendus. Cela aide à faire croître la mémoire et le calcul presque linéairement avec la taille de la séquence. Du point de vue du deployment, l’intégration avec CUDA et les outils de plateforme de NVIDIA, associée à la collaboration avec SGLang et vLLM, crée des pistes pratiques pour la recherche et la production. Les entreprises peuvent explorer Qwen3-Next via des endpoints hébergés ou via des microservices sur site sécurisés et soutenus par des frameworks ouverts.

Points clés à retenir

- Qwen3-Next introduit une approche MoE esparse avec 80B paramètres, mais seulement 3B actifs par token, combinant grande capacité et efficacité.

- Capacité de contexte long (>260K tokens) associée à une scalabilité mémoire et calcul grâce aux Delta Networks gateés et à une combinaison d’attention GQA et linéaire.

- Interconnexions rapides (NVLink 1,8 To/s) et plateformes GPU (Hopper/Blackwell) pour réduire la latence et augmenter le débit.

- Accès ouvert via NIM de NVIDIA, SGLang et vLLM pour le développement et le déploiement; déploiements de référence, notebooks et endpoints disponibles.

- Le travail illustre l’engagement de NVIDIA envers l’ouverture, visant à élargir l’accès, la transparence et la collaboration dans l’IA.

FAQ

-

Qu’est-ce que le modèle 80B-A3B-Thinking du Qwen3-Next ?

C’est un modèle open source de 80 milliards de paramètres, conçu pour fonctionner avec une architecture hybride MoE esparse, permettant environ 3 milliards d’actifs par token et un traitement de contexte long.

-

Comment fonctionne l’architecture MoE dans ces modèles ?

Le module MoE comprend 512 experts routés plus 1 expert partagé, avec 10 experts activés par token. Ce routage distribue la computation entre sous-modules pour équilibrer capacité et efficacité.

-

u’est-ce qui permet le contexte long et l’efficacité ?

Un contexte de plus de 260 000 tokens, Delta Networks gateés pour maintenir le focus sur de longues séquences et une combinaison d’attention GQA et linéaire sur 48 couches.

-

Comment les développeurs peuvent-ils accéder et déployer ces modèles ?

Via build.nvidia.com pour les tests, deployment avec les microservices NIM, et options on-site sécurisées avec support SGLang et vLLM.

-

uelle est la portée plus large de ce travail ?

Il illustre une voie vers des modèles de grande échelle avec une efficacité pratique, favorise le code ouvert et fournit des chemins concrets de déploiement sur les plateformes NVIDIA. ---

Références

More news

NVIDIA HGX B200 réduit l’intensité des émissions de carbone incorporé

Le HGX B200 de NVIDIA abaisse l’intensité des émissions de carbone incorporé de 24% par rapport au HGX H100, tout en offrant de meilleures performances IA et une efficacité énergétique accrue. Cet article résume les données PCF et les nouveautés matérielles.

Scaleway rejoint les Fournisseurs d’Inference de Hugging Face pour une Inférence Serverless et Faible Latence

Scaleway est désormais un Fournisseur d’Inference pris en charge sur Hugging Face Hub, permettant l’inférence serverless directement sur les pages de modèles avec les SDK JS et Python. Accédez à des modèles open-weight populaires et bénéficiez d’une latence réduite.

Prévoir les phénomènes météorologiques extrêmes en quelques minutes sans superordinateur : Huge Ensembles (HENS)

NVIDIA et le Lawrence Berkeley National Laboratory présentent Huge Ensembles (HENS), un outil IA open source qui prévoit des événements météorologiques rares et à fort impact sur 27 000 années de données, avec des options open source ou prêtes à l’emploi.

Comment réduire les goulots d’étranglement KV Cache avec NVIDIA Dynamo

NVIDIA Dynamo déporte le KV Cache depuis la mémoire GPU vers un stockage économique, permettant des contextes plus longs, une meilleure concurrence et des coûts d’inférence réduits pour les grands modèles et les charges AI génératives.

Le Playbook des Grands Maîtres Kaggle: 7 Techniques de Modélisation pour Données Tabulaires

Analyse approfondie de sept techniques éprouvées par les Grands Maîtres Kaggle pour résoudre rapidement des ensembles de données tabulaires à l’aide d’une accélération GPU, des baselines divers à l’assemblage et à la pseudo-étiquetage.

NVIDIA RAPIDS 25.08 Ajoute un Nouveau Profiler pour cuML, Améliorations du moteur GPU Polars et Support d’Algorithmes Étendu

RAPIDS 25.08 introduit deux profils pour cuml.accel (fonctionnel et ligne), l’exécuteur streaming par défaut du moteur Polars GPU, un support de types et chaînes étendu, Spectral Embedding dans cuML et des accélérations zéro-code pour plusieurs estimateurs.