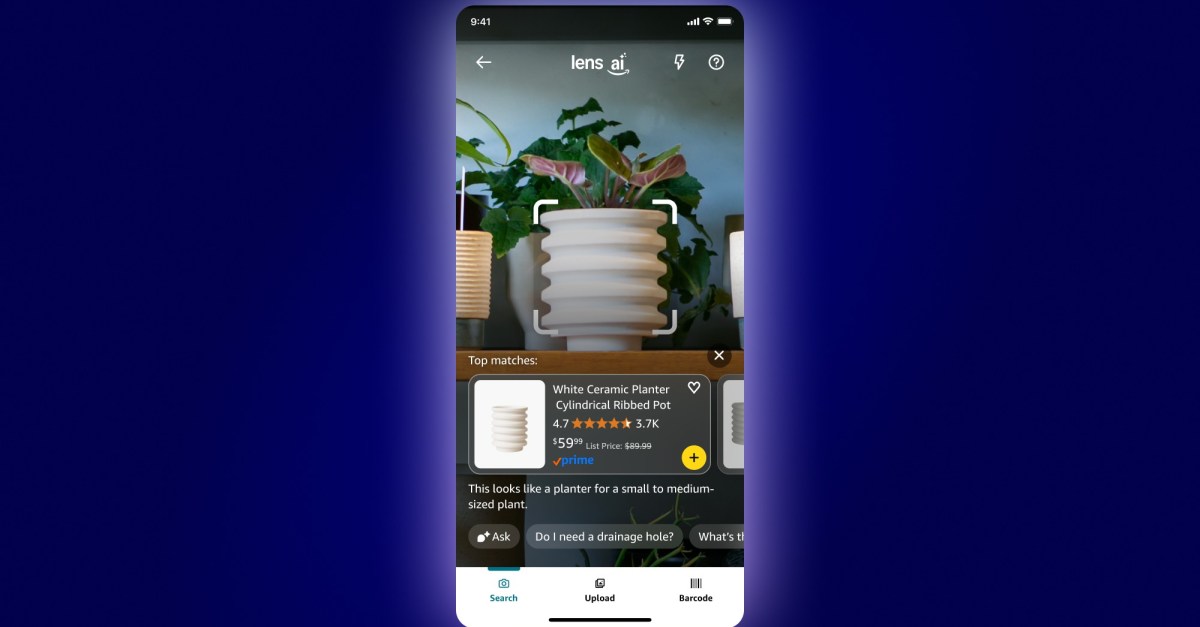

Amazon Lens Live IA : achats en temps réel en pointant votre caméra

Sources: https://www.theverge.com/news/769585/amazon-lens-live-ai-real-time-shopping, The Verge AI

TL;DR

- Lens Live permet d’acheter en pointant votre caméra, en scannant l’environnement pour faire apparaître des listes de produits correspondants en temps réel.

- Elle recourt à un modèle de détection d’objets pour identifier les articles et les comparer à des milliards de fiches du catalogue Amazon, avec des résultats présentés dans un carrousel à faire défiler.

- Des options permettent d’ajouter les articles au panier ou à la liste de souhaits, et Rufus peut résumer les descriptions et répondre aux questions.

- Lens Live est en cours de déploiement sur l’application Amazon Shopping pour iOS et arrivera à plus d’utilisateurs dans les prochaines semaines; c’est l’approche d’Amazon face aux outils de balayage en direct, avec un accent sur l’achat.

Contexte et historique

Amazon propose déjà des capacités de recherche visuelle dans l’application Shopping, notamment l’envoi d’images, le balayage de codes-barres et les recherches par photo. Lens Live étend ces fonctionnalités en autorisant la reconnaissance d’objets en temps réel dans l’environnement de l’utilisateur lorsque vous faites pivoter ou focalisez la caméra. The Verge présente Lens Live comme la réponse d’Amazon à des expériences de balayage en direct similaires à Gemini Live de Google, mais en insistant sur l’achat direct lorsque des articles sont identifiés. Le catalogue Amazon est exploité pour afficher des correspondances issues de milliards de produits.

Nouvelles fonctionnalités

Lens Live utilise un modèle de détection d’objets pour identifier les produits visibles dans le flux de la caméra en temps réel. Dès qu’un article est reconnu, Lens Live le compare au marketplace d’Amazon pour afficher des articles similaires ou correspondants. L’utilisateur voit un carrousel défilant avec des correspondances, et peut directement ajouter au panier ou à la wishlist. L’expérience peut être guidée par une exploration d’une pièce ou par la focalisation sur un produit spécifique. En plus des informations produit, Lens Live intègre Rufus, l’assistant IA d’Amazon, pour résumer les descriptions et répondre aux questions. Cette fonction s’appuie sur les capacités visuelles existantes d’Amazon, qui permettaient déjà des recherches par image, balayage de code-barres et captures photo dans l’application. Amazon indique que Lens Live est en déploiement sur iOS pour le moment et qu’un élargissement est prévu dans les semaines à venir.

Pourquoi cela compte (impact pour les développeurs/entreprises)

Lens Live illustre un flux d’achat en temps réel alimenté par l’IA au sein d’une application grand public. Pour les développeurs, c’est un exemple de comment une détection d’objets en direct peut être associée à un catalogue étendu pour proposer des correspondances exploitables directement dans l’interface. L’intégration de Rufus montre une voie pour combiner des résumés produits et des questions-réponses avec des résultats de recherche en direct, ce qui peut accélérer les parcours d’achat et réduire les lacunes d’informations au moment de la décision. Du point de vue d’entreprise, cela souligne la valeur croissante de l’IA multimodale dans le commerce de détail : perception en temps réel, comparaison avec le catalogue et actions d’achat immédiates dans une appli, avec l’appui d’un assistant IA pour les informations immédiates.

Détails techniques ou Mise en œuvre

Lens Live s’appuie sur un modèle de détection d’objets capable d’identifier les produits visibles dans le flux de la caméra en temps réel. Lorsqu’un article est reconnu, le système le compare à des milliards d’articles répertoriés sur le marketplace d’Amazon pour afficher des correspondances ou des articles similaires. Les résultats s’affichent dans un carrousel défilant, avec des actions directes pour ajouter au panier ou à la wishlist. La disponibilité actuelle est limitée à l’application Amazon Shopping sur iOS, avec une expansion prévue dans les semaines à venir. Lens Live intègre également Rufus, l’assistant IA d’Amazon, pour résumer les descriptions et répondre aux questions sur les articles identifiés. Cette intégration vise à aider les utilisateurs à comprendre rapidement les détails sans sortir du flux de balayage. L’approche s’appuie sur les capacités existantes de recherche visuelle d’Amazon, qui permettaient déjà des recherches par image, scanning de codes et requêtes photo.

Points clés

- Lens Live permet l’identification en temps réel et l’achat en pointant la caméra dans l’application Amazon Shopping (iOS, déploiement progressif).

- Il utilise un modèle de détection d’objets et compare les résultats à des milliards de fiches pour afficher des correspondances.

- Un carrousel défilant présente les articles correspondants avec des options d’ajout au panier ou à la wishlist.

- Rufus est intégré pour résumer les descriptions et répondre aux questions sur les articles.

- Le déploiement doit s’étendre dans les semaines à venir, montrant l’engagement d’Amazon envers des expériences d’achat pilotées par l’IA dans les applications.

FAQ

-

- **Q : Qu’est-ce que Lens Live ?**

Lens Live est une fonctionnalité alimentée par IA qui utilise la caméra pour scanner l’environnement en temps réel et présenter des listings de produits correspondants dans le catalogue d’Amazon. - **Q : Où Lens Live est-il disponible actuellement ?** **A :** Il est déployé sur l’application Amazon Shopping pour iOS et s’étendra à davantage d’utilisateurs dans les semaines à venir. - **Q : Comment Lens Live identifie-t-il les articles ?** **A :** Il utilise un modèle de détection d’objets pour identifier les produits visibles dans la caméra en temps réel et les comparer à des milliards de fiches d’Amazon. - **Q : Que se passe-t-il après l’identification ?** **A :** Un carrousel affiche les correspondances, avec des options pour ajouter au panier ou à la wishlist, et Rufus peut résumer les descriptions et répondre aux questions.

Références

More news

Premier aperçu de l'app Google Home propulsée par Gemini

The Verge rapporte que Google met Gemini dans l'application Google Home avec une refonte majeure et la nouvelle fonction 'Ask Home'.

Shadow Leak montre comment les agents ChatGPT peuvent exfiltrer des données Gmail via injection de prompt

Des chercheurs en sécurité ont démontré une attaque par injection de prompt baptisée Shadow Leak, utilisant Deep Research de ChatGPT pour exfiltrer discrètement des données d'une boîte Gmail. OpenAI a corrigé la faille; l'affaire illustre les risques des IA agentisées.

Les démonstrations ratées des lunettes intelligentes Live AI de Meta n’avaient rien à voir avec le Wi‑Fi, affirme le CTO

Les démonstrations en direct des lunettes Ray‑Ban avec Live AI de Meta ont connu des échecs embarrassants. Le CTO Andrew Bosworth explique les causes, dont un trafic auto-imposé et un bug rare d’appel vidéo, et précise que le bug est corrigé.

OpenAI envisagerait un haut-parleur intelligent, des lunettes, un enregistreur vocal et un pin avec Jony Ive

OpenAI explorerait une famille d'appareils IA avec l'ancien chef du design d'Apple, Jony Ive, incluant un haut-parleur sans écran, des lunettes intelligentes, un enregistreur vocal et un pin portable, avec une sortie visée fin 2026 ou début 2027.

Comment les chatbots et leurs créateurs alimentent la psychose liée à l’IA

Analyse de la psychose liée à l’IA, de la sécurité des adolescents et des questions juridiques à mesure que les chatbots se multiplient, selon les reportages de Kashmir Hill pour The Verge.

Google étend Gemini dans Chrome avec un déploiement multiplateforme et sans abonnement

Gemini IA dans Chrome accède aux onglets, à l’historique et aux propriétés Google, déployé sur Mac et Windows aux États-Unis sans frais, avec automatisation des tâches et intégrations Workspace.