Rencontrez Boti : l’assistant IA qui transforme l’accès des Buenos Airesiens à l’information gouvernementale avec Amazon Bedrock

Sources: https://aws.amazon.com/blogs/machine-learning/meet-boti-the-ai-assistant-transforming-how-the-citizens-of-buenos-aires-access-government-information-with-amazon-bedrock, https://aws.amazon.com/blogs/machine-learning/meet-boti-the-ai-assistant-transforming-how-the-citizens-of-buenos-aires-access-government-information-with-amazon-bedrock/, AWS ML Blog

TL;DR

- La Ville de Buenos Aires a collaboré avec AWS GenAIIC pour créer un assistant IA agentique utilisant LangGraph et Amazon Bedrock, capable de répondre aux questions sur les procédures gouvernementales.

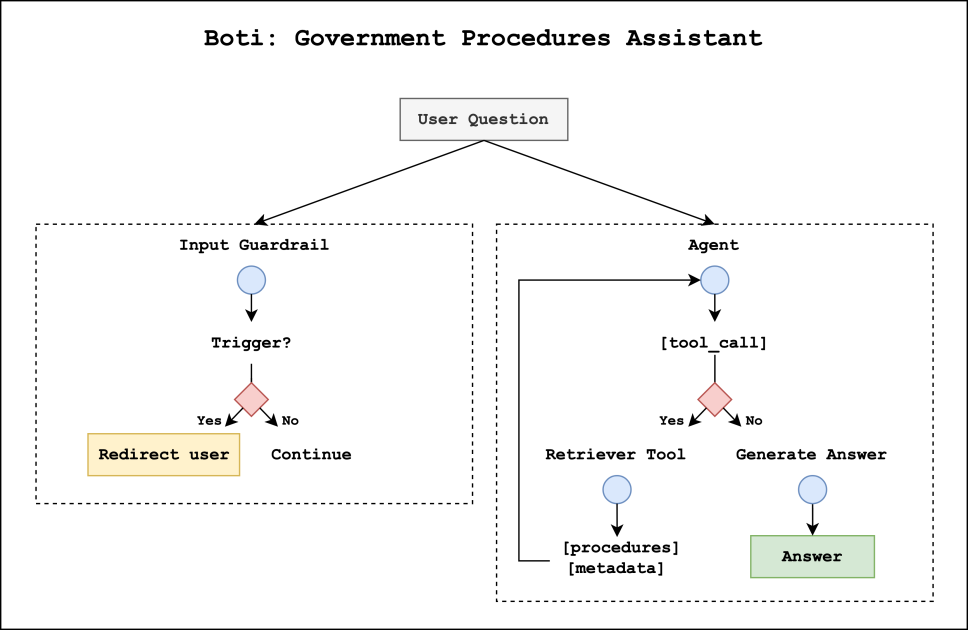

- La solution comporte deux composants: un système de garde (guardrail) pour classer les requêtes et un agent de procédures gouvernementales qui récupère et compose les réponses.

- Un flux de récupération raisonné s’appuie sur des résumés comparatifs pour dissocier des procédures similaires, avec jusqu’à 98,9% de précision top-1 et une amélioration de 12,5 à 17,5% par rapport aux méthodes RAG classiques.

- Les garde-fous ont bloqué 100% des requêtes nocives lors des évaluations; les experts ont constaté 98% de précision du voseo et 92% de précision du futur periphrastique.

- Le projet étend l’accès de Boti au-delà des plus de 3 millions de conversations mensuelles déjà gérées via WhatsApp, en reliant les citoyens à plus de 1 300 procédures gouvernementales.

Contexte et antécédents

Depuis 2019, Boti a été utilisé via WhatsApp, le canal le plus courant pour les informations municipales en Argentine. Cet assistant permettait d’accéder à des informations telles que le renouvellement du permis de conduire, les services de santé et les événements culturels. Cette plateforme est devenue un canal majeur de communication publique, générant plus de 3 millions de conversations par mois. Face à une population croissante et à la complexité du paysage procédural, la Ville a voulu exploiter les avancées de l’IA générative pour répondre précisément aux questions sur les procédures et orienter les citoyens vers les procédures pertinentes. En collaboration avec AWS GenAIIC, l’équipe a construit un système d’IA agentique associant LangGraph et Amazon Bedrock. Deux composants clés structurent la solution: un garde-fou d’entrée et un agent de procédures gouvernementales. Le garde-fou repose sur un classificateur LLM personnalisé qui évalue les requêtes et détermine si elles doivent être traitées. Les requêtes approuvées passent à l’agent qui récupère les informations et produit une réponse dans le ton distinctif de Boti, en espagnol rioplatense. La Ville conserve plus de 1 300 procédures gouvernementales, chacune avec sa propre logique et ses exceptions, ce qui rend nécessaire une approche de désambiguïsation et de récupération précise. Pour la base de connaissances et l’inférence, les équipes utilisent les Bedrock Knowledge Bases et l’API Bedrock Converse pour exécuter les LLMs, en privilégiant une adaptation linguistique au Rioplatense et en insistant sur le voseo et le futur periphrastique.

Nouveautés

Le système d’IA agentique propose deux composants qui opèrent en parallèle lors d’une requête. D’abord, le garde-fou analyse la requête et décide si elle peut être traitée on-topic; si elle est nocive, l’exécution est interrompue et l’utilisateur est redirigé vers des questions conformes. Si elle est approuvée, l’agent de procédures prend le relais pour générer la réponse. Ensuite, l’agent peut appeler un outil de récupération pour obtenir le contexte pertinent depuis les Bedrock Knowledge Bases, garantissant des réponses précises et à jour. L’inférence se fait via l’API Bedrock Converse, avec un éventail de LLMs afin d’optimiser les performances et la latence. Une innovation clé est le flux de récupération par raisonnement, qui commence par la création d’une base de connaissances des procédures comprenant des informations de base (objectif, public, coûts, étapes, exigences) et des résumés comparatifs décrivant ce qui distingue chaque procédure. Les résumés sont regroupés dans des clusters (~5 par groupe) et enrichis par une description des différences, générée par un LLM pour composer le résumé final discriminant. Cette approche rappelle la Contextual Retrieval d’Anthropic, qui ajoute du contexte explicatif avant les extraits. Le Reasoning Retriever reçoit les textes complets des procédures récupérées, suit son propre raisonnement pour identifier le contenu pertinent et les URL sources lors de la génération de la réponse, et fournit le contexte pour la réponse finale. Dans une évaluation sur un ensemble synthétique de 1 908 questions, le Reasoning Retriever a largement dépassé les méthodes RAG usuelles en termes de précision de récupération top-k. Les évaluations ont montré que les embeddings Cohere Multilingual, associés à des étapes de raisonnement utilisant Claude/Haiku sur Bedrock, donnent des performances particulièrement solides, avec tous les top-k supérieurs à 90% et des résultats supérieurs sur les mesures top-k. Sur le plan linguistique, les experts ont mesuré 98% de précision du voseo et 92% de précision du futur periphrastique, montrant que Boti délivre des réponses à la fois exactes et adaptées au dialecte local.

Pourquoi cela compte (impact pour les développeurs/entreprises)

Cette mise en œuvre démontre comment une administration peut faire évoluer un assistant IA capable de gérer un vaste répertoire de procédures tout en garantissant sécurité et exactitude. L’approche guardrail personnalisée illustre comment les organisations peuvent adapter des systèmes IA génératifs à des normes locales et des langues sans compromettre la sécurité. Pour les entreprises, le projet fournit un modèle d’architecture pratique: un système en deux couches qui protège les utilisateurs tout en permettant une récupération complexe sur une base de connaissances bien structurée. L’utilisation conjointe de Bedrock Knowledge Bases et Bedrock Converse API montre comment obtenir une inferénce LLM scalable dans des contextes gouvernementaux. Le projet met aussi en évidence l’importance de l’évolutivité et de la précision dans des domaines où les procédures et les exigences peuvent changer fréquemment, tout en offrant une expérience utilisateur fluide et naturelle en espagnol Rioplatense.

Détails techniques ou Mise en œuvre

- Architecture: deux flux parallèles lors de chaque requête — guardrail d’entrée et agent de procédures. Le guardrail attribue une catégorie primaire (approuvé ou bloqué) et une sous-catégorie; les requêtes approuvées passent à l’agent; les requêtes bloquées sont redirigées vers des contenus sûrs.

- Guardrail: classificateur LLM personnalisé pour détecter le contenu nocif (langage offensant, opinions dangereuses, injections de prompt, comportements non éthiques). À l’évaluation, le guardrail a bloqué 100% des requêtes nocives, avec quelques requêtes normales signalées comme nocives de manière conservatrice.

- Agent: récupère le contexte depuis Bedrock Knowledge Bases et génère des réponses en espagnol Rioplatense.

- Construction du knowledge base: métadonnées des procédures (objectif, public, coûts, étapes, exigences) plus résumés comparatifs décrivant les différences entre les procédures; les résumés sont groupés et enrichis par des descriptions de différences générées par un LLM.

- Reasoning Retriever: après la récupération initiale, applique un raisonnement pour identifier les procédures pertinentes et les sources à citer, assurant la traçabilité.

- Évaluation et modèles: des versions standard (Titan, Summaries Titan, Summaries Cohere) et des configurations avec Reasoning Retriever utilisant Cohere et Claude/Haiku sur Bedrock ont été comparées. Les embeddings Cohere Multilingual et le raisonnement par LLM ont donné des résultats supérieurs, avec excellents scores top-k au-delà de 90% et jusqu’à 98,9% top-1 dans certaines configurations.

- Inférence et latence: l’inférence utilise l’API Bedrock Converse pour exécuter les LLMs et optimiser le temps de réponse.

- Qualité linguistique: les experts ont observé 98% de précision du voseo et 92% précision du futur periphrastique dans les réponses.

Points clés à retenir

- Un système IA en deux couches (garde-fous + agent) peut être déployé à grande échelle pour gérer des procédures gouvernementales tout en maintenant sécurité et précision.

- Des garde-fous personnalisés par langue et contexte local permettent d’assurer la sécurité sans sacrifier l’utilité.

- Le flux de récupération par raisonnement améliore l’équalification des résultats et la désambiguïsation dans des domaines à règles complexes.

- Bedrock Knowledge Bases + Bedrock Converse API permettent une inference LLM intégrée et évolutive pour des tâches d’information gouvernementale.

- Le Boti peut délivrer des réponses rapides et adaptées localement, tout en restant conforme et traçable.

FAQ

-

- **Q : Quel est l’objectif de Boti ?**

ider les citoyens à accéder à des informations sur les procédures gouvernementales en répondant aux questions et en orientant vers la bonne procédure. - **Q : Comment fonctionne le guardrail d’entrée ?** **A :** Il utilise un classificateur LLM personnalisé qui décide entre approuvé ou bloqué; les requêtes approuvées passent à l’agent; les requêtes bloquées sont redirigées. - **Q : Qu’est-ce que le Reasoning Retriever et pourquoi l’utiliser ?** **A :** Il utilise des résumés comparatifs et une sélection basée sur LLM pour désambiguïser les procédures et identifier les résultats les plus pertinents. - **Q : Quels résultats de performance ont été observés ?** **A :** Le guardrail a bloqué 100% des requêtes nocives lors de l’évaluation et le Reasoning Retriever a atteint jusqu’à 98,9% d’exactitude top-1, avec une amélioration de 12,5–17,5% face au RAG standard. Les experts ont mesuré 98% de précision du voseo et 92% du futur periphrastique. - **Q : Quelles technologies soutiennent la solution ?** **A :** LangGraph, Amazon Bedrock, Bedrock Knowledge Bases et Bedrock Converse API.

Références

- AWS ML Blog: Meet Boti: The AI assistant transforming how the citizens of Buenos Aires access government information with Amazon Bedrock. https://aws.amazon.com/blogs/machine-learning/meet-boti-the-ai-assistant-transforming-how-the-citizens-of-buenos-aires-access-government-information-with-amazon-bedrock/

More news

Faire passer vos agents IA du concept à la production avec Amazon Bedrock AgentCore

Une exploration détaillée de la façon dont Amazon Bedrock AgentCore aide à faire passer des applications IA basées sur des agents du proof of concept à des systèmes de production de niveau entreprise, en préservant mémoire, sécurité, observabilité et gestion d’outils à l’échelle.

Surveiller l’inférence par lot Bedrock d’AWS via les métriques CloudWatch

Apprenez à surveiller et optimiser les jobs d’inférence par lot Bedrock via CloudWatch, with alertes et tableaux de bord pour améliorer les performances, les coûts et l’exploitation.

Prompting pour la précision avec Stability AI Image Services sur Amazon Bedrock

Bedrock intègre Stability AI Image Services avec neuf outils pour créer et modifier des images avec précision. Apprenez les techniques de prompting adaptées à l’entreprise.

Utiliser les AWS Deep Learning Containers avec SageMaker AI géré MLflow

Découvrez comment les AWS Deep Learning Containers (DLCs) s’intègrent à SageMaker AI géré par MLflow pour équilibrer le contrôle de l’infrastructure et une gouvernance ML robuste. Un flux TensorFlow pour la prédiction de l’âge des abalones illustre le suivi de bout en bout et la traçabilité des modè

Évoluer la production visuelle avec Stability AI Image Services dans Amazon Bedrock

Stability AI Image Services est désormais disponible dans Amazon Bedrock, offrant des capacités d’édition d’images prêtes à l’emploi via l’API Bedrock et étendant les modèles Stable Diffusion 3.5 et Stable Image Core/Ultra déjà présents.

Créer des flux de travail agentiques avec GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore

Vue d’ensemble complète sur le déploiement des modèles GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore pour alimenter un analyseur d’actions multi-agents avec LangGraph, incluant la quantification MXFP4 en 4 bits et une orchestration sans serveur.