Mercury, modèles de base d'Inception Labs disponibles sur Amazon Bedrock Marketplace et SageMaker JumpStart

Sources: https://aws.amazon.com/blogs/machine-learning/mercury-foundation-models-from-inception-labs-are-now-available-in-amazon-bedrock-marketplace-and-amazon-sagemaker-jumpstart, https://aws.amazon.com/blogs/machine-learning/mercury-foundation-models-from-inception-labs-are-now-available-in-amazon-bedrock-marketplace-and-amazon-sagemaker-jumpstart/, AWS ML Blog

TL;DR

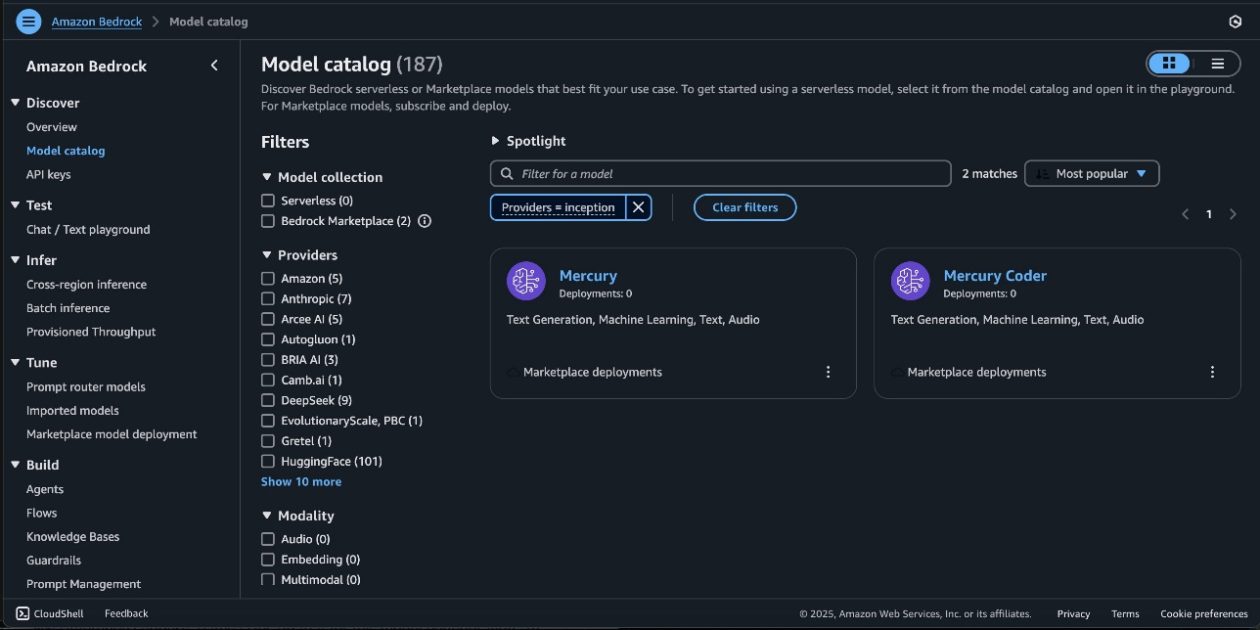

- Mercury et Mercury Coder, les modèles de base d’Inception Labs, sont désormais disponibles via Amazon Bedrock Marketplace et Amazon SageMaker JumpStart.

- Mercury utilise la génération par diffusion pour produire plusieurs tokens en parallèle, offrant une inférence plus rapide que les modèles autoregressifs traditionnels.

- L’accès via Bedrock Marketplace et JumpStart comprend des essais dans le Bedrock playground et un déploiement via SageMaker Studio ou le SageMaker Python SDK.

- Une démonstration montre un jeu de morpion complet avec IA minimax généré en une seule réponse à 528 tokens par seconde, illustrant la qualité du code généré et la vitesse.

- Mercury prend en charge des capacités avancées d’utilisation d’outils, lui permettant d’appeler des fonctions externes en fonction des requêtes utilisateur, permettant des agents IA qui interagissent avec des API et des bases de données. Pour plus de détails, consultez l’article d’origine sur le blog AWS ML décrivant la disponibilité et les capacités. AWS ML Blog.

Contexte et historique

Mercury représente la première famille de modèles de langage basés sur la diffusion à l’échelle commerciale, développée par Inception Labs. La génération par diffusion diffère des modèles autoregressifs traditionnels en produisant plusieurs tokens en parallèle grâce à un processus coarse-to-fine, ce qui permet une inférence à faible latence tout en conservant une haute qualité. Mercury Coder étend ces capacités aux tâches de génération de code. Ces modèles visent à répondre aux besoins des entreprises en matière de vitesse, fiabilité et sécurité lors de l’utilisation d’IA générative sur AWS. Bedrock Marketplace donne accès à un catalogue étendu de modèles de base, y compris Mercury et Mercury Coder, tandis que SageMaker JumpStart propose des modèles pré-entraînés et des flux de travail optimisés pour le déploiement et le MLOps. Ensemble, ils permettent d’explorer, déployer et tester Mercury dans un environnement AWS sécurisé, avec des options pour s’exécuter dans le VPC du client et pour tirer parti des outils Bedrock via Converse API. Cette annonce s’inscrit dans la lignée des directives AWS visant à intégrer les modèles de base via Bedrock et JumpStart, et met en relief le rôle des hubs de modèles dans JumpStart (par exemple, Mistral pour diverses tâches). L’objectif est d’accélérer l’expérimentation et l’adoption responsable de l’IA générative à grande échelle sur AWS.

Nouveautés

- Mercury et Mercury Coder sont désormais accessibles via Amazon Bedrock Marketplace et Amazon SageMaker JumpStart. Vous pouvez déployer ces modèles par diffusion pour concevoir, tester et déployer des applications d’IA générative sur AWS.

- Les modèles prennent en charge les tailles Mini et Small, permettant de choisir l’empreinte du modèle en fonction des exigences de latence, coût et débit.

- L’accès se fait via deux voies intégrées :

- Bedrock Marketplace : les pages de détail du modèle fournissent les capacités, les structures tarifaires et les consignes de mise en œuvre. Vous pouvez vous abonner, tester dans le Bedrock playground et déployer des endpoints. L’API Converse peut être utilisée pour invoquer le modèle à partir des outils Bedrock.

- SageMaker JumpStart : Mercury et Mercury Coder apparaissent dans les hubs JumpStart et peuvent être déployés via SageMaker Studio ou programmiquement via le SageMaker Python SDK. Les hubs JumpStart offrent un catalogue de modèles pré-entraînés pour diverses tâches.

- Le déploiement s’effectue dans un environnement AWS sécurisé et dans votre VPC, répondant aux exigences de sécurité des entreprises. Vous serez guidé sur les permissions IAM nécessaires pour déployer le modèle et sur les abonnements au modèle via AWS Marketplace.

- Après le déploiement, vous pouvez tester l’endpoint en envoyant une charge utile d’exemple ou en utilisant les options de test du SDK. L’article fournit un exemple concret de déploiement du Mercury via le SageMaker SDK et de vérification des capacités par une tâche simple de génération de code.

- Mercury prend en charge des capacités avancées d’utilisation d’outils, permettant de déterminer quand et comment appeler des fonctions externes en fonction des requêtes de l’utilisateur. Cela ouvre la voie à des agents IA capables d’interagir avec des systèmes externes, des APIs et des bases de données.

- L’article donne également des conseils de nettoyage des ressources pour éviter les coûts, avec des instructions pour supprimer les endpoints lorsque vous avez fini.

Accéder et déployer

Vous pouvez accéder aux modèles Mercury via Bedrock Marketplace et SageMaker JumpStart. Bedrock Marketplace expose des paquets de modèles et offre un playground de test pour l’exploration rapide, tandis que JumpStart propose un flux de déploiement géré dans SageMaker Studio ou via JumpStart. Pour déployer, vérifiez vos ressources et permissions IAM, abonnez-vous au paquet de modèle, obtenez l’ARN du paquet et l’utilisez pour créer un modèle déployable via le code. L’article décrit un exemple de déploiement de Mercury via le SageMaker SDK et démontre comment tester l’endpoint après le déploiement. Un exemple de tic-tac-toe illustre les capacités de génération et la rapidité du modèle, avec 528 tokens par seconde dans l’exemple, démontrant les performances de diffusion.

Pourquoi c’est important (impact pour développeurs/entreprises)

- Les modèles Mercury à diffusion offrent une inférence rapide en générant plusieurs tokens en parallèle, ce qui est précieux pour les charges de travail d’IA générative à faible latence (chat, assistants de code, pipelines de génération de contenu).

- L’accès via Bedrock Marketplace et JumpStart réduit les freins d’accès pour les développeurs et les entreprises, permettant une expérimentation rapide et une itération sans nécessiter un entraînement de modèle ou une infrastructure interne lourde.

- La capacité d’exécuter les modèles dans un environnement AWS sécurisé et dans la VPC du client répond aux exigences de sécurité des entreprises, ce qui est crucial pour les secteurs nécessitant isolation des données et contrôles réseau.

- Les capacités d’utilisation d’outils permettent aux agents IA d’automatiser des tâches internes, d’appeler des API et d’interagir avec des bases de données, ouvrant la voie à des assistants plus autonomes.

- L’intégration avec les fonctionnalités SageMaker (Pipelines, Debugger, logs de conteneurs) aide les équipes à gérer le cycle de vie des modèles et à assurer la traçabilité et le contrôle en production.

Détails techniques ou Mise en œuvre

Mercury et Mercury Coder sont proposés en deux tailles (Mini et Small) pour répondre à des exigences de latence et de coût. L’accès peut se faire via Bedrock Marketplace et SageMaker JumpStart, chacun avec son flux de déploiement:

- Bedrock Marketplace : pages de détails du modèle fournissent capacités, tarifs et consignes de mise en œuvre. Abonnement, test dans le Bedrock playground et déploiement d’endpoints possibles. L’API Converse peut être utilisée pour invoquer le modèle via les outils Bedrock.

- SageMaker JumpStart : Mercury et Mercury Coder apparaissent dans les hubs JumpStart et peuvent être déployés via SageMaker Studio ou programmé via le SageMaker Python SDK. Après déploiement, vous pouvez évaluer les performances et les contrôles MLOps avec les fonctionnalités AWS telles que SageMaker Pipelines, SageMaker Debugger et les logs de conteneurs. Étapes de déploiement (vue d’ensemble) :

- Assurez-vous que votre rôle IAM SageMaker dispose des permissions appropriées pour déployer le modèle, y compris les permissions d’abonnement AWS Marketplace si nécessaire.

- Abonnez-vous au paquet du modèle ou utilisez un abonnement existant dans votre compte.

- Obtenez l’ARN du paquet et utilisez-le lors de la création d’un modèle déployable via le SDK (ou via l’interface JumpStart).

- Déployez l’endpoints et testez avec des payloads d’exemple pour valider le comportement et la latence.

- Surveillez les performances et les coûts ; suivez les instructions pour nettoyer les ressources une fois terminé afin d’éviter des frais. Un exemple du post montre Mercury générant un jeu de morpion avec du code complet (HTML, CSS, JavaScript) en une seule réponse, à une vitesse de 528 tokens par seconde lors de l’exemple, démontrant les capacités de génération de code et la vitesse de diffusion.

Tableau rapide

| Famille de modèle | Voies d’accès | Tailles supportées |---|---|---| | Mercury | Bedrock Marketplace, SageMaker JumpStart | Mini, Small |Mercury Coder | Bedrock Marketplace, SageMaker JumpStart | Mini, Small |

Points à retenir

- Mercury apporte la vitesse de diffusion pour les modèles de langage sur AWS via Bedrock Marketplace et JumpStart.

- L’accès est conçu pour l’expérimentation rapide, les tests et la montée en production dans des environnements sécurisés.

- Les capacités d’utilisation d’outils permettent à des agents IA d’interagir avec des API et des bases de données externes.

- L’intégration SageMaker facilite l’observabilité et le cycle de vie des modèles en production (MLOps).

FAQ

- Q : Que sont Mercury et Mercury Coder ? A : Ce sont des modèles de base basés sur la diffusion de Inception Labs, disponibles via Bedrock Marketplace et SageMaker JumpStart sur AWS.

- Q : Comment y accéder sur AWS ? A : Vous pouvez vous abonner au paquet du modèle via Bedrock Marketplace ou déployer via SageMaker JumpStart, puis tester dans le Bedrock playground ou dans SageMaker Studio/SDK.

- Q : Quelles sont les performances démontrées ? A : Un exemple de morpion a généré du code complet et une IA minimax à 528 tokens par seconde, illustrant les capacités et la vitesse de diffusion.

- Q : Y a-t-il des considérations de sécurité ? A : Les endpoints s’exécutent dans un environnement AWS sécurisé et dans votre VPC, avec des instructions de nettoyage pour éviter des frais indésirables.

- Q : Comment gérer le déploiement et le monitoring ? A : Utilisez SageMaker Pipelines, SageMaker Debugger et les logs de conteneurs pour le MLOps, les performances et l’observabilité, avec les outils JumpStart.

Références

More news

Faire passer vos agents IA du concept à la production avec Amazon Bedrock AgentCore

Une exploration détaillée de la façon dont Amazon Bedrock AgentCore aide à faire passer des applications IA basées sur des agents du proof of concept à des systèmes de production de niveau entreprise, en préservant mémoire, sécurité, observabilité et gestion d’outils à l’échelle.

Surveiller l’inférence par lot Bedrock d’AWS via les métriques CloudWatch

Apprenez à surveiller et optimiser les jobs d’inférence par lot Bedrock via CloudWatch, with alertes et tableaux de bord pour améliorer les performances, les coûts et l’exploitation.

Prompting pour la précision avec Stability AI Image Services sur Amazon Bedrock

Bedrock intègre Stability AI Image Services avec neuf outils pour créer et modifier des images avec précision. Apprenez les techniques de prompting adaptées à l’entreprise.

Utiliser les AWS Deep Learning Containers avec SageMaker AI géré MLflow

Découvrez comment les AWS Deep Learning Containers (DLCs) s’intègrent à SageMaker AI géré par MLflow pour équilibrer le contrôle de l’infrastructure et une gouvernance ML robuste. Un flux TensorFlow pour la prédiction de l’âge des abalones illustre le suivi de bout en bout et la traçabilité des modè

Évoluer la production visuelle avec Stability AI Image Services dans Amazon Bedrock

Stability AI Image Services est désormais disponible dans Amazon Bedrock, offrant des capacités d’édition d’images prêtes à l’emploi via l’API Bedrock et étendant les modèles Stable Diffusion 3.5 et Stable Image Core/Ultra déjà présents.

Créer des flux de travail agentiques avec GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore

Vue d’ensemble complète sur le déploiement des modèles GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore pour alimenter un analyseur d’actions multi-agents avec LangGraph, incluant la quantification MXFP4 en 4 bits et une orchestration sans serveur.