Les nœuds de code inline désormais pris en charge dans Amazon Bedrock Flows en préversion publique

TL;DR

- Les nœuds de code inline permettent d’écrire des scripts Python directement dans Amazon Bedrock Flows, évitant le recours à des fonctions AWS Lambda pour la logique simple.

- Préversion publique disponible dans les régions US East (N. Virginia, Ohio), US West (Oregon) et Europe (Francfort).

- L’édition Python et des modèles de code facilitent l’ajout de tâches de pré-traitement et de post-traitement dans les flux.

- Les traces peuvent être actives vers Amazon CloudWatch via l’API (InvokeFlow avec enableTrace = true), offrant des informations d’exécution détaillées.

- Cette fonctionnalité vise à démocratiser le développement IA générative et à réduire la maintenance des flux, accélérant l’adoption d’Bedrock Flows par les entreprises. AWS indique dans son article de blogue que les nœuds de code inline permettent d’écrire des scripts Python directement dans Bedrock Flows, simplifiant les tâches de pré et post-traitement et réduisant le besoin de fonctions Lambda séparées. Pour les détails complets, voir l’article : Inline code nodes now supported in Amazon Bedrock Flows in public preview.

Contexte et fond

Amazon Bedrock Flows est une capacité permettant de concevoir et déployer des flux de travail pour construire des applications IA générative entièrement dans l’environnement Amazon Bedrock. La préversion publique du nœud de code inline introduit un nouveau type de nœud qui permet d’écrire du code Python directement dans le flux, répondant au besoin de pré-traiter et post-traiter des données sans ajouter de fonctions Lambda supplémentaires. Cette amélioration s’inscrit dans les besoins des entreprises de simplifier le développement des flux IA, de réduire la gestion d’infrastructure et de diminuer les obstacles à l’adoption des solutions IA générative. Le billet souligne que les nœuds de code inline fluidifient des tâches comme la normalisation des données et la mise en forme des réponses, facilitant ainsi les itérations tout en maintenant la gouvernance et la sécurité dans Bedrock Flows. L’article note également que Bedrock Flows est désormais généralement disponible avec une sécurité et une traçabilité renforcées, ce qui témoigne de la maturité de la plateforme. L’exemple Thomson Reuters dans le texte illustre un cas d’usage pratique où le code inline gère le pré et le post-traitement pour une expérience de playlist musicale.

Ce qui est nouveau

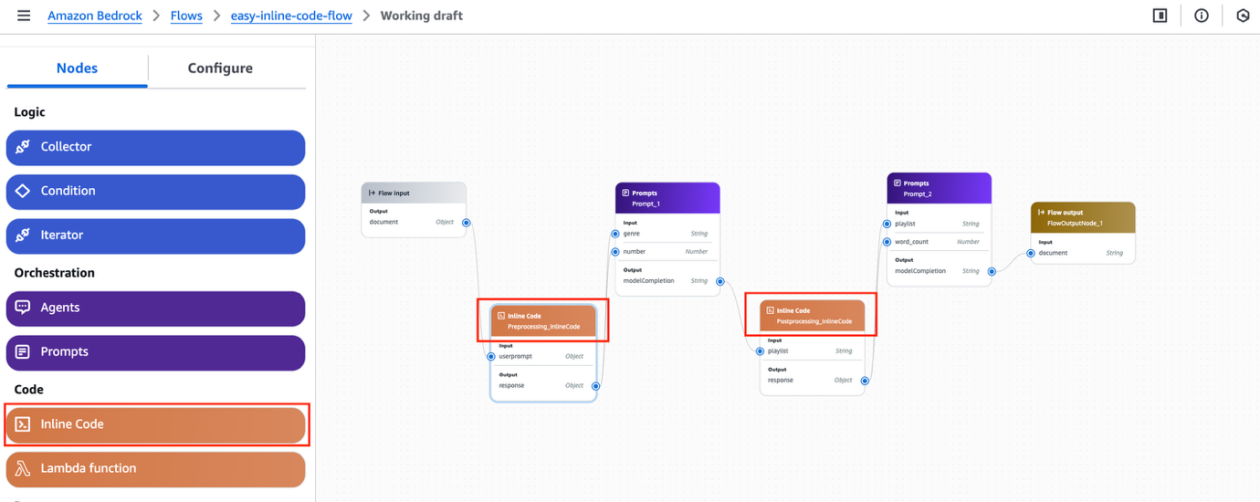

Cette version introduit le support du code inline dans Bedrock Flows, permettant d’exécuter des scripts Python à l’intérieur d’un flux sans recourir à une fonction Lambda pour une logique simple. Le nœud de code inline apparaît comme une nouvelle option dans l’éditeur de flux, dans l’onglet Nodes, et offre un éditeur Python avec des modèles pour faciliter le démarrage. Dans l’exemple décrit dans l’article, deux nœuds de code inline sont utilisés dans le flux pour le pré-traitement et le post-traitement. Notes techniques importantes :

- L’entrée d’un nœud de code inline est considérée comme non fiable; les développeurs doivent implémenter une validation et une manipulation sécurisée du code Python.

- Le système offre des traces d’exécution, fournissant des informations sur chaque étape du traitement et aidant à identifier les problèmes pendant l’exécution. Vous pouvez activer les traces via l’API et les envoyer vers CloudWatch.

- Dans InvokeFlow, réglez enableTrace sur true pour obtenir le flowTraceEvent qui accompagne flowOutputEvent à la sortie.

- L’article montre comment créer un flux simple avec un nœud de code inline et comment exécuter le flux de manière programmatique via les API Bedrock.

- Disponibilité des nœuds de code inline en préversion publique dans les régions US East (N. Virginia, Ohio), US West (Oregon) et Europe (Francfort).

Détails techniques et flux d’exemple

Le billet décrit comment construire un flux avec un nœud de code inline plutôt qu’une fonction Lambda pour une logique personnalisée dans une application IA générative. Il met en évidence que le nœud de code inline se trouve dans l’interface Bedrock Flows, avec un éditeur Python et des modèles de code prêts à l’emploi. L’exemple Thomson Reuters illustre une utilisation pratique où les nœuds inline valident les entrées et formatent les réponses. Pour commencer, ouvrez la console Amazon Bedrock ou utilisez les API Bedrock et commencez à créer des flux avec Bedrock Flows dès aujourd’hui. L’article renvoie vers des ressources supplémentaires pour configurer des flux avec une sécurité et une traçabilité accrues.

Pourquoi cela compte (impact pour les développeurs/entreprises)

Permettre l’exécution de code inline dans Bedrock Flows réduit la nécessité de créer et maintenir des fonctions Lambda pour des tâches simples de pré- et post-traitement. Cela abaisse les barrières à l’adoption de l’IA générative, simplifie la conception et le déploiement des flux, et diminue la surcharge liée à la gestion d’infrastructures supplémentaires. En facilitant la validation des données, la transformation et la mise en forme dans le flux même, les nœuds inline aident les équipes à itérer plus rapidement sur des applications IA tout en restant dans Bedrock. À mesure que Bedrock Flows étend ses capacités, les développeurs peuvent se concentrer davantage sur la création de flux IA avancés et moins sur l’intégration d’autres services. La disponibilité publique dans plusieurs régions élargit l’accès pour les initiatives IA mondiales, répondant aux besoins d’un développement plus fluide et d’une traçabilité robuste. L’objectif, tel que mentionné par AWS, est de démocratiser le développement IA générative et d’accélérer l’adoption par les entreprises, tout en offrant une expérience de développement plus directe et traçable.

Détails techniques ou Mise en œuvre (comment utiliser)

- Ouvrez la console Amazon Bedrock ou les API Bedrock et créez un flux.

- Dans l’éditeur de flux, ajoutez un nœud Inline Code (nouveau type de nœud disponible dans l’onglet Nodes).

- Utilisez l’éditeur Python et les modèles de code pour écrire la logique inline de pré-traitement ou de post-traitement.

- Considérez l’entrée du nœud inline comme non fiable et implémentez une validation sécurisée dans votre code Python.

- Pour l’observabilité, activez les traces en appelant l’API avec enableTrace = true. Visualisez flowTraceEvent avec flowOutputEvent et envoyez les traces vers CloudWatch si souhaité.

- Vous pouvez créer des flux avec plusieurs nœuds de code inline (l’exemple décrit deux nœuds pour le pré et le post-traitement).

- Disponibilité: les nœuds de code inline sont en préversion publique dans US East (N. Virginia, Ohio), US West (Oregon) et Europe (Francfort).

Disponibilité et régions

| Région | Disponibilité |

|---|---|

| US East (N. Virginia, Ohio) | Préversion publique |

| US West (Oregon) | Préversion publique |

| Europe (Francfort) | Préversion publique |

Points clés

- Les nœuds de code inline permettent d’exécuter Python directement dans Bedrock Flows, réduisant le besoin de Lambda pour une logique simple.

- La préversion apporte l’édition Python, des modèles et des flux multi-nœuds dans Bedrock Flows.

- Les traces et l’intégration CloudWatch offrent une observabilité pour exécuter et déboguer les flux.

- Cette fonctionnalité facilite l’adoption et accélère les cycles d’itération pour les applications IA.

- Les régions en préversion publique incluent US East, US West et Europe, configurables via la Console Bedrock ou les API Bedrock.

FAQ

-

Qu’est-ce que les nœuds de code inline ?

Ce sont des nœuds dans Bedrock Flows qui permettent d’écrire des scripts Python directement dans un flux pour effectuer des pré-traitements et des post-traitements simples sans fonctions Lambda supplémentaires.

-

Dois-je encore utiliser Lambda pour une logique simple ?

Les nœuds inline offrent une alternative intégrée pour la logique directe, réduisant le besoin de créer des fonctions Lambda pour des tâches basiques.

-

Comment activer le traçage des flux ?

Définissez enableTrace sur true dans InvokeFlow pour générer flowTraceEvent et l’envoyer vers CloudWatch pour une observabilité en temps réel.

-

Dans quelles régions est-ce disponible ?

En préversion publique dans US East (N. Virginia, Ohio), US West (Oregon) et Europe (Francfort).

-

Où puis-je en apprendre plus ou donner mon avis ?

Consultez le post du blog AWS sur la fonctionnalité et utilisez les canaux AWS comme re:Post et les forums communautaires pour les retours.

Références

More news

Faire passer vos agents IA du concept à la production avec Amazon Bedrock AgentCore

Une exploration détaillée de la façon dont Amazon Bedrock AgentCore aide à faire passer des applications IA basées sur des agents du proof of concept à des systèmes de production de niveau entreprise, en préservant mémoire, sécurité, observabilité et gestion d’outils à l’échelle.

Surveiller l’inférence par lot Bedrock d’AWS via les métriques CloudWatch

Apprenez à surveiller et optimiser les jobs d’inférence par lot Bedrock via CloudWatch, with alertes et tableaux de bord pour améliorer les performances, les coûts et l’exploitation.

Prompting pour la précision avec Stability AI Image Services sur Amazon Bedrock

Bedrock intègre Stability AI Image Services avec neuf outils pour créer et modifier des images avec précision. Apprenez les techniques de prompting adaptées à l’entreprise.

Utiliser les AWS Deep Learning Containers avec SageMaker AI géré MLflow

Découvrez comment les AWS Deep Learning Containers (DLCs) s’intègrent à SageMaker AI géré par MLflow pour équilibrer le contrôle de l’infrastructure et une gouvernance ML robuste. Un flux TensorFlow pour la prédiction de l’âge des abalones illustre le suivi de bout en bout et la traçabilité des modè

Évoluer la production visuelle avec Stability AI Image Services dans Amazon Bedrock

Stability AI Image Services est désormais disponible dans Amazon Bedrock, offrant des capacités d’édition d’images prêtes à l’emploi via l’API Bedrock et étendant les modèles Stable Diffusion 3.5 et Stable Image Core/Ultra déjà présents.

Créer des flux de travail agentiques avec GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore

Vue d’ensemble complète sur le déploiement des modèles GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore pour alimenter un analyseur d’actions multi-agents avec LangGraph, incluant la quantification MXFP4 en 4 bits et une orchestration sans serveur.