Améliorer les Agents IA avec des Modèles ML Prédictifs via SageMaker AI et MCP

TL;DR

- Les agents IA peuvent exploiter des modèles ML prédictifs hébergés sur Amazon SageMaker AI comme des outils pour éclairer les décisions basées sur les données.

- MCP (Model Context Protocol) permet une découverte dynamique des outils et découple l’exécution des agents de celle des outils, offrant ainsi évolutivité et sécurité.

- Le Strands Agents SDK propose une approche guidée par le modèle pour construire rapidement des agents IA, avec deux voies d’accès aux endpoints SageMaker : appels directs ou invocation via MCP.

- Pour les déploiements en production, MCP est recommandé pour son architecture découplée et sa gestion centralisée des permissions; l’accès direct à l’endpoint reste une option valable pour des scénarios simples.

- Le flux démontré entraîne un modèle de séries temporelles, le déploie sur SageMaker AI et le met à disposition d’un agent IA, illustrant une chaîne complète de données vers décision.

Contexte et arrière-plan

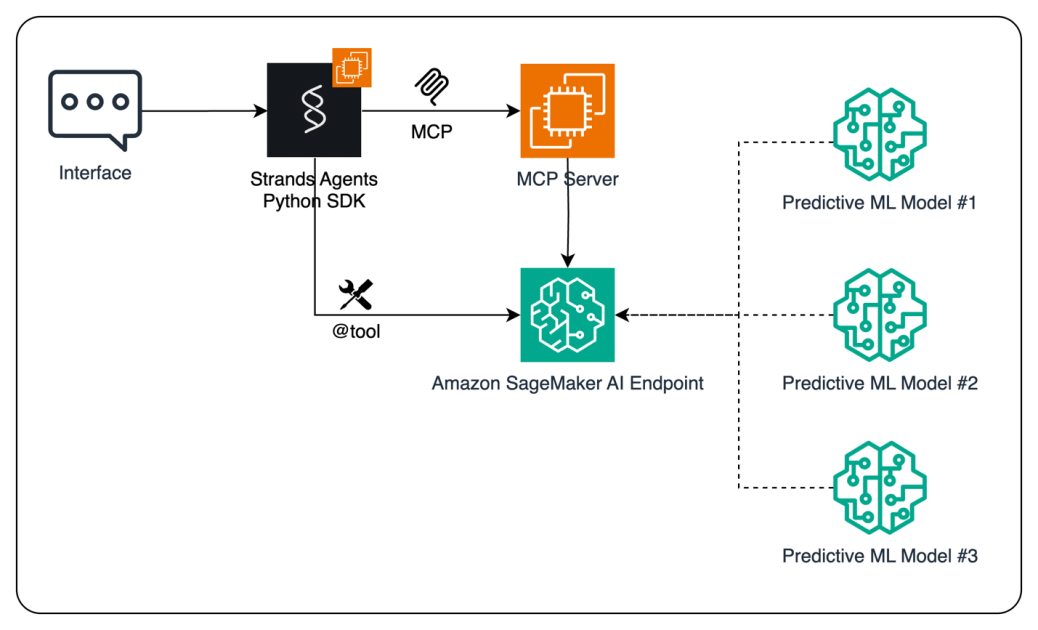

Le ML est passé d’un domaine expérimental à une composante opérationnelle. Les organisations déploient des modèles ML pour des prévisions de ventes, des segments clients et des predictions de churn. Bien que l’IA générative ait pris une place majeure, le ML traditionnel reste essentiel pour des tâches prédictives spécifiques. Des algorithmes établis comme les forêts aléatoires, le boosting (XGBoost), l’ARIMA, le LSTM et les régressions restent performants pour les prévisions et les analyses de données. L’IA générative excelle dans des tâches créatives, mais le ML prédictif demeure crucial pour les décisions fondées sur les données. Pour permettre à des agents IA de prendre des décisions basées sur les données, cette approche combine des modèles ML prédictifs avec MCP, un protocole ouvert standardisant la façon dont les applications fournissent du contexte aux LLMs, sur Amazon SageMaker AI. L’objectif est de permettre aux agents IA d’accéder à des modèles ML en tant qu’outils afin de prendre des décisions plus éclairées, tout en gérant les coûts et les performances. Le Strands Agents SDK est un outil open source qui supporte une conception guidée par les modèles, facilitant le développement rapide d’agents allant de simples assistants à des flux de travail autonomes complexes. Deux chemins permettent de connecter les agents aux endpoints SageMaker : invocation directe des endpoints depuis le code de l’agent ou routage via MCP, permettant une découverte dynamique des outils et une exécution découplée. Pour des déploiements évolutifs et sécurisés, l’approche MCP est recommandée, sans exclure l’accès direct à des fins de démonstration. SageMaker AI propose deux méthodes pour héberger plusieurs modèles derrière un seul endpoint: les composants d’inférence et les endpoints multi-model, optimisant les ressources et les temps de réponse. La démonstration présente un flux où l’utilisateur interagit via une interface de chat, l’agent alimenté par LLM observe l’environnement, décide d’appeler le modèle ML et reçoit la prévision du SageMaker AI, qui est ensuite renvoyée à l’interface utilisateur. Le code complet est disponible sur GitHub, et les lecteurs sont encouragés à consulter la documentation et des exemples concrets pour approfondir.

Ce qui est nouveau

Cette approche montre comment augmenter les agents IA avec des modèles ML prédictifs en exposant le modèle comme outil utilisable par l’agent en temps réel. Les points clés incluent :

- Intégration des modèles ML prédictifs hébergés sur SageMaker AI avec des agents IA via le Strands Agents SDK.

- Deux modes d’invocation : accès direct à l’endpoint SageMaker et invocation via MCP pour découvrir dynamiquement les outils et les faire passer par le serveur MCP.

- Recommandation de MCP pour les déploiements évolutifs et sécurisés, tout en présentant le chemin direct pour des scénarios simples.

- Démonstration de l’hébergement de plusieurs modèles derrière un seul endpoint SageMaker AI via des composants d’inférence ou des endpoints multi-model, optimisant les ressources et la latence.

- Un flux pratique qui entraîne un modèle de séries temporelles (XGBoost), le déploie sur SageMaker AI et l’expose à un agent IA pour la prise de décision en temps réel.

- Des indications sur l’exposition du endpoint comme outil Strands (via @tool) et sur son appel par l’agent, avec une docstring facilitant l’utilisation guidée par modèle.

- La perspective d’intégrer les prédictions dans des outils BI (ex. Amazon QuickSight) ou dans des systèmes d’entreprise (ERP/CRM) pour opérationnaliser les insights.

Pourquoi c’est important (impact pour les développeurs/entreprises)

En combinant ML prédictif et IA conversationnelle, les organisations peuvent doter leurs agents IA de capacités décisionnelles basées sur les données en temps réel. Cette approche diminue la barrière à l’adoption du ML, permettant à des équipes de tirer parti des prévisions sans expertise ML approfondie. MCP offre une découverte dynamique des outils et une gouvernance centralisée, indispensables pour les environnements en production et pour des contrôles de sécurité.” Pour les développeurs, c’est une feuille de route pour créer des agents qui comprennent les données, prévoient des résultats et s’intègrent avec les systèmes métiers. Pour les entreprises, cela accélère les cycles analytics-to-action, facilite l’intégration des prévisions dans les systèmes opérationnels et renforce la gouvernance via un serveur MCP centralisé.

Détails techniques ou Implementation

Le flux suit les étapes suivantes :

- Données et préparation du modèle : créer des données synthétiques de séries temporelles avec tendance, saisonnalité et bruit, puis extraire des features temporelles pertinentes.

- Entraînement et déploiement : entraîner un modèle de régression XGBoost à l’aide du conteneur SageMaker AI 1P, empaqueter et déployer le modèle sur un endpoint pour l’inférence en temps réel.

- Invocation de l’endpoint : écrire une fonction comme invoke_endpoint() avec une docstring descriptive afin qu’elle puisse être utilisée comme outil par les LLMs. Cette fonction peut être convertie en outil Strands Agents via le décorateur @tool et appelée par un agent Strands.

- Deux chemins d’intégration :

- Accès direct à l’endpoint : l’agent appelle directement l’endpoint SageMaker depuis son code.

- Accès via MCP : le client découvre les outils exposés par le serveur MCP, formate la requête et appelle l’inférence via MCP.

- Serveur MCP et schémas d’outil : pour une utilisation à grande échelle, implémenter un serveur MCP qui encapsule l’endpoint et le présente comme un outil avec une interface définie. Un schéma d’outil précise les paramètres d’entrée et les valeurs de retour pour faciliter l’utilisation par les agents IA.

- Considérations de ressources : SageMaker AI offre deux méthodes pour héberger plusieurs modèles derrière un seul endpoint — composants d’inférence et endpoints multi-model. Bien que l’exemple se concentre sur un modèle unique, les pratiques recommandées incluent l’optimisation pour plusieurs modèles selon les besoins.

- Flux de bout en bout : l’utilisateur interagit via une interface, l’agent Strands traite la requête, décide d’invoquer le modèle ML, et la prévision est renvoyée à l’utilisateur. Le système peut produire des graphiques, envoyer des valeurs à des outils BI ou mettre à jour des systèmes ERP/CRM.

- Remarques pratiques : ce motif permet d’accéder aux capacités ML sans expertise approfondie et offre une voie pragmatique pour ajouter de l’intelligence prédictive à des agents IA.

Aperçu des options d’invocation d’outils

| Aspect | Accès direct à l’endpoint | Invocation MCP |---|---|---| | Mécanisme de découverte | Appels d’outils intégrés dans le code de l’agent | Découverte dynamique via le serveur MCP |Composant architectural | Pas de serveur MCP nécessaire | Introduit un serveur MCP pour mediater les appels |Schéma de sécurité | Permissions et appels gérés au niveau de l’outil | Gouvernance et permissions centralisées via le serveur MCP |Considérations de déploiement | Plus simple pour prototypage rapide | Évolutif et sûr pour la production; prend en charge plusieurs outils |Recommandation | Utile pour des expériences rapides | Recommandé pour des déploiements évolutifs et sécurisés |

- Comment choisir : pour une prototypage rapide, l’accès direct est suffisant. Pour la production nécessitant découverte dynamique et sécurité centralisée, MCP est recommandé.

- Code et références : le code complet est disponible sur GitHub; consultez la documentation SageMaker AI pour les détails sur les composants d’inférence et les endpoints multi-model.

Points clés

- Des modèles ML prédictifs hébergés sur SageMaker AI peuvent servir d’outils au sein d’agents IA pour améliorer les décisions.

- MCP fournit découverte dynamique d’outils et une architecture découplée entre agents et outils, avec un serveur MCP gérant l’exécution et les permissions.

- Le Strands Agents SDK facilite le développement d’agents guidés par les modèles, permettant de définir agents avec prompts et outils plutôt que des intégrations personnalisées.

- SageMaker AI prend en charge l’hébergement de plusieurs modèles derrière un seul endpoint via des composants d’inférence ou des endpoints multi-model, optimisant l’utilisation des ressources et la latence.

- Le flux démontré couvre des données synthétiques, l’ingénierie des features, la modélisation XGBoost, le déploiement et l’invocation par l’agent pour illustrer une prise de décision prédictive en temps réel.

FAQ

-

- **Q : Quel problème MCP résout pour les agents IA ?** **

MCP permet la découverte dynamique des outils et découple l’exécution de l’agent de celle des outils grâce à un serveur MCP, offrant gouvernance et sécurité.** - **

-

Comment un agent IA peut-il accéder aux modèles SageMaker AI ?** **

L’agent peut invoquer directement les endpoints ou utiliser MCP pour découvrir et appeler les outils exposés par le serveur MCP.** - **

-

Quelles options existent pour héberger plusieurs modèles derrière un seul endpoint ?** **

SageMaker AI offre des composants d’inférence et des endpoints multi-model pour consolider les modèles sous un seul endpoint et réduire les ressources et la latence.** - **

-

Quel est le flux complet de l’exemple ?** **

Former un modèle de séries temporelles, le déployer sur SageMaker AI, l’exposer comme outil Strands, l’invoquer par l’agent et présenter les prévisions à l’utilisateur ou aux systèmes en aval.**

Références

More news

Faire passer vos agents IA du concept à la production avec Amazon Bedrock AgentCore

Une exploration détaillée de la façon dont Amazon Bedrock AgentCore aide à faire passer des applications IA basées sur des agents du proof of concept à des systèmes de production de niveau entreprise, en préservant mémoire, sécurité, observabilité et gestion d’outils à l’échelle.

Surveiller l’inférence par lot Bedrock d’AWS via les métriques CloudWatch

Apprenez à surveiller et optimiser les jobs d’inférence par lot Bedrock via CloudWatch, with alertes et tableaux de bord pour améliorer les performances, les coûts et l’exploitation.

Prompting pour la précision avec Stability AI Image Services sur Amazon Bedrock

Bedrock intègre Stability AI Image Services avec neuf outils pour créer et modifier des images avec précision. Apprenez les techniques de prompting adaptées à l’entreprise.

Utiliser les AWS Deep Learning Containers avec SageMaker AI géré MLflow

Découvrez comment les AWS Deep Learning Containers (DLCs) s’intègrent à SageMaker AI géré par MLflow pour équilibrer le contrôle de l’infrastructure et une gouvernance ML robuste. Un flux TensorFlow pour la prédiction de l’âge des abalones illustre le suivi de bout en bout et la traçabilité des modè

Évoluer la production visuelle avec Stability AI Image Services dans Amazon Bedrock

Stability AI Image Services est désormais disponible dans Amazon Bedrock, offrant des capacités d’édition d’images prêtes à l’emploi via l’API Bedrock et étendant les modèles Stable Diffusion 3.5 et Stable Image Core/Ultra déjà présents.

Créer des flux de travail agentiques avec GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore

Vue d’ensemble complète sur le déploiement des modèles GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore pour alimenter un analyseur d’actions multi-agents avec LangGraph, incluant la quantification MXFP4 en 4 bits et une orchestration sans serveur.