Anthropic renforce les règles d'utilisation de Claude face à un paysage IA plus dangereux

Sources: https://www.theverge.com/news/760080/anthropic-updated-usage-policy-dangerous-ai-landscape

TL;DR

- Anthropic a mis à jour la politique d’utilisation de Claude pour interdire explicitement l’assistance au développement d’armes biologiques, chimiques, radiologiques et nucléaires (CBRN) et d’explosifs à haut rendement.

- Une nouvelle section ‘Ne pas compromettre des systèmes informatiques ou des réseaux’ interdit la découverte/exploitation de vulnérabilités, la création de logiciels malveillants et les outils d’attaques par déni de service.

- En mai, Anthropic a mis en place des protections ‘AI Safety Level 3’ avec le modèle Claude Opus 4 pour rendre les jailbreaks plus difficiles et réduire l’aide sur les sujets CBRN.

- Les fonctionnalités agentives telles que Computer Use et Claude Code sont citées comme sources de risques, notamment d’abus à grande échelle et d’attaques cyber.

- La politique relative au contenu politique a été assouplie pour ne cibler que les usages trompeurs ou perturbateurs des processus démocratiques et le ciblage d’électeurs/campagnes.

Contexte et historique

Anthropic a publié une mise à jour de sa politique d’utilisation pour le chatbot Claude en réponse à des préoccupations croissantes en matière de sécurité. L’entreprise interdisait auparavant l’utilisation de Claude pour ‘produire, modifier, concevoir, commercialiser ou distribuer des armes, explosifs, matériaux dangereux ou autres systèmes conçus pour causer des dommages ou la perte de vies humaines’. La comparaison entre l’ancienne et la nouvelle version montre une expansion et une clarification de cette interdiction dans plusieurs domaines spécifiques. En mai, Anthropic a déployé des protections ‘AI Safety Level 3’ simultanément au lancement du modèle Claude Opus 4. Ces mesures visent à rendre le modèle plus difficile à jailbreaker et à empêcher qu’il aide au développement d’armes CBRN. Anthropic met également en avant les capacités agentives comme domaines de risque. Deux exemples cités sont Computer Use, qui permet à Claude d’effectuer des actions sur l’ordinateur d’un utilisateur, et Claude Code, qui intègre Claude directement dans le terminal d’un développeur. L’entreprise signale que ces fonctionnalités introduisent des risques d’abus à grande échelle, de création de logiciels malveillants et d’attaques informatiques. Pour le texte complet, consultez la couverture originale: The Verge.

Nouveautés

Les changements et clarifications principaux sont:

- Interdiction explicite d’utiliser Claude pour aider au développement d’armes biologiques, chimiques, radiologiques ou nucléaires (CBRN).

- Interdiction spécifique de l’assistance sur les explosifs à haut rendement.

- Nouvelle section ‘Ne pas compromettre des systèmes informatiques ou des réseaux’ interdisant la découverte/exploitation de vulnérabilités, la création/distribution de maliciels et le développement d’outils de déni de service.

- Réduction de l’interdiction sur le contenu politique: au lieu d’interdire tout contenu lié aux campagnes et au lobbying, la politique vise désormais les cas trompeurs ou perturbateurs des processus démocratiques et le ciblage électoral/ de campagne.

- Clarification que les exigences pour les cas d’utilisation ‘à haut risque’ s’appliquent aux scénarios de recommandation destinés aux consommateurs et non aux usages internes d’entreprise. Ces changements étendent l’interdiction précédente en nommant des catégories de risque élevées et en ajoutant des restrictions liées aux capacités agentives.

Pourquoi c’est important (impact pour développeurs/entreprises)

- Conformité et gestion des risques: Les développeurs et organisations utilisant Claude doivent examiner la politique mise à jour pour s’assurer que leurs applications ne violent pas les interdictions explicites concernant les CBRN, les explosifs à haut rendement, ou les nouvelles restrictions de cybersécurité.

- Contrôles renforcés pour les fonctionnalités agentives: Computer Use et Claude Code peuvent effectuer des actions au-delà de la génération de texte. L’entreprise souligne que ces capacités introduisent des risques d’abus à grande échelle et d’attaques informatiques, ce qui implique la nécessité de contrôles supplémentaires.

- Conception et déploiement de produits: Les équipes qui construisent des systèmes de recommandation destinés aux consommateurs doivent respecter les exigences ‘à haut risque’. Anthropic a précisé que ces exigences concernent les scénarios destinés au consommateur, pas l’usage interne en entreprise.

- Conséquences sur le contenu politique et la conformité: La modification de la politique politique cible désormais des usages trompeurs et le ciblage d’électeurs. Les acteurs travaillant sur des technologies de campagne ou de lobbying doivent réévaluer l’utilisation de Claude.

Détails techniques ou de mise en œuvre

La mise à jour associe des changements de politique à des protections au niveau du modèle. Points clés:

- AI Safety Level 3 et Claude Opus 4: Déployés en mai pour réduire les jailbreaks et limiter l’assistance sur les sujets CBRN.

- Fonctionnalités agentives citées:

| Fonction agentive | Description dans la mise à jour |

|---|---|

| Computer Use | Permet à Claude d’agir sur l’ordinateur d’un utilisateur; cité comme facteur de risques d’abus à grande échelle et d’attaques informatiques |

| Claude Code | Intègre Claude dans le terminal d’un développeur; cité parmi les fonctionnalités introduisant des risques de maliciels et de sécurité |

- Nouvelles interdictions cybersécurité: La section ‘Ne pas compromettre des systèmes informatiques ou des réseaux’ interdit l’utilisation de Claude pour découvrir/exploiter des vulnérabilités, créer/distribuer des maliciels, et développer des outils de DDoS.

- Comparaison de la politique sur les armes: | Sujet | Ancienne politique | Nouvelle politique |---|---:|---| | Armes et explosifs | Interdiction de produire, modifier, concevoir, commercialiser ou distribuer armes, explosifs, matériaux dangereux ou autres systèmes causant des dommages ou la perte de vies | Étendue pour interdire explicitement l’assistance au développement d’explosifs à haut rendement et d’armes CBRN |

Points clés

- Interdiction explicite de l’assistance aux armes CBRN et aux explosifs à haut rendement.

- Nouvelle section cybersécurité interdisant la découverte de vulnérabilités, la création de maliciels et les outils de DDoS.

- Protections AI Safety Level 3 avec Claude Opus 4 pour réduire les jailbreaks et limiter l’assistance sur les CBRN.

- Fonctions agentives telles que Computer Use et Claude Code sont identifiées comme risques et font l’objet de garde-fous.

- Politique politique ajustée pour cibler les usages trompeurs, disruptifs ou de ciblage d’électeurs; exigences ‘à haut risque’ pour scénarios consommateurs.

FAQ

-

La politique interdit-elle tout contenu politique?

Non. Anthropic interdit maintenant seulement les usages trompeurs ou perturbateurs des processus démocratiques et le ciblage d'électeurs/campagnes.

-

Que signifie CBRN dans la mise à jour?

CBRN désigne les armes biologiques, chimiques, radiologiques et nucléaires, explicitement citées comme catégories interdites pour l'aide au développement.

-

Les règles 'à haut risque' s'appliquent-elles aux outils internes?

Anthropic a clarifié que ces exigences s'appliquent aux scénarios de recommandation destinés aux consommateurs, et non aux usages internes en entreprise.

-

Quelles fonctionnalités agentives sont mentionnées comme préoccupantes?

Computer Use et Claude Code sont nommés comme capacités présentant des risques tels que la création de maliciels et des attaques informatiques.

Références

- Couverture de la mise à jour de la politique Anthropic: The Verge

More news

Build a scalable containerized web application on AWS using the MERN stack with Amazon Q Developer – Part 1

In a traditional SDLC, a lot of time is spent in the different phases researching approaches that can deliver on requirements: iterating over design changes, writing, testing and reviewing code, and configuring infrastructure. In this post, you learned about the experience and saw productivity gains

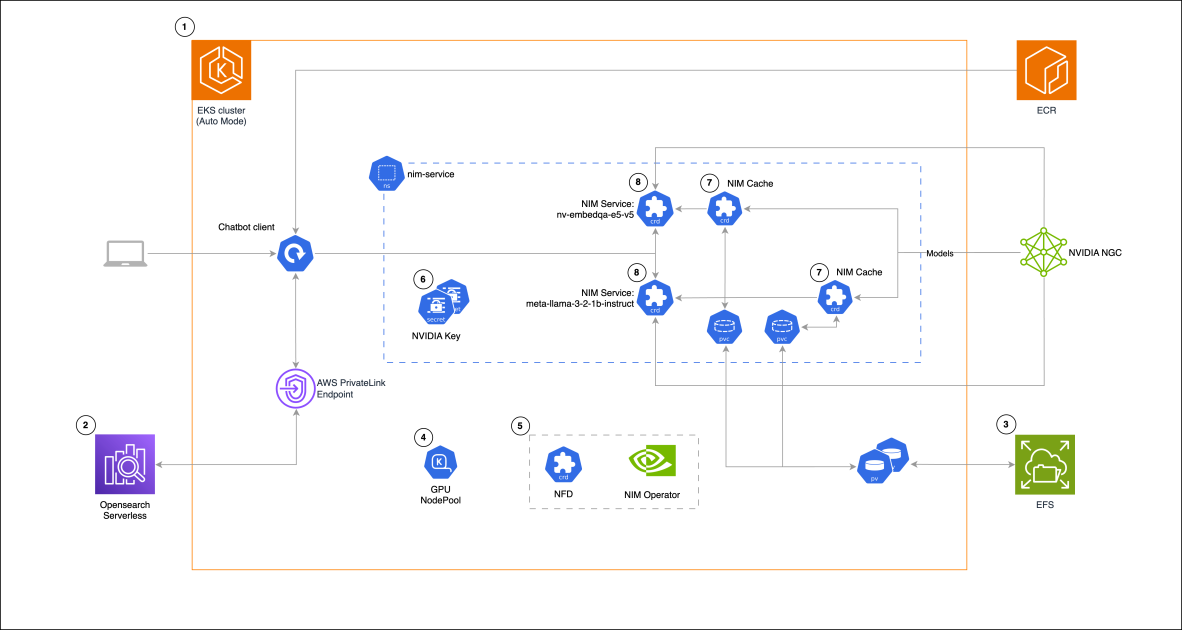

Building a RAG chat-based assistant on Amazon EKS Auto Mode and NVIDIA NIMs

In this post, we demonstrate the implementation of a practical RAG chat-based assistant using a comprehensive stack of modern technologies. The solution uses NVIDIA NIMs for both LLM inference and text embedding services, with the NIM Operator handling their deployment and management. The architectu

GPT-5 a déçu les attentes élevées mais améliore coût, rapidité et codage

Le lancement de GPT-5 a suscité des réactions mitigées : progrès incrémentaux aux benchmarks, coût et latence réduits, meilleure performance en codage, mais critiques sur le ton rédactionnel et des erreurs inattendues.

Introducing Amazon Bedrock AgentCore Gateway: Transforming enterprise AI agent tool development

In this post, we discuss Amazon Bedrock AgentCore Gateway, a fully managed service that revolutionizes how enterprises connect AI agents with tools and services by providing a centralized tool server with unified interface for agent-tool communication. The service offers key capabilities including S

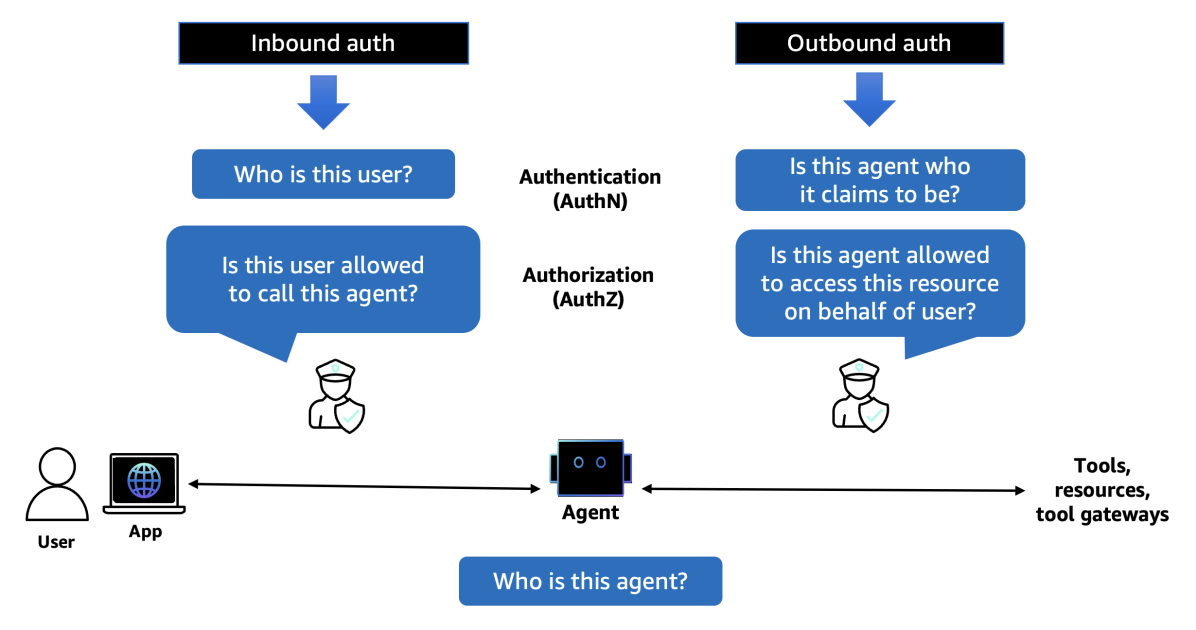

Introducing Amazon Bedrock AgentCore Identity: Securing agentic AI at scale

In this post, we explore Amazon Bedrock AgentCore Identity, a comprehensive identity and access management service purpose-built for AI agents that enables secure access to AWS resources and third-party tools. The service provides robust identity management features including agent identity director

Sam Altman dit que le marché de l'IA est en bulle et prévoit des dépenses colossales en centres de données

Sam Altman a déclaré au Verge qu'il pense que le marché de l'IA est en bulle, a comparé la situation à la bulle dot‑com et a annoncé des milliers de milliards en dépenses de data centers.