Dynamo 0.4 offre 4x plus de performances, autoscaling basé sur les SLO et observabilité en temps réel

Sources: https://developer.nvidia.com/blog/dynamo-0-4-delivers-4x-faster-performance-slo-based-autoscaling-and-real-time-observability, developer.nvidia.com

TL;DR

- Dynamo 0.4 introduit l’autoscaling basé sur les SLO via Planner et AIConfigurator pour optimiser le PD disaggregation entre les GPUs, avec une intégration native à Kubernetes.

- Le serving disaggregated découple le pré-remplissage et le décodage entre GPUs, offrant jusqu’à 4x plus d’interactivité pour gpt-oss-120b sur NVIDIA Blackwell B200 et des gains de 2,5x de débit pour DeepSeek-R1 671B sur GB200 NVL72, sans coût d’inférence supplémentaire.

- Les fondamentaux d’observabilité s’étendent : métriques Prometheus et compatibilité Grafana, et une API pour émettre des métriques personnalisées.

- Améliorations de tolérance et de résilience : routage en vol des requêtes et détection plus rapide des pannes en contournant etcd, réduisant le temps de détection et de récupération.

- Lancement de scripts pour reproduire les résultats, guides de déploiement pour des environnements multi-nœuds avec DeepSeek-R1 et Llama4 Maverick via TensorRT-LLM, support initial de TensorRT-LLM sur Hopper, et interfaces CLI/web pour AIConfigurator.

Contexte et arrière-plan

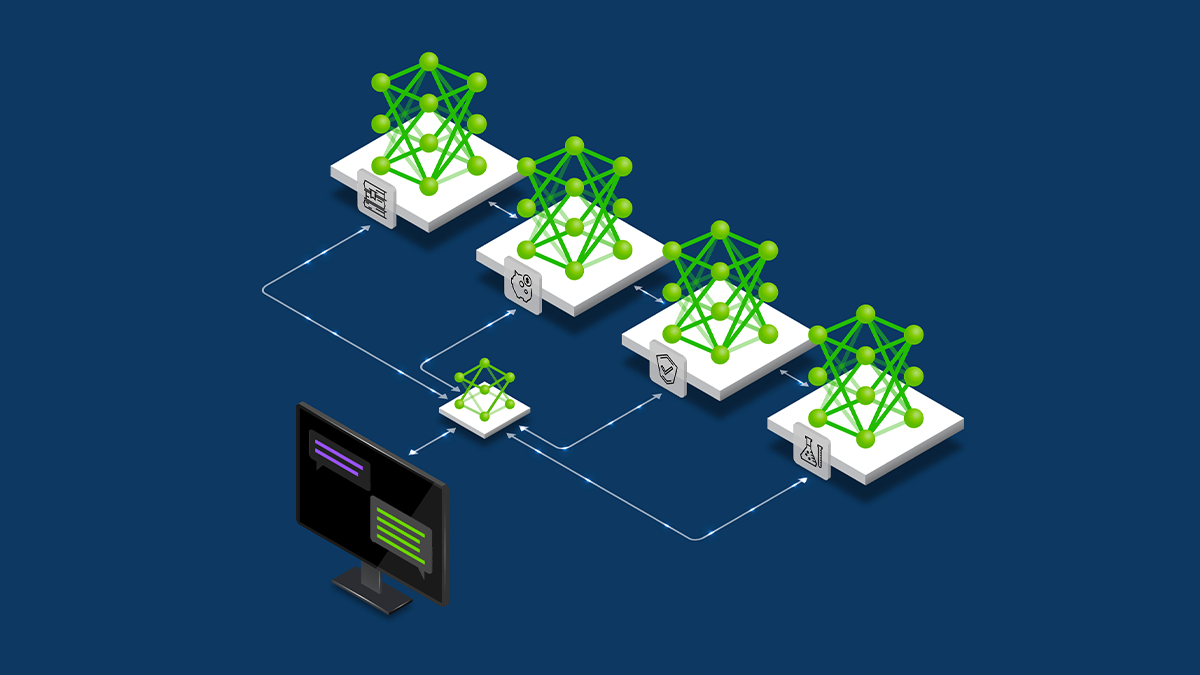

Le paysage des modèles Open Source de pointe a connu une montée en puissance, avec des projets comme gpt-oss d’OpenAI et Kimi K2 de Moonshot AI. Dans ce cadre, Dynamo 0.4 vise à déployer ces modèles à grande échelle tout en maîtrisant les coûts. La release met l’accent sur la performance, l’observabilité et l’autoscaling basé sur les SLO afin de répondre à des cibles de latence pour les workloads génératifs. L’architecture de serving disaggregated de Dynamo découple les phases d’inférence en stages distincts exécutés sur des GPUs séparés. En séparant ces phases, Dynamo permet une allocation de ressources et un parallélisme de modèle plus fin, adapté à chaque étape et augmentant considérablement l’efficacité. AIConfigurator et Planner assistent les équipes pour estimer les gains de throughput et configurer le système selon les SLO. La version 0.4 étend le travail antérieur en introduisant l’autoscaling basé sur les SLO et en renforçant l’observabilité. Elle fournit également les outils et guides nécessaires pour reproduire les résultats et adopter le serving disaggregated dans des déploiements réels.

Quoi de neuf

Dynamo 0.4 apporte un ensemble d’améliorations majeures destinées à rendre l’inférence de modèles de grande taille scalable et fiable en production :

- AIConfigurator : nouvel outil qui recommande les configurations optimales de PD disaggregation et les stratégies de model-parallel adaptées à un modèle donné et à un budget GPU, tout en garantissant les SLO. Il s’appuie sur des données de performance pré-mesurées par composants du modèle (attention, FFN, communication, mémoire) et sur différentes techniques de planification (batching statique, batching en vol, serving disaggregated). Interfaces CLI et web fournies, support initial pour TensorRT-LLM sur NVIDIA Hopper. D’autres frameworks et hardware seront ajoutés dans les futures versions.

- Planner basé sur les SLO : planificateur GPU proactif qui ajuste le nombre de travailleurs d’inférence en fonction de la file préfill et de l’usage mémoire du decode pour optimiser l’utilisation des GPUs et réduire les coûts. S’intègre nativement à Kubernetes pour les déploiements conteneurisés et prend en charge le vLLM, avec des plans pour d’autres frameworks.

- Observabilité : Dynamo 0.4 émet des métriques clés via Prometheus, facilitant leur affichage dans Grafana et d’autres outils open source sans développement supplémentaire. Une API de métriques personnalisées ajoute de la flexibilité.

- Tolérance et résilience : routage des requêtes en vol pour préserver les calculs intermédiaires et acheminer les requêtes vers les GPUs en ligne en cas de défaillance, réduisant les pertes et les retravaux. Détection des pannes plus rapide grâce à une meilleure intégration du routeur intelligent qui contourne etcd.

- Échelle et déploiement : le serving disaggregated est conçu pour les environnements multinœuds et les déploiements à grande échelle.

- Ressources développeurs : scripts pour reproduire les résultats et guides de déploiement multi-nœuds (DeepSeek-R1 avec SGLang et Llama4 Maverick avec TensorRT-LLM dans Dynamo).

- Performances (exemples validés) : exécution de gpt-oss-120b sur Dynamo + TensorRT-LLM avec NVIDIA Blackwell B200 jusqu’à 4x plus rapide en interactivité; exécution de DeepSeek-R1 671B sur GB200 NVL72 avec Dynamo + TensorRT-LLM environ 2,5x plus throughput par GPU, sans coûts d’inférence accrus.

Pourquoi c’est important (impact pour les développeurs/entreprises)

Pour les développeurs et les entreprises qui déploient des inférences de grands modèles, Dynamo 0.4 apporte à la fois performance et fiabilité opérationnelle. La capacité de disaggregated serving permet une utilisation plus fine des ressources, facilitant le respect des cibles de latence tout en maîtrisant les coûts. L’autoscaling basé sur les SLO permet une planification proactive des ressources et réduit les risques de goulets d’étranglement en période de forte demande. L’observabilité en temps réel offre une visibilité essentielle pour diagnostiquer les goulets et maintenir la fiabilité en production. L’introduction d’AIConfigurator et Planner, associée aux guides de déploiement, abaisse les barrières à l’adoption du serving disaggregated dans des environnements multi-nœuds. L’intégration native à Kubernetes simplifie l’évolutivité des workloads AI, tandis que l’API de métriques personnalisées permet d’adapter la surveillance aux cas d’usage spécifiques. Le support initial de TensorRT-LLM sur Hopper et les exemples multi-framework élargissent les options matérielles et frameworks pour optimiser les performances et les coûts.

Détails techniques ou Implémentation

Le cœur du Dynamo repose sur une architecture de serving disaggregated qui scinde l’inférence en stages distincts et exécutables sur des GPUs séparés. Plus précisément, les phases de pré-remplissage (prefill) et de décodage (decode) sont disloquées, permettant une allocation de ressources GPU et un parallélisme de modèle plus fin adaptables aux besoins de chaque étape. Cette séparation améliore l’efficacité et le throughput pour les grands modèles et les longues séquences. Le Planner supervise l’inférence et ajuste dynamiquement le nombre de travailleurs en fonction de la charge et de l’usage mémoire, afin de maximiser l’utilisation des GPUs et de réduire les coûts. Il s’intègre directement à Kubernetes pour faciliter les déploiements conteneurisés et prend en charge des frameworks comme le vLLM. AIConfigurator propose des configurations optimales de PD disaggregation et des stratégies de model parallel en se basant sur des données de performance et des techniques d’ordonnancement. L’observabilité, élément central de cette version, émet des métriques à partir de composants du plan d’événements, de contrôle et de données via Prometheus et est conçu pour être consommé par Grafana sans développement supplémentaire. L’API de métriques personnalisées offre une flexibilité supplémentaire pour adapter la surveillance aux environnements particuliers. Cette base prépare l’arrivée de métriques plus granulaires liées au PD disaggregation dans les prochaines versions. Les améliorations de tolérance à la faute adressent les environnements multinœuds avec des centaines de GPUs. En inflight re-routing, les requêtes peuvent être transférées vers des GPUs en ligne sans perdre les calculs intermédiaires, évitant ainsi des recalculs inutiles. L’amélioration de la détection des pannes passe par le contournement d’etcd et l’utilisation de signaux de santé pour réduire considérablement le temps de détection et de récupération. Pour les chercheurs et les ingénieurs, NVIDIA fournit les scripts permettant de reproduire les résultats et des guides de déploiement multi-nœuds démontrant l’utilisation de DeepSeek-R1 avec SGLang et Llama4 Maverick via TensorRT-LLM dans Dynamo. Ces ressources visent à faciliter l’adoption et la mise en production.

Points essentiels

- Dynamo 0.4 pousse le serving disaggregated avec autoscaling basé sur les SLO, configurabilité par IA et observabilité renforcée.

- Des gains concrets incluent jusqu’à 4x plus d’interactivité pour gpt-oss-120b sur B200 et ~2,5x de débit pour DeepSeek-R1 sur NVL72, sans coût d’inférence supplémentaire.

- AIConfigurator aide à optimiser le PD disaggregation et le parallèle de modèle dans un budget GPU donné, via CLI et interface web.

- Planner offre un autoscaling proactif basé sur les SLO, avec intégration Kubernetes native pour les charges d’inférence générative.

- Améliorations d’observabilité et API de métriques personnalisées pour une meilleure visibilité et résolution des problèmes en production.

FAQ

-

Que propose essentiellement Dynamo 0.4 ?

Un serving disaggregated avec autoscaling basé sur les SLO, une configurabilité IA et une observabilité en temps réel pour les modèles de grande taille.

-

uels gains de performance sont mis en avant dans le 0.4 ?

Jusqu’à 4x plus d’interactivité pour gpt-oss-120b sur B200 et environ 2,5x de débit pour DeepSeek-R1 671B sur NVL72, sans coûts d’inférence supplémentaires.

-

uels outils soutiennent la configuration et l’échelle dans cette version ?

IConfigurator (CLI et web), Planner (autoscaling basé sur les SLO) et l’intégration native à Kubernetes.

-

Comment la fiabilité est-elle améliorée avec Dynamo 0.4 ?

Le routage en vol preserve les calculs intermédiaires et redirige les requêtes vers les GPUs en ligne; la détection des pannes est plus rapide grâce au contournement d’etcd.

-

Où trouver les ressources de déploiement et de reproduction ?

NVIDIA propose des scripts et guides de déploiement multi-nœuds; reportez-vous à l’article officiel pour les détails.

Références

More news

NVIDIA HGX B200 réduit l’intensité des émissions de carbone incorporé

Le HGX B200 de NVIDIA abaisse l’intensité des émissions de carbone incorporé de 24% par rapport au HGX H100, tout en offrant de meilleures performances IA et une efficacité énergétique accrue. Cet article résume les données PCF et les nouveautés matérielles.

Scaleway rejoint les Fournisseurs d’Inference de Hugging Face pour une Inférence Serverless et Faible Latence

Scaleway est désormais un Fournisseur d’Inference pris en charge sur Hugging Face Hub, permettant l’inférence serverless directement sur les pages de modèles avec les SDK JS et Python. Accédez à des modèles open-weight populaires et bénéficiez d’une latence réduite.

Prévoir les phénomènes météorologiques extrêmes en quelques minutes sans superordinateur : Huge Ensembles (HENS)

NVIDIA et le Lawrence Berkeley National Laboratory présentent Huge Ensembles (HENS), un outil IA open source qui prévoit des événements météorologiques rares et à fort impact sur 27 000 années de données, avec des options open source ou prêtes à l’emploi.

Comment réduire les goulots d’étranglement KV Cache avec NVIDIA Dynamo

NVIDIA Dynamo déporte le KV Cache depuis la mémoire GPU vers un stockage économique, permettant des contextes plus longs, une meilleure concurrence et des coûts d’inférence réduits pour les grands modèles et les charges AI génératives.

Le Playbook des Grands Maîtres Kaggle: 7 Techniques de Modélisation pour Données Tabulaires

Analyse approfondie de sept techniques éprouvées par les Grands Maîtres Kaggle pour résoudre rapidement des ensembles de données tabulaires à l’aide d’une accélération GPU, des baselines divers à l’assemblage et à la pseudo-étiquetage.

Microsoft transforme le site Foxconn en data center Fairwater AI, présenté comme le plus puissant au monde

Microsoft dévoile des plans pour un data center Fairwater AI de 1,2 million de mètres carrés au Wisconsin, abritant des centaines de milliers de GPU Nvidia GB200. Le projet de 3,3 milliards de dollars promet un entraînement IA sans précédent.