Atelier Apple sur l'apprentissage automatique respectueux de la vie privée (PPML) 2025 — Récapitulatif et ressources

Sources: https://machinelearning.apple.com/updates/ppml-2025

TL;DR

- Apple a organisé un atelier hybride de deux jours, Workshop on Privacy-Preserving Machine Learning (PPML), plus tôt cette année pour discuter de la vie privée, de la sécurité et de l’IA.

- L’atelier a porté sur quatre domaines : apprentissage et statistiques privées ; attaques et sécurité ; fondements de la confidentialité différentielle ; et modèles fondamentaux et confidentialité.

- Apple a partagé des enregistrements de présentations sélectionnées et un récapitulatif des publications sur sa page de recherche en apprentissage automatique.

Contexte et arrière-plan

Apple affirme que la vie privée est un droit humain fondamental et souligne l’importance de créer des techniques de protection de la vie privée parallèlement aux avancées des capacités d’IA. L’entreprise a rappelé sa recherche continue dans l’utilisation de la confidentialité différentielle en apprentissage automatique et a organisé le Workshop on Privacy-Preserving Machine Learning (PPML) en tant qu’événement hybride de deux jours réunissant des chercheurs d’Apple et la communauté de recherche plus large. La rencontre s’est concentrée sur l’intersection de la confidentialité, de la sécurité et des systèmes d’intelligence artificielle en évolution rapide. Les présentations et les discussions ont exploré les fondements théoriques ainsi que les défis pratiques de la construction de systèmes d’IA protégeant la vie privée. Apple a partagé des enregistrements de certaines conférences invitées et un récapitulatif des publications discutées lors de l’atelier.

Ce qui est nouveau

L’atelier a présenté un large éventail de travaux récents couvrant théorie, algorithmes, études empiriques et systèmes pour l’apprentissage automatique préservant la vie privée. Les thèmes principaux comprenaient :

- Apprentissage privé et statistiques, avec des mécanismes d’estimation privée et d’agrégation.

- Attaques et sécurité, examinant les risques d’inférence et d’extraction liés aux modèles personnalisés et aux grands modèles de langage.

- Fondements de la confidentialité différentielle, explorant l’amplification, la composition, la confidentialité en flux et la conception de mécanismes.

- Modèles fondamentaux et confidentialité, y compris des approches pour générer des données synthétiques différentiellement privées via des API de modèles fondamentaux pour les images et le texte. Apple a publié des enregistrements de présentations sélectionnées et une liste organisée des publications discutées lors de l’atelier.

Pourquoi c’est important (impact pour développeurs/entreprises)

- Conception produit : alors que les fonctionnalités d’IA deviennent plus personnelles, les approches discutées au PPML aident les concepteurs et ingénieurs à bâtir des composants respectueux de la vie privée.

- De la recherche à la pratique : le mélange d’avancées théoriques et d’interventions axées sur les systèmes rapproche la recherche académique des systèmes ML déployables.

- Évaluation des risques : les présentations sur les attaques et l’audit soulignent l’importance de la modélisation des menaces pour les modèles et les API, pertinent pour les équipes déployant des modèles fondamentaux et des services personnalisés.

- Conformité et confiance : les fondements et mécanismes de confidentialité différentielle présentés offrent des techniques que les organisations peuvent envisager pour respecter des engagements de confidentialité et renforcer la confiance des utilisateurs.

Détails techniques ou implémentation

L’atelier a couvert des sujets techniques variés. La liste ci-dessous reprend des présentations invitées et des articles présentés pendant le PPML ; les titres et les auteurs sont reproduits à partir des documents partagés par Apple.

Domaines d’intérêt abordés

| Domaine | Exemples de présentations ou articles

| --- |

|---|

| Apprentissage privé et statistiques |

| Attaques et sécurité |

| Fondements de la confidentialité différentielle |

| Modèles fondamentaux et confidentialité |

Présentations sélectionnées (liste partielle)

- Local Pan-Privacy — Guy Rothblum (Apple)

- Differential Private Continual Histograms — Monika Henzinger (IST&A)

- PREAMBLE: Private and Efficient Aggregation of Block Sparse… — Hannah Keller (Aarhus University)

- Tukey Depth Mechanisms for Practical Private Mean Estimation — Gavin Brown (University of Washington)

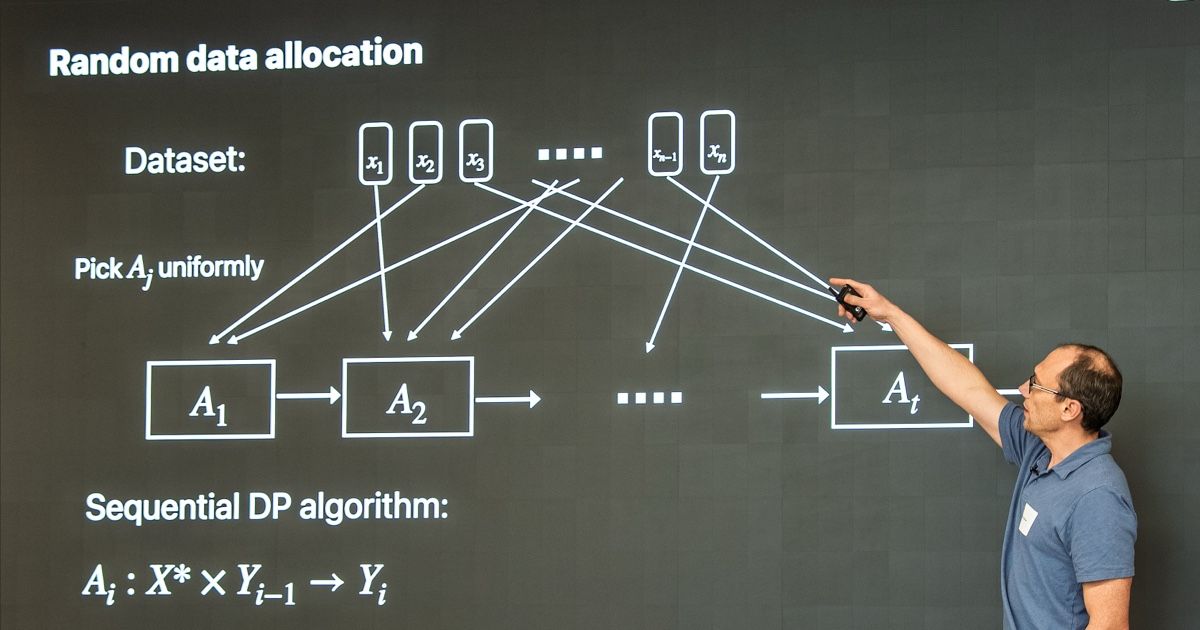

- Privacy Amplification by Random Allocation — Vitaly Feldman (Apple)

- Differentially Private Synthetic Data via Foundation Model APIs — Sivakanth Gopi (Microsoft Research)

- Scalable Private Search with Wally — Rehan Rishi et Haris Mughees (Apple)

- AirGapAgent: Protecting Privacy-Conscious Conversational Agents — Eugene Bagdasarian et al. (Google Research / DeepMind)

- A Generalized Binary Tree Mechanism for Differentially Private Approximation of All-Pair Distances — Michael Dinitz et al.

- Differentially Private Synthetic Data via Foundation Model APIs 1: Images — Zinan Lin et al. (Microsoft Research)

- Differentially Private Synthetic Data via Foundation Model APIs 2: Text — Chulin Xie et al. L’atelier a également remercié de nombreux contributeurs, notamment Hilal Asi, Anthony Chivetta, Vitaly Feldman, Haris Mughees, Martin Pelikan, Rehan Rishi, Guy Rothblum et Kunal Talwar.

Points clés

- La recherche en ML préservant la vie privée reste active, à la croisée de la théorie et des systèmes.

- Les fondements de la confidentialité différentielle et les techniques d’amplification restent centraux pour les déploiements pratiques.

- Comprendre les attaques et effectuer des audits est essentiel pour évaluer les risques de déploiement de modèles personnalisés et de modèles fondamentaux.

FAQ

-

Qu'était PPML 2025 ?

PPML 2025 était un atelier hybride de deux jours sur Privacy-Preserving Machine Learning organisé par Apple pour discuter de l'état de l'art en ML respectueux de la vie privée.

-

Quels étaient les domaines principaux ?

Les quatre domaines principaux étaient Apprentissage et Statistiques Privées ; Attaques et Sécurité ; Fondements de la Confidentialité Différentielle ; et Modèles Fondamentaux et Confidentialité.

-

Les enregistrements sont-ils disponibles ?

Apple a partagé des enregistrements sélectionnés et un récapitulatif des publications sur sa page de recherche ; voir Références.

Références

- Page de l’atelier et enregistrements : https://machinelearning.apple.com/updates/ppml-2025

More news

Anthropic renforce les règles d'utilisation de Claude face à un paysage IA plus dangereux

Anthropic interdit l'aide à la création d'armes CBRN et d'explosifs puissants, ajoute des interdictions cybersécurité, précise le contenu politique et clarifie les usages à haut risque.

Build a scalable containerized web application on AWS using the MERN stack with Amazon Q Developer – Part 1

In a traditional SDLC, a lot of time is spent in the different phases researching approaches that can deliver on requirements: iterating over design changes, writing, testing and reviewing code, and configuring infrastructure. In this post, you learned about the experience and saw productivity gains

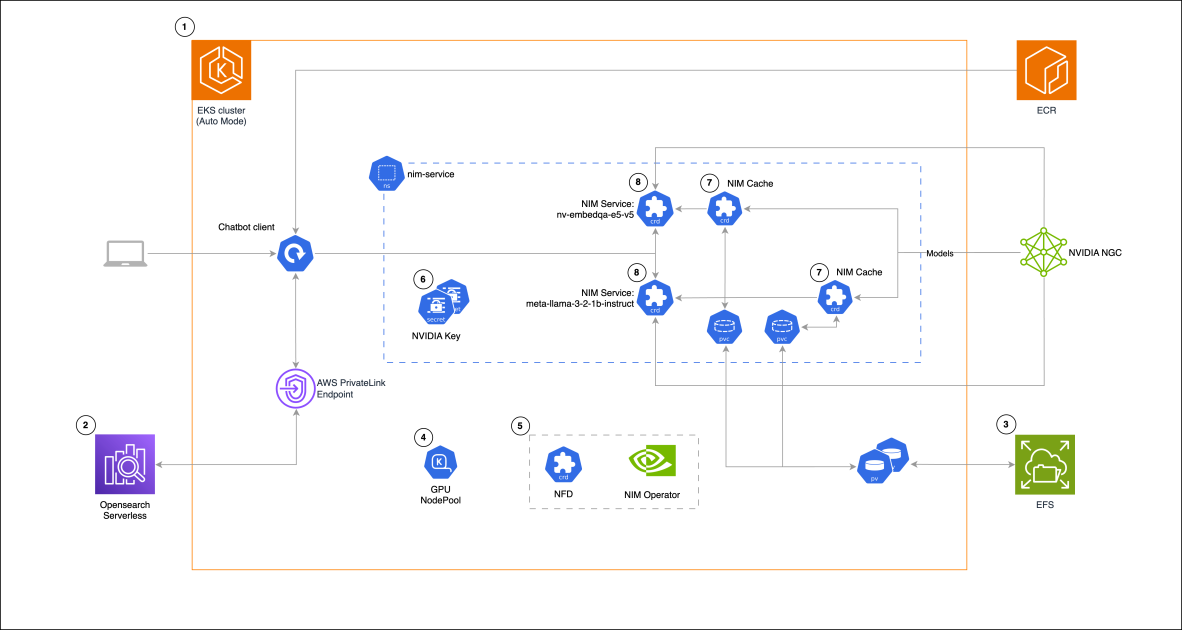

Building a RAG chat-based assistant on Amazon EKS Auto Mode and NVIDIA NIMs

In this post, we demonstrate the implementation of a practical RAG chat-based assistant using a comprehensive stack of modern technologies. The solution uses NVIDIA NIMs for both LLM inference and text embedding services, with the NIM Operator handling their deployment and management. The architectu

GPT-5 a déçu les attentes élevées mais améliore coût, rapidité et codage

Le lancement de GPT-5 a suscité des réactions mitigées : progrès incrémentaux aux benchmarks, coût et latence réduits, meilleure performance en codage, mais critiques sur le ton rédactionnel et des erreurs inattendues.

Introducing Amazon Bedrock AgentCore Gateway: Transforming enterprise AI agent tool development

In this post, we discuss Amazon Bedrock AgentCore Gateway, a fully managed service that revolutionizes how enterprises connect AI agents with tools and services by providing a centralized tool server with unified interface for agent-tool communication. The service offers key capabilities including S

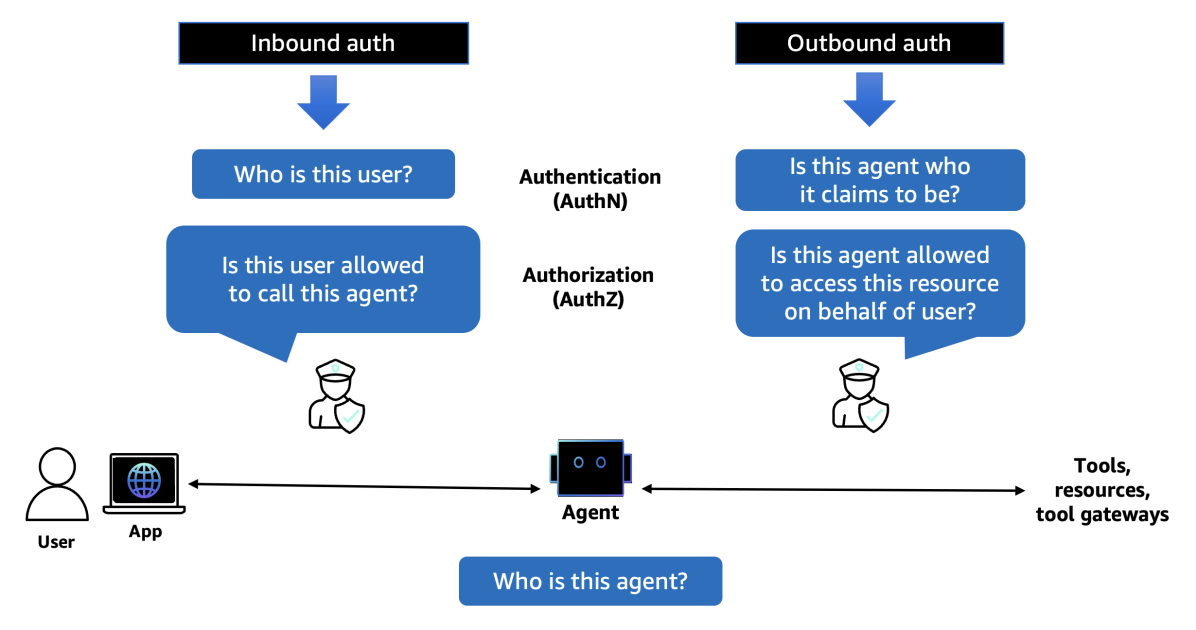

Introducing Amazon Bedrock AgentCore Identity: Securing agentic AI at scale

In this post, we explore Amazon Bedrock AgentCore Identity, a comprehensive identity and access management service purpose-built for AI agents that enables secure access to AWS resources and third-party tools. The service provides robust identity management features including agent identity director