TimeScope : évaluer la compréhension de longues vidéos par les modèles Vision-Language

Sources: https://huggingface.co/blog/timescope-video-lmm-benchmark, Hugging Face Blog

TL;DR

- TimeScope est une référence open source qui teste les modèles vision-langage sur des vidéos longues (1 minute à 8 heures) en insérant des aiguilles (needles).

- Il va au-delà de la récupération pour évaluer la synthèse, la localisation et l’analyse du mouvement fin via trois types d’aiguilles.

- Dans les modèles évalués, les vidéos plus longues exposent des pics de dégradation de performance; augmenter la taille du modèle ne garantit pas une portée temporelle plus longue.

- Gemini 2.5-Pro se démarque particulièrement sur des vidéos de plus d’une heure, tandis que d’autres modèles plafonnent à une longueur de contexte similaire.

- La référence est ouverte et accessible sur Hugging Face.

Contexte et historique

Ces dernières années, l’IA multimodale promet des compétences croissantes pour comprendre des vidéos très longues, reflétant les progrès des modèles à contexte long en langue naturelle. Cependant, évaluer ces affirmations est complexe: les benchmarks vidéo existants utilisent souvent des aiguilles statiques insérées dans les vidéos, ce qui mesure surtout la recherche visuelle plutôt que la compréhension temporelle réelle. Cette approche peut masquer des faiblesses dans le raisonnement sur des séquences temporelles étendues. Des études sur des benchmarks textuels comme HELM et RULER ont mis en évidence la fragilité des capacités de contexte long lorsque les tâches exigent du raisonnement ou de l’agrégation. Dans le domaine vidéo, ce défi est amplifié par le fait que de nombreux modèles sont formés sur des fenêtres temporelles restreintes, bien que l’on présente leur capacité comme plus vaste. Face à cela, TimeScope propose une méthode ciblée pour quantifier la capacité des systèmes multimodaux à comprendre des narrations vidéo sur le long terme.

Ce qu’apporte TimeScope

TimeScope est une référence open source hébergée sur Hugging Face. L’évaluation repose sur l’insertion de plusieurs needles courtes (~5–10 s) dans une vidéo de base qui peut durer 1 minute à 8 heures. Les needles contiennent l’information clé nécessaire pour résoudre la tâche et obligent le modèle à traiter l’entrée complète, sans recourir à des échantillonnages épars. Trois types d’aiguilles sont évalués, chacun visant une dimension différente de la compréhension vidéo longue:

- Récupération localisée et compréhension d’un événement: des questions qui peuvent être répondues en analysant le needle, testant la capacité à localiser et interpréter un événement dans le contexte.

- Synthèse d’informations et extraction de texte dispersé: des needles basées sur du texte, insérées à différents temps, exigent que le modèle identifie tous les mots et les ordonne dans l’ordre chronologique.

- Perception du mouvement et temporalité: pour les questions sur le mouvement, l’échantillonnage d’un seul cadre n’est pas suffisant; le modèle doit percevoir les dynamiques à travers les frames. TimeScope mesure aussi comment les performances varient avec la longueur de la vidéo de base. Les résultats initiaux indiquent une tendance: les performances baissent lorsque le contenu à traiter est plus long, montrant que la compréhension temporelle sur de longues durées demeure difficile même pour des modèles performants. Les évaluations ont été menées sur une gamme de modèles Vision-Language, des options open-source aux grands modèles comme Gemini 2.5-Pro. Les résultats soulignent le potentiel et les limites actuelles de la compréhension de vidéos longues et soulignent la nécessité d’approches d’entraînement ciblées et d’évaluations temporelles robustes.

Pourquoi cela compte (impact pour développeurs/entreprises)

La capacité à raisonner sur des heures de vidéos ouvre des possibilités transformationnelles: des agents autonomes pourraient résumer de longues séquences, détecter des anomalies subtiles au cours d’opérations prolongées et répondre à des questions sur des récits étendus. En robotique, l’analyse sur de longues durées pourrait soutenir une prise de décision en temps réel lors d’opérations prolongées. Pour des applications grand public, des assistants personnels pourraient offrir des retours continus et contextuels tout au long de la vie quotidienne. Cependant TimeScope rappelle aussi une réalité: les promesses d’une compréhension de vidéos sur des heures ne sont pas encore généralisables. L’évaluation incite les développeurs et les entreprises à s’appuyer sur des tests temporels rigoureux pour guider le choix des modèles, prioriser les axes d’entraînement et planifier le déploiement dans des scénarios de vidéos longues.

Détails techniques ou Mise en œuvre

TimeScope utilise le principe d’insertion d’aiguilles. Une vidéo de base sert de “faisceau” et des aiguilles courtes sont insérées à des positions aléatoires. Les aiguilles portent les informations-clés nécessaires pour répondre aux questions, forçant le modèle à intégrer l’information tout au long de la timeline et non à se contenter de blocs statiques. Les trois types d’aiguilles testent des dimensions distinctes de la compréhension:

- Récupération locale et compréhension: des questions nécessitent d’identifier le contenu dans l’aiguille afin d’obtenir la réponse.

- Synthèse d’informations dispersées: les aiguilles textuelles nécessitent d’extraire et d’organiser les mots dans l’ordre chronologique.

- Perception du mouvement: les questions sur le mouvement exigent de suivre les dynamiques entre les frames. TimeScope évalue aussi comment les performances varient avec la durée de la vidéo de base. Les premiers résultats montrent des tendances où l’augmentation de la longueur du contenu entraîne une chute des performances, indiquant que la fidélité temporelle à long terme demeure un défi. Le Gemini 2.5-Pro se démarque en maintenant une meilleure précision sur des vidéos longues. Les résultats montrent des compromis entre tâches: par exemple, Qwen 2.5-VL excelle en synthèse d’informations (OCR) mais est moins performant en Perception Temporelle Fine. TimeScope encourage des recherches axées sur une compréhension temporelle équilibrée et robuste. La version open-source de TimeScope invite la communauté à reproduire, étendre et améliorer l’évaluation de vidéos longues. Tous les composants sont disponibles pour l’étude et le développement, avec des résultats et visualisations accessibles via l’espace Hugging Face qui l’accompagne.

Points clés à retenir

- La compréhension de vidéos longues reste un domaine où les promesses dépassent encore les résultats concrets.

- L’augmentation de la taille du modèle ne garantit pas une portée temporelle plus longue.

- Des pics de dégradation apparaissent à certaines durées, soulignant le besoin d’entraînements adaptés à la durée.

- Les modèles montrent des forces et des faiblesses différentes selon la tâche: synthèse d’informations (OCR) vs perception du mouvement.

- L’ouverture de TimeScope favorise l’évaluation rigoureuse et la progression collective vers des systèmes multimodaux mieux alignés sur le long terme.

FAQ

Références

More news

Scaleway rejoint les Fournisseurs d’Inference de Hugging Face pour une Inférence Serverless et Faible Latence

Scaleway est désormais un Fournisseur d’Inference pris en charge sur Hugging Face Hub, permettant l’inférence serverless directement sur les pages de modèles avec les SDK JS et Python. Accédez à des modèles open-weight populaires et bénéficiez d’une latence réduite.

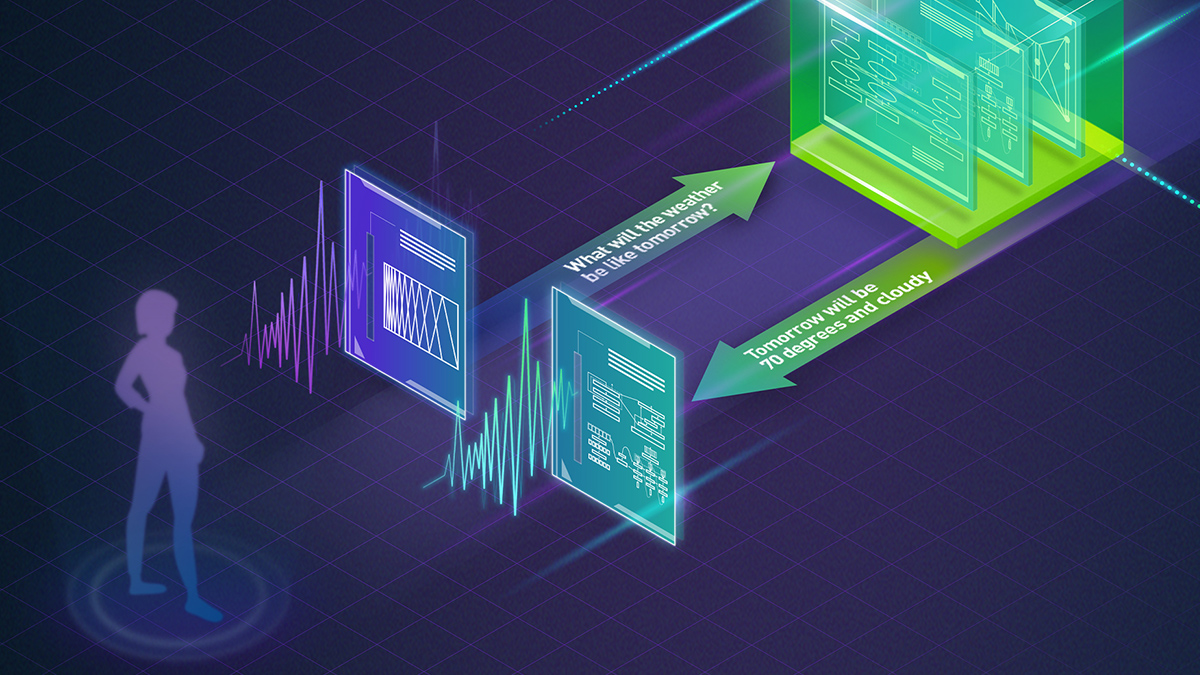

Prévoir les phénomènes météorologiques extrêmes en quelques minutes sans superordinateur : Huge Ensembles (HENS)

NVIDIA et le Lawrence Berkeley National Laboratory présentent Huge Ensembles (HENS), un outil IA open source qui prévoit des événements météorologiques rares et à fort impact sur 27 000 années de données, avec des options open source ou prêtes à l’emploi.

Créer des flux de travail agentiques avec GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore

Vue d’ensemble complète sur le déploiement des modèles GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore pour alimenter un analyseur d’actions multi-agents avec LangGraph, incluant la quantification MXFP4 en 4 bits et une orchestration sans serveur.

Autodesk Research mène la CFD à vitesse Warp sur le NVIDIA GH200

Autodesk Research, Warp de NVIDIA et le GH200 démontrent une CFD Python-native avec XLB, atteignant environ 8x de vitesse et évoluant jusqu’à 50 milliards de cellules.

Réduire la latence de démarrage à froid pour l’inférence LLM avec NVIDIA Run:ai Model Streamer

Analyse approfondie sur la façon dont NVIDIA Run:ai Model Streamer abaisse les temps de démarrage à froid pour l’inférence des LLM en diffusant les poids vers la mémoire GPU, avec des benchmarks sur GP3, IO2 et S3.

Qwen3-Next Modèles MoE Hybrides Open Source : Précision Améliorée et Inférence Plus Rapide sur la Plateforme NVIDIA

Les prévisualisations open source Qwen3-Next 80B-A3B-Thinking et 80B-A3B-Instruct présentent une architecture MoE hybride pour un contexte long et une inférence efficace, avec déploiement et outils ouverts soutenus par NVIDIA.