TimeScope : Benchmark pour mesurer la compréhension de vidéos longues par les modèles multimodaux

Sources: https://huggingface.co/blog/timescope-video-lmm-benchmark, Hugging Face Blog

TL;DR

- TimeScope est un benchmark open source hébergé sur Hugging Face qui mesure la capacité des modèles vision-langage à comprendre des vidéos longues en insérant des needles courtes (~5–10 secondes) dans des vidéos de base allant de 1 minute à 8 heures. TimeScope blog

- Le benchmark évalue trois types de tâches et trois types de needles pour aller au-delà de la récupération brute, en couvrant synthèse, localisation et analyse de mouvement fin. TimeScope blog

- Gemini 2.5-Pro se distingue en conservant une précision élevée sur les vidéos de plus d’une heure; Qwen 2.5-VL (3B et 7B) et InternVL 2.5 (2B, 4B, 8B) présentent des courbes de long vidéo similaires à leurs homologues plus petits. TimeScope blog

- Les résultats montrent que la compréhension des vidéos d’une heure reste difficile et que l’open-sourcing de TimeScope peut guider des améliorations ciblées dans l’entraînement et l’évaluation des modèles multimodaux. TimeScope blog

Contexte et arrière-plan

Les capacités de contexte long dans les modèles vision-langage attirent de plus en plus d’attention, parallèlement aux avancées des modèles de langage à contexte étendu. Bien que certains systèmes annoncent des fenêtres de contexte couvrant des milliers de cadres, il existe un scepticisme sur la véritable compréhension temporelle. Les benchmarks vidéo existants comme Video Needle in a Haystack (VideoNIAH) injectent des needles statiques et mesurent la recherche visuelle plutôt que le raisonnement temporel réel. Des efforts tels que HELM et RULER ont démontré la fragilité des affirmations sur le long contexte lorsque les tâches exigent raisonnement ou agrégation temporelle. TimeScope blog TimeScope s’inscrit dans ce contexte en tant que benchmark open-source destiné à tester une compréhension temporelle plus profonde sur des vidéos longues. Il complète les évaluations axées sur le texte et les images en se concentrant sur la compréhension temporelle étendue. TimeScope blog TimeScope est hébergé en open source sur Hugging Face et propose un outil concret pour mesurer dans quelle mesure les modèles peuvent raisonner sur des narrations vidéo longues plutôt que de se limiter à des extraits ou à des indices frame-par-frame. L’objectif est de migrer d’affirmations générales vers des évaluations robustes du raisonnement temporel, de la synthèse et de l’analyse du mouvement. TimeScope blog

Quoi de neuf

TimeScope introduit une approche de test innovante pour des vidéos longues. Une vidéo de base longue (1 minute à 8 heures) sert de “haies”, et des needles courtes (environ 5–10 secondes) sont insérées à des positions aléatoires. L’objectif n’est pas seulement de repérer l’aiguille, mais d’exiger une compréhension profonde du contenu dans le contexte global pour répondre à des questions ou effectuer des analyses. TimeScope blog Trois types de needles et trois types de tâches composent l’évaluation :

- Les types de tâches examinent la récupération, la synthèse et la localisation, avec une emphase sur l’intégration des informations au fil du temps. Par exemple, une question peut porter sur le mode de transport montré dans des clips dispersés du vidéo. TimeScope blog

- Les needles incluent des needles basées sur le texte (2–4 clips courts affichant des mots à l’écran) qui obligent le modèle à identifier et ordonner les mots dispersés dans l’ordre chronologique, simulant l’extraction d’horodatages ou de faits clefs. TimeScope blog

- Une needles axée sur le mouvement teste les dynamiques dans de courts clips; des questions comme « Combien de fois l’homme a balancé sa hache ? » nécessitent une perception du mouvement sur plusieurs frames. TimeScope blog Avec des longueurs de vidéo variables et des positions de needles aléatoires, TimeScope mesure combien de vidéo un modèle peut réellement traiter et montre que la performance chute à mesure que la vidéo s’allonge. Dans les premiers tests, TimeScope a été appliqué à une suite de modèles vision-langage, des favoris open-source aux poids lourds comme Gemini 2.5-Pro. Les résultats soulignent les points faibles en raisonnement temporel, en synthèse d’information et en perception du mouvement, ouvrant la voie à des améliorations ciblées dans l’entraînement et l’évaluation. Pour des résultats détaillés et des visualisations, consultez l’espace Hugging Face associé. TimeScope blog

Pourquoi cela compte pour les développeurs/entreprises

TimeScope traite une question clé pour les déploiements réels : les systèmes peuvent-ils comprendre des narrations vidéo longues, ou se contentent-ils de récupérer des segments pertinents ? Des applications telles que la robotique, l’analyse d’opérations prolongées et la synthèse de vidéos longues exigent un raisonnement temporel sur plusieurs heures. L’ouverture du code de TimeScope permet à la communauté de tester des modèles de manière cohérente, de comparer des approches et d’orienter les stratégies d’entraînement pour améliorer le raisonnement temporel et l’analyse du mouvement. TimeScope blog Les résultats rappellent aussi que l’augmentation de la taille d’un modèle n’assure pas forcément une fenêtre temporelle plus longue. TimeScope met en évidence les limites actuelles et appelle à des approches de formation et d’architecture adaptées au raisonnement temporel long. TimeScope blog

Détails techniques ou d’implémentation

La prémisse de TimeScope est simple et puissante : insérer des needles courtes dans des vidéos longues et exiger une compréhension holistique pour résoudre les tâches. Les needles, courtes (5–10 secondes) sont conçues pour pousser les modèles à relier des informations au fil du temps, plutôt que de s’appuyer sur une échantillonnage dense. La vidéo de base varie de 1 minute à 8 heures, créant des scénarios de contexte long pour l’évaluation. TimeScope blog Points techniques clés :

- Insertion des needles : une vidéo-base longue sert de haystack, et une ou plusieurs needles courtes sont insérées à des positions aléatoires. Les needles contiennent les informations-clés nécessaires pour résoudre la tâche, obligeant le modèle à traiter l’entrée entière sans raccourcis. TimeScope blog

- Trois types de needles, chacun visant un aspect différent de la compréhension de vidéos longues : (1) needles basées sur le texte pour identifier et ordonner des mots dispersés, (2) needles centrées sur le mouvement pour tester la dynamique interframes, et (3) needles de localisation pour cibler du contenu au fil du temps. TimeScope blog

- Les tâches évaluent la récupération, la synthèse d’information, la localisation et l’analyse du mouvement sur des vidéos de longue durée. TimeScope blog Dans les premiers résultats, Gemini 2.5-Pro se distingue en maintenant une précision robuste sur les vidéos de plus d’une heure, tandis que Qwen 2.5-VL (3B et 7B) et InternVL 2.5 (2B, 4B, 8B) présentent des courbes de long vidéo presque identiques à celles des variantes plus petites et atteignent à peu près le même horizon de contexte. Ces tendances soulignent que l’augmentation de la taille ne garantit pas nécessairement un horizon temporel plus long. TimeScope blog TimeScope est open source et toutes les composantes sont disponibles pour la communauté. Le projet comprend également un Hugging Face Space proposant des résultats détaillés et des visualisations, aidant chercheurs et développeurs à diagnostiquer les faiblesses et à orienter les améliorations en formation et évaluation. TimeScope blog

Tableau rapide de comparaison

| Modèle | Comportement sur les vidéos longues | Remarque |---|---|---| | Gemini 2.5-Pro | Précision élevée sur les vidéos > 1 heure | Ex primeur parmi les modèles testés |Qwen 2.5-VL 3B | Courbe longue similaire aux variantes plus petites | Excelle dans la synthèse OCR; faiblesse possible en perception temporelle fine |Qwen 2.5-VL 7B | Courbe longue similaire à 3B | Tendances similaires; raisonnement temporel robuste requis |InternVL 2.5 (2B/4B/8B) | Courbes longues similaires entre les tailles | Plateau autour du même horizon |

Points clés à retenir

- La compréhension vidéo sur des heures reste un objectif et les affirmations de traitement de milliers de frames ne sont pas encore reflétées dans des performances robustes sur des scénarios longs. TimeScope blog

- Les performances des modèles se dégradent en fonction de la longueur du vidéo, soulignant le besoin d’un raisonnement temporel véritable plutôt que de la simple récupération statique. TimeScope blog

- Le Gemini 2.5-Pro se démarque pour des vidéos plus longues, mais la plupart des modèles montrent un comportement de plateau, ce qui suggère des limites des architectures actuelles ou des données d’entraînement. TimeScope blog

- Augmenter le nombre de paramètres seul ne garantit pas un horizon temporel plus long; TimeScope met en évidence des compromis entre les tâches comme la synthèse d’information et la perception du mouvement. TimeScope blog

- L’ouverture du code de TimeScope encourage la communauté à améliorer les données, les régimes d’entraînement et les méthodes d’évaluation pour progresser vers une compréhension vidéo vraiment longue durée. TimeScope blog

FAQ

-

- **Q : Qu’est-ce que TimeScope ?**

TimeScope est un benchmark open source sur Hugging Face qui teste la compréhension de vidéos longues en insérant des needles dans des vidéos-base pour mesurer le raisonnement temporel et l’analyse du mouvement. - **Q : Comment les needles sont-elles insérées et que testent-elles ?** **A :** Des needles courtes (~5–10 secondes) sont insérées à des positions aléatoires dans des vidéos-base (1 minute à 8 heures). Elles testent la récupération, la synthèse d’information, la localisation et l’analyse du mouvement dans le temps. - **Q : Quels résultats ont été observés ?** **A :** Gemini 2.5-Pro conserve une précision robuste sur les vidéos dépassant une heure; Qwen 2.5-VL et InternVL 2.5 présentent des courbes de long vidéo proches des variantes plus petites, avec plateau local. - **Q : Pourquoi cela est-il important pour les équipes de développement ?** **A :** Cela fournit une méthode ouverte et standardisée pour évaluer la compréhension de vidéos longues, guidant la collecte de données, la conception de modèles et les stratégies d’entraînement pour améliorer le raisonnement temporel et la perception du mouvement.

Références

More news

Scaleway rejoint les Fournisseurs d’Inference de Hugging Face pour une Inférence Serverless et Faible Latence

Scaleway est désormais un Fournisseur d’Inference pris en charge sur Hugging Face Hub, permettant l’inférence serverless directement sur les pages de modèles avec les SDK JS et Python. Accédez à des modèles open-weight populaires et bénéficiez d’une latence réduite.

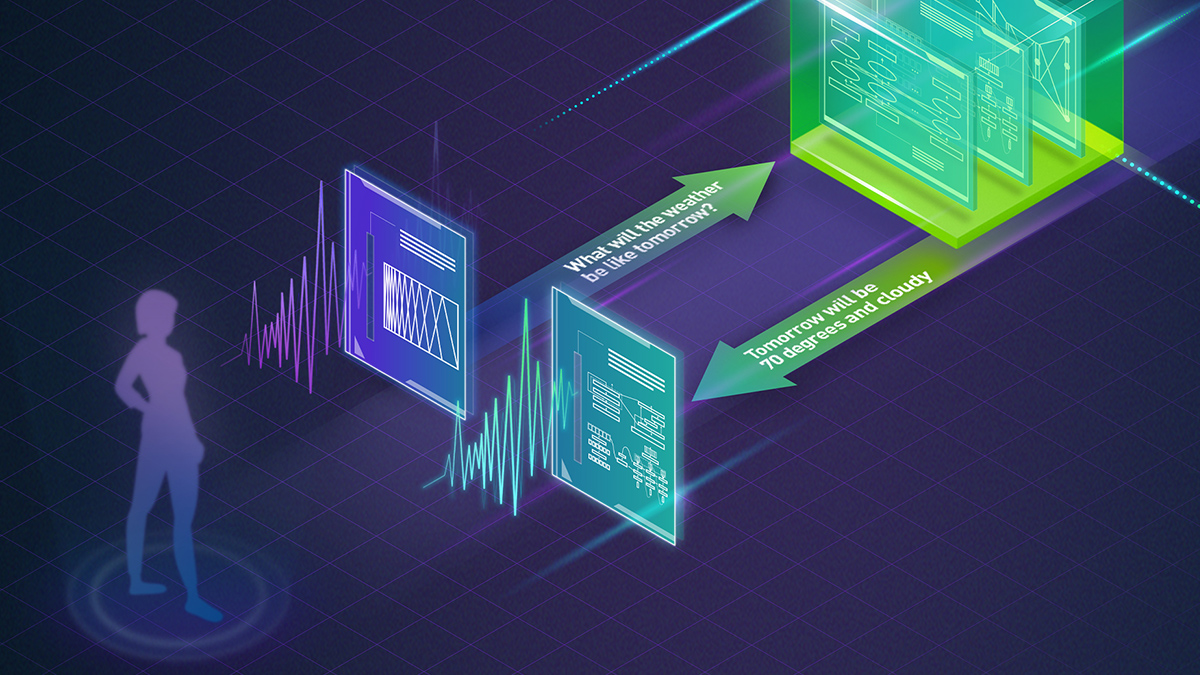

Prévoir les phénomènes météorologiques extrêmes en quelques minutes sans superordinateur : Huge Ensembles (HENS)

NVIDIA et le Lawrence Berkeley National Laboratory présentent Huge Ensembles (HENS), un outil IA open source qui prévoit des événements météorologiques rares et à fort impact sur 27 000 années de données, avec des options open source ou prêtes à l’emploi.

Créer des flux de travail agentiques avec GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore

Vue d’ensemble complète sur le déploiement des modèles GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore pour alimenter un analyseur d’actions multi-agents avec LangGraph, incluant la quantification MXFP4 en 4 bits et une orchestration sans serveur.

Autodesk Research mène la CFD à vitesse Warp sur le NVIDIA GH200

Autodesk Research, Warp de NVIDIA et le GH200 démontrent une CFD Python-native avec XLB, atteignant environ 8x de vitesse et évoluant jusqu’à 50 milliards de cellules.

Réduire la latence de démarrage à froid pour l’inférence LLM avec NVIDIA Run:ai Model Streamer

Analyse approfondie sur la façon dont NVIDIA Run:ai Model Streamer abaisse les temps de démarrage à froid pour l’inférence des LLM en diffusant les poids vers la mémoire GPU, avec des benchmarks sur GP3, IO2 et S3.

Qwen3-Next Modèles MoE Hybrides Open Source : Précision Améliorée et Inférence Plus Rapide sur la Plateforme NVIDIA

Les prévisualisations open source Qwen3-Next 80B-A3B-Thinking et 80B-A3B-Instruct présentent une architecture MoE hybride pour un contexte long et une inférence efficace, avec déploiement et outils ouverts soutenus par NVIDIA.