Consilium : Quand plusieurs LLM collaborent pour atteindre un consensus

Sources: https://huggingface.co/blog/consilium-multi-llm, Hugging Face Blog

TL;DR

- Consilium est une plateforme multi-LLM qui permet aux modèles d’IA de discuter de questions complexes et d’atteindre un consensus par le biais de débats structurés.

- Elle fonctionne à la fois comme une interface Gradio et comme un serveur MCP (Model Context Protocol), s’intégrant à des applications pour faciliter une collaboration dynamique des agents.

- Le projet introduit des rôles, des rounds et un analyste principal pour synthétiser les résultats, ainsi qu’un agent de recherche pour les modèles avec appel de fonction et cinq sources de recherche.

- Un benchmark MAI-DxO de Microsoft est cité pour démontrer comment la collaboration multi-IA peut surpasser l’analyse individuelle, validant l’approche de Consilium.

- Des développements en cours incluent l’intégration du Open Floor Protocol, l’élargissement de la sélection de modèles et des rôles d’agents configurables.

Contexte et antécédents

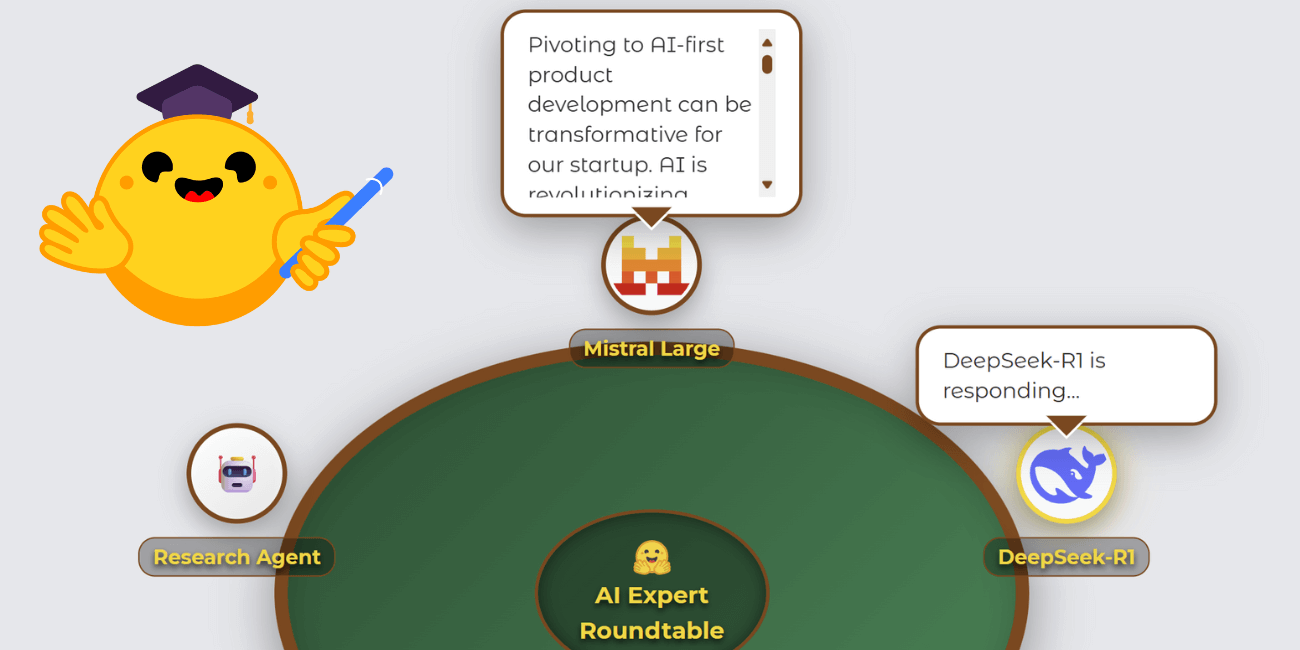

Comme décrit dans le blog Hugging Face, Consilium est une plateforme IA qui permet à plusieurs modèles de discuter de questions et d’atteindre un consensus par des débats structurés. Le projet est né lors d’un hackathon Gradio Agents & MCP et a évolué d’un simple serveur MCP vers un environnement de débat collaboratif plus riche. L’auteur souligne que l’idée centrale est le consensus par la discussion, un concept qui a reçu un écho particulier après le travail MAI-DxO de Microsoft, qui présentait un panel d’IA avec des rôles distincts pour diagnostiquer des problèmes. Le travail a montré que la collaboration entre plusieurs perspectives d’IA peut dépasser l’analyse d’un seul modèle, illustrant la valeur potentielle de Consilium. Le design met aussi l’accent sur une expérience utilisateur engageante. Plutôt qu’une interface de chat standard, le développeur a créé une visualisation en table ronde façon poker pour asseoir les LLM autour d’une table, affichant les réponses, l’état de réflexion et l’activité de recherche. Cette approche visuelle est implémentée comme un composant Gradio personnalisé, cœur de la démonstration et clé pour qualifier le projet dans plusieurs tracks du hackathon. Le développement du composant a bénéficié de l’excellente expérience développeur de Gradio, avec seulement une lacune de documentation sur la publication PyPI qui a conduit l’auteur à contribuer au premier projet Gradio. L’état de la table est géré via un dictionnaire de session, avec un objet d’état principal suivant les participants, les messages, le locuteur actuel, la réflexion et l’affichage des bulles, mis à jour via des callbacks update_visual_state pour produire des mises à jour en temps réel. Le projet a aussi exploré la nécessité de rôles structurés pour rendre les discussions entre LLMs productives. Des expériences initiales ont montré que sans rôles définis, les conversations manquaient de stimulation. En introduisant des rôles distincts et un analyste leader pour synthétiser le résultat final et évaluer si le consensus était atteint, la dynamique des échanges s’est améliorée. Deux modes de communication alternatifs ont été ajoutés en plus du partage contextuel complet, afin d’offrir plus de contrôle sur l’interaction des modèles pendant les débats. Les rondes de discussion configurables (1 à 5) ont été introduites et les tests ont montré que davantage de rounds augmentent la probabilité d’atteindre le consensus, au prix d’un coût computationnel.

Ce qui est nouveau

Depuis sa création, Consilium a intégré plusieurs fonctionnalités et intégrations notables. La plateforme inclut désormais :

- Un mécanisme d’analyste leader où l’utilisateur sélectionne un LLM pour synthétiser le résultat final et évaluer le consensus.

- Des rounds de discussion configurables (1–5), avec des tests montrant que plus de rounds augmentent la probabilité de consensus, mais nécessitent plus de calcul.

- Une sélection de modèles actuelle comprenant Mistral Large, DeepSeek-R1, Meta-Llama-3.3-70B et QwQ-32B. Claude Sonnet et OpenAI o3 n’ont pas été inclus en raison des crédits hackathon et des considérations des sponsors, et non de limitations techniques.

- Un agent de recherche dédié pour les modèles prenant en charge les appels de fonction, apparaissant comme un autre participant sur la table. Cet agent accède à cinq sources : Web Search, Wikipedia, arXiv, GitHub et SEC EDGAR.

- Une architecture de base extensible pour des outils de recherche, permettant une expansion future et priorisant des ressources librement intégrables.

- Des indicateurs de progression et des estimations de temps pour les tâches de recherche longues afin de maintenir l’engagement des utilisateurs.

- Une compatibilité avec le Open Floor Protocol (OFP) pour standardiser la communication entre agents sur plusieurs plateformes. OFP permet d’inviter et de retirer dynamiquement des agents tout en maintenant la conscience de la conversation. Le projet intègre activement OFP, avec le développement continu hébergé à https://huggingface.co/spaces/azettl/consilium_ofp. Notez que le travail OFP vise à standardiser l’échange de messages entre agents, ce qui peut faciliter l’intégration multi-plateformes et l’orchestration d’agents dans des scénarios réels.

Pourquoi cela compte (impact pour les développeurs/entreprises)

Consilium illustre une transition vers des systèmes d’IA collaboratifs où plusieurs modèles spécialisés discutent et synthétisent des résultats plutôt que de dépendre d’un seul modèle généraliste. Le blog souligne que la collaboration multi-perspectives peut surpasser l’analyse d’un seul modèle, un point soutenu par des travaux de diagnostic IA qui ont obtenu une précision bien plus élevée lorsque plusieurs perspectives étaient combinées. Les implications pour les développeurs et les entreprises incluent :

- Amélioration de la qualité des décisions : des débats structurés avec des rôles et une synthèse par analyste leader peuvent produire des conclusions plus robustes.

- Flexibilité et extensibilité : le serveur MCP et l’architecture modulaire permettent l’intégration dans des workflows existants et l’ajout futur de modèles et de types d’agents.

- Transparence et traçabilité : l’état de la table et les mises à jour incrémentielles offrent une vue claire sur la manière dont les conclusions ont été atteintes, avec les processus de réflexion et les activités de recherche visibles pour les utilisateurs.

- Workflows collaboratifs personnalisables : les utilisateurs peuvent régler le nombre de rounds, définir les rôles et choisir parmi un ensemble croissant de modèles pour des cas d’usage spécifiques et des contraintes de ressources. Cette approche s’inscrit aussi dans des tendances industrielles plus larges autour de l’orchestration et de la gouvernance de l’IA, suggérant que les systèmes multi-agents pourraient devenir une alternative pratique ou un complément aux grands modèles de but général pour de nombreux cas d’utilisation. En associant une interface visuelle interactive à un backend robuste (serveur MCP) et des protocoles fondés sur des standards (Open Floor Protocol), Consilium se positionne comme un modèle pour les flux de travail IA collaboratifs dans des déploiements réels.

Détails techniques ou Mise en œuvre

Au cœur, Consilium gère un état par session qui alimente la visualisation front-end et la logique de débat back-end. Les éléments clés : participants, messages, currentSpeaker, thinking et showBubbles. Les mutations d’état se font via une boucle de mise à jour simple : lorsque les modèles réfléchissent, parlent ou effectuent des recherches, le backend ajoute des entrées à la liste des messages et bascule les indicateurs de speaker/pensée, assurant un retour visuel en temps réel sans machines à états complexes. Les choix architecturaux importants incluent :

- Intégration MCP : Consilium peut agir comme serveur MCP, permettant de dialoguer avec des projets et applications existants et facilitant l’intégration dans des flux de travail réels.

- Composant Gradio personnalisé : la visualisation de la table est réalisée via un composant Gradio riche, offrant des interactions comme les bulles de parole, les états de pensée et le suivi de la recherche, et servant de cœur pour la démonstration multi-modèles en temps réel.

- Rôles d’agents distincts : l’introduction de rôles a permis de rendre le débat plus productif et d’éviter l’absence d’engagement lorsque le contexte est partagé sans structure.

- Synthèse par l’analyste leader : les utilisateurs peuvent désigner un LLM pour synthétiser le résultat final et vérifier la présence d’un consensus, fournissant un point de décision clair.

- Rounds configurables : de 1 à 5 rounds, balançant coût computationnel et probabilité de consensus.

- Sélection de modèles : la liste actuelle comprend Mistral Large, DeepSeek-R1, Meta-Llama-3.3-70B et QwQ-32B. Claude Sonnet et OpenAI o3 ne font pas partie de la sélection, pour des raisons de crédits hackathon et de sponsorisation.

- Agent de recherche fonctionnel : pour les modèles qui supportent les appels de fonction, un agent de recherche apparaît comme un autre participant. Cet agent peut accéder à cinq sources (Web, Wikipedia, arXiv, GitHub, SEC EDGAR) via une architecture de base extensible.

- Intégration OFP : OFP standardise les messages entre agents et permet d’ajouter/supprimer des agents tout en conservant une conscience continue de la conversation. L’intégration OFP est en cours et détaillée dans l’espace dédié : https://huggingface.co/spaces/azettl/consilium_ofp. D’un point de vue opérationnel, les recherches peuvent être longues. Pour maintenir l’engagement, l’interface affiche des indicateurs de progression et des estimations de temps pour les tâches de recherche, offrant une visibilité sur les durées prévues. Le design du projet reflète des recherches et des études sur le multi-agent et les débats productifs. L’expérience communautaire du hackathon, avec du soutien et de la collaboration sur Discord, a aussi façonné le développement. Pour suivre l’intégration OFP, voir l’espace mentionné ci-dessus.

Points clés

- Consilium démontre comment des débats entre plusieurs LLM peuvent produire des résultats de meilleure qualité qu’un seul modèle.

- L’interface Gradio personnalisée associée au serveur MCP offre une plateforme intégrable et évolutive pour les workflows IA collaboratifs.

- Les rôles, l’analyste leader et les rounds configurables améliorent l’engagement et la qualité des décisions.

- L’agent de recherche dédié et l’accès à cinq sources permettent une recherche robuste et traçable.

- L’intégration OFP est en progression pour standardiser la collaboration multi-agents entre plateformes.

FAQ

-

- **Q : Qu’est-ce que Consilium ?**

Une plateforme multi-LLM qui permet aux IA de discuter et de parvenir à un consensus via des débats structurés, accessible comme espace Gradio et comme serveur MCP. - **Q : Quels modèles sont utilisés dans Consilium ?** **A :** Mistral Large, DeepSeek-R1, Meta-Llama-3.3-70B et QwQ-32B. Claude Sonnet et OpenAI o3 ne sont pas inclus pour des raisons liées aux crédits hackathon et sponsors. - **Q : Qu’est-ce que l’Open Floor Protocol dans ce contexte ?** **A :** Un protocole de communication entre agents avec des messages JSON standardisés; l’intégration OFP permet d’inviter/d’exclure dynamiquement des agents tout en maintenant la conversation. Voir https://huggingface.co/spaces/azettl/consilium_ofp. - **Q : Comment le consensus est-il déterminé ?** **A :** Par un analyste leader qui synthétise le résultat final et évalue si le consensus a été atteint, dans des rounds configurables. - **Q : Quels composants techniques principaux ?** **A :** Un serveur MCP, un composant Gradio personnalisé pour la mesa, un état de session, un agent de recherche avec cinq sources et des plans pour OFP.

Références

More news

Scaleway rejoint les Fournisseurs d’Inference de Hugging Face pour une Inférence Serverless et Faible Latence

Scaleway est désormais un Fournisseur d’Inference pris en charge sur Hugging Face Hub, permettant l’inférence serverless directement sur les pages de modèles avec les SDK JS et Python. Accédez à des modèles open-weight populaires et bénéficiez d’une latence réduite.

Comment réduire les goulots d’étranglement KV Cache avec NVIDIA Dynamo

NVIDIA Dynamo déporte le KV Cache depuis la mémoire GPU vers un stockage économique, permettant des contextes plus longs, une meilleure concurrence et des coûts d’inférence réduits pour les grands modèles et les charges AI génératives.

Réduire la latence de démarrage à froid pour l’inférence LLM avec NVIDIA Run:ai Model Streamer

Analyse approfondie sur la façon dont NVIDIA Run:ai Model Streamer abaisse les temps de démarrage à froid pour l’inférence des LLM en diffusant les poids vers la mémoire GPU, avec des benchmarks sur GP3, IO2 et S3.

Simplifier l accès aux changements de contenu ISO-rating avec Verisk Rating Insights et Amazon Bedrock

Verisk Rating Insights, propulsé par Amazon Bedrock, LLM et RAG, offre une interface conversationnelle pour accéder aux changements ERC ISO, réduisant les téléchargements manuels et accélérant les informations fiables.

Comment msg a renforcé la transformation RH avec Amazon Bedrock et msg.ProfileMap

Cet article explique comment msg a automatisé l'harmonisation des données pour msg.ProfileMap en utilisant Amazon Bedrock pour alimenter des flux d'enrichissement pilotés par LLM, améliorant la précision de l'appariement des concepts RH, réduisant la charge manuelle et assurant la conformité avec l'

Automatiser des pipelines RAG avancés avec Amazon SageMaker AI

Optimisez l’expérimentation jusqu’à la production pour le RAG (Retrieval Augmented Generation) avec SageMaker AI, MLflow et Pipelines, afin d’obtenir des flux reproductibles, évolutifs et gouvernés.