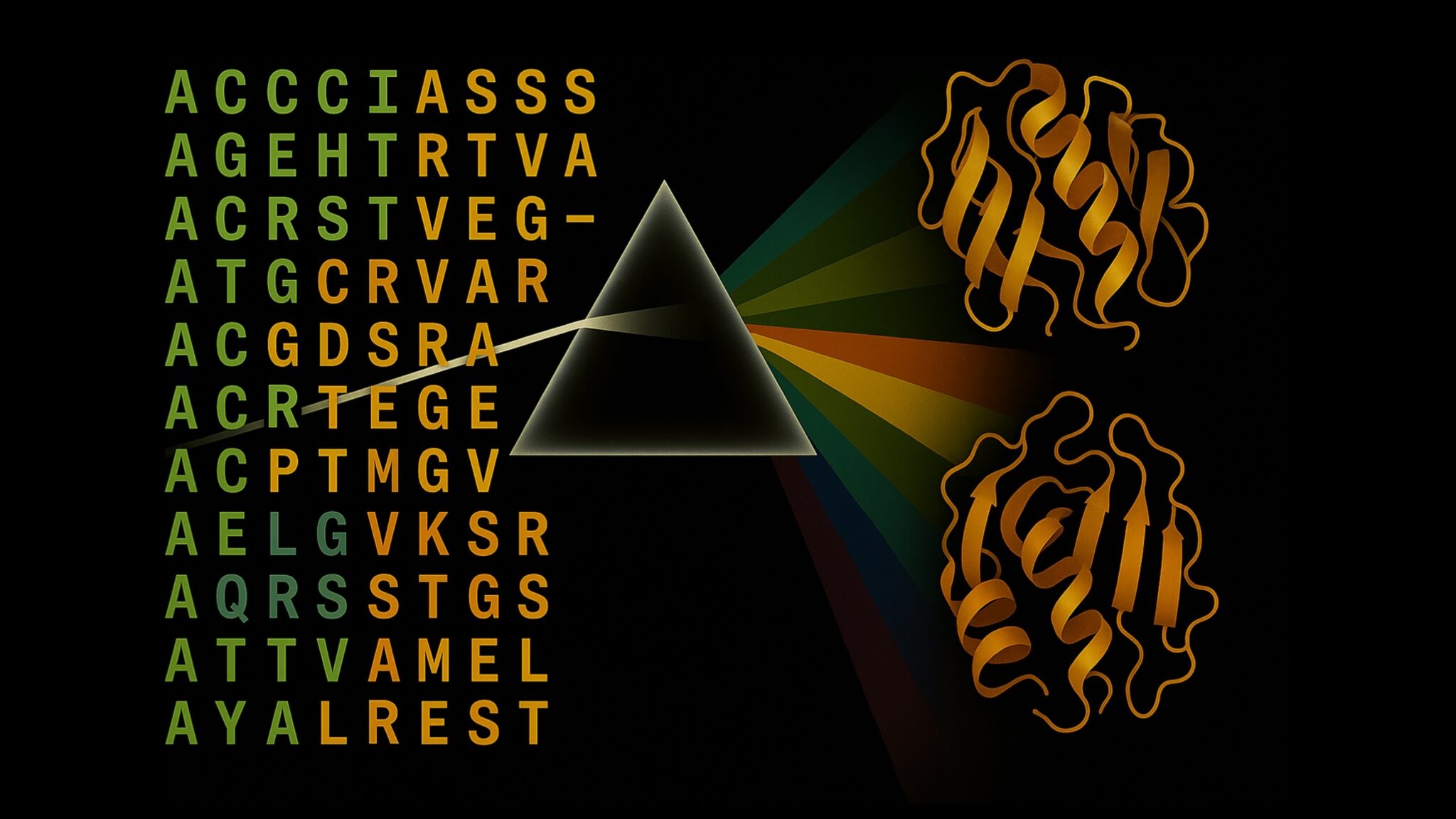

Seq vs Seq : la suite Ettin d’encodeurs et decodeurs appariés

Sources: https://huggingface.co/blog/ettin, Hugging Face Blog

TL;DR

- Ettin introduit les premiers modèles d’État de l’art appariés encodeur uniquement et décodeur uniquement, entraînés sur des données identiques, des formes de modèles identiques et des recettes d’entraînement identiques source.

- La suite couvre six échelles allant de 17M à 1B de paramètres pour les encodeurs et les décodeurs source.

- L’entraînement suit une recette en trois phases : pré-entraînement sur 1,7T de tokens avec des contextes courts, extension de contexte à 8K tokens sur 250B de tokens, puis une phase de Décroissance avec 100B tokens issus de sources premium source.

- Toutes les données d’entraînement sont publiques et reproductibles, ce qui permet des comparaisons équitables ; les encodeurs excellent en classification et récupération, tandis que les décodeurs dominent la génération source.

- Sur les benchmarks, les modèles Ettin surpassent ou égalent des baselines établies comme Llama 3.2 1B et SmolLM2, avec des gains notables sur des tâches à forte composante connaissance comme SciQ source.

Contexte et antécédents

La communauté LLM s’est largement orientée vers des modèles purement décodeurs (decoder) pour la génération, tandis que les modèles encodeurs restent centraux pour la classification, la récupération et les embeddings en production. Les encodeurs sont généralement plus rapides et consomment moins de mémoire pour les tâches discriminatives, mais les capacités génératives des encodeurs ont été historiquement moins développées que celles des décodeurs. Ettin propose une comparaison équitable entre les deux architectures en les entraînant avec les mêmes données, les mêmes recettes et les mêmes dimensions de modèle, les seules différences étant les schémas d’attention et les objectifs de formation. Le nom Ettin fait référence au géant à deux têtes de la mythologie nordique, symbolisant cette approche à architectures jumelées. Toutes les données utilisées pour Ettin sont publiques et reproductibles, renforçant l’engagement envers l’open science et la reproductibilité. Vous pouvez continuer à entraîner ces modèles avec de nouvelles données ou proposer une nouvelle recette pour aller plus loin source.

Ce qui est nouveau

Ettin propose une suite cohérente de six modèles pour chaque architecture (Encodeur et Décodeur), allant de 17M à 1B de paramètres. La même base de données, les mêmes formes de modèle et la même recette d’entraînement sont appliquées aux deux familles pour permettre des comparaisons équitables entre les motifs d’attention et les objectifs. Plus précisément :

- Deux objectifs d’entraînement sont explorés dans un cadre contrôlé : le MLM pour les encodeurs et le CLM pour les décodeurs. La même base de données et la même recette sont appliquées aux deux, permettant une analyse équitable de l’architecture vs l’objectif.

- Le régime de données est public et reproductible : les données d’entraînement sont publiques, permettant aux chercheurs de reproduire les résultats ou d’étendre l’entraînement avec de nouvelles données.

- Ettin suit une approche en trois phases, héritée du ModernBERT, avec une extension de contexte jusqu’à 8K tokens et des données filtrées de haute qualité. La phase 3 utilise 100B tokens de sources premium tout en diminuant progressivement le taux d’apprentissage source.

- Les modèles encodeurs et décodeurs affichent des performances de pointe pour les modèles ouverts sur diverses tâches et tailles. Sur plusieurs benchmarks, les encodeurs Ettin surpassent le ModernBERT, tandis que les décodeurs Ettin surpassent ou égalent des baselines établies comme Llama 3.2 et SmolLM2, avec des gains marqués sur des tâches à fort contenu de connaissance comme SciQ source.

- Les résultats mettent en évidence des avantages architecturaux fondamentaux qui persistent lorsque les données, les recettes et les échelles sont contrôlées : les encodeurs excellent en classification et récupération, tandis que les décodeurs conservent un avantage en génération, et ce à mesure que la taille augmente. Une expérience supplémentaire a consisté à poursuivre l’entraînement pendant 50B tokens avec l’objectif opposé, pour étudier les effets de l’objectif sur l’apprentissage, montrant que l’architecture elle-même compte source.

- Pour les chercheurs et les professionnels, Ettin propose des boilerplates et un chemin clair pour reproduire ou étendre le travail. Les auteurs invitent les utilisateurs à tester les modèles et à considérer des flux de travail de classification, récupération et génération en utilisant des encoders ou des décodeurs source.

Pourquoi c’est important (impact pour développeurs/entreprises)

La contribution centrale d’Ettin est de permettre des comparaisons justes entre architectures encodeur et décodeur dans des conditions identiques de données et de recettes. Cela aide les équipes à choisir l’approche adaptée à leur application, qu’il s’agisse d’un modèle discriminatif rapide pour appareil ou d’un système génératif plus puissant pour des tâches à contexte long. Le caractère ouvert des données et des recettes réduit l’obstacle à l’entrée et facilite la reproduction et l’adaptation par les équipes qui souhaitent construire sur des modèles de haut niveau avec leurs données. En pratique, cela permet d’évaluer : (1) quelle architecture convient le mieux aux tâches de classification et de récupération vs génération, (2) comment l’échelle influe sur les performances dans un régime de données commun, et (3) comment le changement d’objectif peut influencer le comportement et les biais potentiels dans des scénarios de déploiement source.

Détails techniques ou implémentation

La suite Ettin comprend six échelles de modèle pour chaque architecture (Encodeur et Décodeur), allant de 17M à 1B de paramètres. Pour chaque architecture, la même base de données, les mêmes formes et la même recette d’entraînement sont appliquées afin d’assurer des comparaisons équitables des schémas d’attention et des objectifs. La routine d’entraînement en trois phases est centrale : 1) pré-entraînement sur 1,7T de tokens avec des contextes courts (1024) pour établir les bases, 2) extension du contexte jusqu’à 8K tokens avec des données filtrées de haute qualité, 3) phase de décrochage avec 100B tokens issus de sources premium et diminution progressive du taux d’apprentissage. Un essai clé consiste à continuer l’entraînement pendant 50B tokens avec l’objectif opposé (MLM pour encodeurs, CLM pour décodeurs) afin d’étudier comment les objectifs modulent l’apprentissage sous le même cadre architecture/data. L’ouverture des données et des composants d’entraînement permet d’explorer les avantages architecturaux et les dynamiques de biais avec des entrées transparentes source.

Points clés à retenir

- Ettin établit un cadre équitable pour comparer architectures encodeur et décodeur, en utilisant les mêmes données, formes et recettes.

- Les encodeurs excellent dans les tâches de classification et récupération, même à des tailles plus modestes, tandis que les décodeurs montrent des avantages en génération, surtout à mesure que l’échelle augmente.

- La couverture à six échelles (17M–1B) pour les deux familles offre des options d’implémentation variées, des modèles rapides pour les appareils jusqu’à des systèmes plus performants.

- Toutes les données d’entraînement Ettin sont publiques et reproductibles, facilitant la reproduction et l’extension par la communauté.

- L’expérience qui inverse l’objectif après l’entraînement initial démontre que l’architecture compte au-delà de l’objectif, avec des effets mesurables sur l’apprentissage et le biais.

- Ettin propose des boilerplates pratiques et un chemin clair pour tester des modèles ouverts sur des tâches de classification, récupération et génération source.

FAQ

-

- **Q : Qu’est-ce qu’Ettin ?**

Ettin est décrit comme la première suite de modèles d’État de l’Art appariés encodeur et décodeur, entraînés sur des données identiques, avec des formes et des recettes identiques; les différences résident dans l’attention et les objectifs d’entraînement [source](https://huggingface.co/blog/ettin). - **Q : Combien de tailles et quelle plage pour Ettin ?** **A :** Six échelles pour encodeurs et décodeurs, de 17M à 1B de paramètres [source](https://huggingface.co/blog/ettin). - **Q : Quel régime de données est utilisé ?** **A :** Une approche en trois phases avec 1,7T tokens de pré-entraînement, 250B tokens pour l’extension de contexte à 8K et 100B tokens de sources premium pour la phase de décrochage; les données sont publiques et reproductibles [source](https://huggingface.co/blog/ettin). - **Q : Comment les résultats se comparent-ils aux baselines ?** **A :** Les encodeurs Ettin surpassent le ModernBERT et les décodeurs Ettin égalent ou surpassent Llama 3.2 et SmolLM2, avec des gains marqués sur SciQ et d’autres tâches axées sur le savoir [source](https://huggingface.co/blog/ettin). - **Q : Puis-je reproduire ou tester ces modèles moi-même ?** **A :** Oui. Des boilerplates sont fournis et toutes les données sont publiques, facilitant la reproduction ou l’extension [source](https://huggingface.co/blog/ettin).

Références

More news

Scaleway rejoint les Fournisseurs d’Inference de Hugging Face pour une Inférence Serverless et Faible Latence

Scaleway est désormais un Fournisseur d’Inference pris en charge sur Hugging Face Hub, permettant l’inférence serverless directement sur les pages de modèles avec les SDK JS et Python. Accédez à des modèles open-weight populaires et bénéficiez d’une latence réduite.

Réduire la latence de démarrage à froid pour l’inférence LLM avec NVIDIA Run:ai Model Streamer

Analyse approfondie sur la façon dont NVIDIA Run:ai Model Streamer abaisse les temps de démarrage à froid pour l’inférence des LLM en diffusant les poids vers la mémoire GPU, avec des benchmarks sur GP3, IO2 et S3.

Comment msg a renforcé la transformation RH avec Amazon Bedrock et msg.ProfileMap

Cet article explique comment msg a automatisé l'harmonisation des données pour msg.ProfileMap en utilisant Amazon Bedrock pour alimenter des flux d'enrichissement pilotés par LLM, améliorant la précision de l'appariement des concepts RH, réduisant la charge manuelle et assurant la conformité avec l'

Comment la Quantization Aware Training permet de récupérer la précision en inferance à faible précision

Explore QAT et QAD comme méthodes de récupération de précision dans des modèles à faible précision, en s'appuyant sur TensorRT Model Optimizer et les formats FP8/NVFP4/MXFP4.

Accélérer l’Inference de la Structure des Protéines de Plus de 100x avec le NVIDIA RTX PRO 6000 Blackwell Server Edition

Le RTX PRO 6000 Blackwell Server Edition de NVIDIA accélère considérablement l’inférence de structure des protéines, permettant des flux de travail GPU complets avec OpenFold et TensorRT, jusqu’à 138x plus rapide que AlphaFold2.

Rendez vos ZeroGPU Spaces plus rapides avec la compilation AoT de PyTorch

Découvrez comment la compilation AoT de PyTorch améliore les performances des ZeroGPU Spaces, permettant la réutilisation instantanée des modèles compilés, la quantification FP8 et les formes dynamiques pour des démos plus réactives sur les GPUs H200.