NVIDIA affirme que l’IA peut aider à résoudre les problèmes du réseau électrique causés par l’IA

Sources: https://techcrunch.com/2025/03/20/nvidia-thinks-ai-can-solve-electrical-grid-problems-caused-by-ai, techcrunch.com

TL;DR

- Nvidia s’associe à l’EPRI pour utiliser l’IA afin de résoudre les problèmes du réseau électrique.

- Open Power AI Consortium déploiera des modèles d’IA spécifiques au domaine qui seront open source pour les chercheurs.

- La demande d’électricité est en partie tirée par la croissance des centres de données et des charges IA, avec une prévision de croissance d’environ 4% par an, selon l’IEA.

- Les membres couvrent des utilités et des entreprises technologiques, dont Nvidia, l’EPRI, PG&E, Con Edison, Constellation Energy, Duke Energy, TVA et ENOWA; Microsoft et Oracle sont mentionnés comme membres technologiques.

Contexte et arrière-plan

Le secteur de l’énergie et l’industrie technologique deviennent de plus en plus interdépendants alors que les charges IA exigent davantage d’électricité. Nvidia a annoncé qu’elle s’associe à l’EPRI, organisation de recherche et développement dans l’industrie de l’énergie, pour appliquer l’IA à des problématiques du réseau électrique. L’initiative tourne autour du Open Power AI Consortium, réunissant des services publics et des entreprises technologiques. Le groupe prévoit d’utiliser des modèles d’IA spécifiques au domaine—des approches spécialisées pour le secteur de l’énergie—et de les rendre open source afin que les chercheurs du milieu universitaire et industriel puissent les utiliser et les adapter. Le contexte plus large présente un réseau sous tension croissante: la demande d’électricité devrait croître d’environ 4% par an dans les années à venir, selon l’International Energy Agency (IEA), soit près du double du niveau observé en 2023. Le consortium se positionne comme un effort collaboratif pour anticiper et atténuer les défis du réseau avant qu’ils ne deviennent problématiques. Outre Nvidia et l’EPRI, le groupe comprend plusieurs services publics et énergétiques majeurs, ainsi que des acteurs technologiques de premier plan qui voient dans la capacité de production d’énergie un avantage concurrentiel. L’objectif est de développer des outils d’IA exploitables et à grande échelle qui peuvent être intégrés aux opérations et à la gestion des actifs du réseau. Dans le contexte industriel, on note que les entreprises technologiques cherchent continuellement à sécuriser des capacités de génération, car l’énergie devient un facteur décisif pour les initiatives d’IA et de cloud. Bien que les projets d’énergies renouvelables restent centraux, l’accent ici est mis sur la dynamique du réseau à l’ère de l’IA et sur la manière dont des modèles d’IA open source adaptés au domaine peuvent aider à coordonner la production et la distribution, et à améliorer la résilience. Une donnée connexe citée dans les analyses de l’industrie suggère que la réduction de la consommation pendant les pics de demande et le décalage des tâches non critiques vers les heures creuses pourraient déverrouiller une capacité supplémentaire du réseau. Une étude estime que telles actions de demande pourraient révéler environ 76 GB de capacité aux États-Unis, soit environ 10% de la demande de pic. Cette donnée illustre le type de stratégies qui pourraient accompagner le développement de modèles d’IA dirigés par le domaine.

Pourquoi cela compte (impact pour les développeurs et les entreprises)

Pour les développeurs et les entreprises, cette initiative met en évidence une opportunité croissante de construire des outils d’IA opérant dans des contextes d’infrastructures critiques. Des modèles d’IA spécifiques au domaine du réseau électrique, axés sur la prévision de la demande, la planification de la génération et l’évaluation de la stabilité en temps réel, pourraient réduire la pression sur le réseau tout en améliorant la fiabilité. Le fait que ces modèles soient open source facilite l’expérimentation et accélère la collaboration entre les services publics, les chercheurs et les fournisseurs de technologies. D’un point de vue commercial, cette démarche reflète une tendance continue: l’échelle de l’IA et la croissance des données alimentent la demande d’énergie fiable, ce qui façonne la planification de la capacité et l’approvisionnement en énergie des fournisseurs technologiques. La présence de services publics aux côtés des géants technologiques indique un intérêt commun pour des solutions d’IA exploitables et interopérables avec les systèmes opérationnels et de gestion des actifs du réseau.

Détails techniques ou Mise en œuvre

Le Open Power AI Consortium poursuivra des modèles d’IA spécifiques au domaine du réseau électrique. Ces modèles seront open source, permettant aux chercheurs académiques et industriels de les étudier, de les adapter et de les déployer dans des contextes locaux et réglementaires variés. Les architectures exactes, ensembles de données et critères d’évaluation n’ont pas été divulgués dans le contenu source, mais l’objectif est clair: une IA guidée par le domaine qui reflète les particularités de la génération, de la transmission et de la distribution. Les participants clés incluent Nvidia et EPRI comme moteurs de la collaboration, avec des services publics supplémentaires — PG&E, Con Edison, Constellation Energy, Duke Energy, Tennessee Valley Authority et ENOWA — aux côtés de Microsoft et Oracle en tant que partenaires technologiques. Cette combinaison suggère une approche multi-partie prenante visant à favoriser l’interopérabilité et le transfert rapide des connaissances entre les secteurs. L’effort est présenté non seulement comme de la recherche mais comme une voie vers des solutions d’IA déployables dans les opérations réelles du réseau. Parmi les signaux industriels, la pression croissante des charges de données et d’IA sur le réseau et le déploiement continu d’énergies renouvelables, y compris le solaire, soulignent la nécessité d’une coordination intelligente pour optimiser fiabilité et réduction des pertes.

Tableau: Participants et rôles

| Participant | Rôle

| --- |

|---|

| Nvidia |

| EPRI |

| PG&E |

| Con Edison |

| Constellation Energy |

| Duke Energy |

| Tennessee Valley Authority |

| ENOWA |

| Microsoft |

| Oracle |

Points clés

- Le consortium utilisera des modèles d’IA spécifiques au domaine pour résoudre les problèmes du réseau.

- Les modèles seront open source, favorisant la recherche et la collaboration étendue.

- L’initiative illustre une intégration croisée des secteurs pour améliorer fiabilité et efficacité du réseau face à une demande croissante.

- Le contexte du marché indique une augmentation de la demande d’énergie des data centers et des charges IA, associée à des projets renouvelables.

- Les résultats potentiels orienteront les stratégies d’IA pour optimiser la demande, la génération et les opérations du réseau.

FAQ

-

- **Q : Qu’est-ce que le Open Power AI Consortium ?**

C’est une collaboration entre Nvidia, EPRI, des services publics et des acteurs technologiques comme Microsoft et Oracle pour développer des modèles d’IA spécifiques au domaine pour le réseau électrique, avec un accès open source pour les chercheurs. - **Q : Quels organismes participent ?** **A :** Nvidia, EPRI, PG&E, Con Edison, Constellation Energy, Duke Energy, Tennessee Valley Authority, ENOWA, Microsoft et Oracle. - **Q : Pourquoi l’IA pour le réseau électrique ?** **A :** La demande d’électricité croît avec les charges d’IA et des data centers; l’IA spécifique au domaine peut améliorer la fiabilité, l’efficacité et la résilience du réseau. - **Q : Y a-t-il des considérations énergétiques associées ?** **A :** Oui, l’IEA prévoit une croissance d’environ 4% par an et des discussions sur des stratégies de réduction de la demande pour débloquer une capacité supplémentaire.

Références

More news

Scaleway rejoint les Fournisseurs d’Inference de Hugging Face pour une Inférence Serverless et Faible Latence

Scaleway est désormais un Fournisseur d’Inference pris en charge sur Hugging Face Hub, permettant l’inférence serverless directement sur les pages de modèles avec les SDK JS et Python. Accédez à des modèles open-weight populaires et bénéficiez d’une latence réduite.

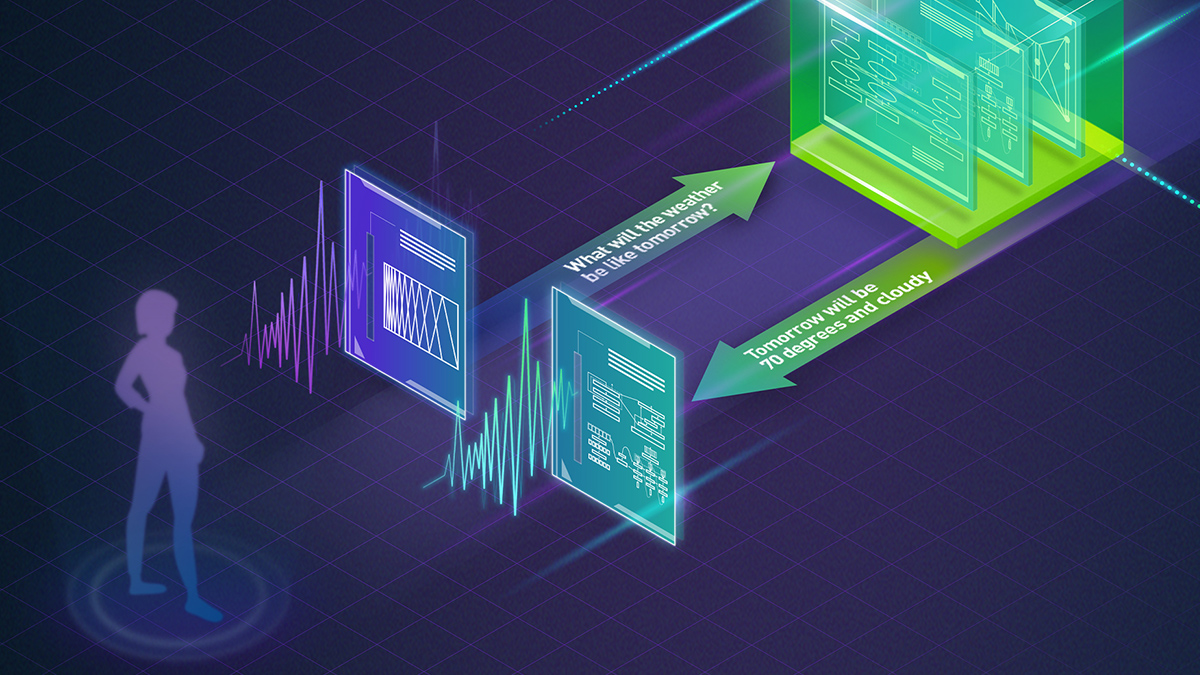

Prévoir les phénomènes météorologiques extrêmes en quelques minutes sans superordinateur : Huge Ensembles (HENS)

NVIDIA et le Lawrence Berkeley National Laboratory présentent Huge Ensembles (HENS), un outil IA open source qui prévoit des événements météorologiques rares et à fort impact sur 27 000 années de données, avec des options open source ou prêtes à l’emploi.

Créer des flux de travail agentiques avec GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore

Vue d’ensemble complète sur le déploiement des modèles GPT OSS d’OpenAI sur SageMaker AI et Bedrock AgentCore pour alimenter un analyseur d’actions multi-agents avec LangGraph, incluant la quantification MXFP4 en 4 bits et une orchestration sans serveur.

Autodesk Research mène la CFD à vitesse Warp sur le NVIDIA GH200

Autodesk Research, Warp de NVIDIA et le GH200 démontrent une CFD Python-native avec XLB, atteignant environ 8x de vitesse et évoluant jusqu’à 50 milliards de cellules.

Réduire la latence de démarrage à froid pour l’inférence LLM avec NVIDIA Run:ai Model Streamer

Analyse approfondie sur la façon dont NVIDIA Run:ai Model Streamer abaisse les temps de démarrage à froid pour l’inférence des LLM en diffusant les poids vers la mémoire GPU, avec des benchmarks sur GP3, IO2 et S3.

Qwen3-Next Modèles MoE Hybrides Open Source : Précision Améliorée et Inférence Plus Rapide sur la Plateforme NVIDIA

Les prévisualisations open source Qwen3-Next 80B-A3B-Thinking et 80B-A3B-Instruct présentent une architecture MoE hybride pour un contexte long et une inférence efficace, avec déploiement et outils ouverts soutenus par NVIDIA.