Visual Haystacks: Benchmark de raisonnement sur plusieurs images

Sources: http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks, bair.berkeley.edu

TL;DR

- Visual Haystacks (VHs) introduit un benchmark visuel centré sur Needle-In-A-Haystack pour tester le raisonnement en long contexte sur de grands ensembles d’images non corrélées.

- Le benchmark présente deux tâches: Single-Needle (unique aiguille) et Multi-Needle (deux à cinq aiguilles), avec des ensembles basés sur COCO et environ 1K paires QA binaires couvrant de 1 à 10K images par ensemble.

- Les modèles open-source peinent à mesure que le haystack grandit; les modèles propriétaires font face à des limites de payload et de longueur de contexte, révélant des lacunes dans le raisonnement multi-image actuel.

- MIRAGE, une approche d’entraînement en une seule étape, étend LLaVA aux tâches MIQA et obtient une recall/precision solides sur les tâches multi-imagerie et des résultats de pointe sur de nombreuses tâches à aiguille unique.

- La qualité de récupération et l’intégration des images sont cruciales; les retrievers basés sur CLIP sous-performent pour les tâches basées sur des questions par rapport au retriever MIRAGE. Pour plus de détails, consultez l’article original présentant Visual Haystacks: Visual Haystacks benchmark.

Contexte et antécédents

Les humains excellent dans le traitement de grands ensembles d’informations visuelles, une compétence clé pour atteindre une intelligence générale artificielle (AGI). Pendant des décennies, les chercheurs en IA ont développé des systèmes de Visual Question Answering (VQA) pour interpréter des scènes dans des images uniques et répondre à des questions associées. Bien que les avancées récentes des modèles de fond aient réduit l’écart entre le traitement visuel humain et machine, le VQA conventionnel se limite à raisonner sur une seule image à la fois et non sur des collections d’images. Cette limitation présente des défis dans des scénarios plus complexes: détection de motifs dans des collections d’images médicales, surveillance forestière via des images satellites, cartographie des changements urbains à partir de données de navigation autonome, analyse d’éléments thématiques dans de grandes collections d’art, ou compréhension du comportement des consommateurs à partir de vidéos de vente au détail. Chacun de ces scénarios nécessite le traitement visuel sur des centaines ou des milliers d’images ainsi qu’un raisonnement croisé entre ces images. Pour combler ce vide, ce travail se concentre sur la tâche Multi-Image Question Answering (MIQA), qui dépasse les capacités des systèmes VQA traditionnels. Visual Haystacks est présenté comme le premier benchmark NIAH centré sur la vision, conçu pour évaluer les grands modèles multimodaux (LMMs) dans le traitement d’informations visuelles à long contexte. Le paradigme NIAH place l’« aiguille » essentielle dans un « foin » volumineux, et sert à tester le traitement du long contexte, y compris des entrées comme des documents longs, des vidéos ou des centaines d’images. Visual Haystacks étend cette idée à la récupération et au raisonnement visuel sur de grands ensembles d’images non corrélées, introduisant environ 1K paires QA binaires où chaque ensemble peut contenir de 1 à 10K images. L’objectif est que le modèle localise les images pertinentes avant de répondre, plutôt que de se fier au raisonnement basé sur des suppositions.

Quoi de neuf

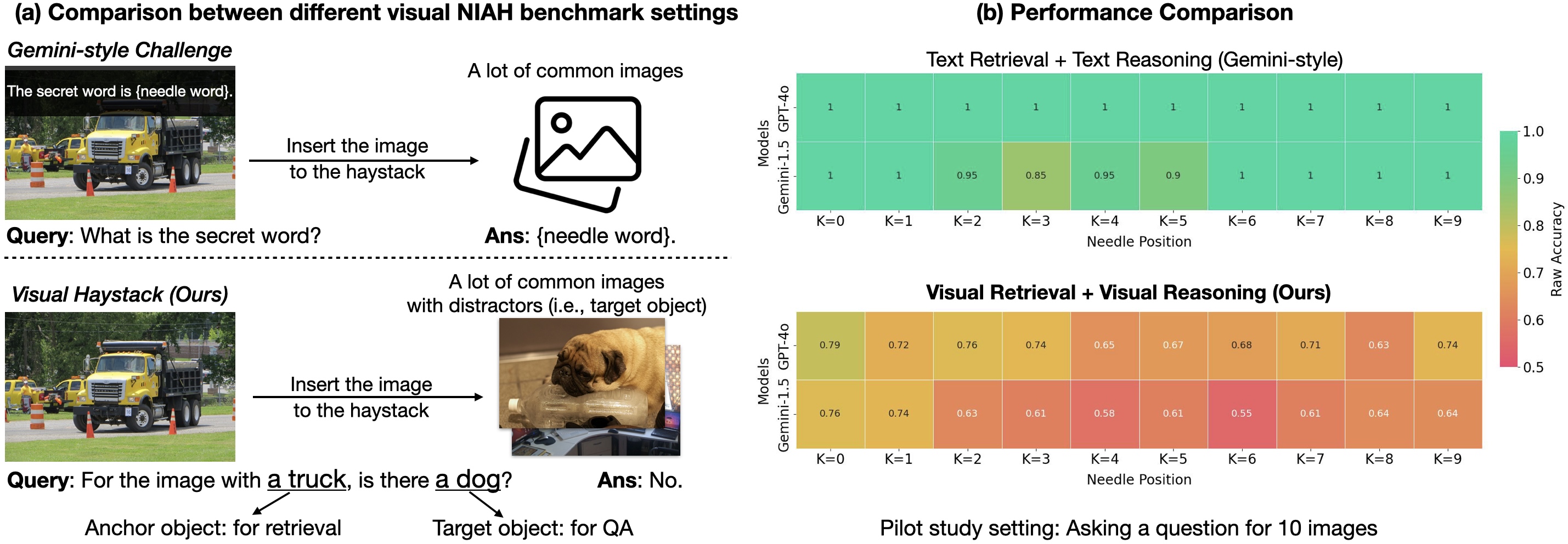

Le Visual Haystacks propose deux défis principaux:

- Défi Single-Needle: il n’y a qu’une seule aiguille dans le foin. La question est formulée comme: « Pour l’image ayant l’objet d’ancrage, y a-t-il un objet cible ? »

- Défi Multi-Needle: il y a deux à cinq aiguilles dans le foin. Les questions peuvent être: « Pour toutes les images avec l’objet d’ancrage, toutes contiennent-elles l’objet cible ? » ou « Pour toutes les images avec l’objet d’ancrage, en contiennent-elles au moins une ? » Ces tâches testent à la fois la capacité du modèle à récupérer des images pertinentes dans un grand groupe et sa capacité à raisonner entre les images pour donner une réponse précise. Le jeu de données utilise des images et annotations du jeu COCO, afin d’ancrer l’évaluation dans un domaine visuel largement utilisé. Une évaluation exhaustive sur les deux configurations (Single- et Multi-Needle) a examiné plusieurs modèles open-source et propriétaires, notamment LLaVA-v1.5, GPT-4o, Claude-3 Opus et Gemini-v1.5-pro. Une ligne de référence « captioning » a également été incluse, où les images sont d’abord légendées par LLaVA, puis les légendes sont utilisées par Llama3 pour répondre à la question. Parmi les constats, on observe:

- Difficultés avec les distracteurs visuels: dans les tâches à aiguille unique, les performances chutent à mesure que le nombre d’images augmente, même si l’exactitude oraculaire reste élevée. Cela montre que les modèles actuels ont des difficultés marquées de récupération visuelle en présence de distracteurs.

- Contraintes de contexte: les modèles open-source comme LLaVA sont limités à trois images en raison d’une longueur de contexte de 2K, limitant le raisonnement multi-image. Des modèles propriétaires (Gemini-v1.5, GPT-4o) font face à des limites de payload lorsque le nombre d’images dépasse environ 1K.

- Dégradation des performances avec des haystacks plus importants: les performances se dégradent globalement à mesure que le nombre d’images augmente, notamment dans les scénarios multi-Needle, où les résultats restent faibles.

- Le raisonnement entre plusieurs images reste problématique: les approches basées sur les LMM affichent de faibles performances sur les tâches multi-imagerie par rapport à une approche simple qui enchaîne une étape de captioning avec un agrégateur LLM, ce qui suggère que les LMMs actuels ne savent pas bien intégrer les informations à travers de multiples images. Pour répondre à ces lacunes, les auteurs proposent MIRAGE—Multi-Image Retrieval Augmented Generation—un paradigme open et simple d’entraînement en une seule étape qui étend LLaVA pour les tâches MIQA. L’architecture MIRAGE comprend:

- Compression des encodages existants: MIRAGE utilise un modèle de compression sensible à la requête pour réduire les tokens d’encodage visuel d’environ 10 fois, permettant d’intégrer plus d’images dans le même contexte.

- Retriver pour filtrer les images non pertinentes: MIRAGE emploie un retriever entraîné en parallèle du fine-tuning de l’LLM pour prédire si une image sera pertinente et supprimer dynamiquement les images non pertinentes.

- Données d’entraînement multi-imagerie: MIRAGE enrichit les données d’instruction à une image unique avec des données de raisonnement multi-image et des données synthétiques de raisonnement multi-image. En revisitant le VHs avec MIRAGE, on observe que MIRAGE peut gérer 1K ou 10K images et atteint des performances d’état de l’art pour la plupart des tâches à aiguille unique, malgré un backbone QA par image unique plus faible (32 tokens par image). MIRAGE est également évalué sur des tâches VQA variées et montre une mémoire et une précision solides pour les tâches multi-image, surpassant des concurrents robustes comme GPT-4, Gemini-v1.5 et le Large World Model (LWM). De plus, MIRAGE montre des performances compétitives en QA d’image unique. Enfin, le retriever de MIRAGE, entraîné conjointement avec l’LLM, dépasse CLIP dans ce cadre, démontrant que CLIP peut ne pas convenir lorsque les textes posent des questions.

Pourquoi cela compte (impact pour les développeurs/entreprises)

Le benchmark Visual Haystacks est pertinent car il met l’accent sur des besoins réels où les systèmes d’IA doivent raisonner sur de larges collections de données visuelles plutôt que sur une seule image. Cela s’applique à:

- l’analyse d’imagerie médicale, où les motifs peuvent s’étendre sur plusieurs images;

- la surveillance environnementale via des images satellites;

- la cartographie des évolutions urbaines à partir de données de navigation;

- la gestion de grandes collections d’art et d’œuvres au regard de motifs et tendances;

- l’analyse du comportement des consommateurs via des images de surveillance de vente au détail. Pour les développeurs et les entreprises, MIRAGE propose une voie pratique vers des solutions d’IA capables de traiter de grands ensembles d’images sans nécessiter des ressources monumentales. En combinant une représentation visuelle compressée et un retriever aligné sur la tâche avec un modèle de raisonnement, MIRAGE offre une solution open et scalable pour des scénarios de MIQA.

Détails techniques ou Mise en œuvre

Le travail Visual Haystacks donne à la fois une évaluation et une proposition architecturale concrète (MIRAGE) pour répondre aux limitations observées. Points techniques saillants:

- Caractéristiques du jeu de données: environ 1K paires binaires QA par haystack, avec chaque ensemble de 1 à 10K images. Les questions portent sur la présence d’un objet cible dans les images pertinentes, donné l’objet d’ancrage.

- Évaluation en deux modes: Single-Needle et Multi-Needle. L’évaluation mesure non seulement la précision des réponses mais aussi la capacité du modèle à récupérer les images pertinentes avant de répondre.

- Limites de contexte: les LMM open-source comme LLaVA-v1.5 sont limités à trois images en raison d’une longueur de contexte de 2K. Les modèles propriétaires, tels que Gemini-v1.5 et GPT-4o, font face à des limites de payload lorsque le nombre d’images dépasse environ 1K.

- Architecture MIRAGE: extension LLaVA pour les tâches MIQA comprenant trois composants:

- Compression des encodages: réduction des tokens visuels pour permettre plus d’images dans le même contexte.

- Retriver sensible à la requête: retriever entraîné conjointement avec l’LLM pour prédire la pertinence des images et filtrer les images non pertinentes.

- Données d’entraînement multi-image: augmentation des données d’entraînement avec des données multi-image et des données synthétiques pour améliorer la robustesse.

- Résultats: MIRAGE atteint des performances de pointe pour la plupart des tâches à aiguille unique, malgré un backbone QA par image unique plus faible. Sur les tâches multi-image, MIRAGE montre de fortes capacités de recall et de précision, dépassant des concurrents tels que GPT-4, Gemini-v1.5 et LWM, tout en restant compétitif sur les Q/A à image unique. Le retriever MIRAGE co-entrainé sur l’LLM dépasse CLIP dans ce contexte, soulignant l’importance d’une récupération alignée sur la tâche plutôt que l’utilisation exclusive de méthodes génériques.

Points clés (takeaways)

- Le raisonnement visuel en long contexte reste difficile pour les LMMs actuels lorsqu’ils sont confrontés à de grands ensembles d’images non corrélées, notamment en présence de distracteurs visuels.

- Les limites de contexte et les limites de payload entravent la montée en charge du QA d’image unique vers des tâches multi-imagerie.

- Une approche de récupération augmentée par génération, alignée sur la tâche et intégrée au raisonnement, offre une voie prometteuse pour des performances robustes en MIQA sur des ensembles 1K–10K images.

- Des pipelines basés sur les légendes peuvent être compétitifs dans certains scénarios multi-imagerie, ce qui souligne la valeur d’intégrer vision, langage et récupération avec soin.

- Pour les applications pratiques, les retrievers adaptés à la tâche et les représentations visuelles compressées permettent un raisonnement de long contexte scalable sans nécessiter des ressources excessives.

FAQ

-

- **Q : Qu’est-ce que Visual Haystacks et pourquoi est-ce important ?**

Visual Haystacks est un benchmark NIAH centré sur la vision destiné à évaluer les LMMs sur le raisonnement de long contexte à travers de grands ensembles d’images non corrélées, en testant à la fois la récupération d’images et le raisonnement inter-imagerie. Voir l’article d’introduction: [Visual Haystacks benchmark](http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks). - **Q : Quelles sont les deux tâches MIQA introduites par VHs ?** **A :** Single-Needle (aiguilles uniques) et Multi-Needle (2–5 aiguilles), avec des questions sur la présence d’un objet cible dans les images pertinentes. - **Q : Qu’est-ce que MIRAGE et pourquoi est-il significatif ?** **A :** MIRAGE est une approche open et simple d’entraînement en un seul étage qui étend LLaVA aux tâches MIQA via compression des encodages, retriever sensible à la requête et données d’entraînement multi-imagerie, permettant de gérer 1K–10K images et montrant des performances robustes en multi-imagerie. - **Q : Comment les LMMs actuels performent-ils sur VHs et quels sont les principaux goulots d’étranglement ?** **A :** Les modèles luttent contre les distrators visuels et l’intégration d’informations à travers plusieurs images. Les limites de contexte pour les options open-source (2K) et les limites de payload pour les options propriétaires freinent l’escalade vers plus de 1K images, avec des performances qui se dégradent sur des haystacks plus grands, surtout dans les scénarios multi-needle.

Références

- Visual Haystacks: Are We Ready for Multi-Image Reasoning? Launching VHs: The Visual Haystacks Benchmark. http://bair.berkeley.edu/blog/2024/07/20/visual-haystacks

More news

Réduire la latence de démarrage à froid pour l’inférence LLM avec NVIDIA Run:ai Model Streamer

Analyse approfondie sur la façon dont NVIDIA Run:ai Model Streamer abaisse les temps de démarrage à froid pour l’inférence des LLM en diffusant les poids vers la mémoire GPU, avec des benchmarks sur GP3, IO2 et S3.

Comment msg a renforcé la transformation RH avec Amazon Bedrock et msg.ProfileMap

Cet article explique comment msg a automatisé l'harmonisation des données pour msg.ProfileMap en utilisant Amazon Bedrock pour alimenter des flux d'enrichissement pilotés par LLM, améliorant la précision de l'appariement des concepts RH, réduisant la charge manuelle et assurant la conformité avec l'

Comment la Quantization Aware Training permet de récupérer la précision en inferance à faible précision

Explore QAT et QAD comme méthodes de récupération de précision dans des modèles à faible précision, en s'appuyant sur TensorRT Model Optimizer et les formats FP8/NVFP4/MXFP4.

Accélérer l’Inference de la Structure des Protéines de Plus de 100x avec le NVIDIA RTX PRO 6000 Blackwell Server Edition

Le RTX PRO 6000 Blackwell Server Edition de NVIDIA accélère considérablement l’inférence de structure des protéines, permettant des flux de travail GPU complets avec OpenFold et TensorRT, jusqu’à 138x plus rapide que AlphaFold2.

Les checklists surpassent les modèles de récompense pour l’alignement des modèles de langage

Une approche RL utilisant des checklists dérivées des instructions guide l’alignement et surpasse les modèles de récompense fixes sur plusieurs benchmarks du Qwen2.5-7B-Instruct, présentée à l’ICLR 2025.

SlowFast-LLaVA-1.5 : LLMs vidéo économes en jetons pour la compréhension du long terme

La recherche ML d’Apple présente SlowFast-LLaVA-1.5 (SF-LLaVA-1.5), une famille de LLMs vidéo à faible coût en jetons pour la compréhension de vidéos longues, utilisant le mécanisme SlowFast à deux flux et des données publiques pour atteindre des performances de pointe entre 1B et 7B.