Bref aperçu des biais de genre dans l’IA : résultats clés et implications

Sources: https://thegradient.pub/gender-bias-in-ai, thegradient.pub

TL;DR

- Les modèles d’IA reflètent et amplifient souvent les biais de genre présents dans les données d’entraînement The Gradient.

- Il existe des méthodes de dé-biaisage pour les embeddings de mots, mais elles ne s’appliquent pas nécessairement directement aux systèmes basés sur des transformers; les stratégies d’atténuation plus globales sont encore en cours d’élaboration.

- Le biais apparaît dans divers domaines : résolution de coréférence, tâches de langage et génération d’images; de nombreuses conclusions mettent en évidence des préoccupations intersectionnelles (par ex. genre et couleur de peau).

- Des benchmarks (p. ex. BBQ, Gender Shades) quantifient les biais mais peuvent conduire à optimiser les modèles pour ces benchmarks plutôt que pour une justice large.

- Les travaux en cours préconisent une évaluation plus large, des jeux de données diversifiés et des outils d’audit accessibles pour identifier et combler les lacunes.

Contexte et contexte historique

Les systèmes d’IA entraînés sur des données humaines reflètent les biais humains et peuvent les amplifier dans les tâches qui suivent. Cet article propose un panorama des travaux influents qui mesurent, analysent et tentent de mitiger le biais de genre dans l’IA. Les termes IA, genre et biais sont utilisés de manière générale, le genre étant fréquemment traité comme binaire dans de nombreuses enquêtes pour des raisons de faisabilité de la mesure. L’article met en lumière un échantillon illustratif et non exhaustif de travaux montrant comment le biais apparaît dans des composants différents—des embeddings de mots aux grands modèles de langage (LLM)—et pourquoi il est crucial d’y répondre dans des contextes réels. Le tout souligne l’importance croisée de l’intersectionnalité. Consultez l’exposé original pour plus de contexte et de références : https://thegradient.pub/gender-bias-in-ai [The Gradient]. Les embeddings de mots révèlent des associations de genre dans des vecteurs numériques appris à partir de grands corpus textuels. Par exemple, un cadre classique montre comment des relations entre mots peuvent encoder du sexisme, tel que l’analogie homme:roi :: femme:? où le « ? » pointe vers « reine ». Des travaux de dé-biaisage proposent une méthode utilisant une liste de mots neutres en termes de genre pour réduire les analogies stéréotypées tout en préservant les relations sémantiques légitimes. Cependant, cette approche cible les embeddings de mots et ne se transpose pas automatiquement aux systèmes transformateurs modernes qui alimentent l’IA actuelle. Cela implique que des représentations biaisées dans les composants fondamentaux peuvent se répercuter sur les tâches en aval comme l’analyse de sentiment ou le classement de documents. [The Gradient] Un autre axe de recherche examine les biais intersectionnels dans la reconnaissance faciale, montrant que ces systèmes peuvent avoir des performances différentes selon le genre et la couleur de la peau. Un ensemble de données équitablement réparti entre quatre sous-groupes contenait des évaluations plus faibles pour les visages à peau plus sombre, en particulier pour les femmes. En réponse, Microsoft et IBM ont actualisé les jeux de données et les modèles d’entraînement pour inclure une représentation plus diversifiée des tons de peau, des genres et des âges, et ont publié des billets de blog pour discuter ouvertement de ces questions. L’objectif est de veiller à ce que les systèmes technologiques servent toutes les personnes, et pas seulement certaines démarcations démographiques. [The Gradient] Dans le traitement du langage naturel, les systèmes de résolution de coréférence démontrent aussi des biais de genre. Certaines preuves montrent que certains modèles résolvent les pronoms masculins en les associant à des occupations plus souvent qu’aux pronoms féminins ou neutres. Des exemples et jeux de données illustrent que des occupations telles que « manager » apparaissent comme masculines dans de nombreuses situations, alors que les statistiques réelles montrent une représentation significative de femmes. [The Gradient] Les grands modèles de langage (LLMs) présentent des biais préjudiciables dans des contextes ambigus, ce qui est démontré par des jeux de données dédiés à révéler des préjugés sociaux. Un ensemble de données sur les biais dans les questions et réponses (BBQ) a révélé que les modèles renforçaient des stéréotypes dans la plupart des prompts testés. Le travail souligne aussi l’importance d’évaluer dans des contextes culturels et linguistiques variés, et pas seulement en anglais. [The Gradient] Enfin, les modèles de génération d’images (tels que DALL·E 2, Stable Diffusion et Midjourney) véhiculent des biais sociaux, et sous-représentent fréquemment des identités marginalisées lorsque les prompts concernent des postes de pouvoir. Pour illustrer, DALL·E 2 a généré des hommes blancs dans 97% des cas pour des prompts comme « CEO ». Les chercheurs ont développé des outils d’audit des modèles via des jeux de prompts ciblés sur des occupations et des identités de genre et d’origine ethnique; ces outils sont accessibles sur HuggingFace. L’objectif est d’établir des méthodes d’audit robustes alors que ces outils gagnent en sophistication et en commercialisation. [The Gradient] Ces articles illustrent une vague de recherche plus large sur la mesure des biais de genre et leurs dommages sociétaux dans l’IA. Les études utilisent de nombreux benchmarks et ensembles de données pour quantifier le biais, ce qui est crucial pour la responsabilité, mais il existe un risque que les modèles soient optimisés pour ces benchmarks plutôt que pour des scénarios réels variés. On cherche aussi à évaluer les biais au-delà du genre binaire et dans d’autres identités et contextes. [The Gradient]

Ce qui est nouveau

- Embeddings et dé-biaisage: des travaux montrent que des analyses arithmétiques simples sur les vecteurs de mots révèlent des associations de genre. Une méthode proposée utilise une liste de mots neutres en termes de genre pour réduire les biais stéréotypés; toutefois, cela ne résout pas totalement les biais dans les modèles transformateurs modernes. [The Gradient]

- Biais intersectionnel dans la reconnaissance faciale: un ensemble de données équivalent entre quatre groupes montre une plus grande erreur pour les femmes à peau plus sombre; les mitigations impliquent l’élargissement des données d’entraînement pour inclure une plus grande diversité de tons de peau, de genres et d’âges. [The Gradient]

- Biais dans la résolution de coréférence: des études montrent que les modèles associant les pronoms masculins à des occupations reflètent des stéréotypes. [The Gradient]

- Biais dans les benchmarks de QA pour les LLMs: BBQ montre que les LLMs peuvent renforcer des préjugés dans des réponses à des questions ambigües; l’importance des contextes culturels est soulignée. [The Gradient]

- Biais dans la génération d’images et outils d’audit: les modèles générateurs affichent des biais dans les prompts relatifs à l’occupation et au genre; des outils d’audit ouverts facilitent la compréhension et la réduction des biais. [The Gradient] Pourquoi cela compte: ces résultats démontrent que le biais n’est pas limité à un seul type de modèle ou à une tâche, mais peut influencer les données, les représentations et les sorties des systèmes d’IA. La recherche appelle à une évaluation plus large, à des jeux de données diversifiés et à des outils d’audit accessibles pour améliorer la responsabilité. [The Gradient]

Pourquoi cela importe (impact pour les développeurs et les entreprises)

- Risque de justice et de conformité: les systèmes déployés dans le recrutement, la modération de contenu, le crédit, le droit, etc., peuvent perpétuer des stéréotypes ou des traitements inéquitables s’ils s’appuient sur des données biaisées. Les entreprises doivent envisager des évaluations de biais trans-domaines, des données représentatives et une gouvernance de l’IA tout au long du cycle de vie.

- Stratégie et gouvernance des données: les travaux montrent que les améliorations passent souvent par une révision des jeux de données pour mieux couvrir les diverses démographies (genre, tonalité de peau, âge). Cela souligne l’importance d’une collecte de données inclusive, d’une documentation transparente et d’une gouvernance de l’IA efficace.

- Outils de transparence et de responsabilité: les benchmarks et les outils d’audit publics facilitent l’évaluation et la reddition de comptes, encourageant des pratiques d’évaluation reproductibles et ouvertes. [The Gradient]

- Portée plus large de l’évaluation: il est nécessaire d’évaluer les biais sur plusieurs axes et dans différents contextes culturels et linguistiques pour révéler les risques. Adoptez des plans d’évaluation multidimensionnels et tenez compte des contextes culturels et linguistiques lors de la mesure du biais. [The Gradient]

Détails techniques ou Mise en œuvre

- Dé-biaisage des embeddings de mots: une approche utilise une liste de mots neutres en termes de genre (par ex. female, male, woman, man, girl, boy, sister, brother) pour réduire les associations stéréotypées; les résultats montrent une réduction des biais dans les embeddings, mais les biais persistent dans les systèmes transformer plus avancés. [The Gradient]

- Limites des benchmarks: les benchmarks permettent une évaluation automatisée du biais, mais il existe un risque que les modèles soient optimisés pour ces ensembles plutôt que pour des scénarios réels variés. Des évaluations multilingues et interculturelles sont cruciales pour capturer des biais plus larges. [The Gradient]

- Outils d’audit et ressources publiques: des outils permettent d’auditer les modèles de génération d’images via des prompts ciblant occupations, genre et ethnie; ces ressources sont publiquement accessibles (ex. espace HuggingFace) pour soutenir les efforts d’audit et de réduction des biais. [The Gradient]

- Mitigations industrielles: face aux biais identifiés, de grandes entreprises ont révisé leurs données d’entraînement et leurs programmes de diversité pour améliorer la représentation du genre et de la couleur de peau dans leurs systèmes. [The Gradient]

Points clés

- Le biais en IA est multi-facette: representations, perception, langage et sorties génératives, touchant divers domaines.

- Le dé-biaisage des embeddings de mots est possible, mais ne résout pas tout pour les systèmes transformer contemporains; des stratégies plus larges sont nécessaires.

- Les benchmarks aident à mesurer le biais mais doivent être complétés par des jeux de données diversifiés et une évaluation continue.

- Les réponses industrielles démontrent qu’il est possible d’améliorer les biais via les données et la gouvernance, mais un effort continu est nécessaire pour adresser les biais intersectionnels et non anglais.

- L’accès à des outils d’audit publics et à des benchmarks transparents est essentiel pour une IA responsable et traçable. [The Gradient]

FAQ

-

- **Q : Qu’entend-on par biais de genre dans l’IA ?**

C’est le traitement inégal, défavorable ou injuste des personnes en fonction de leur genre dans les modèles, les représentations ou les sorties de l’IA, souvent issu de données d’entraînement biaisées et de choix de modélisation. [The Gradient] - **Q : Quels domaines montrent des biais de genre selon cette vue d’ensemble ?** **A :** Les biais apparaissent dans les embeddings de mots, la résolution de coréférence, les benchmarks de QA/LLMs (p. ex., BBQ) et la génération d’images, avec des préoccupations intersectionnelles liées au genre et à la couleur de peau. [The Gradient] - **Q : Est-il possible d’éliminer complètement les biais ?** **A :** Il existe des efforts de dé-biaisage (par ex. embeddings de mots), mais les biais persistent dans les systèmes transformateurs plus vastes et dans diverses tâches; une évaluation continue et des données diversifiées sont nécessaires. [The Gradient] - **Q : Que doivent faire les entreprises pour traiter le biais de l’IA ?** **A :** Investir dans des données représentatives, réaliser des audits continus, utiliser des outils d’audit publics et des benchmarks variés, et prendre en compte les contextes culturels et linguistiques lors de l’évaluation du biais. [The Gradient]

Références

- The Gradient. A Brief Overview of Gender Bias in AI. https://thegradient.pub/gender-bias-in-ai

More news

NVIDIA HGX B200 réduit l’intensité des émissions de carbone incorporé

Le HGX B200 de NVIDIA abaisse l’intensité des émissions de carbone incorporé de 24% par rapport au HGX H100, tout en offrant de meilleures performances IA et une efficacité énergétique accrue. Cet article résume les données PCF et les nouveautés matérielles.

Réduire la latence de démarrage à froid pour l’inférence LLM avec NVIDIA Run:ai Model Streamer

Analyse approfondie sur la façon dont NVIDIA Run:ai Model Streamer abaisse les temps de démarrage à froid pour l’inférence des LLM en diffusant les poids vers la mémoire GPU, avec des benchmarks sur GP3, IO2 et S3.

Comment msg a renforcé la transformation RH avec Amazon Bedrock et msg.ProfileMap

Cet article explique comment msg a automatisé l'harmonisation des données pour msg.ProfileMap en utilisant Amazon Bedrock pour alimenter des flux d'enrichissement pilotés par LLM, améliorant la précision de l'appariement des concepts RH, réduisant la charge manuelle et assurant la conformité avec l'

Comment la Quantization Aware Training permet de récupérer la précision en inferance à faible précision

Explore QAT et QAD comme méthodes de récupération de précision dans des modèles à faible précision, en s'appuyant sur TensorRT Model Optimizer et les formats FP8/NVFP4/MXFP4.

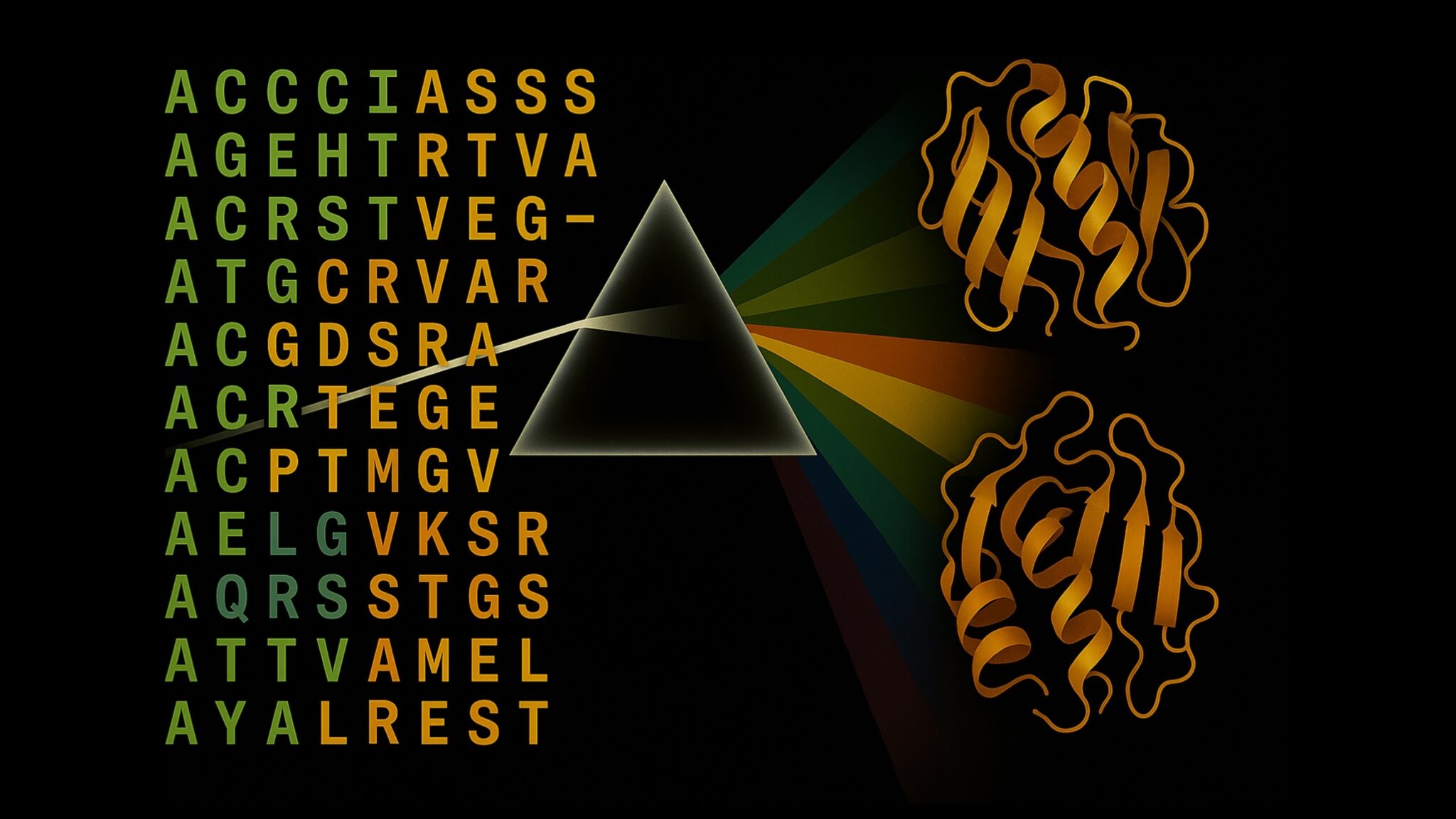

Accélérer l’Inference de la Structure des Protéines de Plus de 100x avec le NVIDIA RTX PRO 6000 Blackwell Server Edition

Le RTX PRO 6000 Blackwell Server Edition de NVIDIA accélère considérablement l’inférence de structure des protéines, permettant des flux de travail GPU complets avec OpenFold et TensorRT, jusqu’à 138x plus rapide que AlphaFold2.

Modèles Falcon-H1 de TII disponibles sur Amazon Bedrock Marketplace et SageMaker JumpStart

AWS annonce les modèles Falcon-H1 à instruction de TII (0,5B–34B) sur Amazon Bedrock Marketplace et SageMaker JumpStart, avec support multilingue, architecture hybride et guide de déploiement.