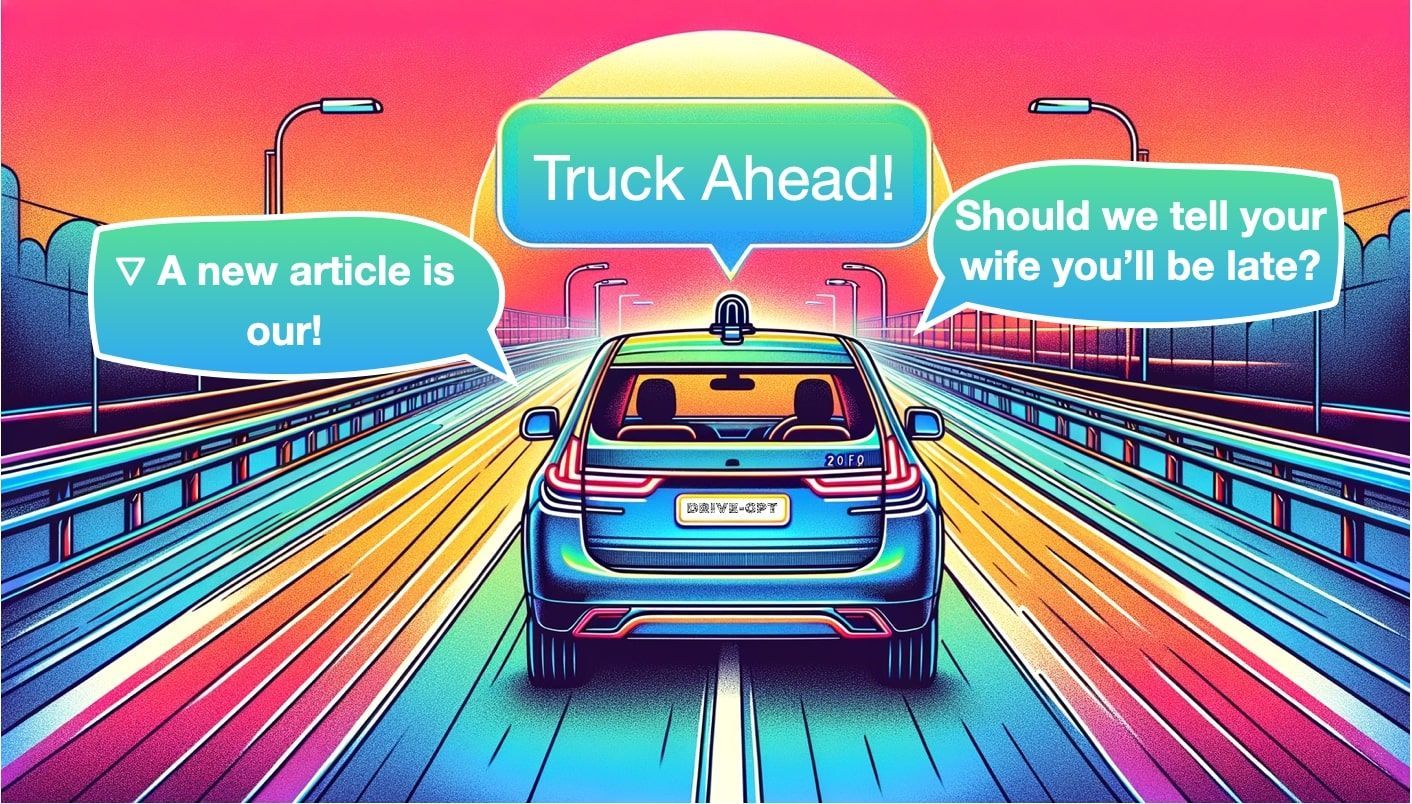

Car-GPT : les LLM pourraient-ils enfin faire décoller les voitures autonomes ?

Sources: https://thegradient.pub/car-gpt, thegradient.pub

TL;DR

- Les Modèles de Langage de Grande Taille (LLMs) sont explorés pour compléter la conduite autonome dans les domaines perception, planification et génération, potentiellement en complément des architectures modulaire traditionnelles.

- Les axes actuels sont trois flux actifs : perception (détection/prédiction/tracking), planification (trajectoires via des prompts langage), et génération (création de scénarios ou de vidéos futures à partir d’inputs).

- Des approches comme Talk2BEV, HiLM-D, MTD-GPT, DriveGPT, GAIA-1, MagicDrive et Driving Diffusion illustrent les possibilités, notamment pour des perception guidée par le langage et des scènes futures générées.

- La confiance, la transparence et le déterminisme restent des questions majeures; les déploiements en conditions réelles restent à un stade précoce et prudent.

Contexte et arrière-plan

La conduite autonome a longtemps évolué entre architectures modulaire et apprentissage end‑to‑end. Dans les années 2010, les stacks traditionnels séparaient le logiciel en modules tels que Perception (voir le monde), Localisation (localiser précisément), Planification (élaborer une trajectoire) et Contrôle (exécuter les commandes). Une décennie plus tard, certains chercheurs ont exploré l’apprentissage end‑to‑end, remplaçant les modules par un réseau unique prévoyant la direction et l’accélération. Cette approche présente l’avantage d’une simplification mais soulève le problème connu de la “boîte noire” et n’apporte pas encore une solution fiable au problème de conduite. La question est de savoir si les LLMs, désormais centraux dans de nombreuses avancées IA, pourraient être la réponse inattendue pour la conduite autonome. Les LLMs fonctionnent sur des tokens (mots, sous-mots ou caractères) et reposent sur des architectures de Transformer avec des mécanismes d’attention, de normalisation et d’attention croisée. Concrètement, on peut distinguer trois tâches centrales adaptées aux voitures : détection, prédiction et tracking en perception; planification pour les décisions de conduite; et génération pour des scénarios ou des instructions qui enrichissent perception et planification. Trois familles d’utilisation des LLMs dans les voitures autonomes émergent : perception, planification et génération. En perception, l’objectif est de détecter des objets, des voies et d’autres éléments de la scène à partir d’images ou de vidéos; en planification, les sorties de perception peuvent être utilisées pour guider les décisions de conduite, souvent via des prompts en langage pour orienter le comportement; en génération, on vise à créer des scénarios ou des vidéos afin d’enrichir les données d’entraînement et les tests. Parmi les exemples dans le domaine figurent HiLM-D et MTD-GPT pour la perception, PromptTrack pour maintenir des IDs d’objets sur plusieurs frames, Talk2BEV pour la planification BEV guidée par le langage, DriveGPT pour transformer les sorties de perception en trajectoires de conduite, et GAIA-1 pour la génération de vidéos à partir de texte et d’images, avec MagicDrive et Driving Into the Future et Driving Diffusion pour la synthèse de scènes futures. La conclusion est que les LLMs ne constituent pas une solution unique mais apportent une contribution à la perception, la planification et la génération qui peut compléter les modèles traditionnels. Le sujet de la fiabilité et de la transparence demeure, et les déploiements réels restent encore à un stade précoce.

Ce qui est nouveau

- Perception, Planification et Génération forment désormais trois flux actifs intégrant des LLMs dans la conduite autonome. Dans la perception, les LLMs aident à la détection, la prédiction et le tracking; dans la planification, le langage guide les décisions; et dans la génération, on produit des scénarios ou des données.

- Des systèmes notables incluent Talk2BEV (planification BEV guidée par le langage), DriveGPT (transfert des sorties de perception vers des trajectoires via LLM), GAIA-1 (textes et images → vidéos avec un World Model qui capture les interactions du monde), et MagicDrive (génération guidée par la perception).

- D’autres travaux visent à prévoir ou simuler des scénarios futurs avec Driving Into the Future et Driving Diffusion, afin d’étendre les données et la couverture de scénarios d’entraînement.

- Le thème clé est le BEV “orienté langage”, où le langage est utilisé pour affiner les sorties et/ou orienter le planificateur pour focaliser l’attention sur des zones pertinentes ou proposer des actions alternatives.

- Le domaine reconnaît le risque d’hallucinations et de comportement non déterministe; même si des progrès se font, c’est encore trop tôt pour des déploiements live dans les véhicules.

- La première vague d’articles mentionnant explicitement les LLMs dans les voitures date de la mi-2023, avec des revues décrivant l’évolution jusqu’à aujourd’hui.

Pourquoi cela compte (impact pour les développeurs/entreprises)

- Pour les développeurs, les LLMs offrent une voie potentielle vers des pipelines de perception et de planification plus flexibles, capable d’intégrer des prompts en langage naturel pour guider l’attention, le raisonnement et les décisions de conduite. Cela permet d’expérimenter rapidement de nouvelles stratégies de conduite ou des techniques de génération de données sans reconstruire les modules de perception de base.

- Pour les entreprises, les solutions basées sur les LLMs peuvent faciliter des Q&A plus sûrs pour les opérateurs, une meilleure collaboration humain-machine et une augmentation de la génération de scénarios pour l’entraînement des modèles. Toutefois, l’usage des LLMs implique des risques d’hallucinations et de comportements non déterministes, nécessitant des validations rigoureuses en conditions réelles.

- Le domaine privilégie une approche prudente et progressive : les tests et les simulations doivent précéder tout déploiement en conditions réelles, avec un accent sur la transparence du comportement du modèle pour satisfaire les régulateurs, les constructeurs et les conducteurs.

Détails techniques ou Mise en œuvre

- Les LLMs fonctionnent sur des entrées tokenisées via des architectures encodeur-décodeur, uniquement encodeur ou uniquement décodeur, avec des Transformer comprenant l’attention multi-têtes, la normalisation et l’attention croisée.

- En perception, les systèmes combinent des détecteurs traditionnels avec un raisonnement guidé par l’attention pour produire détection, prédiction et IDs de suivi entre les images via correspondance bipartite (algorithme de Hungarian).

- En planification, BEV est privilégié pour simplifier le raisonnement spatial. Talk2BEV montre comment un LLM peut affiner la perception BEV en suggérant des zones à inspecter et contribuera à la trajectoire.

- DriveGPT illustre une approche où les sorties de perception alimentent un LLM pour générer directement des trajectoires de conduite, démontrant une liaison entre langage et contrôle.

- GAIA-1 illustre une intégration plus holistique avec des entrées texte et image alimentant un World Model pour produire des vidéos, capturant les interactions du monde pour l’entraînement et la validation. D’autres projets comme MagicDrive, Driving Into the Future et Driving Diffusion proposent des scènes futures synthétiques pour étendre les données et les scénarios d’entraînement.

- Une préoccupation centrale est la confiance et le détermi nisme : contrairement aux systèmes purement déterministes, les LLMs peuvent halluciner ou donner des sorties non déterministes. La prudence et une validation rigoureuse en simulation et en station sont recommandées avant tout déploiement sur route.

Points clés

- Les LLMs sont étudiés comme compléments aux modules traditionnels de conduite, et non comme remplacement intégral.

- Trois flux majeurs : Perception (détection/prediction/tracking), Planification (orientée par le langage) et Génération (création de scénarios et données).

- BEV guidé par le langage et les approches multimodales favorisent un raisonnement plus flexible et une interprétation plus claire.

- Des modèles comme Talk2BEV, GAIA-1, DriveGPT montrent des avancées allant du raisonnement sur les objets à la génération de vidéos, mais les déploiements réels restent à un stade précoce.

- La fiabilité et la transparence restent des priorités, nécessitant des validations robustes en conditions réelles.

FAQ

-

- **Q : Comment les LLMs sont-ils utilisés dans la conduite autonome aujourd’hui ?**

Ils interviennent dans la perception, la planification et la génération, la perception englobant détection/prédiction/tracking, la planification utilisant des prompts en langage pour guider les décisions, et la génération produisant des scénarios ou guidant les données. - **Q : Quels sont les défis principaux pour les LLMs dans les voitures autonomes ?** **A :** Hallucinations et comportement non déterministe, nature de “boîte noire” de nombreux composants et nécessité d’essais réels pour assurer sécurité et fiabilité. - **Q : Qu’est-ce que BEV guidé par le langage et pourquoi est-ce important ?** **A :** C’est l’utilisation de prompts linguistiques pour affiner les sorties BEV et aider le planificateur à se concentrer sur des zones critiques et à proposer des actions alternatives. - **Q : Existe-t-il des déploiements en direct de systèmes Car-GPT ?** **A :** L’article indique que le domaine est à un stade précoce, axé sur la simulation, les jeux de données et les tests en laboratoire plutôt que sur des déploiements routiers massifs.

Références

More news

Comment réduire les goulots d’étranglement KV Cache avec NVIDIA Dynamo

NVIDIA Dynamo déporte le KV Cache depuis la mémoire GPU vers un stockage économique, permettant des contextes plus longs, une meilleure concurrence et des coûts d’inférence réduits pour les grands modèles et les charges AI génératives.

Prompting pour la précision avec Stability AI Image Services sur Amazon Bedrock

Bedrock intègre Stability AI Image Services avec neuf outils pour créer et modifier des images avec précision. Apprenez les techniques de prompting adaptées à l’entreprise.

Évoluer la production visuelle avec Stability AI Image Services dans Amazon Bedrock

Stability AI Image Services est désormais disponible dans Amazon Bedrock, offrant des capacités d’édition d’images prêtes à l’emploi via l’API Bedrock et étendant les modèles Stable Diffusion 3.5 et Stable Image Core/Ultra déjà présents.

Réduire la latence de démarrage à froid pour l’inférence LLM avec NVIDIA Run:ai Model Streamer

Analyse approfondie sur la façon dont NVIDIA Run:ai Model Streamer abaisse les temps de démarrage à froid pour l’inférence des LLM en diffusant les poids vers la mémoire GPU, avec des benchmarks sur GP3, IO2 et S3.

Simplifier l accès aux changements de contenu ISO-rating avec Verisk Rating Insights et Amazon Bedrock

Verisk Rating Insights, propulsé par Amazon Bedrock, LLM et RAG, offre une interface conversationnelle pour accéder aux changements ERC ISO, réduisant les téléchargements manuels et accélérant les informations fiables.

Comment msg a renforcé la transformation RH avec Amazon Bedrock et msg.ProfileMap

Cet article explique comment msg a automatisé l'harmonisation des données pour msg.ProfileMap en utilisant Amazon Bedrock pour alimenter des flux d'enrichissement pilotés par LLM, améliorant la précision de l'appariement des concepts RH, réduisant la charge manuelle et assurant la conformité avec l'